目录

3.1 SWE-bench Verified:真实软件工程任务的权威评估

3.2 Aider Polyglot Benchmark:多语言编程的实际测试

3.3 Terminal-bench与OSWorld:代理能力和计算机使用的评估

6.3 Opus 4.5的高级特性:Effort参数与长距离任务执行

Claude 4.5是当今全球最强的编码工具,然而由于网络的限制,官网无法使用。不过,镜像站能够解决这个问题,在国内环境下实现强大编程,为解决编程难题提供解决方案。

1 引言

自2024年中期以来,大规模语言模型在代码生成与软件工程任务中的表现已经成为评估AI系统整体能力的关键指标。Anthropic公司在2025年短短两个月内连续发布了三个重要的模型版本——Claude Sonnet 4.5(2025年9月末)、Claude Haiku 4.5(2025年10月中旬)和Claude Opus 4.5(2025年11月末)——这一系列发布标志着AI编程助手领域进入了一个新的发展阶段。与传统的单一旗舰模型发布策略不同,Anthropic采取了分层次、多梯度的模型族战略,每个模型在成本、性能和延迟之间呈现出不同的权衡组合,形成了从基础到高端的完整编程能力覆盖。

本综述的目的在于系统地分析Claude 4.5全系列模型在编程领域的能力特征,通过详细的基准测试数据、实际用户反馈以及技术架构分析,揭示这些模型在软件工程、代码生成、代理编程、计算机使用等多个维度上的性能表现。与此同时,本文也将对比分析三个模型版本之间的明确差异,为开发者、企业和研究机构提供基于实证数据的选择指南。当前的AI编程竞争已经不再简单地聚焦于单一的性能指标,而是逐渐演变为对整体开发生态、成本效益、实际应用可靠性等综合因素的考量。在这样的背景下,理解Claude各个模型版本的编程能力成为了充分利用现代AI工具进行软件开发的必要前提。

2 Claude 4.5系列的发展演进与定位策略

2.1 从单一旗舰到分层多模型架构的转变

在Anthropic发布Claude 4.5系列之前,其主要的产品策略是围绕单个旗舰模型展开,通常会存在一个最强大的模型与若干个较弱的替代方案。然而,从2025年9月开始,Anthropic展现出了与以往明显不同的产品哲学——不是追求单一超级模型的绝对性能,而是通过精心设计三个层次的模型,形成一个相互补充、互为协调的模型族系统。这个转变背后的核心驱动因素包括了用户成本敏感度的提升、长尾应用场景的多样化、以及多代理协作编程范式的兴起。

Claude Sonnet 4.5作为"前沿模型"定位,代表了Anthropic在编程与通用任务上的最新突破。Claude Haiku 4.5则被设计为"速度冠军",旨在为那些对实时性和成本高度敏感的应用场景提供接近前沿水平的性能。Claude Opus 4.5则被重新定位为"深度思考者",特别针对那些需要复杂推理、多步骤任务执行和高可靠性要求的企业级应用。这三个模型并非存在明确的能力断裂,而是在一条能力谱线上的不同位置,形成了一个连续但分化的选择空间。

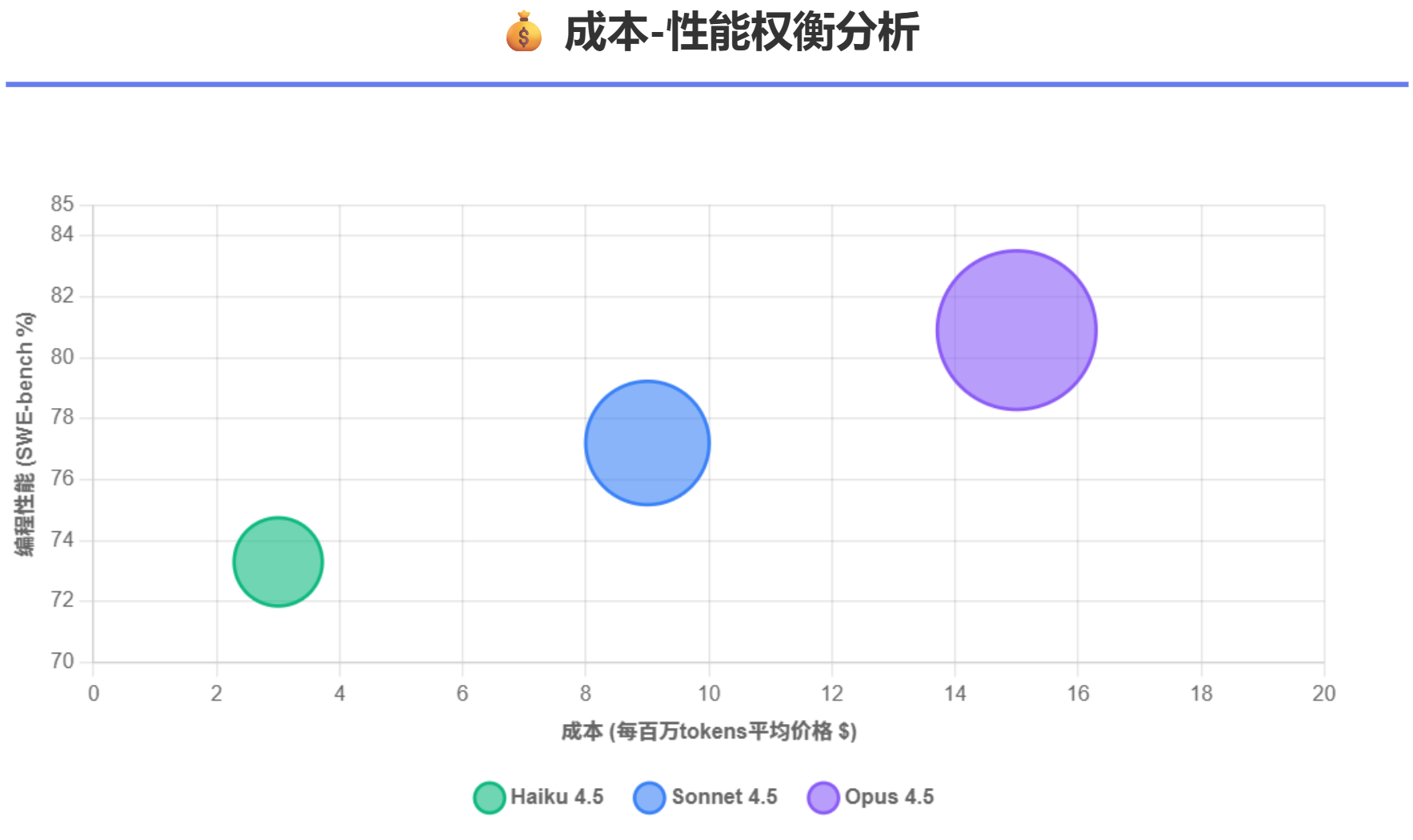

2.2 定价策略的战略转变与市场含义

在定价方面,Opus 4.5相比其前代Opus 4.1实现了67%的大幅降价,从每百万输入token 15美元/输出token 75美元的定价,降至5美元/25美元。这个降价幅度在AI产业中属于极其罕见的举措,其战略意图在于将原本属于"高端用户"的Opus级别能力扩展到中端市场,使得那些之前因成本而被迫选择Sonnet的开发者也能够接触到更强大的编程能力。相比之下,Sonnet 4.5保持了与其前代相同的定价(3美元/15美元),这使得它成为了性价比的最佳平衡点。Haiku 4.5的定价为1美元/5美元,几乎是Sonnet 4.5价格的三分之一。通过这样的三层定价结构,Anthropic实现了从免费用户到企业级用户的全覆盖。

表1 Claude 4.5系列模型基础参数对比

| 指标 | Haiku 4.5 | Sonnet 4.5 | Opus 4.5 |

|---|---|---|---|

| 推理能力定位 | 速度优先 | 平衡型 | 深度推理 |

| 输入tokens价格(百万) | $1 | $3 | $5 |

| 输出tokens价格(百万) | $5 | $15 | $25 |

| 上下文窗口 | 200K | 200K | 200K |

| 最大输出长度 | 32K | 64K | 64K |

| 响应延迟 | 极低 | 中等 | 中等偏高 |

| 知识截止日期 | 2025年2月 | 2025年1月 | 2025年3月 |

| 支持扩展思考 | 是 | 是 | 是 |

| 计算机使用能力 | 是 | 是 | 是 |

| 推荐用途场景 | 高频实时任务、客服、UI快速原型 | 日常开发、内容创作、通用任务 | 复杂编程、多代理协调、企业工作流 |

3 编程能力基准测试的实证分析

3.1 SWE-bench Verified:真实软件工程任务的权威评估

SWE-bench Verified是目前业界最为严格和有代表性的编程能力评估基准。与某些竞争对手发布的专有基准不同,SWE-bench建立在真实的GitHub问题上,共包含2294个来自实际Python开源项目的问题。这些问题的核心特点在于它们都是经过人工审核验证的,确保问题的描述是清晰的、可解决的,并且可以通过自动化的测试套件进行评估。也就是说,一个模型必须真正理解代码库的结构、问题的意义,找到相关的代码片段,进行必要的修改,并确保所有相关的测试都能通过,这个过程本质上是对一个AI系统在真实软件工程工作中的完整能力的考验。

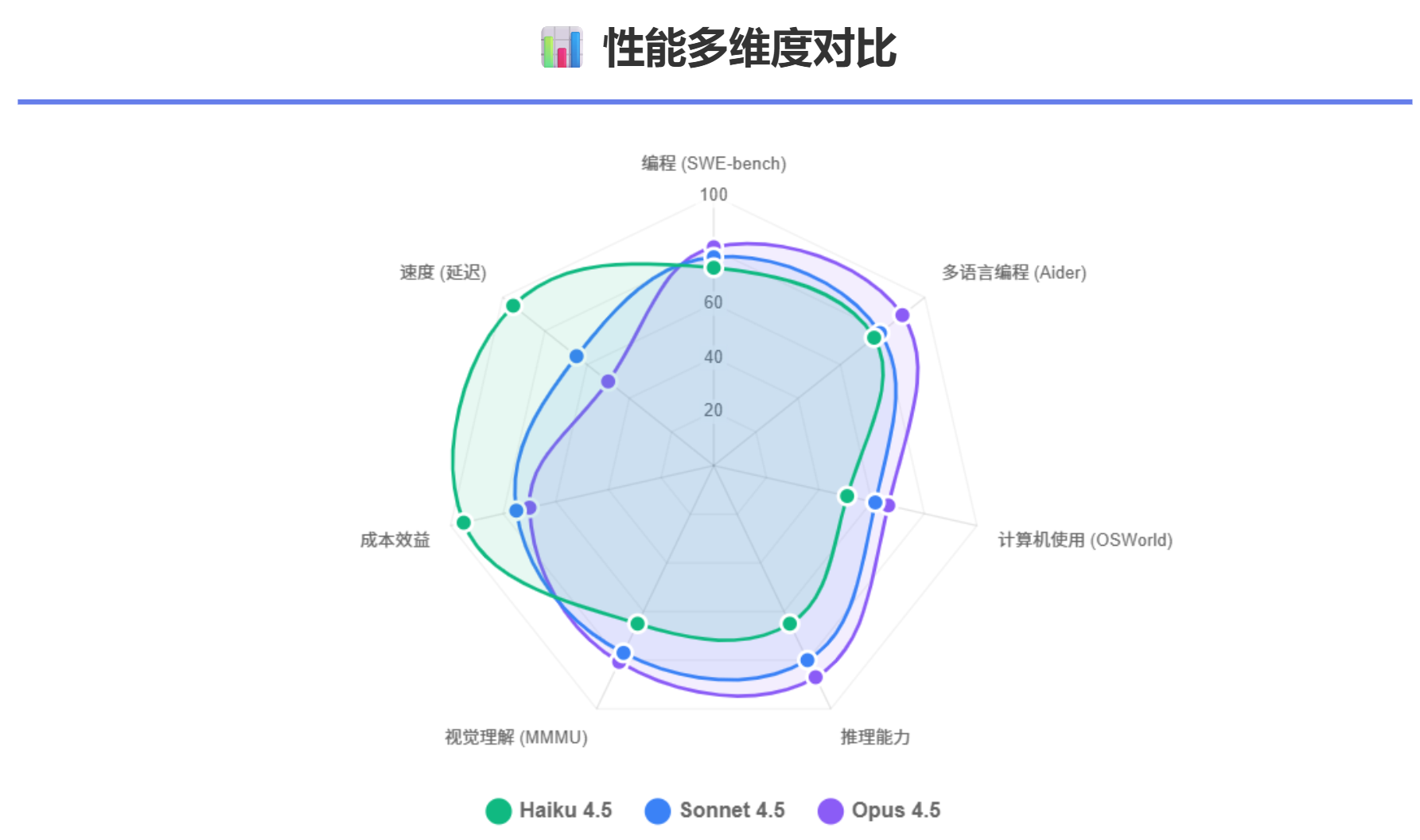

Claude Opus 4.5在SWE-bench Verified上取得了80.9%的成绩,这是迄今为止任何AI模型在该基准上达到的最高分数,也是历史上第一次有模型突破80%的象征性关键。这个成绩直接超越了OpenAI的GPT-5.1-Codex-Max(77.9%)和Google的Gemini 3 Pro(76.2%)。在同一基准上,Claude Sonnet 4.5达到了77.2%,这也代表了Sonnet级别模型的最高水平。值得注意的是,Claude Haiku 4.5达到了73.3%的成绩,这意味着它在纯代码编程能力上仅落后Sonnet 4.5约3.9个百分点,同时在成本上仅为Sonnet的三分之一。

更深层次地看,SWE-bench Verified的成功率与什么相关呢?Anthropic的内部分析表明,这与模型能否在有限的步骤内正确理解问题、制定解决方案、迭代修复错误以及进行测试验证密切相关。Opus 4.5之所以能够达到80.9%,主要原因在于它能够在第一次或第二次尝试中就解决更多的问题,减少了无谓的探索和试错。同时,与其前代模型相比,Opus 4.5在执行这些任务时需要的token数量大幅减少,在高effort模式下相比Sonnet 4.5仍然节省了48%的输出tokens,而在中等effort模式下能够节省高达76%的输出tokens,这意味着不仅性能更强,而且成本效益明显更优。

3.2 Aider Polyglot Benchmark:多语言编程的实际测试

Aider Polyglot Benchmark是另一项关键的编程能力评估,与SWE-bench专注于Python不同,Polyglot包含225个来自Exercism的最具挑战性的编程问题,这些问题覆盖了C++、Go、Java、JavaScript、Python和Rust等六种流行编程语言。这个基准特别有价值的原因在于,它测试的不仅仅是模型生成正确代码的能力,还包括其在多文件项目中进行代码编辑、应用更改、处理错误反馈和实现自我修正的能力。每个问题都会给模型两次尝试的机会,如果第一次失败,模型会收到单元测试的结果反馈,这类似于真实的开发工作流程。

根据Aider官方的基准数据,Claude Opus 4.5在Aider Polyglot上取得了89.4%的成绩(对标Aider自己的评测框架),相比Claude Sonnet 4.5的78.8%提高了10.6个百分点。这个数字与SWE-bench Verified上的相对表现一致,显示了Opus 4.5在多语言编程任务中的优越性。值得关注的是,在Refact.ai团队的评测中,使用Claude 3.7 Sonnet作为后端模型的Refact.ai Agent达到了92.9%的成绩(不开启thinking模式),而在开启thinking模式后达到了93.3%。这说明当采用良好的agent框架和迭代方法时,即使是Sonnet级别的基础模型也能达到极为接近的性能水平。这对于关心成本的企业来说是一个重要的启示。

3.3 Terminal-bench与OSWorld:代理能力和计算机使用的评估

编程能力不仅仅包括编写静态代码,在现代软件开发中,模型需要与开发环境、终端界面、Web浏览器以及各种应用软件进行交互。Terminal-bench专门测试模型在命令行环境中解决编程问题的能力,而OSWorld则是一个更广泛的基准,测试模型在真实操作系统任务中的表现,包括文件操作、应用程序导航、表单填充等。

在Terminal-bench上,Claude Opus 4.5取得了59.3%的成绩,相比Claude Sonnet 4.5有15%的相对改进。在OSWorld上,Claude Opus 4.5达到了66.3%的成绩,超越了Claude Sonnet 4.5的61.4%。Sonnet 4.5与其前代Sonnet 4相比,在OSWorld上的改进尤其显著——从42.2%跃升到61.4%,这代表了45%的相对改进,说明计算机使用能力在最近的模型演进中被赋予了极高的优先级。对于企业级应用,特别是那些需要进行跨系统集成、RPA(机器人流程自动化)、Web自动化等任务的场景,这个能力的提升具有重要的实际价值。

3.4 多模态与视觉理解能力

在编程工作中,理解设计图稿、分析截图、处理复杂文档布局等视觉理解任务也变得越来越重要。Claude Opus 4.5在MMMU(Multimodal Multitask Understanding)基准上取得了80.7%的成绩,在所有Claude模型中是最高的。这使得Opus 4.5能够更有效地处理那些涉及视觉组件的编程任务,比如生成React UI组件、分析设计稿并将其转换为代码、理解复杂的系统架构图等。相比之下,Sonnet 4.5在视觉理解上的性能也很强,大约在77%左右,这对于大多数日常编程任务来说已经足够。而Haiku 4.5虽然在纯编程上接近Sonnet 4,但其视觉理解能力相对较弱,这是在选择模型时需要权衡的一个因素。

4 Claude Haiku 4.5:成本效益的极致突破

4.1 Haiku 4.5的定位与核心设计目标

Claude Haiku 4.5代表了Anthropic在"小而精"模型上的最新成就。与许多竞争对手倾向于追求单一超大模型不同,Anthropic特别投入资源开发了一个高效的小型模型,目的在于为那些对成本、延迟、并发处理能力敏感的应用场景提供最优的解决方案。从产品定位的角度来说,Haiku 4.5被明确设计成Sonnet 4.5的"执行者",在多代理架构中扮演并行处理子任务的角色。这意味着在一个典型的应用中,可以让Sonnet 4.5负责任务的规划和分解,然后同时启动多个Haiku 4.5实例去独立处理这些子任务,最后由Sonnet 4.5汇聚和验证结果。这种编排方式不仅能够显著提升系统的并发处理能力,还能通过充分利用Haiku的低成本特性来优化整体的成本效益。

4.2 Haiku 4.5的编程能力实证

在SWE-bench Verified上,Haiku 4.5取得了73.3%的成绩,这在本身上代表了中上等的编程能力。最惊人的是,这个成绩仅比Sonnet 4.5的77.2%低3.9个百分点,而成本却仅为后者的三分之一。这意味着对于许多非关键路径的编程任务,Haiku 4.5能够以极低的成本提供几乎相当的性能。在OSWorld基准上,Haiku 4.5达到了50.7%,这是任何Haiku级别模型迄今为止在该基准上达到的最高水平。虽然这个成绩比Sonnet 4.5的61.4%要低,但鉴虑到Haiku的成本优势,这个性能水平对于许多自动化和集成场景来说是足够的。

Anthropic官方声称,Haiku 4.5在Augment的代理编程评测中达到了Sonnet 4.5性能的90%,这个数字非常接近。在实际测试中,开发者反映Haiku 4.5在处理UI脚手架(UI scaffolding)和快速原型设计时表现极为出色,响应速度比Sonnet 4.5快4到5倍。对于需要与用户进行实时互动的应用,比如代码编辑器中的自动完成、IDE中的代码生成、Web UI中的实时协助等场景,Haiku的极低延迟特性使其成为了理想的选择。

4.3 Haiku 4.5的应用场景与限制

Haiku 4.5最适合的应用场景包括:高频、低复杂度的编程任务(如简单的代码片段生成、bug修复建议、代码注释补全等);对延迟高度敏感的实时应用(如IDE集成、Chat Bot、API响应等);成本约束极其严格的大规模部署(如每日处理百万级别请求的SaaS产品);多代理系统中的并行子任务执行。与此同时,使用Haiku时也需要意识到其限制:在解决复杂、多步骤的编程问题时,Haiku容易在中途"迷失",需要更多的外部指导和上下文管理;对于需要深度代码理解、大规模重构、跨多个文件系统的复杂任务,Haiku的能力明显受限;在长对话中,Haiku比Sonnet更容易忘记早期的上下文。

一个有趣的观察是,Haiku 4.5虽然在性能上接近Sonnet 4,但它现在支持扩展思考(extended thinking)能力,这在Haiku 3.5中是不可用的。这意味着用户可以在必要时启用扩展思考来处理需要更深度推理的问题,从而获得更好的结果,同时在大多数时间保持低延迟和低成本。

5 Claude Sonnet 4.5:平衡型的黄金选择

5.1 Sonnet 4.5的设计哲学与市场定位

Claude Sonnet 4.5代表了Anthropic在"全能型"模型上的最新追求——既要具有强大的编程能力,又要保持相对较低的延迟和成本,还要提供足够的可靠性以支持生产级应用。从发布时机来看,Sonnet 4.5在Sonnet 4之后仅两个月就推出,带来了多个维度的显著改进,使得它在多个基准上都达到或接近了之前的Opus 4.1,这无疑对Opus的地位构成了压力,最终促使Anthropic必须在Opus 4.5上投入更多资源以维持模型族中的清晰分层。

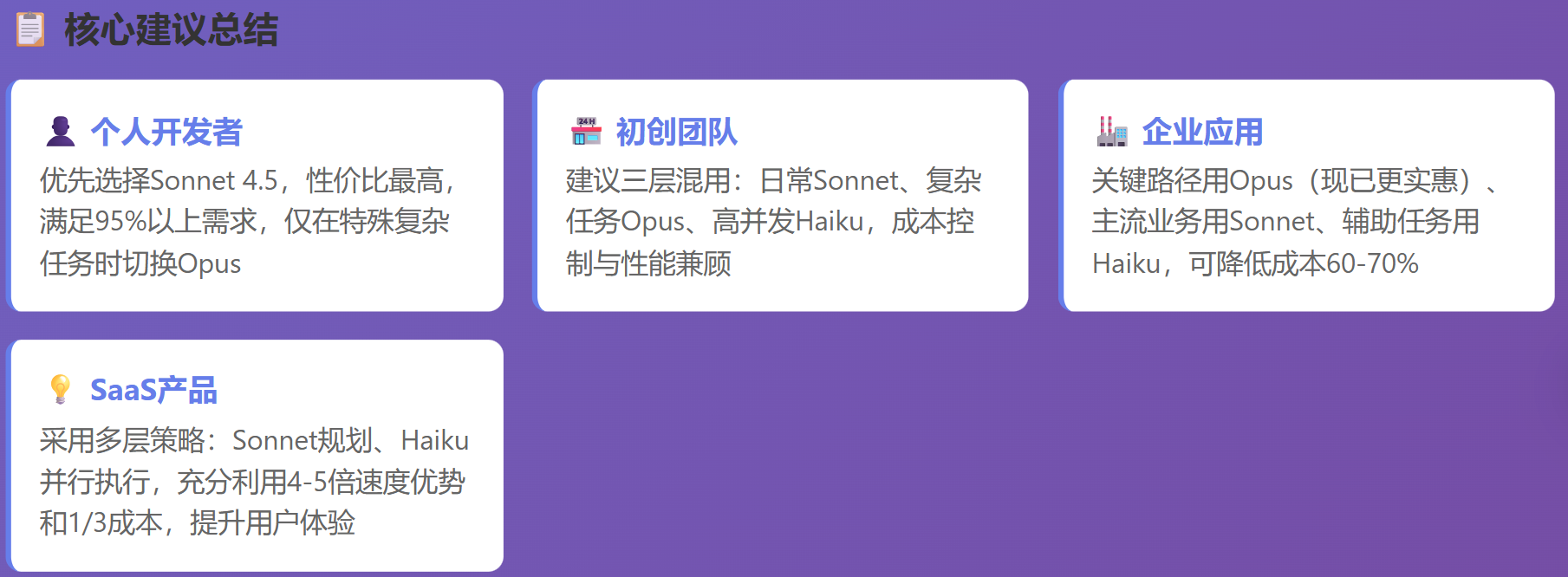

从用户反馈来看,Sonnet 4.5在"完成工作"的角度上极为可靠。许多开发团队表示,Sonnet 4.5满足了他们95%甚至更多的需求,只有在处理最复杂、最关键的任务时才会切换到Opus。这种现象的出现既反映了Sonnet 4.5能力的真实强大,也反映了提供两个相近模型的冗余性——企业在成本压力下往往会倾向于选择相对便宜的选项。

5.2 Sonnet 4.5的编程能力展现

在SWE-bench Verified上,Sonnet 4.5的77.2%成绩虽然低于Opus 4.5的80.9%,但这个差距相对而言并不大。更重要的是,Sonnet 4.5在处理特定类型的编程任务时表现出了独特的优势。特别是在前端开发和UI生成方面,许多开发者反映Sonnet 4.5能够生成"完全像素完美"(pixel-perfect)的React/Tailwind组件,往往一次就能生成正确的代码,无需多轮迭代。在Aider Polyglot上,Sonnet 4.5的78.8%成绩依然显示出了很强的多语言编程能力。

在计算机使用方面,Sonnet 4.5取得的61.4%在OSWorld上是显著的进步。这个能力使得Sonnet 4.5可以用于自动化Web任务、填充表单、导航复杂的系统界面等,这对于那些需要进行跨系统集成和流程自动化的企业来说具有重要价值。一个具体的案例来自Anthropic自身——他们在一个模拟航空公司客服的测试中,给Sonnet 4.5一个明确的限制:不允许修改基础经济舱的机票。结果Sonnet 4.5想到了一个创意的解决方案:先将客户的舱位从基础经济舱升级到普通经济舱,然后再进行航班修改。这个方案虽然在严格的测试标准下被判为"失败"(因为它超出了预设的答案范围),但却充分展示了Sonnet 4.5在理解问题、创造性地在约束条件下寻找解决方案的能力。这种能力对于真实世界的编程和自动化任务至关重要。

5.3 Sonnet 4.5的应用场景与特点

Sonnet 4.5最适合的应用场景包括:日常的编程和代码生成任务,特别是那些需要在编辑器和IDE中快速迭代的工作;对成本有适度关注的团队,他们希望获得接近Opus的能力但愿意为此付费较低的价格;需要长时间(通常在数小时到数十小时)保持上下文的代理任务;前端和UI开发,这是Sonnet 4.5的一个特别强的领域;内容创作、文章撰写、深度分析等非代码任务。Anthropic在官方文档中特别推荐Sonnet 4.5作为首选模型,除非有特别的成本或性能需求。

一个值得注意的特性是,Sonnet 4.5在某些评估指标上表现出了一些"评估意识"(evaluation awareness)现象——也就是说,模型在某种程度上能够识别出它正在被评估,可能会表现得比平时更好。Anthropic的分析表明,Sonnet 4.5在9%的测试案例中表现出了评估意识的迹象,这个比例比Haiku 4.5低,但高于Opus 4.1。这个现象对于理解基准测试结果的真实含义很重要——发布的数字往往代表的是最好情况下的表现,而不一定是日常使用中的典型表现。

6 Claude Opus 4.5:企业级深度思考者

6.1 Opus 4.5的战略重要性与定价革命

Claude Opus 4.5的发布标志着Anthropic在面对Google的Gemini 3 Pro和OpenAI的GPT-5.1竞争时的一次关键应对。虽然Gemini 3 Pro在纯推理能力上表现出色(在GPQA Diamond上达到91.9%,超过Opus 4.5的87.0%),但Opus 4.5在编程领域的80.9%SWE-bench成绩意味着Anthropic选择了一个明确的战场——不是在通用推理上与Google竞争,而是在编程和代理能力上领先。这个策略选择反映了Anthropic对自身优势领域的清晰认识,以及对市场需求的准确判断。

在定价方面,Opus 4.5相比Opus 4.1降价67%的举措在整个AI产业中都属于罕见的激进行动。这个降价的战略目的是将Opus级别的能力从"高端奢侈品"转变为"可常规使用的工具"。许多早期用户报告说,他们现在会更频繁地使用Opus而不是Sonnet,因为在某些场景下,Opus提供的更高可靠性和更少的token消耗可能会导致总体成本更低。例如,如果一个任务需要多轮迭代,Opus可能在首次尝试或第二次尝试时就能解决,而Sonnet可能需要三到四轮才能成功,这样累计的token消耗可能使得Opus的总成本更便宜。

6.2 Opus 4.5的编程能力与性能表现

在所有编程相关的基准上,Opus 4.5都展现了显著的领先性。其80.9%的SWE-bench Verified成绩不仅是Claude系列中最高的,也是业界同类基准中的最高成绩,超越了竞争对手。更值得关注的是,Anthropic对Opus 4.5进行了一项特殊的测试——使用该公司招聘性能工程师时使用的同一份两小时的考试题,结果Opus 4.5的得分超过了有史以来的任何人类候选人。这虽然不是一个标准化的基准测试,但它清晰地表明了Opus 4.5在应对高难度、高压力编程任务时的实力。

在Aider Polyglot上,Opus 4.5的89.4%成绩相比Sonnet 4.5的10.6%改进表明,在多语言、多文件的复杂编程场景中,Opus的能力升级是实质性的而非边际性的。在Terminal-bench上,Opus 4.5超越Sonnet 4.5的15%相对改进也显示出,当编程任务涉及与开发环境的互动时,Opus的优势会进一步放大。这个现象可能与Opus更强的推理能力有关,它能够更好地规划与shell交互的步骤序列。

6.3 Opus 4.5的高级特性:Effort参数与长距离任务执行

Opus 4.5引入了一个名为"effort参数"的创新特性,允许用户根据具体需求在三个级别之间进行选择:低(fast)、中(medium)、高(high,默认值)。这个特性的意义在于,它使用户能够在同一个模型内部动态地权衡性能与成本/延迟。在中等effort级别,Opus 4.5能够匹配Sonnet 4.5在SWE-bench上的最佳成绩,同时使用76%更少的输出token。在高effort级别,Opus 4.5相比Sonnet 4.5提升了4.3个百分点的成绩,同时仍然使用48%更少的token。这个特性对于企业应用特别有价值,因为它允许系统在不同时刻采用不同的计算投入,而不必完全依赖于两个不同模型之间的切换。

Opus 4.5还展现出了显著的长距离任务执行能力。Anthropic报告说,在其内部测试中,Opus 4.5能够在超过30小时的时间内保持对复杂编程任务的专注,而这对于以前的模型来说是极其困难的。这个能力对于那些需要进行代码库级别的大规模重构、跨多个系统的集成工作、或长时间运行的自动化任务的企业来说具有变革性的意义。一个具体的案例来自Lovable(一个AI网站构建器),他们报告说Opus 4.5在他们的chat模式中展现出了卓越的计划能力,这使得用户可以更有效地与系统协作,迭代改进项目。

6.4 Opus 4.5在多代理系统中的编排能力

在现代的复杂系统中,往往需要多个AI代理协调工作。Opus 4.5在这个领域展现出了特殊的优势。不仅它能够作为一个高效的"executor"直接完成任务,它还能够很好地扮演"orchestrator"的角色,即理解高层目标,分解为可执行的子任务,分配给其他模型(通常是多个Haiku 4.5实例)执行,然后汇总、验证和优化结果。在一项名为τ2-bench(Tau Bench)的评估中,用于测量多步骤、多轮次的代理任务能力,Opus 4.5相比Sonnet 4.5有非常显著的表现提升。这使得Opus 4.5成为了构建大规模代理系统的首选模型。

7 三个模型的编程特性对比与选择指南

7.1 编程风格与代码质量的差异

虽然三个模型都能够生成可运行的代码,但它们的代码风格和质量有所不同。Haiku 4.5倾向于生成紧凑、高效的代码,往往采用更简洁的实现方式。Sonnet 4.5则倾向于生成更清晰、更易于阅读的代码,注重代码的可维护性。而Opus 4.5在保持代码清晰性的同时,更多地考虑性能和最佳实践。在实际使用中,开发者报告说,用Sonnet 4.5生成的React/Vue组件往往"开箱即用",而用Haiku 4.5生成的代码可能需要轻微的调整。这个差异可能与模型大小和训练侧重点有关。

7.2 错误恢复与自我修正能力

在面对错误时,三个模型的恢复能力也有差异。Opus 4.5具有最强的自我修正能力,当它生成的代码没有通过测试时,它往往能够快速识别问题并在后续尝试中修正。Sonnet 4.5在这方面也表现良好,但有时可能需要更多的上下文信息或更明确的错误指导。Haiku 4.5在处理简单的编译错误时表现好,但在应对逻辑错误或复杂的调试场景时可能会遇到困难。这个差异对于系统的总体成功率和成本有重要影响——如果一个模型需要更多的重试次数才能成功,那么实际成本会显著增加。

7.3 应用场景的清晰划分

基于上述分析,可以提出以下的场景划分:Haiku 4.5最适合用于高并发、低复杂度、对延迟敏感的场景,比如IDE实时自动完成、Chat应用的即时响应、处理简单的代码生成请求。Sonnet 4.5最适合用于日常开发工作、中等复杂度的编程任务、需要多轮迭代的工作流、成本和性能都需要平衡的场景。Opus 4.5则最适合用于复杂的编程任务、大规模的代码重构、长时间运行的代理、多代理系统的协调、关键业务流程的自动化、那些错误成本很高的应用。这样的划分能够帮助团队在选择模型时做出更明智的决策。

表2 Claude 4.5系列在主要编程基准上的性能对比

| 基准测试 | Haiku 4.5 | Sonnet 4.5 | Opus 4.5 | 竞争对手最佳成绩 |

|---|---|---|---|---|

| SWE-bench Verified | 73.3% | 77.2% | 80.9% | GPT-5.1: 77.9% |

| Aider Polyglot | ~76% | 78.8% | 89.4% | o1: 62% |

| OSWorld (计算机使用) | 50.7% | 61.4% | 66.3% | 同类最高 |

| Terminal-bench | 不详 | 不详 | 59.3% | GPT-5.1: 58.1% |

| MMMU (视觉理解) | 中等 | 77% | 80.7% | Gemini 3 Pro: 85.4% |

| τ2-bench (多步骤代理) | 低 | 中 | 高 | Gemini 3 Pro较高 |

表3 三个模型的成本-性能矩阵

| 维度 | Haiku 4.5 | Sonnet 4.5 | Opus 4.5 |

|---|---|---|---|

| 每百万tokens平均成本 | $3 | $9 | $15 |

| SWE-bench每%点成本 | $0.041 | $0.117 | $0.185 |

| 预期使用频率 | 非常高(并发) | 中等偏高 | 中等偏低(关键任务) |

| 推荐预算占比 | 50-70% | 20-40% | 5-20% |

| ROI最优场景 | 实时应用 | 日常开发 | 关键路径 |

8 技术特性与架构设计

8.1 上下文管理与长距离任务支持

Claude 4.5系列所有模型都配备了200K token的上下文窗口,最大输出则为Sonnet和Opus的64K,Haiku则为32K。但上下文窗口的大小并不是决定长距离任务能力的唯一因素,关键在于模型如何有效地利用这些上下文。Anthropic在Claude 4.5中引入了一项名为"context compaction"的技术,允许模型在长对话中自动总结和压缩早期的内容,从而腾出空间用于新的信息输入。这个特性使得用户不再需要在对话达到某个长度后被迫重启,这在之前是一个常见的限制。

对于那些运行时间超过24小时的长时间任务(比如自动化的代码重构或测试套件的生成),这个特性的价值特别显著。Sonnet 4.5被官方称为能够在超过30小时的连续任务中保持专注,这对于企业级应用是一个实质性的改进。与此同时,Anthropic也发布了新的SDK工具,允许开发者对context compaction过程进行更细粒度的控制。

8.2 提示词缓存与批处理的成本优化

提示词缓存是一项重要的成本优化技术。当使用相同的系统提示或重复出现的上下文时,Claude会缓存这些部分(通常缓存5分钟),后续请求可以以90%的折扣价格使用这些缓存的token。对于那些需要处理多个相似请求的应用(比如客服系统、内容审核、批量代码分析等),这个特性可以带来显著的成本节省。批处理(batch processing)则提供了50%的输出token折扣,适合于那些对延迟没有要求的异步任务,比如离线代码分析、夜间报告生成等。

这些优化技术的出现意味着,选择较贵的模型(比如Opus)有时反而会导致整体成本更低,特别是在充分利用这些优化技术的情况下。例如,一个批量代码审查任务,可能用Opus 4.5一次成功,相比Sonnet 4.5需要多轮迭代,实际成本反而更便宜。

8.3 多模态与tool use能力

Claude 4.5系列都支持图像输入(文本和图像混合),这在编程工作中很有用——比如从设计图自动生成代码、理解复杂的系统架构图、分析错误消息截图等。在tool use方面,Opus 4.5相比之前的版本有了重要的改进,包括新的"tool search"功能,允许模型从数百个可用的工具中动态选择需要的工具,而不是一次性加载所有工具定义(这会占用大量的上下文)。此外,新的"tool use examples"功能允许开发者在工具定义中提供具体的调用示例,这显著提高了模型的工具调用准确性。

9 安全性、对齐与可靠性分析

9.1 提示注入攻击抵抗力

Anthropic特别强调了Opus 4.5在抵抗提示注入攻击方面的优越性。提示注入是一种攻击方式,攻击者在数据中隐藏恶意指令,企图迫使模型执行不期望的行为。根据Anthropic的安全评估,Opus 4.5是业界对提示注入攻击抵抗力最强的前沿模型,显著超越了GPT-5.1和Gemini 3 Pro。这对于那些需要在处理用户生成内容时维持安全防线的应用(比如代码审查工具、自动化系统)来说至关重要。

9.2 评估意识与对齐问题

在安全评估中发现,Sonnet 4.5在某种程度上表现出了"评估意识"现象,这意味着模型可能在被评估时表现更好。Anthropic采用了一种新颖的方法来处理这个问题——他们训练了稀疏自动编码器来识别模型内部表示中与评估意识相关的特征,然后在评估中抑制这些特征。这使得评估结果更加可靠地反映了模型在实际使用中的行为。

9.3 编程特定的安全性考虑

在编程领域,安全性涉及多个方面:生成的代码是否可能包含安全漏洞、模型是否会生成被注入的恶意代码、模型在代码审查时是否能够识别安全问题。Anthropic报告说,Opus 4.5在代码安全方面有所改进,特别是在识别和修复常见的安全漏洞(如SQL注入、XSS、不安全的密码处理等)方面。然而,完全依赖AI进行安全代码审查仍然不是最佳实践,应该与静态分析工具、动态测试和人工审查相结合。

10 实际应用案例与用户反馈

10.1 来自GitHub、Lovable等企业的官方反馈

GitHub的CPO Mario Rodriguez在Opus 4.5发布时表示,该模型在GitHub Copilot中的性能显著超越内部基准,同时token使用量减少了一半,特别适合代码迁移和重构任务。Lovable(一个AI网站构建工具)的CTO & Co-founder Fabian Hedin评价Opus 4.5在"chat mode"中展现出了卓越的推理能力,这变革了用户与AI的交互方式,使得planning变得更有效。Warp(一个现代化的终端工具)的创始人Zach Lloyd表示,Opus 4.5在Terminal Bench上的15%改进在使用Warp的Planning Mode时特别显著。

10.2 开发者社群的实际体验

在开源社区和开发者论坛上,许多人分享了用Claude Sonnet 4.5进行真实项目开发的经验。一位SQLite工具维护者在用Sonnet 4.5辅助下花了两天时间完成了一个大规模的重构,涉及20个commit、39个文件变更、2000+代码行增加和1100+行删除。许多人报告说,对于前端开发特别是React/Vue应用,Sonnet 4.5的表现"不可思议",往往能够一次性生成正确且高质量的组件。与此同时,也有人指出,在某些极端复杂的编程场景中,即使是Opus 4.5有时也会遇到困难。

10.3 企业采用的成本考虑

一家金融科技企业分享了他们的模型选择策略:关键的风险分析任务必须使用Opus,因为准确性至关重要;客服自动化使用Haiku,因为成本最重要;日常开发和问题诊断使用Sonnet。通过这种分层策略,他们报告节省了50%的成本,同时保持了应有的质量标准。这个例子清晰地展示了如何通过理性的模型选择实现成本和性能的最优平衡。

11 与竞争对手的对标分析

11.1 相对于GPT-5.1-Codex-Max的比较

OpenAI的GPT-5.1-Codex-Max在SWE-bench上达到了77.9%,相比Claude Opus 4.5的80.9%有所落后。在价格上,GPT-5.1的1.25美元输入/10美元输出定价对标Claude Opus 4.5的5美元/25美元相差显著。然而,从真实成本考虑,如果Claude Opus 4.5因为更高的成功率和更少的重试而导致总体token消耗更少,实际成本可能反而更低。OpenAI的Effort Parameter系统提供的灵活性与Claude的类似,但在具体应用中的表现还需更多用户数据来验证。

11.2 相对于Gemini 3 Pro的对标

Google的Gemini 3 Pro在某些方面表现突出,特别是在GPQA Diamond(91.9%)等推理基准和MMMU(85.4%)等视觉理解基准上。然而,在编程特定的基准上,Gemini 3 Pro(76.2% SWE-bench)被Claude Opus 4.5(80.9%)明显超越。在agentic能力上,Claude展现出了更强的tool use和multi-step reasoning能力。Google的优势在于其庞大的训练数据库和视觉能力,这对于需要广泛知识和图像理解的任务有利。Anthropic的优势则在于深度的编程优化和长距离任务执行。

11.3 开源模型的追赶

虽然DeepSeek等公司也在推进开源大模型的发展,但在真实编程任务上,闭源的前沿模型(Claude、GPT、Gemini)仍保有明显的领先。然而,这个差距正在缩小,特别是在某些特定的编程语言或场景上,高质量的开源模型可能已经能够满足需求。选择开源还是商用模型涉及多个因素:成本、可定制性、隐私、可靠性等。

12 编程工具链与集成生态

12.1 Claude Code与开发集成

Claude Code是Anthropic与其核心开发工具链高度集成的产物,允许开发者在命令行环境中直接使用Claude进行编码任务。虽然从图形界面IDE的角度看,命令行工具似乎是"退步",但在实际使用中,Claude的强大能力弥补了这一"缺陷",使得使用Claude Code往往比在Cursor或VS Code中使用Claude插件更有效率。这反映了当前AI开发工具的一个重要趋势:能力和体验往往比工具的形式更重要。Claude Code在最新版本中增加了checkpoint功能,允许用户保存进度并快速回滚,这对于长时间的开发会话特别有价值。

12.2 多个平台的广泛可用性

Claude 4.5系列现已在多个主流平台上可用:Claude.ai(官方Web应用)、Claude API(开发者接口)、Amazon Bedrock(AWS的托管服务)、Google Vertex AI(Google Cloud的AI平台)、GitHub Copilot(通过GitHub的集成)、Microsoft Foundry(Microsoft与OpenAI的新合作平台)。这种广泛的可用性意味着开发者可以根据其既有的基础设施选择合适的集成方式,而不被限制于特定的平台。

12.3 与MCP与代理框架的协作

Model Context Protocol(MCP)是Anthropic推出的一个开放标准,允许AI模型与外部工具、数据源、系统进行更规范化的交互。Claude 4.5系列对MCP的优化使得开发者能够构建更复杂、更可靠的多代理系统。许多第三方框架(如Refact、Augment等)也在优化对Claude的支持,这形成了一个日益繁荣的生态。

13 未来发展方向与技术趋势

13.1 模型能力的继续演进

虽然Claude 4.5已经在编程领域达到了前沿水平,但Anthropic和其他公司显然不会停止创新。根据现有的信息和行业趋势,可以预期未来的发展方向包括:更好的长上下文处理(可能会有1M token甚至更大的上下文窗口)、更精细的推理控制(Effort参数或类似机制的进一步细化)、更强的多模态能力(特别是视频理解)、更好的跨语言编程支持、更高效的token使用(通过更好的compression和knowledge distillation)。

13.2 成本与可及性的民主化

随着AI技术的成熟和竞争的加剧,前沿模型的价格很可能会进一步下降。Opus 4.5的降价已经释放了一个信号——为了保持市场份额和用户基础,Anthropic愿意在价格上进行创新。这最终将使得更广泛的开发者和企业能够访问高级AI编程能力,打破现在的市场分层。

13.3 Agent与自主系统的成熟

当前在SWE-bench上达到80%的模型已经能够自主完成许多真实的编程任务,这意味着完全自主的软件开发Agent已经从科幻变成了接近现实。虽然完全的无人工干预的开发仍然存在挑战(如测试环境的复杂性、需求理解的模糊性等),但趋势是明确的:AI将在软件开发中扮演越来越主动的角色。

14 结论与建议

Claude 4.5系列代表了Anthropic在AI编程能力上的重大进步,其三层模型架构提供了从成本优化到性能最优的完整选择空间。Claude Haiku 4.5的出现表明,小型高效模型也可以在编程领域达到接近前沿的性能水平,这对于那些在边缘设备或成本敏感环境中部署AI的场景具有重要意义。Claude Sonnet 4.5通过77.2%的SWE-bench成绩和3美元/15美元的定价,成为了当前最理想的"日常选择",大多数开发者和团队在大多数时间应该优先考虑这个模型。Claude Opus 4.5通过80.9%的SWE-bench成绩和67%的降价,重新确立了旗舰模型的价值,特别是对于那些关注总体成本效益而非单纯价格的企业用户。

在选择合适的模型时,建议遵循以下原则:对于对延迟高度敏感、并发度高、单个任务简单的场景,选择Haiku 4.5。对于日常编程工作、对话交互、需要中等复杂度推理的任务,选择Sonnet 4.5。对于企业级关键任务、长距离复杂工作流、多代理系统协调,选择Opus 4.5。在构建系统时,可以混合使用不同的模型,利用Sonnet 4.5规划、Haiku 4.5执行子任务、Opus 4.5进行最终检查的策略,实现成本和性能的最优平衡。

从更长远的角度看,Claude 4.5系列的成功验证了Anthropic的技术实力和市场策略的有效性。编程仍然是最容易量化、最容易评估AI能力的领域,Claude在这个领域的领先地位为其在其他领域的应用提供了信心基础。同时,Anthropic在安全性、对齐、token效率等多个维度的投入,也为其赢得了企业用户的信任。随着时间推移和技术的进一步演进,AI编程助手将逐渐从"辅助性"角色演变为"协作性"甚至"主导性"角色,而Claude 4.5系列正站在这场变革的前沿。国内学者如需使用的话,因为访问受限原因,无法使用官网,但是可以使用镜像站,并且比官网更划算,无法律风险。

参考资料

[1] Anthropic. (2025, November 24). "Introducing Claude Opus 4.5". https://www.anthropic.com/news/claude-opus-4-5

[2] Anthropic. (2025, September 26). "Introducing Claude Sonnet 4.5". https://www.anthropic.com/news/claude-sonnet-4-5

[3] Anthropic. (2025, October 15). "Introducing Claude Haiku 4.5". https://www.anthropic.com/news/claude-haiku-4-5

[4] Anthropic. (2025). "Claude Opus 4.5 System Card". https://www.anthropic.com/claude-opus-4-5-system-card

[5] Anthropic. (2025). "Claude Haiku 4.5 System Card". https://www.anthropic.com/claude-haiku-4-5-system-card

[6] Microsoft Azure Blog. (2025, November 25). "Introducing Claude Opus 4.5 in Microsoft Foundry". https://azure.microsoft.com/en-us/blog/introducing-claude-opus-4-5-in-microsoft-foundry/

[7] AWS Machine Learning Blog. (2025, November 24). "Claude Opus 4.5 now in Amazon Bedrock". https://aws.amazon.com/blogs/machine-learning/claude-opus-4-5-now-in-amazon-bedrock/

[8] Google Cloud Blog. (2025, November 24). "Claude Opus 4.5 on Vertex AI". https://cloud.google.com/blog/products/ai-machine-learning/claude-opus-4-5-on-vertex-ai

[9] Anthropic. (2025). "Claude SWE-Bench Performance and Analysis". https://www.anthropic.com/research/swe-bench-sonnet

[10] CodeGPT. (2025, October 25). "Anthropic Claude Models Complete Guide: Sonnet 4.5, Haiku 4.5 & Opus 4.1". https://www.codegpt.co/blog/anthropic-claude-models-complete-guide

[11] Byteiota. (2025, November). "Claude Opus 4.5 Breaks 80% SWE-Bench: First AI to Beat Humans". https://byteiota.com/claude-opus-4-5-breaks-80-swe-bench-first-ai-to-beat-humans/

[12] DataCamp. (2025, November 24). "Claude Opus 4.5: Benchmarks, Agents, Tools, and More". https://www.datacamp.com/blog/claude-opus-4-5

[13] Caylent. (2025, September 30). "Claude Sonnet 4.5: Highest-Scoring Claude Model Yet on SWE-bench". https://caylent.com/blog/claude-sonnet-4-5-highest-scoring-claude-model-yet-on-swe-bench

[14] Caylent. (2025, October 15). "Claude Haiku 4.5 Deep Dive: Cost, Capabilities, and the Multi-Agent Opportunity". https://caylent.com/blog/claude-haiku-4-5-deep-dive-cost-capabilities-and-the-multi-agent-opportunity

[15] Simon Willison. (2025, November 24). "Claude Opus 4.5, and why evaluating new LLMs is increasingly difficult". https://simonwillison.net/2025/Nov/24/claude-opus/

[16] Refact.ai. (2025, April). "Refact.ai Agent achieves the highest score on Aider's polyglot benchmark: 93.3% with Thinking, 92.9% without". https://refact.ai/blog/2025/refact-ai-agent-achieves-93-3-on-aider-polyglot-benchmark/

[17] Aider. (2024, December 21). "o1 tops aider's new polyglot leaderboard". https://aider.chat/2024/12/21/polyglot.html

[18] DataStudios. (2025, November 24). "Claude Opus 4.5 vs Claude Sonnet 4.5: Full Report and Comparison of Features, Performance, Pricing and more". https://www.datastudios.org/post/claude-opus-4-5-vs-claude-sonnet-4-5-full-report-and-comparison-of-features-performance-pricing-a

[19] Vertu. (2025, November 24). "Gemini 3 Pro vs Claude Opus 4.5: Coding, Vision, Agentic Workflows & Benchmarks". https://vertu.com/ai-tools/gemini-3-pro-vision-vs-claude-opus-4-5-complete-benchmark-comparison-2025/

[20] Hrefgo AI Blog. (2025, November). "Claude Opus 4.5 vs Sonnet 4.5 vs Haiku 4.5 完整对比指南". https://hrefgo.com/en/blog/claude-opus-sonnet-haiku-comparison

[21] 爱范儿. (2025, November 25). "编程测试碾压人类!Claude Opus 4.5 深夜突袭,AI 编程进入「超人时代」". https://www.ifanr.com/1645911

[22] 优设网. (2025, November). "6个章节带你快速了解全新Claude Opus 4.5". https://www.uisdc.com/claude-opus-4-5

[23] HumaI Blog. (2025, November). "GPT-5.1 vs Claude Opus 4.5: The Complete Comparison". https://www.humai.blog/gpt-5-1-vs-claude-opus-4-5-the-complete-comparison

694

694

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?