近日,网易云信宣布支持兼容 MCP 开源协议,将即时通讯(IM)和实时音视频(RTC)服务通过 MCP 协议开放给开发者,降低开发成本,提升开发效率。

网易云信对外提供包括 IM 与 RTC 在内的融合通信服务。在 MCP 之前,云信通常以 Open-API 形式或在管理后台以 UI 的方式来暴露数据和功能。

而在兼容 MCP 协议后,云信的能力可以通过 MCP 协议暴露,开发者无需做任何开发,只需通过简单配置就可结合大模型来快速获取云信 Open-API 暴露的数据和能力,并且利用大模型或其他 MCP 工具对相关数据和能力进行进一步加工和使用,服务于业务运营。

1

什么是MCP协议?

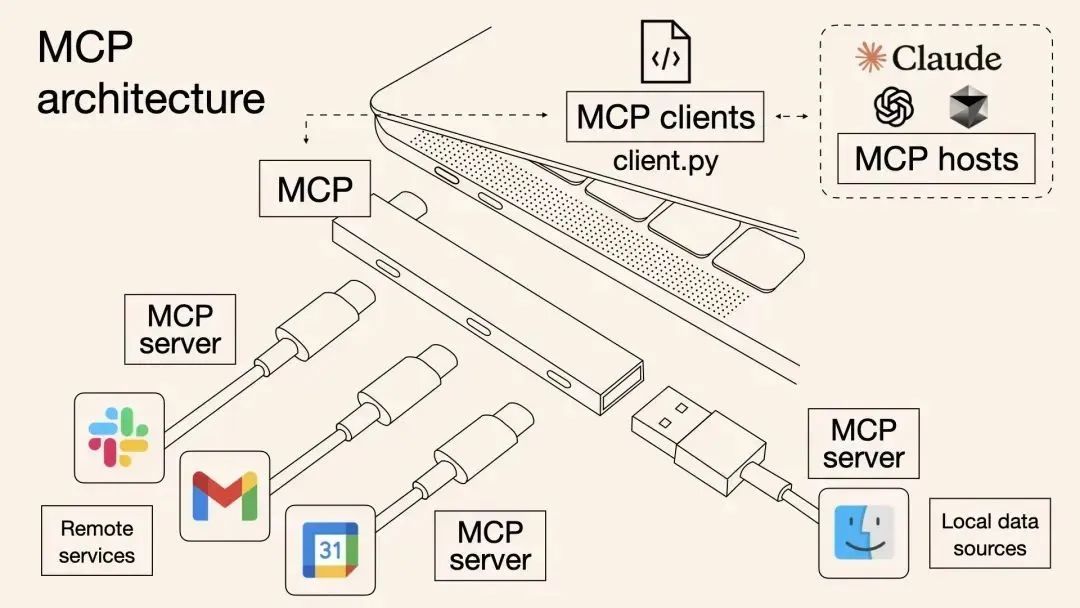

MCP(Model Context Protocol)是模型上下文协议,最初由 Anthropic 提出并开源,旨在创建一个开放、标准的规范,让大语言模型能够无缝与各种外部数据源和工具进行交互,目标是成为 AI 领域的“HTTP 协议”,也可以将其想象为 AI 世界的“USB-C”或“通用连接器”,解决模型智能与现实应用之间的连接问题,最终目的是推动大模型应用的标准化和去中心化。

随着 OpenAI 与 Google 相继表态支持 MCP 后,MCP 正在成为全球广泛接受的标准,标志着 AI 应用开发向着更高效统一的方向迈出了坚实的一步。

通过 MCP 协议,AI Agent 应用在访问外部数据和调用外部工具时,将变成一个统一开放的系统。工具提供方和Agent 应用维护者只需聚焦各自关注的内容,而无需关注对方的细节。例如,Agent 应用开发者只需要知道有哪些MCP 工具及其各自的功能,而工具提供方也只需关注工具本身的功能实现即可。

2

在MCP之前,大家都是怎么做的?

众所周知,大模型在文本理解、逻辑推理等方面能力都很强,但受限于训练数据的时效性,无法覆盖最新的知识和信息,因此通过大模型获得的信息可能是陈旧的、过期的;但若要针对近期发生的信息生成内容,就有可能出现“幻觉”,联网数据查询不到、信源质量不高等都会导致输出内容鱼龙混杂,甚至胡编乱造的问题。

在 MCP 之前,解决信息陈旧问题,通常有以下常见思路:

1. 模型微调

重新使用最新的数据来训练大模型,缺点是成本比较高。

2. RAG 和向量数据库

将最新的数据或私有的数据通过向量数据库方式进行 topN 匹配,并作为上下文提交给大模型,缺点是需要在大模型的请求 pipeline 中额外增加请求向量数据库的工作,有一定的业务侵入性。

此外,对 “外部检索” 的依赖,会导致检索精度、延迟、数据管理成本和系统复杂度面临挑战。

3. function-call

目前大部分大模型都支持 function-call,其实 RAG 和向量数据也可以以 tool 的形式被模型调用;此外,通过 function-call 我们可以让大模型去使用外部的一些工具,搭配上流程编排(workflow)和目标规划,就演变成了时下火热的 AI Agent。

但是 function-call 最大的问题就是没有统一的标准和规范,因此工具的设计和实现往往和Agent 本身的开发耦合在一起了。MCP 协议的出现就是希望将工具调用标准化,从而互相解耦。

3

如何接入和使用网易云信 MCP?

介绍了这么多,接下来我们具体讲讲如何接入和使用云信 MCP。

在本次示例中,我们以 cherry-studio 这个支持 MCP 协议的大模型客户端为例,并选择了 DeepSeek 作为演示的大模型。

首先,你需要先安装好 cherry-studio,并且已经拥有了 DeepSeek 的账号;其次,你需要在本地安装好 python 的包管理工具 uv;此外,下载 Yunxin-MCP-Server 的源码到本地,具体参考如下:

1. cherry-studio:https://cherry-ai.com/download

2. uv:https://docs.astral.sh/uv/

3. DeepSeek:https://www.deepseek.com/

4. Yunxin-MCP-Server:

https://github.com/netease-im/yunxin-mcp-server

备注:后续我们计划把 Yunxin-MCP-Server 发布到 PyPi 仓库,则本地将不再需要下载 Yunxin-MCP-Server 的源码。

配置方法

一个 IM 的简单示例

一个 RTC 的简单示例

在上述演示中,我们使用了 Yunxin-MCP-Server 中的多个工具。例如:

在 IM 场景中,让大模型分析历史消息和群成员关系等,用于辅助运营。此外通过大模型,我们也能直接查询 SDK/API 调用情况的实时统计数据,以及每日消息量这样的 T+1 离线统计数据,从而可以让大模型来分析和判断系统的运行状态,并且给出一些建议。

在 RTC 场景中,让大模型查询了房间和网络不同维度上的卡顿率指标情况,用来辅助判断系统当前的运行状态,以及方便问题排查。

实际上,我们还可以将云信 MCP 和其他 MCP 工具组合使用,例如把上述查询到的数据写入 Excel 并绘制成可视化图表,发挥更大价值。

换句话来说,当大模型准备就绪,工作流衔接合理,只需完成简单的配置工作就能搭建功能各异、且专属于自己的 MCP Agent!

因此,Yunxin-MCP-Server 提供了比上述示例中更多的 tool,完整工具列表可以通过 github 查看:https://github.com/netease-im/yunxin-mcp-server。

4

小 结

随着越来越多企业和开发者加入,我们将会看到越来越产品和工具从“出厂”就自带 MCP 接口,使其天生就拥有 AI 基因,具备与其他 MCP 工具融合共生的能力。我们期待 MCP 能成为 AI 与工具交互的标准接口,催生出新一代更自主、更全面、多模态的智能体验。

最后,欢迎您试用云信 MCP,若您对当前 Yunxin-MCP-tool 提供的能力有任何建议,比如对已有工具能力增强的需求、更多其他的工具需求等,都可以留言告诉我们。

云小信智能体,为您 7x24h 在线答疑

关于我们

干货资料 免费领取

【扫描二维码】即可免费领取!

437

437

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?