今日输出: 获取CNN模型的计算力(flops)参数量(parameters)

使用工具: pytorch 的 torchstat 包

from torchstat import stat

import torchvision.models as models

model = models.alexnet()

stat(model,(3,244,244)

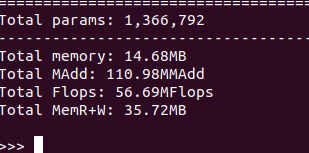

输出结果

alexnet:

shufflenet

虽然shufflenet的网络stage比较多,但是参数量和计算量还是非常小的

model = models.shufflenet_v2_x0_5()

__all__ = [

'ShuffleNetV2', 'shufflenet_v2_x0_5', 'shufflenet_v2_x1_0',

'shufflenet_v2_x1_5', 'shufflenet_v2_x2_0'

]

本文探讨了PyTorch中AlexNet和ShuffleNet两种模型的FLOPs(计算量)及参数量,并强调了Shufflenet虽结构复杂但参数量小的特点。

本文探讨了PyTorch中AlexNet和ShuffleNet两种模型的FLOPs(计算量)及参数量,并强调了Shufflenet虽结构复杂但参数量小的特点。

5701

5701

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?