目录

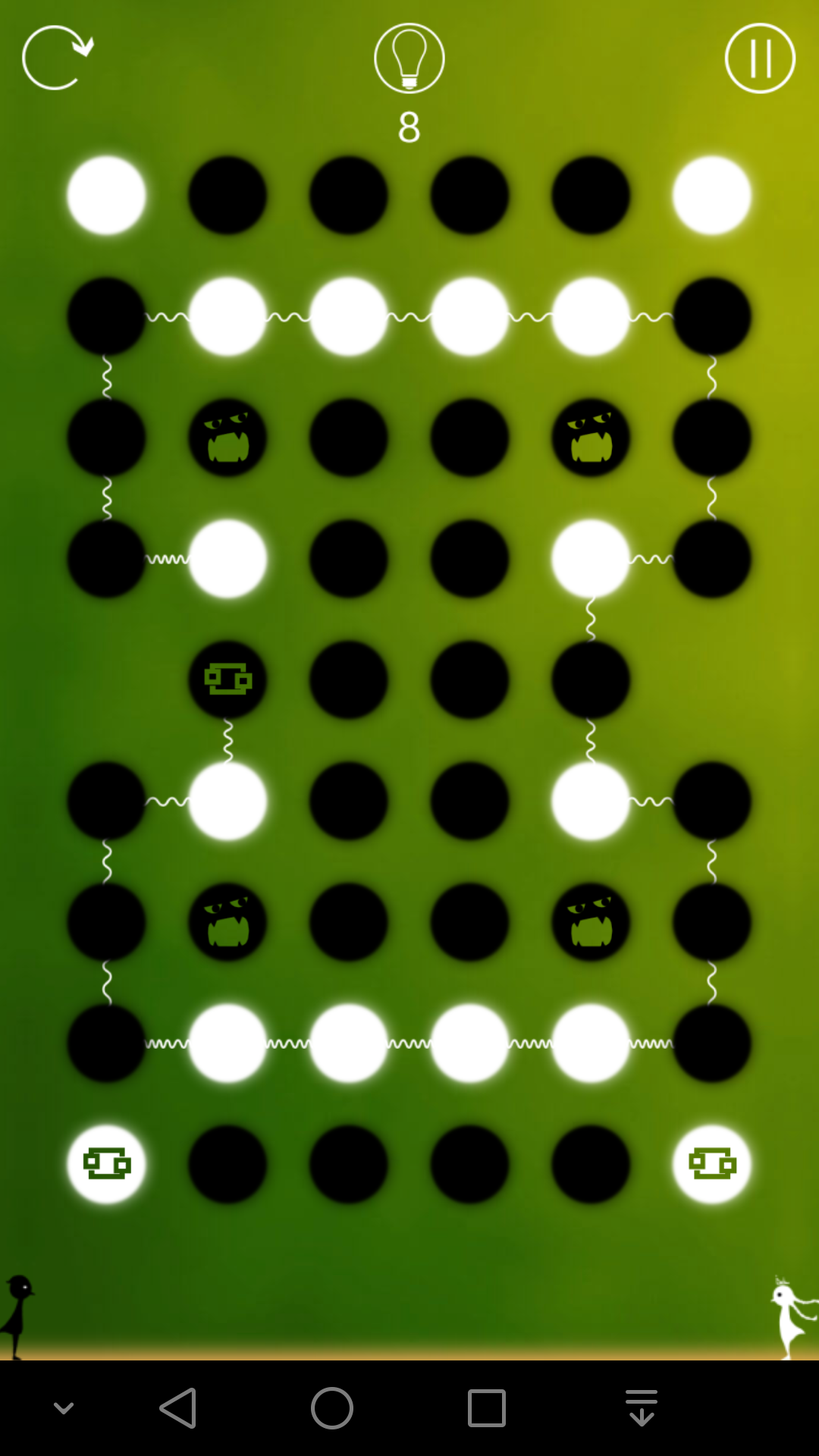

7,顺意

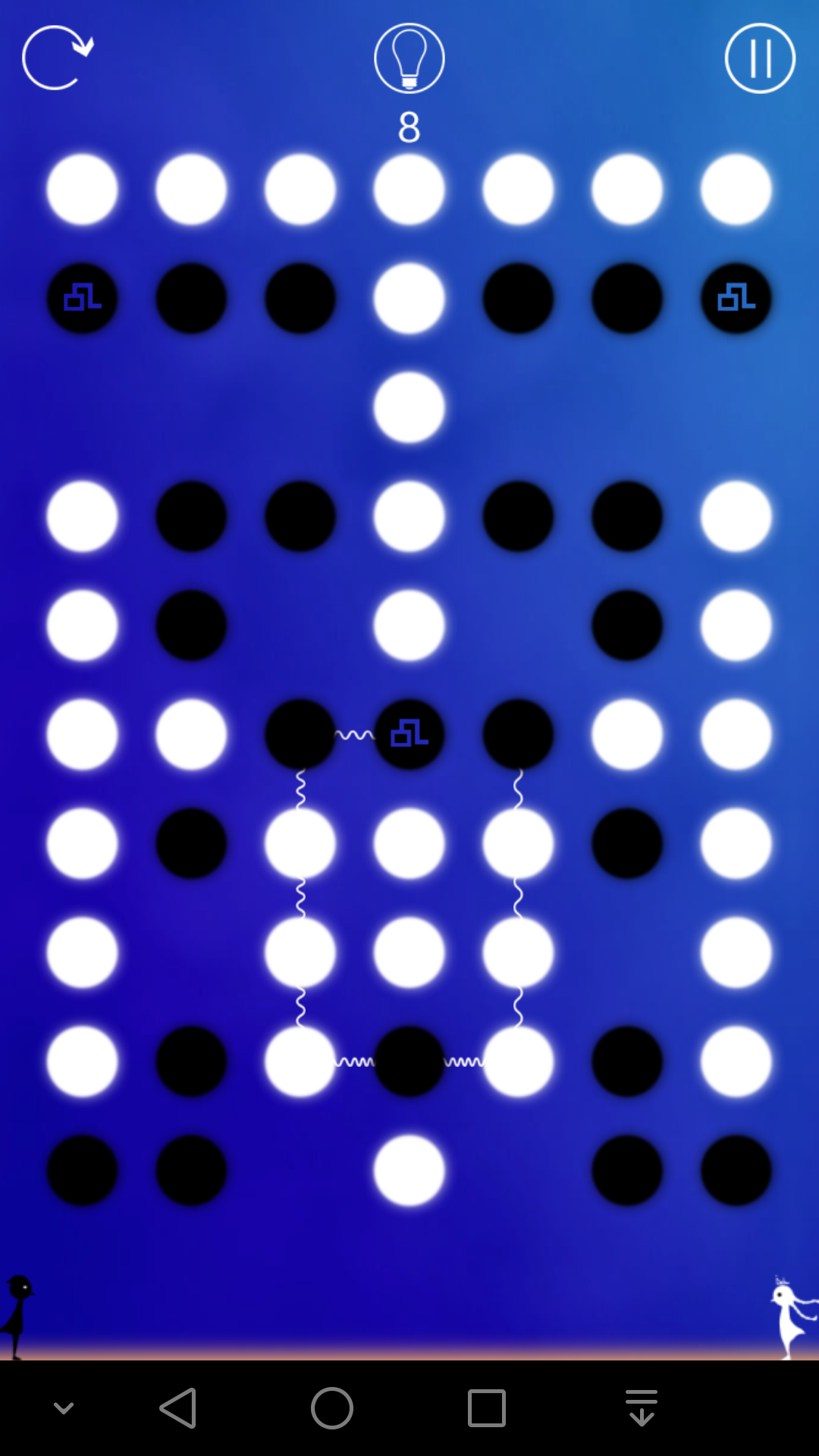

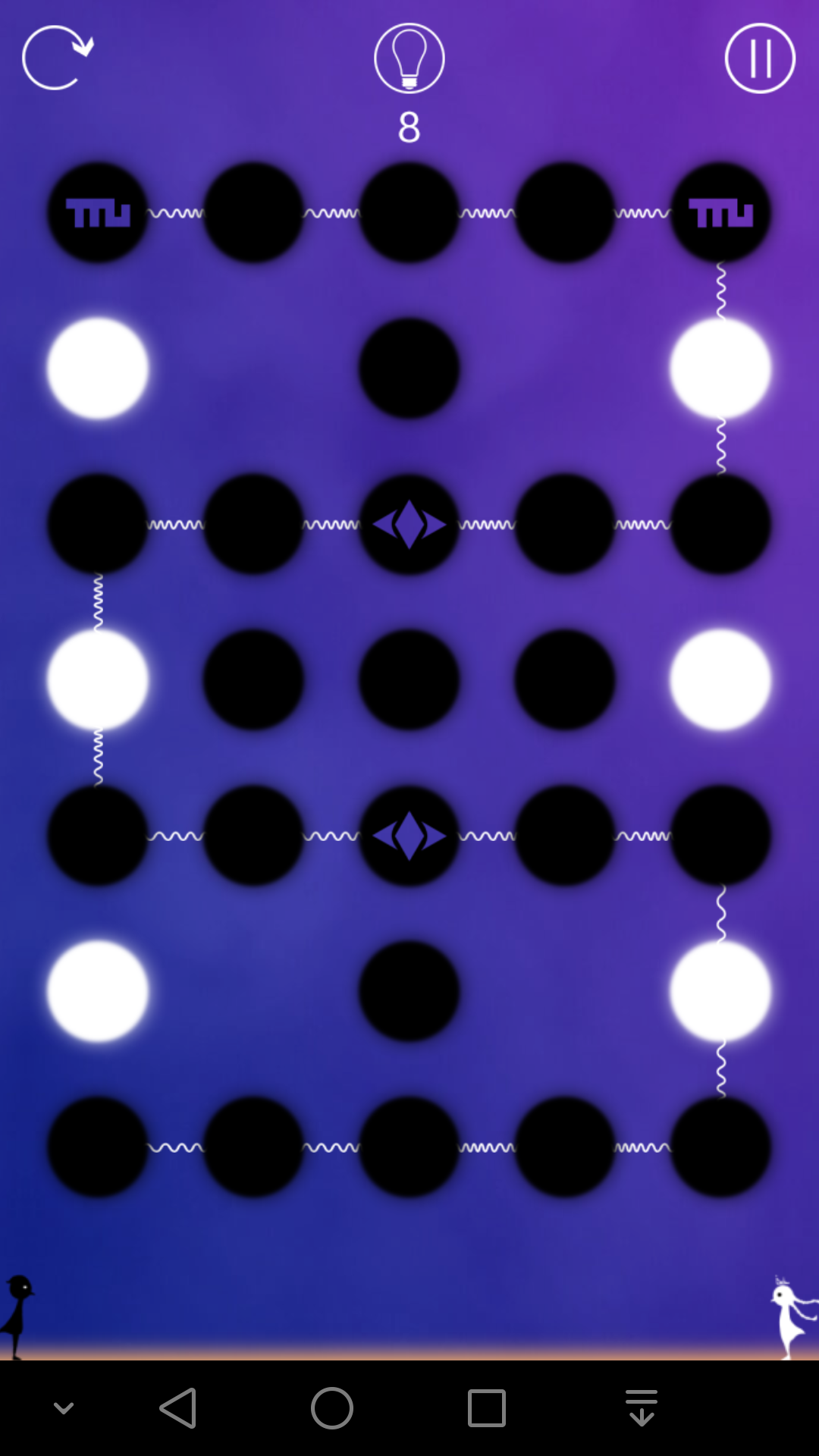

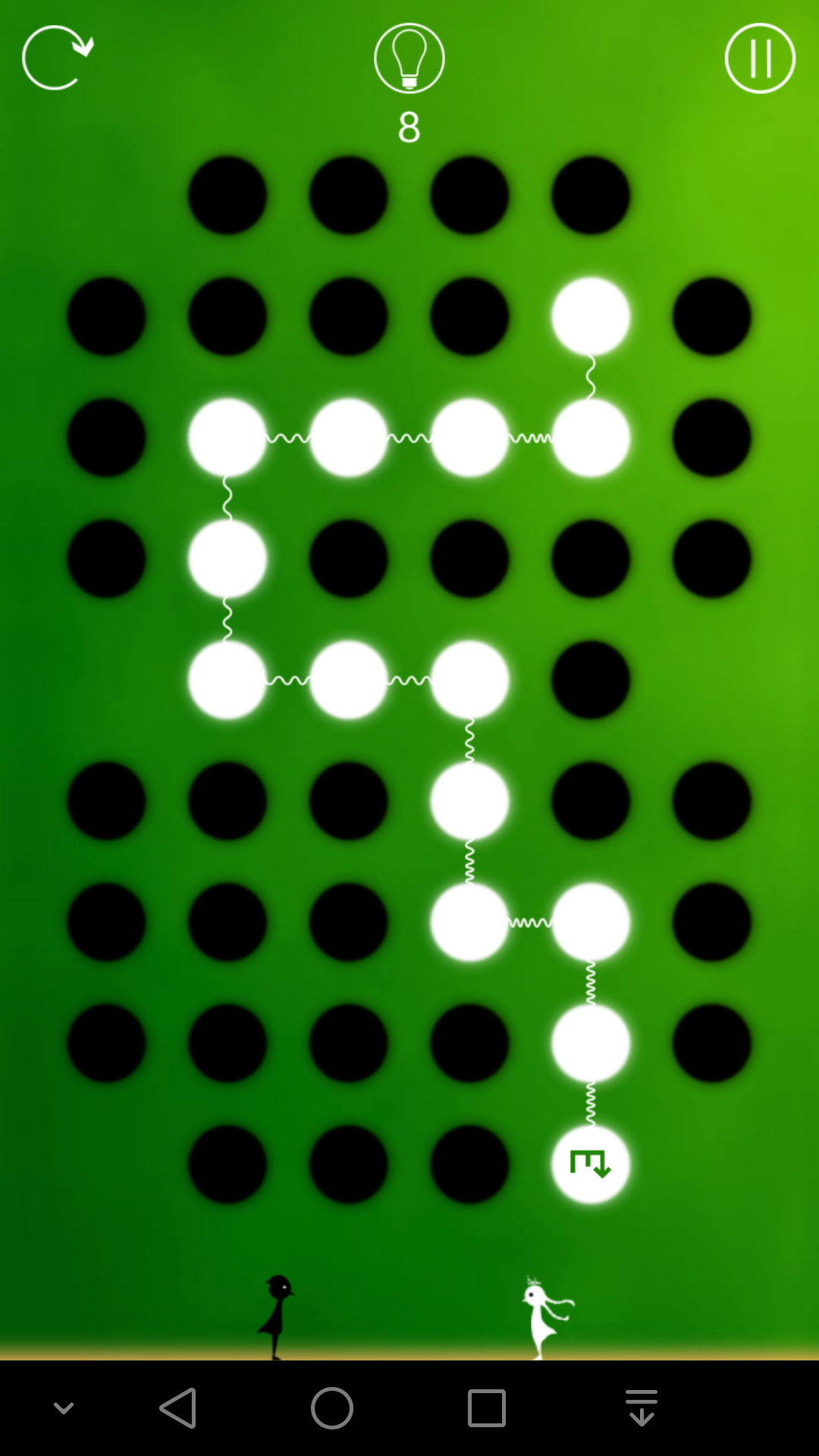

7-1

这一关和前面的不一样,这一关有8个特殊标记的黑格子,这些格子的颜色不能改变。

在前面,我所有的理论基本上是讲述两件事,第一,如何判断最后是全部变成白色,还是全部变成黑色,第二,如何利用对称性来寻找解法。

既然有些格子的颜色无法改变,那么第一点就不用管了,只需要考虑第二点。

实际上,我们可以理解成,这些不能变色的格子根本不存在(直接去掉),但是最后一定要把所有的点都变成某种颜色才能过关。

对于前面出现的规律三:“对于有3个起点的对称局面,如果有2个起点是对称的,那么往往先消掉第三个起点是比较好的方案(即这个思路比较容易找到答案)”,在经过大量的关卡验证之后,我们已经发现,这条规律可以非常有效的指导我们寻找对称解法,而且往往只要找到合适的第一路径,整个问题就已经基本上解决了。并且在此基础上,我们可以发现除了特殊情况下的规律四之外,这些第一路径还有着共同的规律。

较孤立点:如果一个点只有2个位置相对的邻居(即三点一线)甚至1个邻居,那么我们称之为较孤立点。

注:在考虑邻居的时候,要先去掉那些不能变色的格子,理由上面已经出现过。

规律五:在寻找第一路径的时候应该遵循2个原则,第一,路径的形状尽量简单,第二,在较孤立点很多的时候,路径应该尽量包含尽可能多的某种颜色的点,具体是哪种颜色,取决于对称的2个起点的具体位置。

注(关于形状):上面很多关卡都是形状很简单,比如矩形或者一条线段,6-1所示的第一路径也是矩形,因为前面提到过,路径不是边的集合而是点的集合。

注(关于尽可能多):尽可能多的待变色点,是排除掉一些特殊点的,而哪些点可以称为这里的特殊点,可以由局面本身直接判断出来。例如在6-12中(看做左右对称),对称轴上面有7个白点和2个黑点,那么第一路径一定是包含这2个黑点,而不包含这7个白点的,这可以根据我前面的理论算出来,这7个点就可以算作特殊点。我给出的第一路径包含了其他所有的白点。

注(关于某种颜色):在6-12中,白点不是待变色点,而在下面的7-5中,第一路径几乎包含所有白点,白点是待变色点。这和2个对称的起点的具体位置有关,用粗略的语言可以概括成:2个对称的起点所处位置的整齐程度。

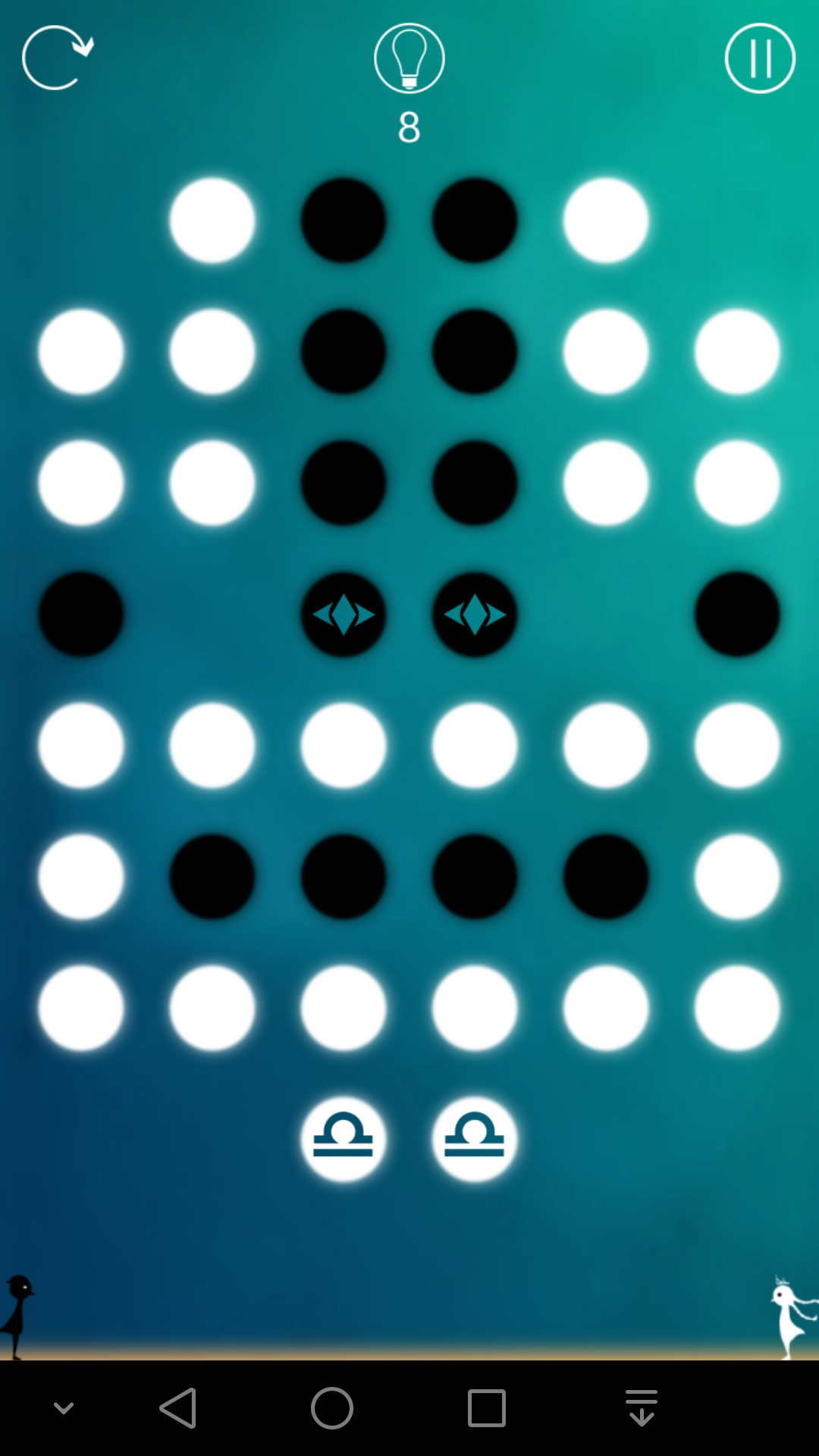

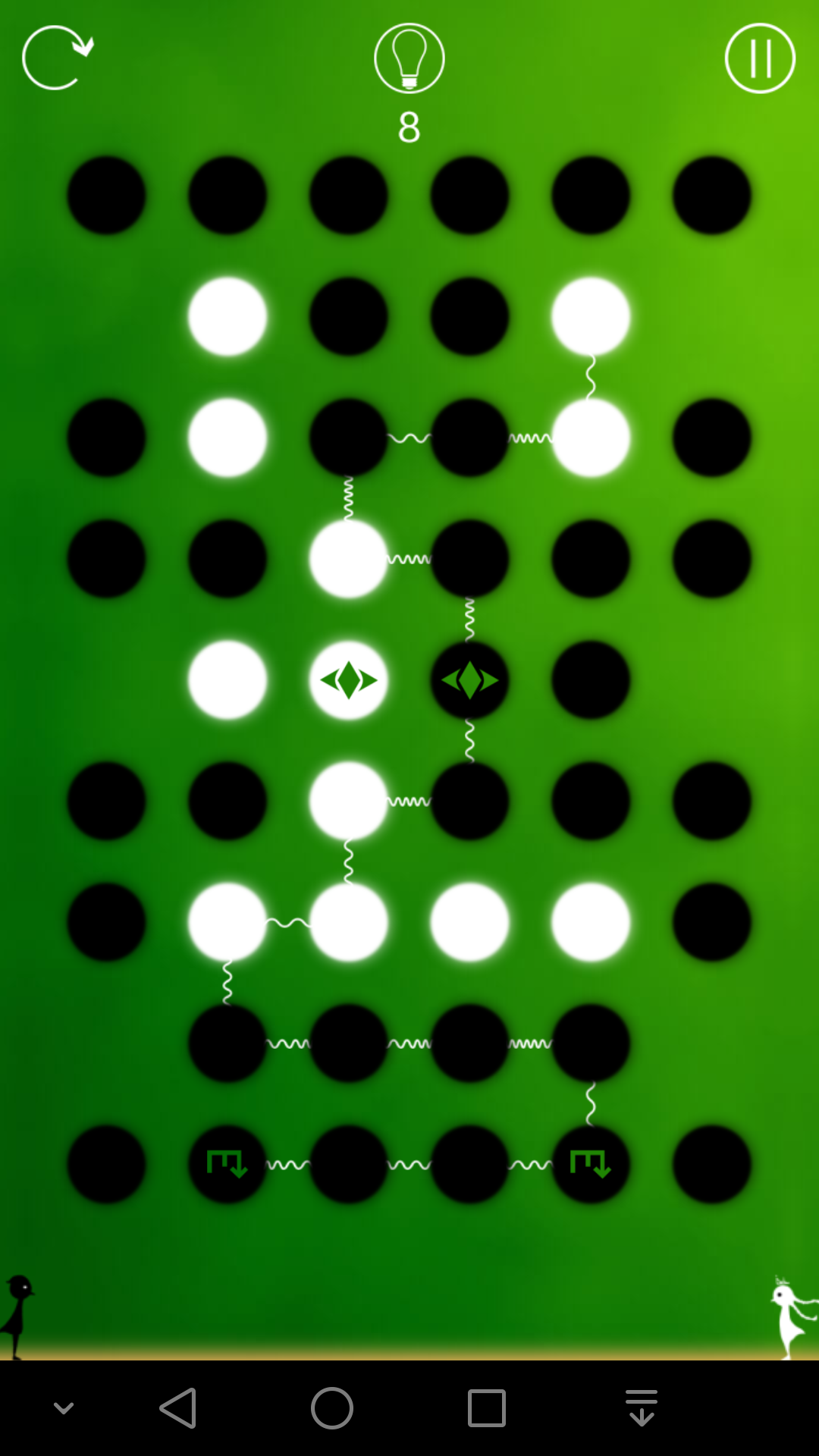

7-2

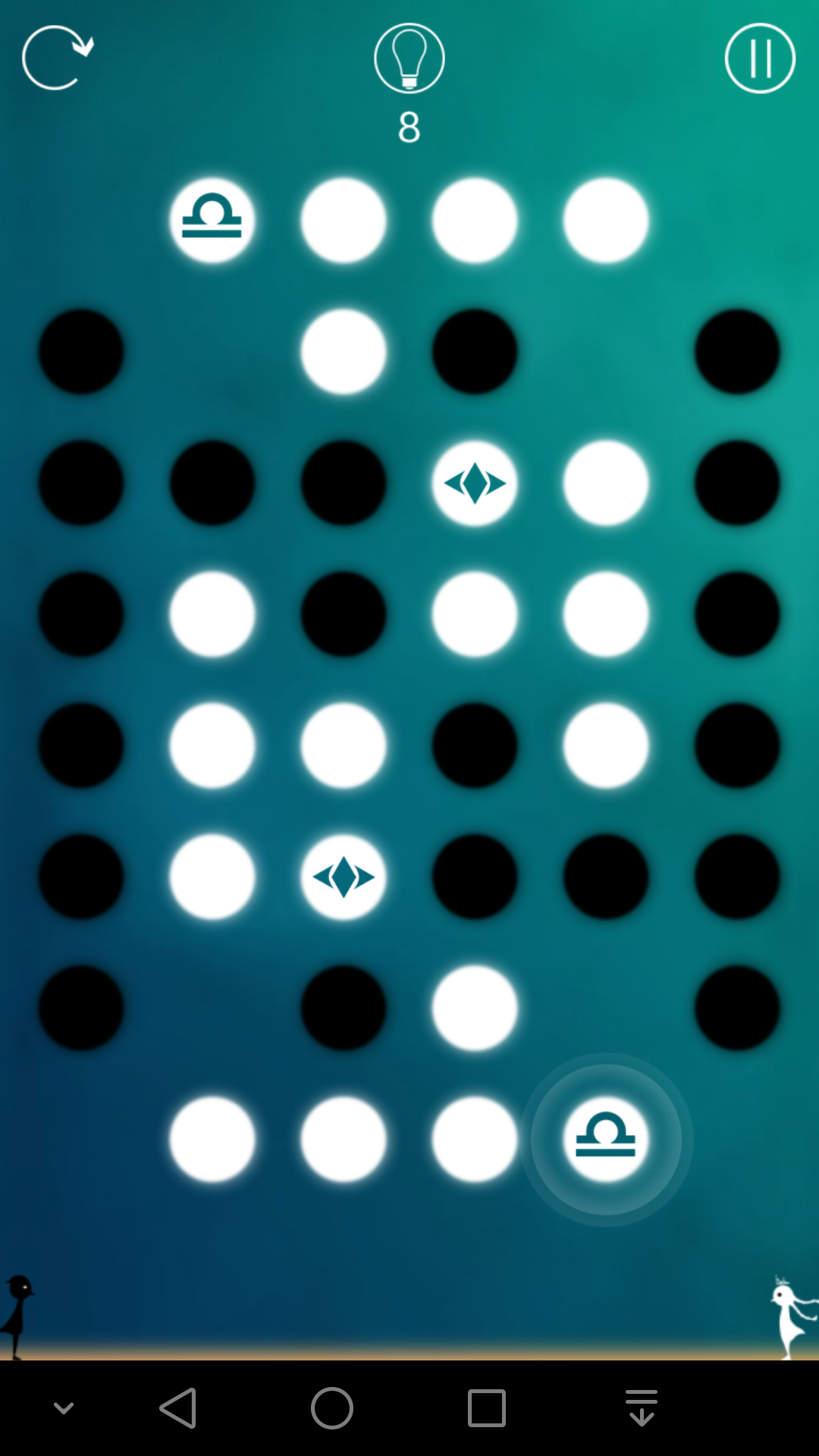

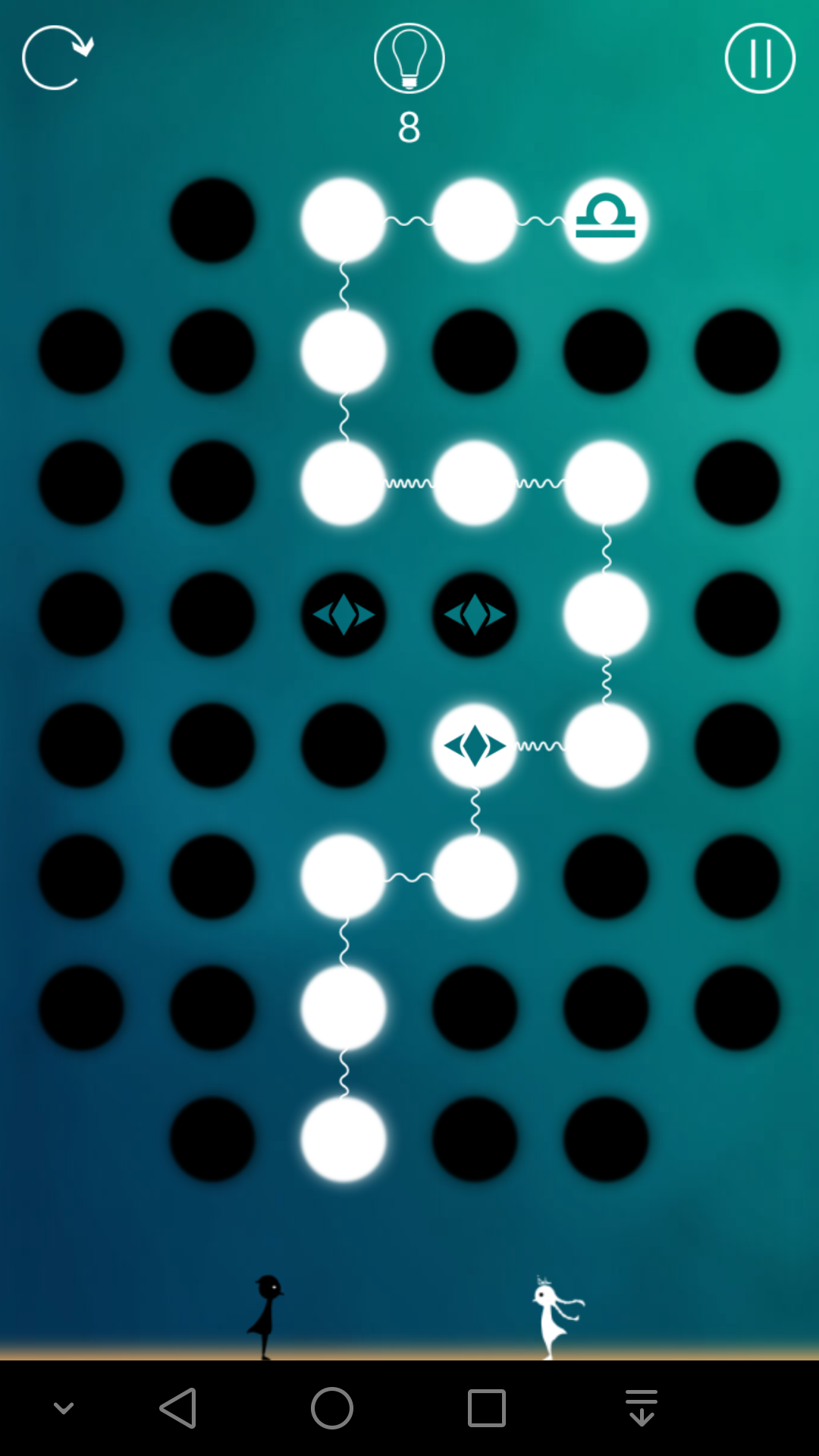

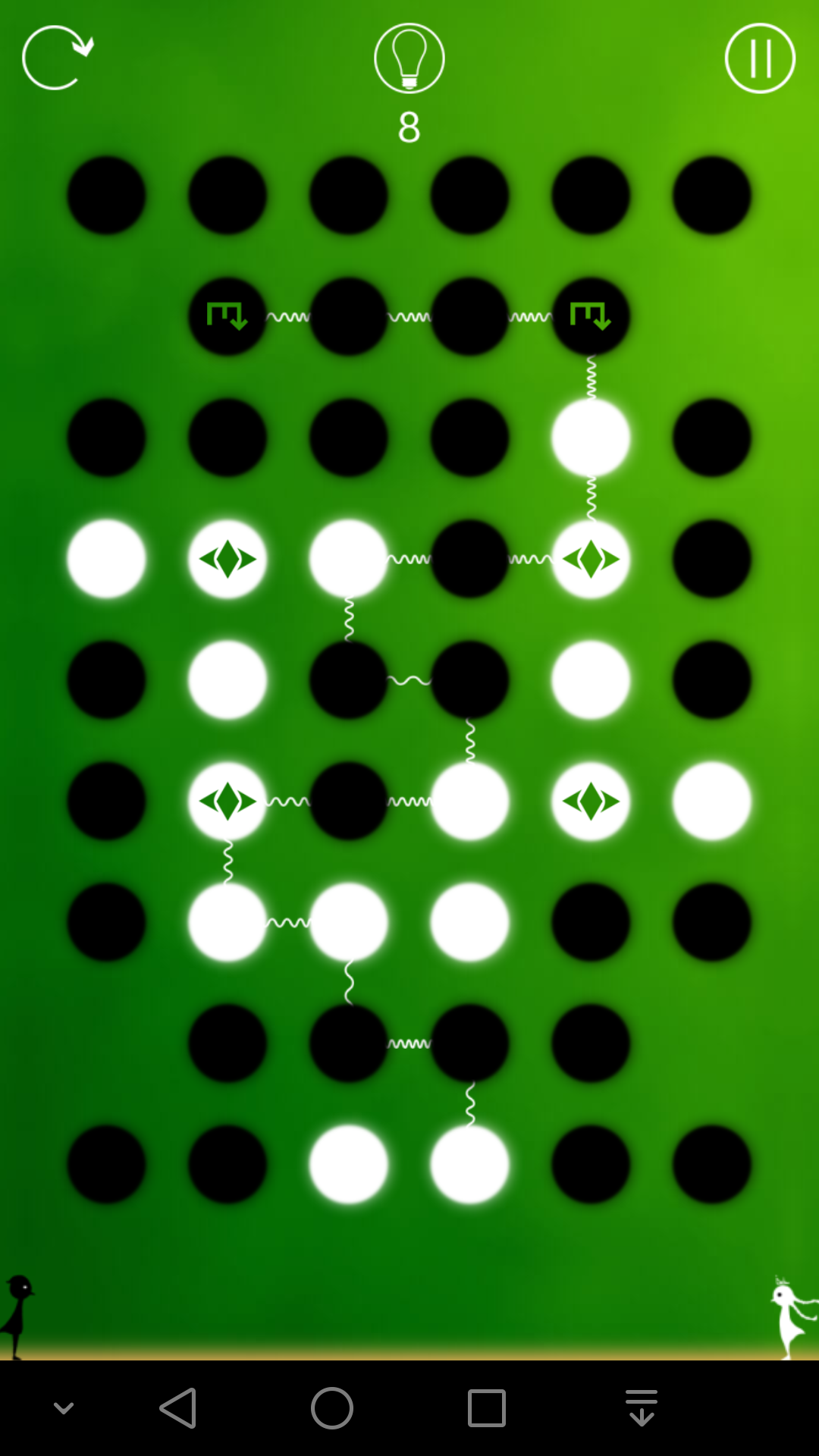

7-3

7-4

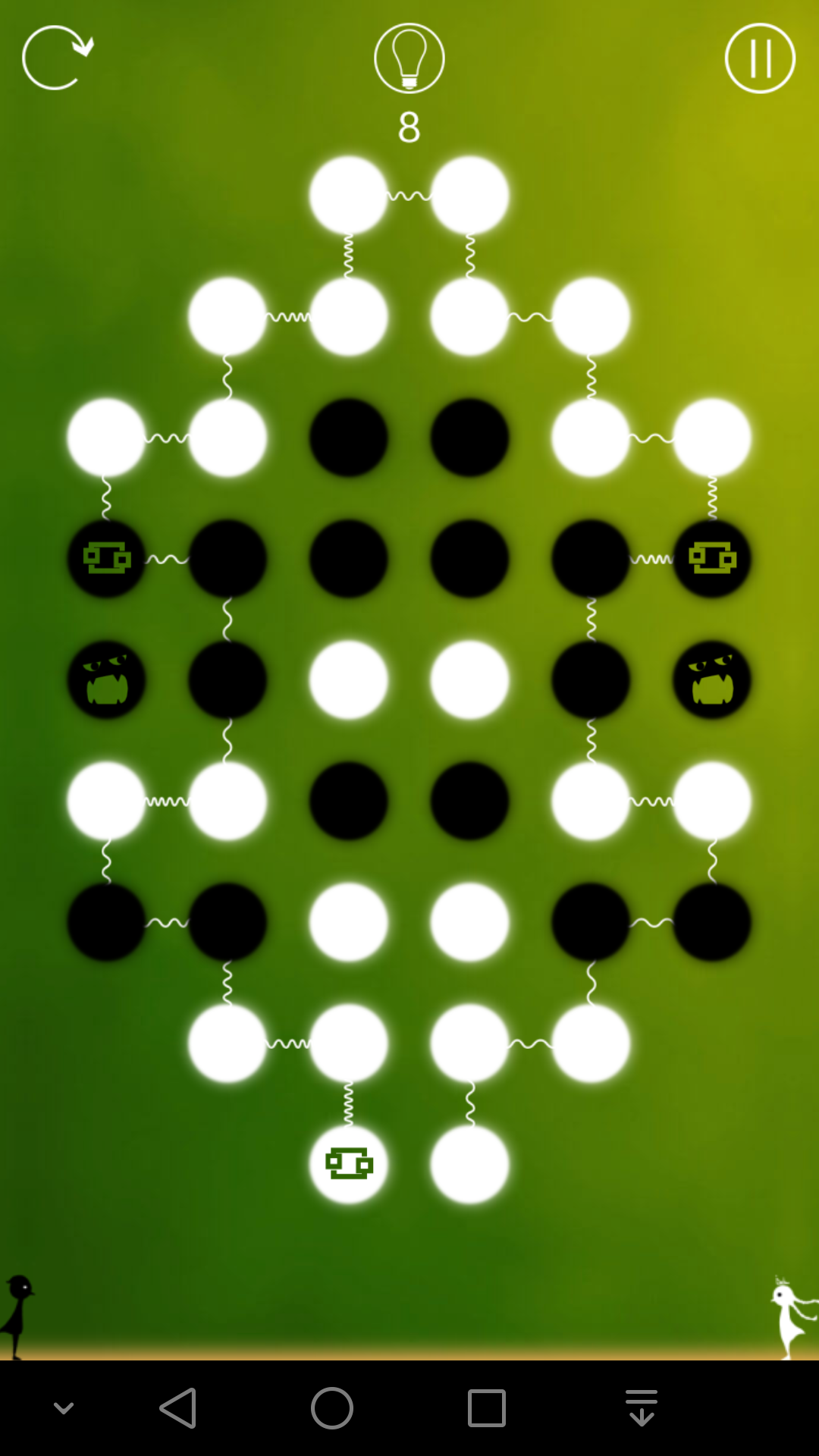

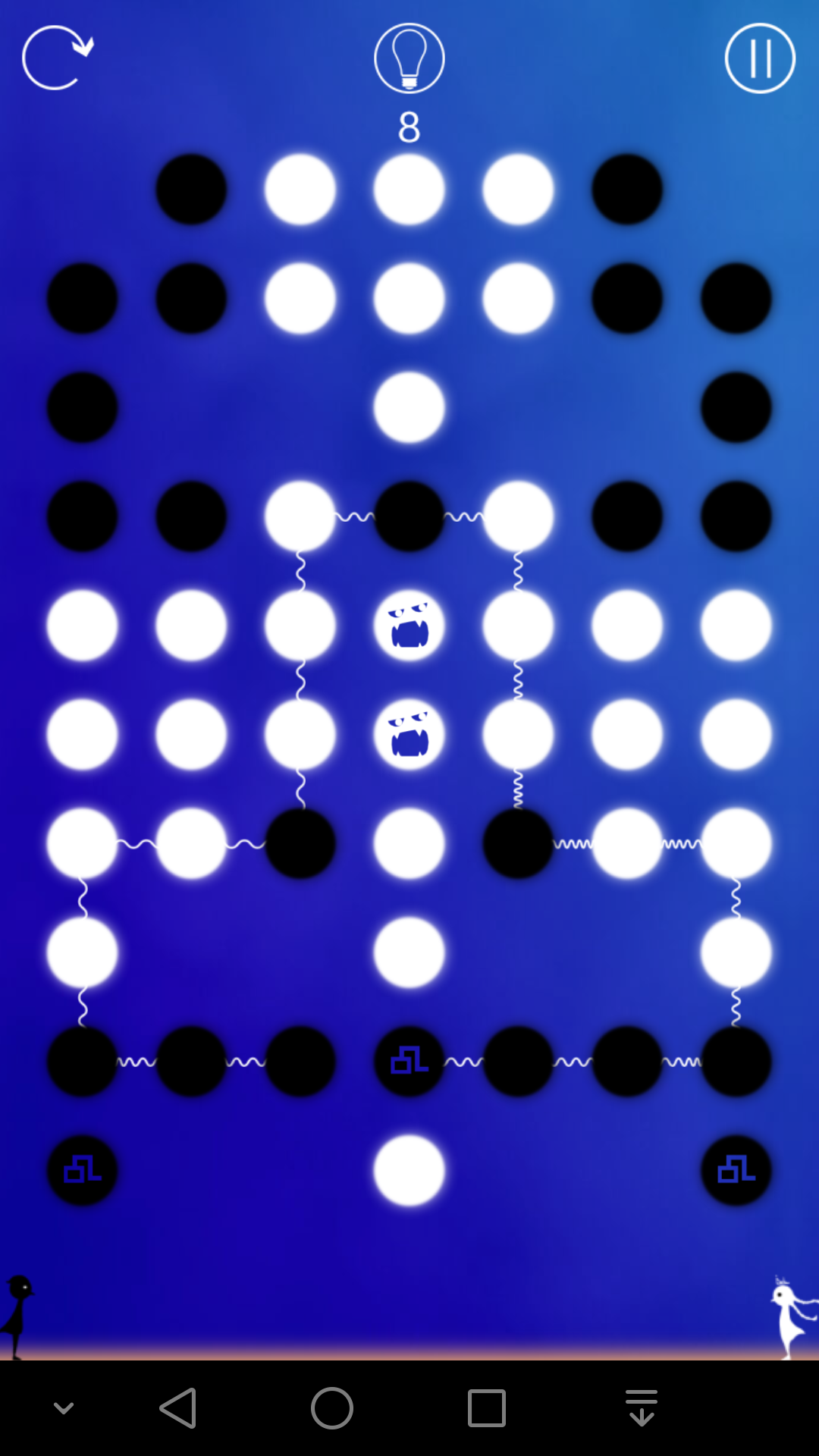

7-5

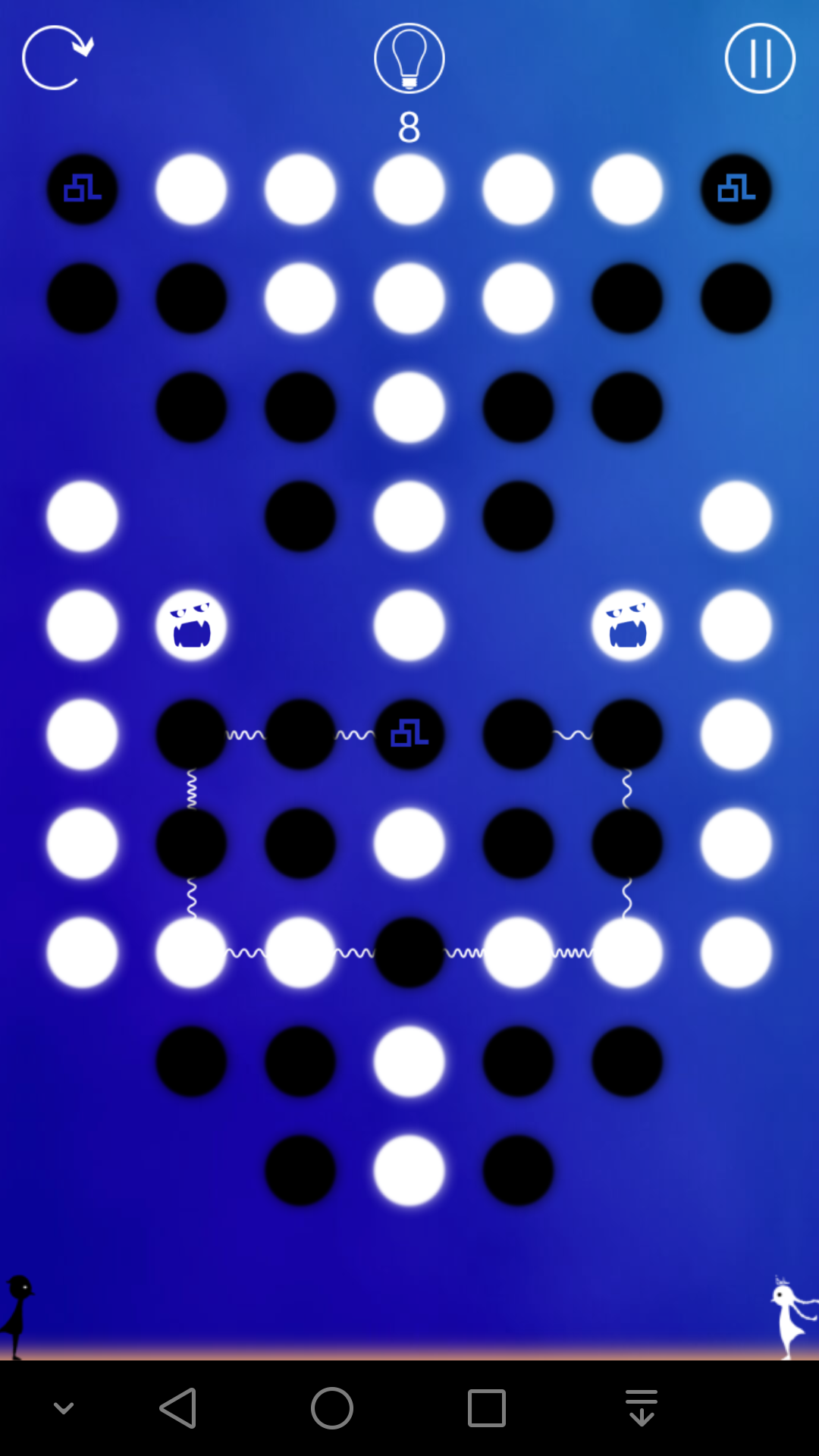

7-6

7-7

7-8

7-9

7-10

前面提到的方法都是针对对称的局面,因为不对称的局面很少而且都不难,所以没有详述。

这一关有一定的难度,除非发现这一点:以1为起点的路径必定经过2和4,而且不经过3。

实际上想到这一点很容易,但是证明这一点就不容易了。

首先,3条路径中,有2条是分别以7、8为终点的。

如果以1为起点的路径以7或8为终点,那么考虑点2、3、4、12不难发现,应该是无解的。(详情略)

以5、6位起点的路径分别以7、8为终点,那么这2条路径都满足,要么同时经过2、3、4,要么都不经过,所以先画完以1为起点的路径之后,2、3、4应该是一样的颜色,和9、10、11一样。

所以以1为起点的路径必定经过2和4,而且不经过3。

7-11

7-12

8,萌芽

8-1

8-2

8-3 8-4 8-5

8-6

8-7 8-8 8-9

8-10 8-11

8-12

9,时光

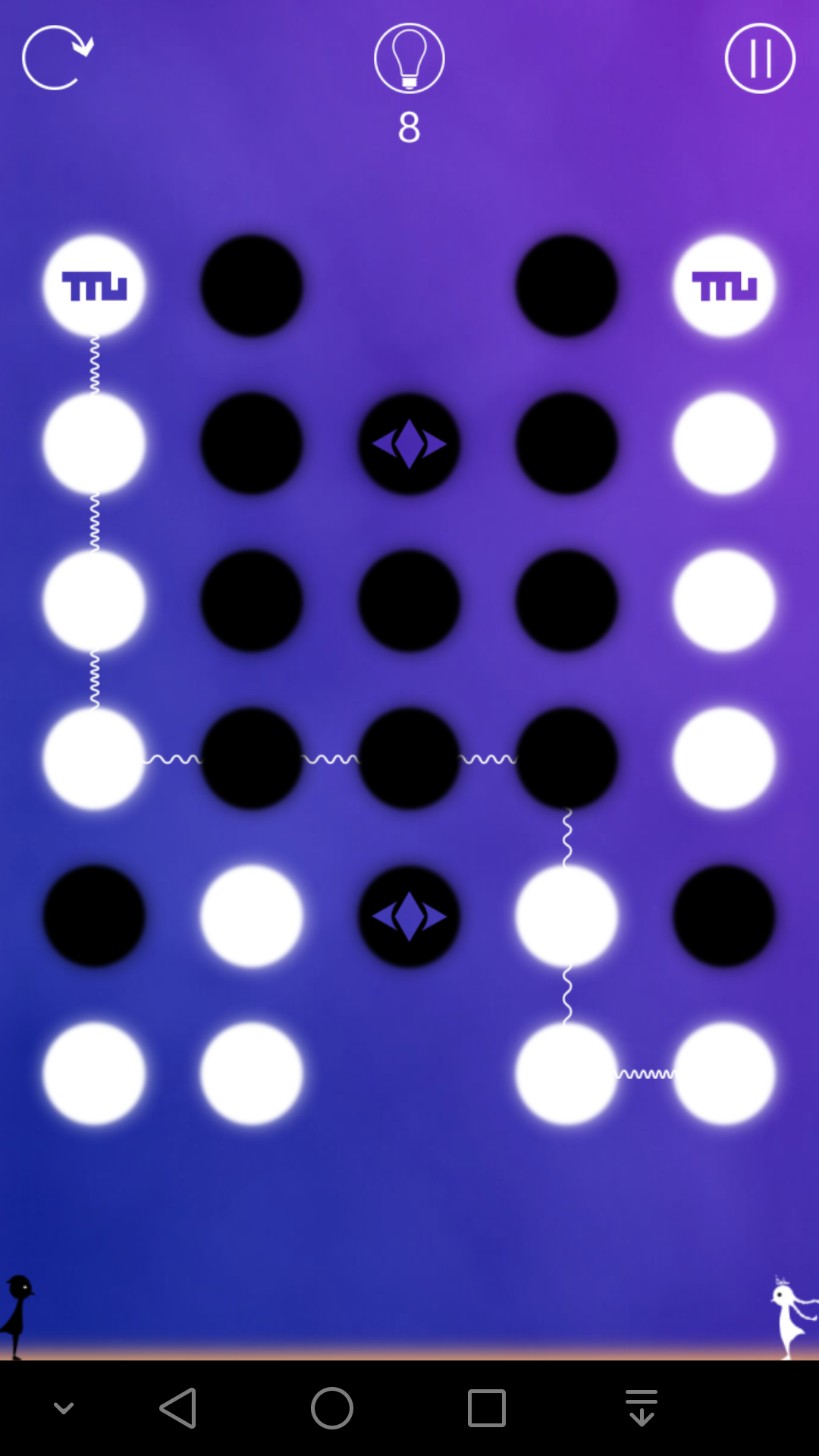

9-1

9-2

可以看出来,一个陷阱引起的空间塌陷现象只能出现一次,一次之后陷阱所在的点就会变成普通点。

那么对于每个陷阱来说,有2种情况,第一,在所有路径中,至少有一条是经过陷阱的,第二,任何路径都不经过陷阱。

按照游戏设计的原则来说,第二种情况讲道理应该是很少见的,到底是哪种情况很容易分析出来。

注意,无论是第一种情况还是第二种情况,陷阱所在的点既可能是待变色点,也可能不是待变色点,没有直接的对应关系。

分析出了陷阱是哪种情况之后,就可以在游戏开始之前预先去掉陷阱的效果了。

规律六:如果是第一种情况,相当于直接将陷阱的4个邻居变色,然后去掉陷阱效果,下面的9-3里面有图解,如果是第二种情况,相当于直接去掉陷阱效果。

9-3

这2个其实是一样的,所以答案很简单

9-4

因为对称解法要求对称轴必须是纯色的,所以这2个陷阱都不经过。

9-5

9-6

很明显最后一定是全部变成黑色,而且陷阱一定要经过的,所以答案不难找到。

9-7

9-8

9-9

按照上下对称的原则找答案

9-10

9-11

9-12

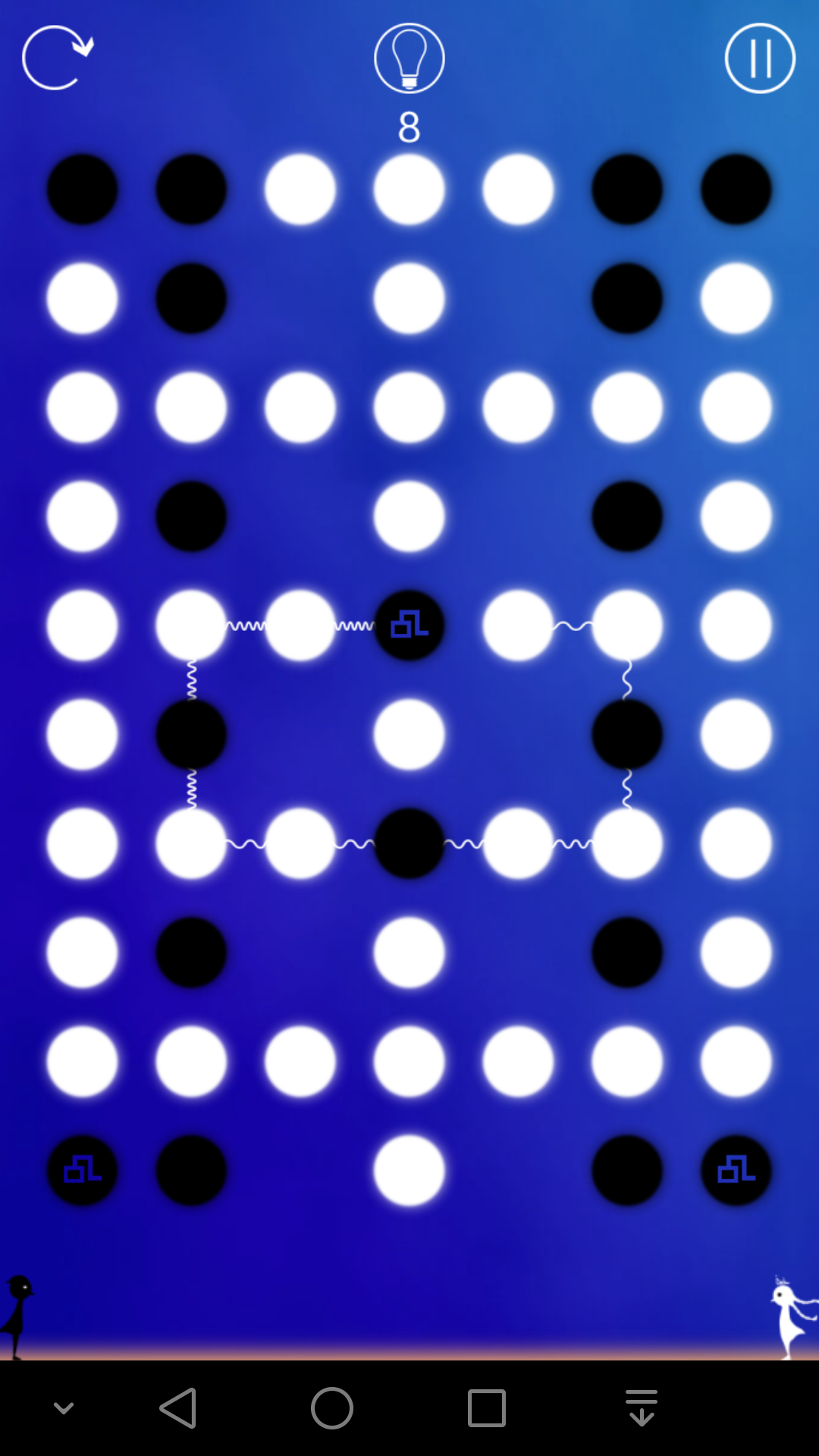

10,前奏

10-1

10-2

10-3

10-4

10-5

10-6

10-7

10-8

10-9

10-10

10-11

10-12

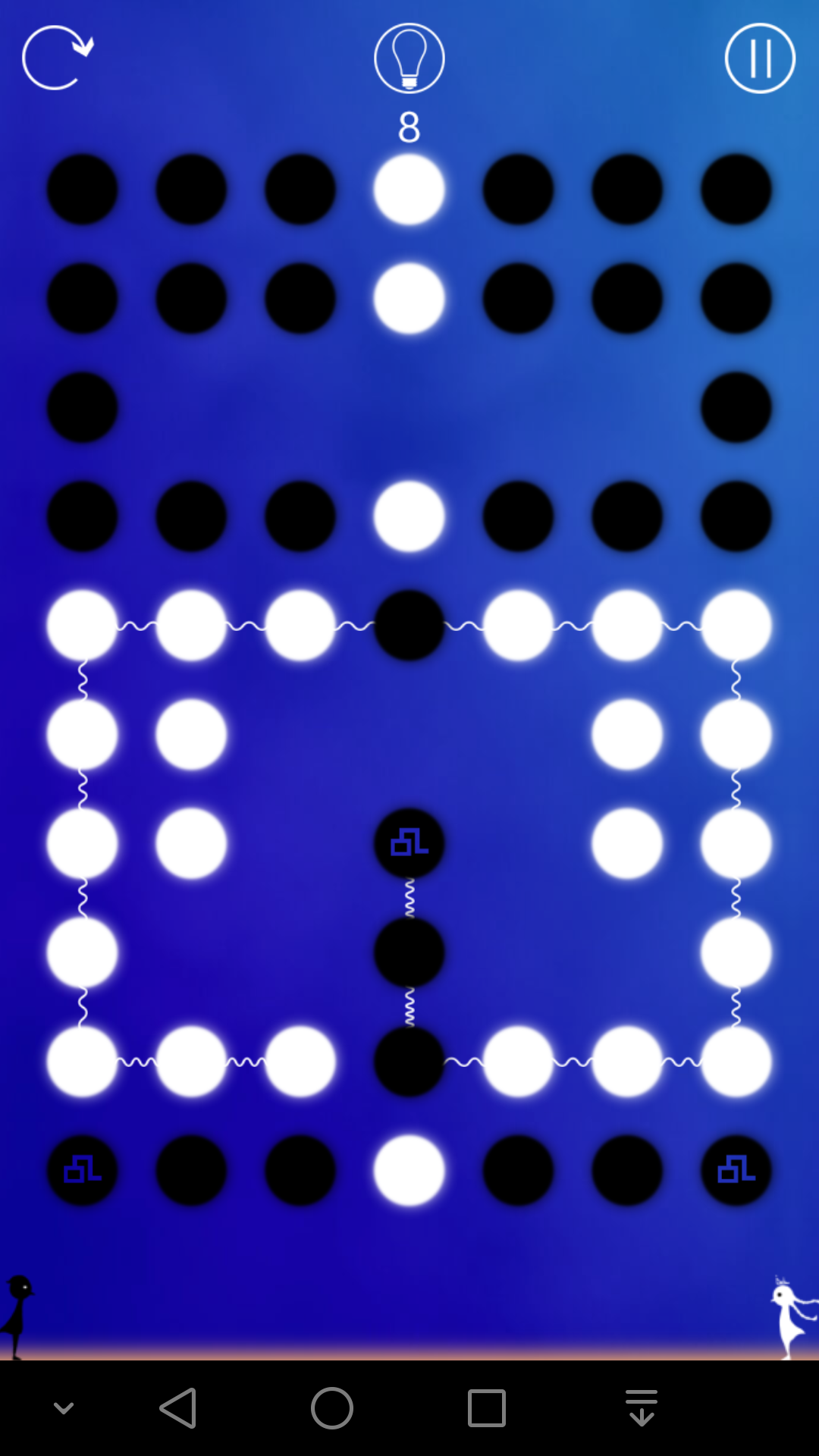

11,命运

11-1

11-2

11-3

11-4

11-5

11-6

11-7

11-8

11-9

11-10

11-11

11-12

本文提供了一个游戏谜题的详细解法指南,包括如何利用对称性寻找解法、特殊标记格子的影响及陷阱机制的应对策略等核心内容。

本文提供了一个游戏谜题的详细解法指南,包括如何利用对称性寻找解法、特殊标记格子的影响及陷阱机制的应对策略等核心内容。

1万+

1万+