sparse_categorical_crossentropy 与 binary_crossentropy的区别。

可以看看书本作者的阐述

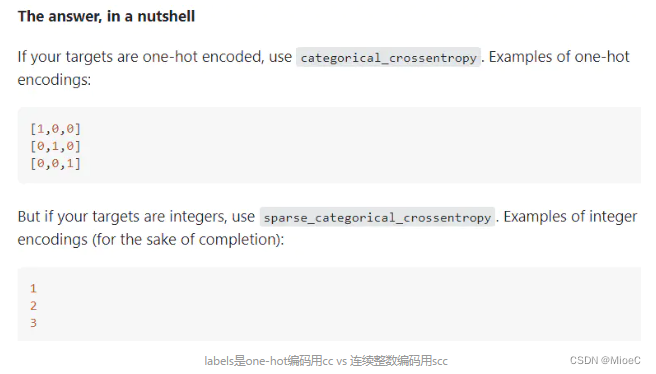

原文意思为:看你输出的是什么格式的

one-hot 的话用categorical_crossentropy

数字编码的话用sparse_categorical_cossentropy

实际使用过程中, 如果数量少的话可以用one—hot格式

而大量的分类,如1000个分类的话,会占用大量的空间并且提升算法复杂度,所以最好选择数字编码。

categorical_crossentropy 与 binary_crossentropy的区别

一个用于多分类,一个用于二分类

本文详细介绍了在深度学习中,sparse_categorical_crossentropy与categorical_crossentropy的区别,以及它们与binary_crossentropy的不同。前者适用于数字编码的多分类问题,后者用于one-hot编码的多分类,而binary_crossentropy则专门用于二分类任务。在实际应用中,当类别数量较少时,推荐使用one-hot编码,而大量类别时,数字编码更为高效。理解这些损失函数对于优化模型性能至关重要。

本文详细介绍了在深度学习中,sparse_categorical_crossentropy与categorical_crossentropy的区别,以及它们与binary_crossentropy的不同。前者适用于数字编码的多分类问题,后者用于one-hot编码的多分类,而binary_crossentropy则专门用于二分类任务。在实际应用中,当类别数量较少时,推荐使用one-hot编码,而大量类别时,数字编码更为高效。理解这些损失函数对于优化模型性能至关重要。

1608

1608

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?