文章目录

第一节 激活函数

1.基本情况

权重,激励函数,损失函数,反向传播,优化函数,5个任务。

2.全连接层网络

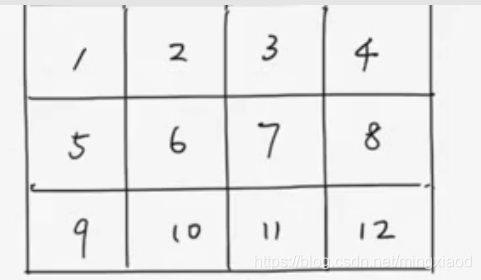

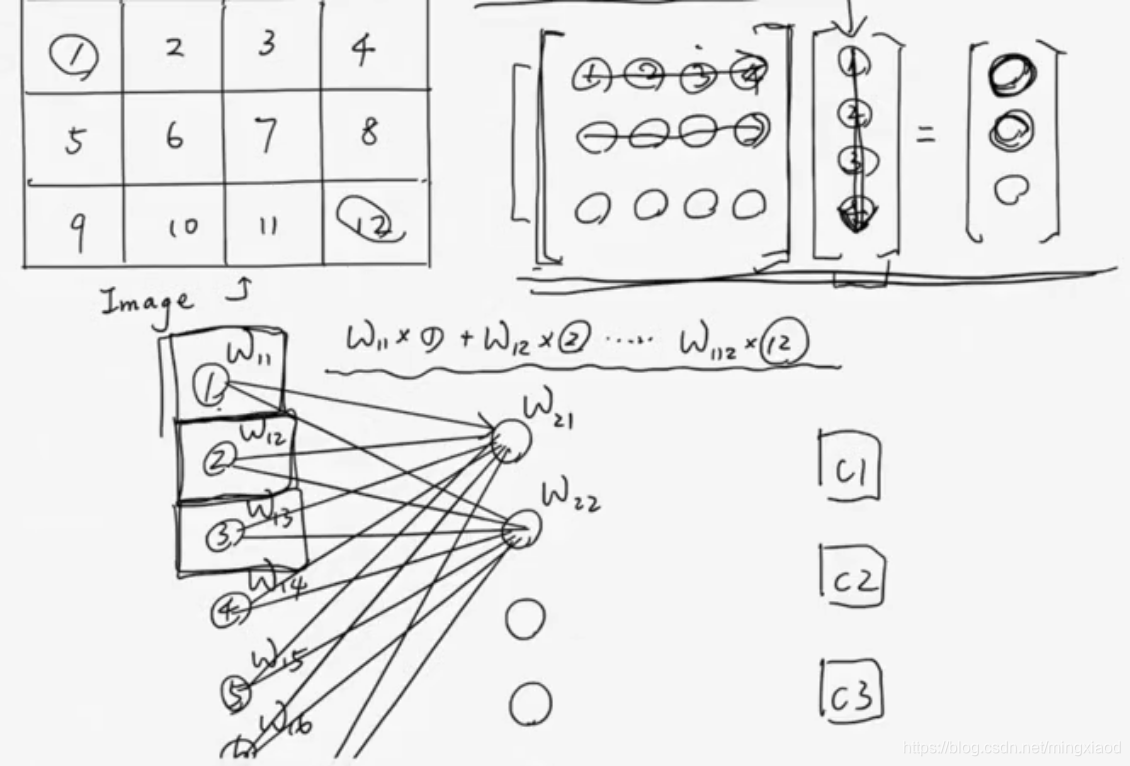

以34的照片为例:

首先将图片展开为一维向量,如下所示:

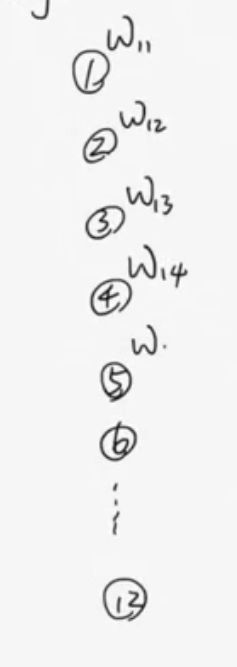

每个像素值配有权重,每设置12个参数值,与12个像素值进行计算,然后输入下一层的神经元当中,设置权重的数目由第二层的神经元个数决定。即:若第二层神经元有4个,则可以表示为矩阵的运算,412的权重矩阵乘以121的像素值,最后得到41的矩阵,作为下一层的输入值。

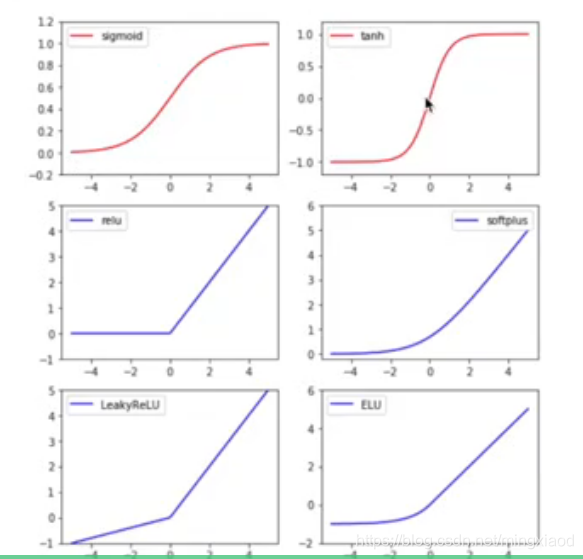

3.激活函数

sigmoid和tanh激活函数缺点:

当网络加深时,由于激活函数两端和中间梯度变化巨大,当如何当数据处于某个端点指时,经过多层训练之后,可能会把这些这些数据归为同一类。所以在深层神经网络中常见的网络是relu。

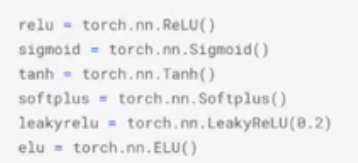

pytorch中调用激活函数:

首先激活函数都是由封装的类构成,所以在调用的时候需要先赋值给一个实例,然后通过实例来进行来添加参数。

导入:

调用:

第二节 损失函数

1.回归损失函数

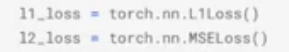

L1loss和L2loss表达式:

pytorch中的损失函数:

L1_loss = torch.nn.L1Loss()

L2_loss = torch.nn.MSELoss()#L2loss并不叫做L2Loss

2.分类损失函数

在分类任务中,当分类的对象为非数字类的数据格式时,需要对数据进行数据格式的转化,如下采用独热编码。

(1)独热编码转化

LabelEncoder:标签编码

OneHotEncoder:独热编码

LabelEncoder和OneHotEncoder 在特征工程中的应用:

参考博客链接:https://blog.youkuaiyun.com/accumulate_zhang/article/details/78510571

在分类和聚类运算中我们经常计算两个个体之间的距离,对于连续的数字(Numric)这一点不成问题,但是对于名词性(Norminal)的类别,计算距离很难。即使将类别与数字对应,例如{‘A’,‘B’,‘C’}与[0,1,2]对应,即LableEncoder,但我们也不能认为A与B,B与C距离为1,而A与C距离为2。独热编码正是为了处理这种距离的度量,该方法认为每个类别之间的距离是

本文详细介绍了深度学习的基础知识,包括激活函数(如sigmoid和relu)、损失函数(如L1loss、L2loss、Hinge Loss和交叉熵损失函数)及其在PyTorch中的实现,以及反向传播和优化算法(如Batch Gradient Descent、Stochastic Gradient Descent、Adam等)。重点讨论了不同损失函数和优化器的特点和应用场景。

本文详细介绍了深度学习的基础知识,包括激活函数(如sigmoid和relu)、损失函数(如L1loss、L2loss、Hinge Loss和交叉熵损失函数)及其在PyTorch中的实现,以及反向传播和优化算法(如Batch Gradient Descent、Stochastic Gradient Descent、Adam等)。重点讨论了不同损失函数和优化器的特点和应用场景。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

37万+

37万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?