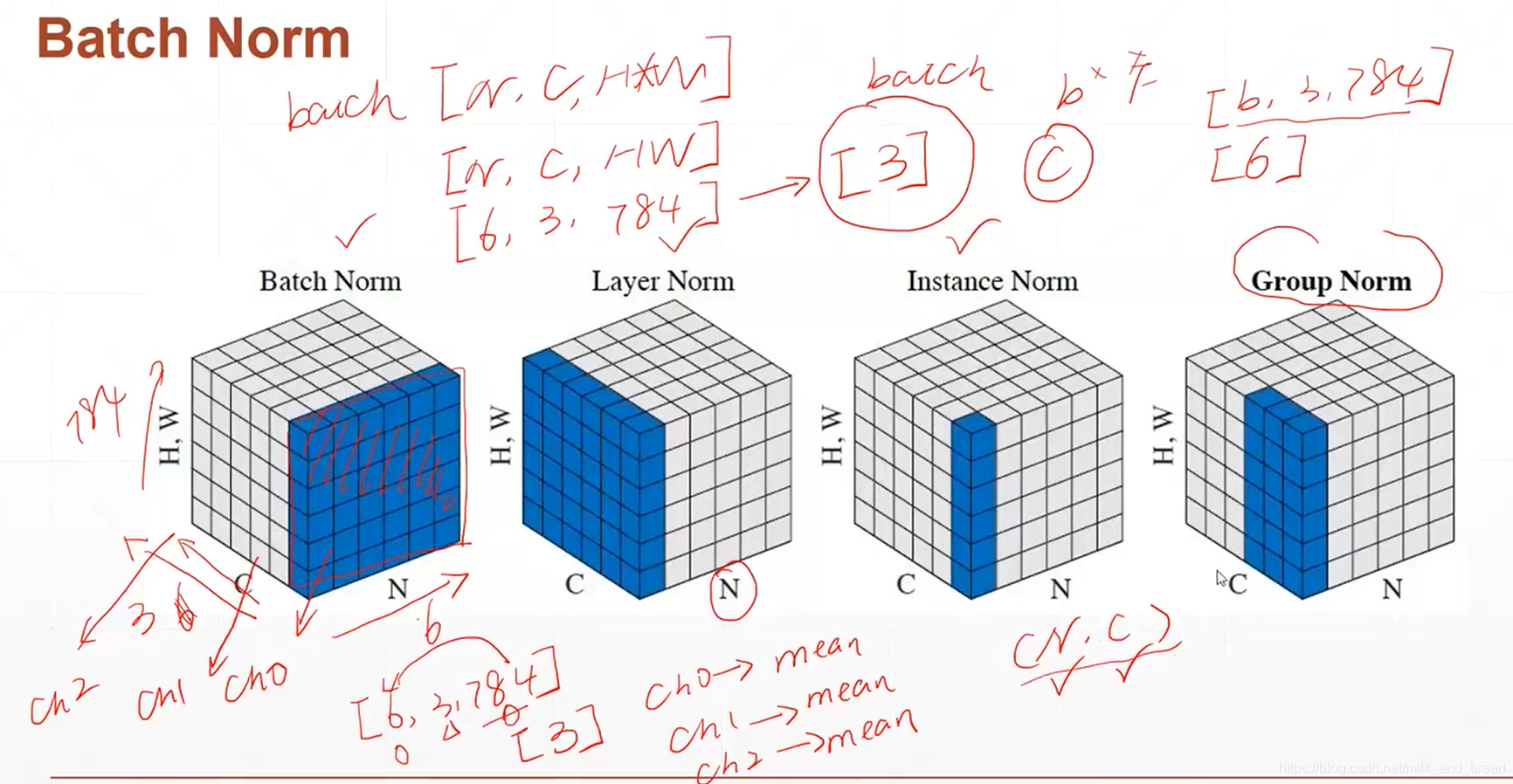

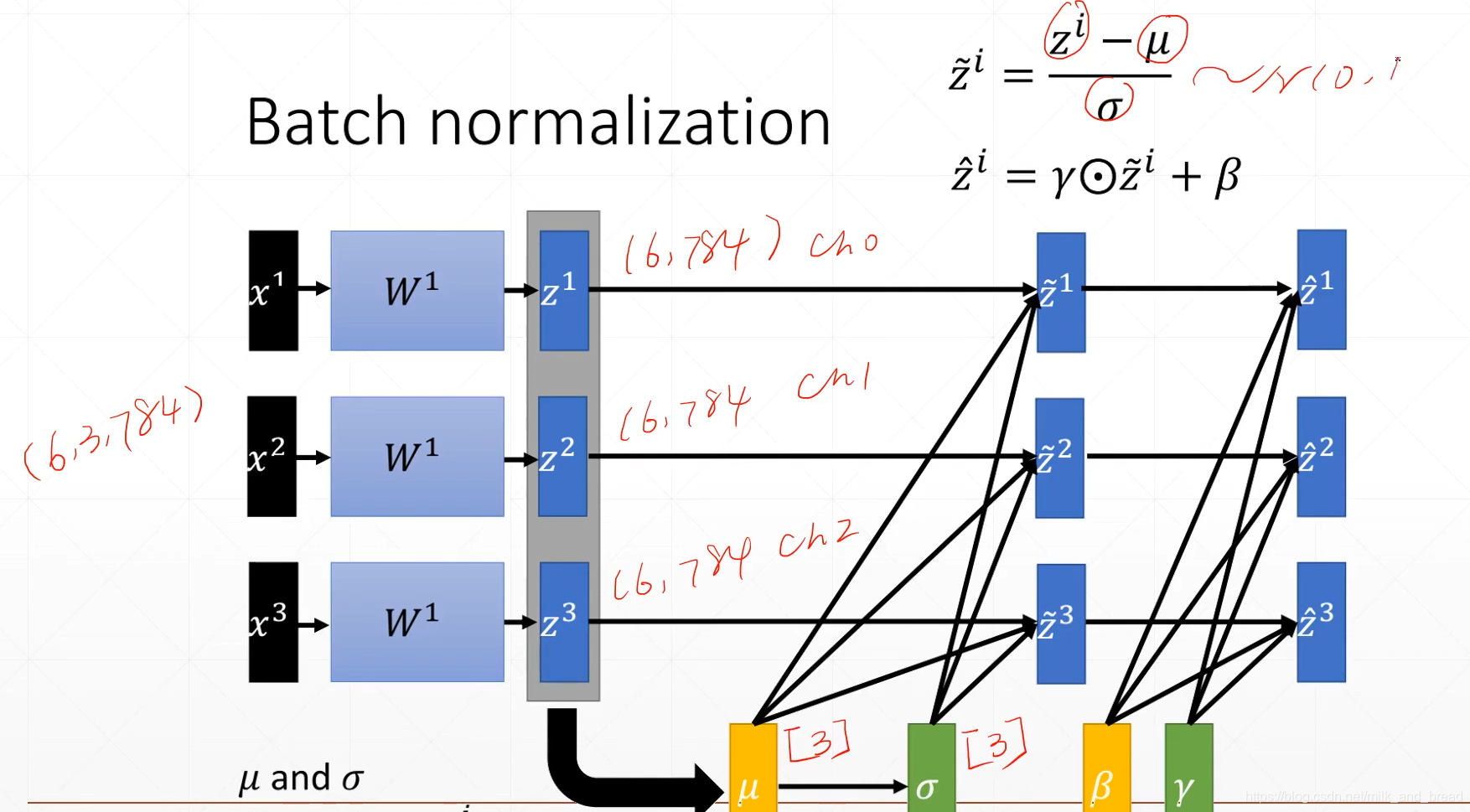

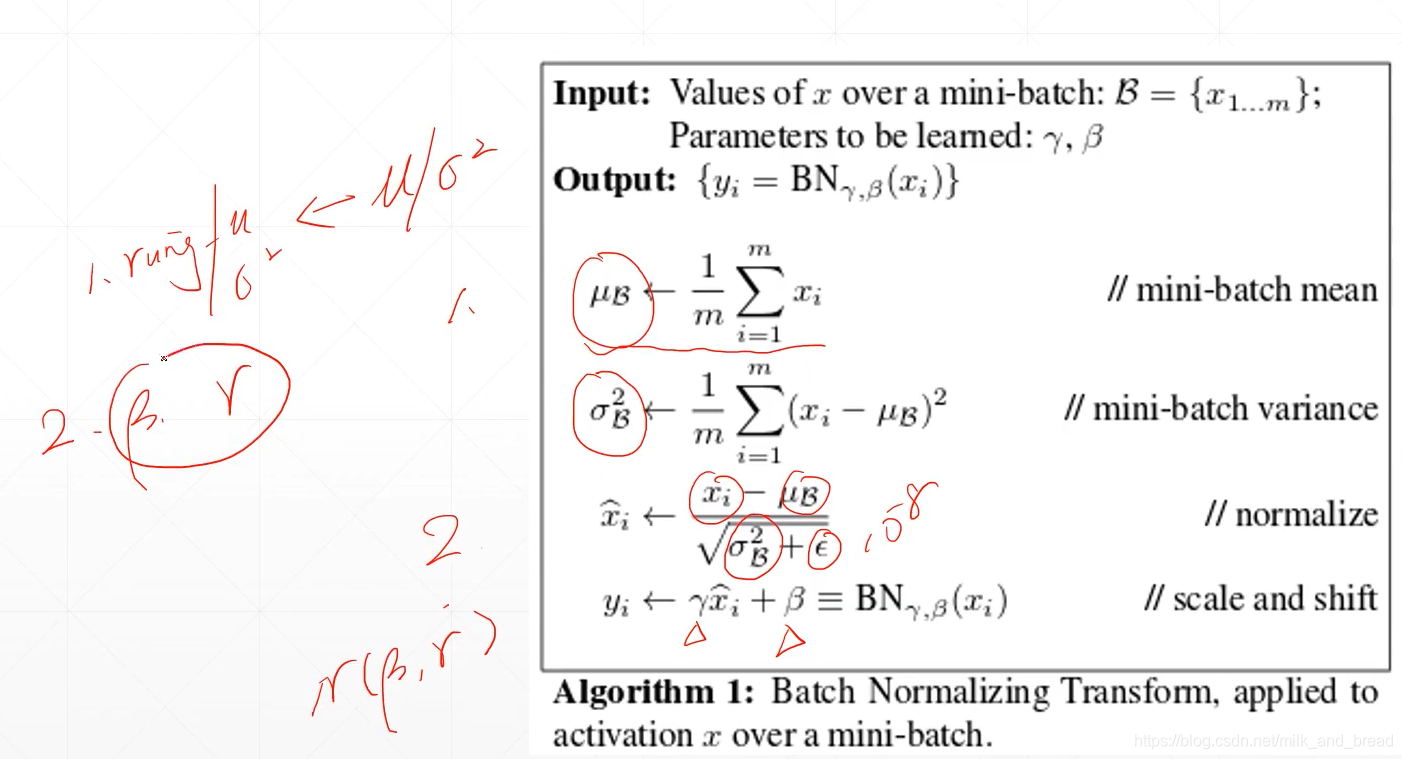

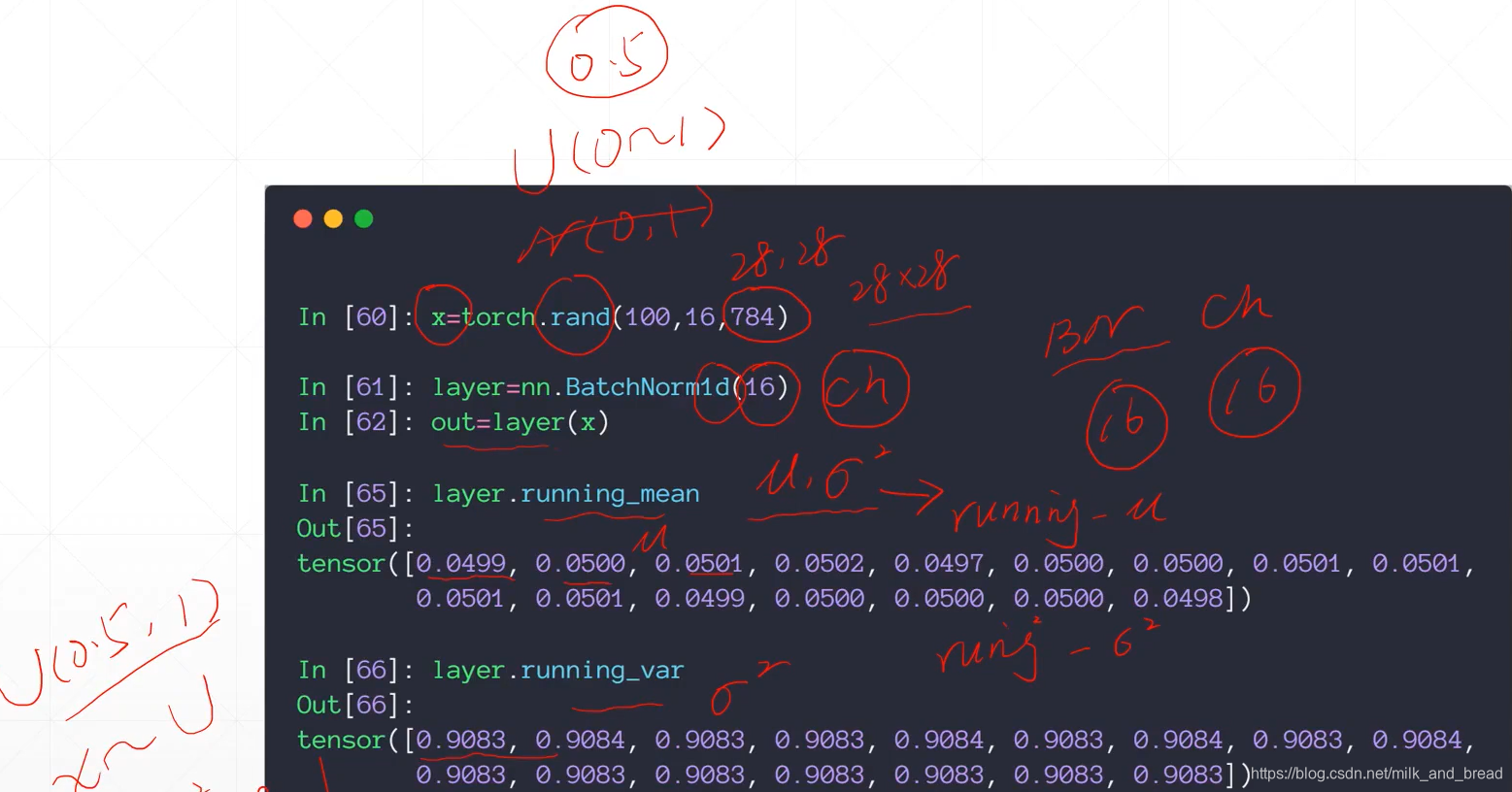

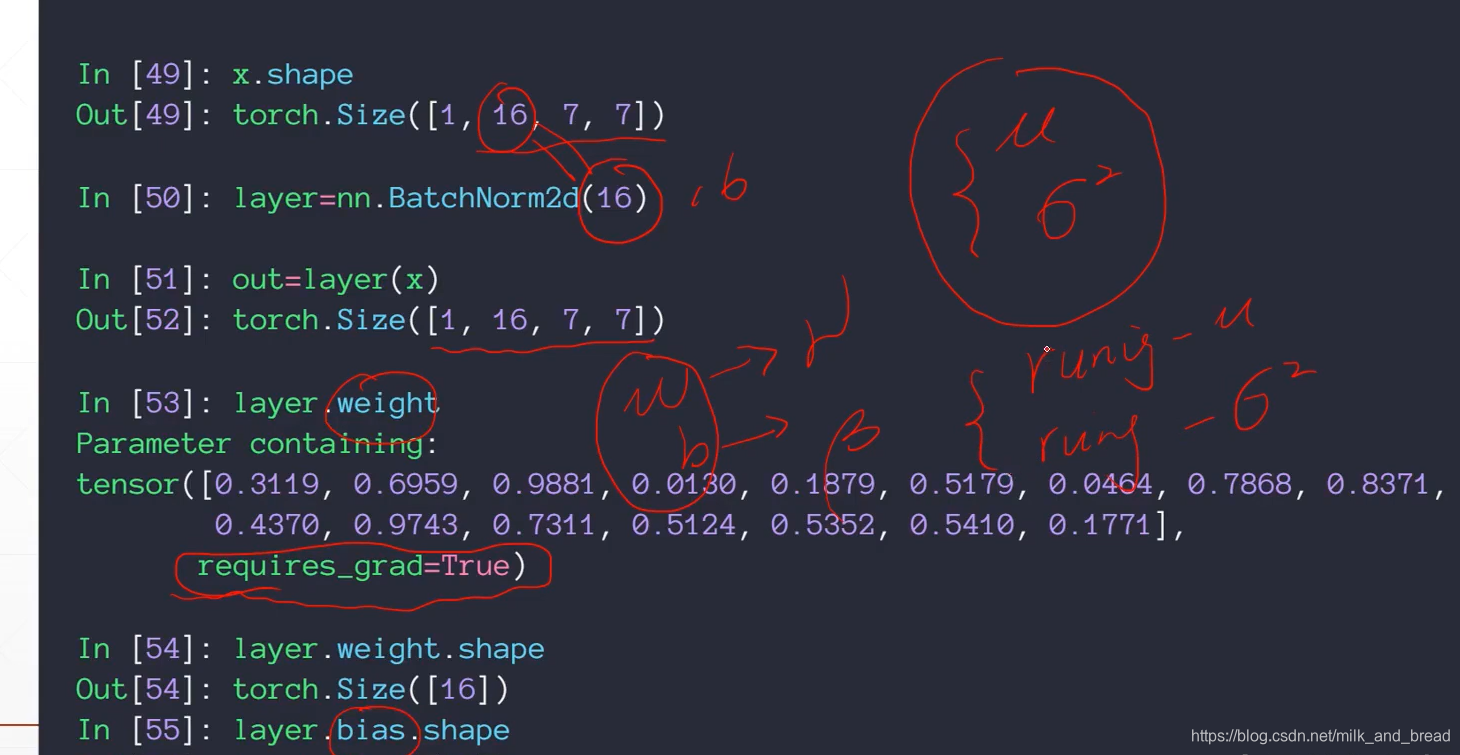

批量归一化BatchNorm

最新推荐文章于 2025-03-29 10:57:46 发布

部署运行你感兴趣的模型镜像

您可能感兴趣的与本文相关的镜像

PyTorch 2.5

PyTorch

Cuda

PyTorch 是一个开源的 Python 机器学习库,基于 Torch 库,底层由 C++ 实现,应用于人工智能领域,如计算机视觉和自然语言处理

335

335

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?