一、接入其他大模型

大模型排行榜:https://superclueai.com/

LangChain4j 可接入大模型:https://docs.langchain4j.dev/category/language-models

DeepSeek 是支持 OpenAI 标准的大语言模型。

二、接入 DeepSeek

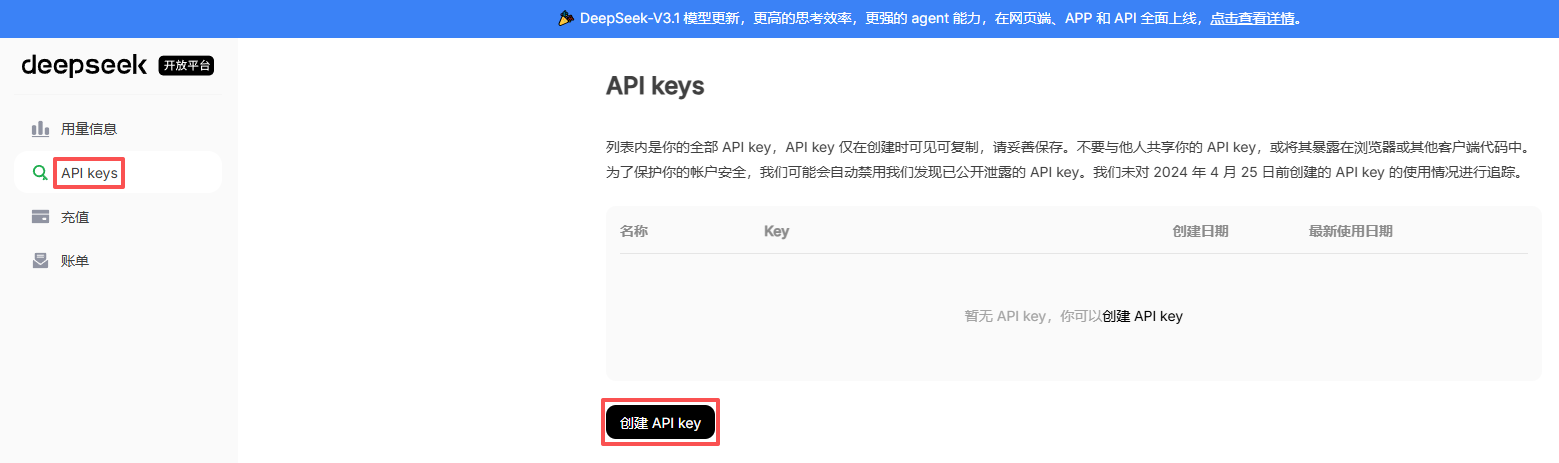

2.1、获取开发参数

访问官网: https://www.deepseek.com/ 注册账号,获取 base_url 和 api_key,充值

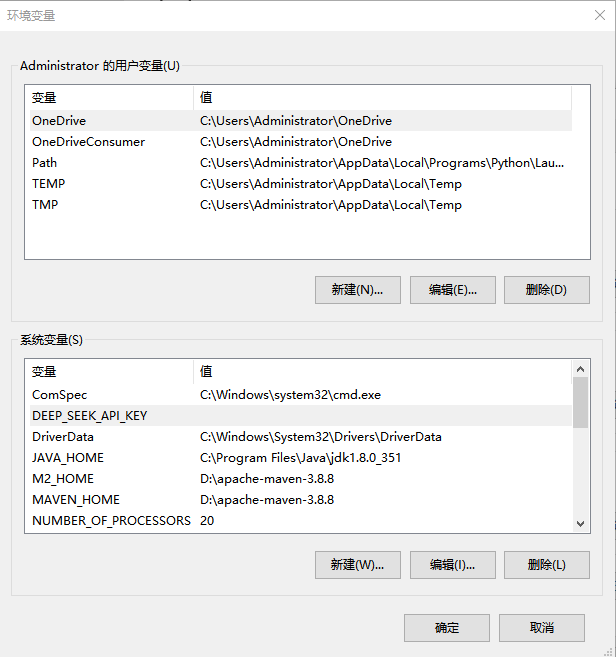

2.2、配置开发参数

为了 apikay 的安全,建议将其配置在服务器的环境变量中。变量名自定义即可,例如

DEEP_SEEK_API_KEY

2.3、配置模型参数

DeepSeek API文档: https://api-docs.deepseek.com/zh-cn/

在 LangChain4j 中,DeepSeek 和 GPT 一样也使用了 OpenAI 的接口标准,因此也使用OpenAiChatModel 进行接入。

# DeepSeek

langchain4j.open-ai.chat-model.base-url=https://api.deepseek.com

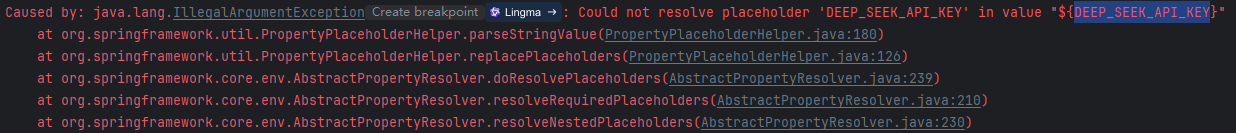

langchain4j.open-ai.chat-model.api-key=${DEEP_SEEK_API_KEY}

# DeepSeek-V3

langchain4j.open-ai.chat-model.model-name=deepseek-chat

# DeepSeek-R1 推理模型

#langchain4j.open-ai.chat-model.model-name=deepseek-reasoner

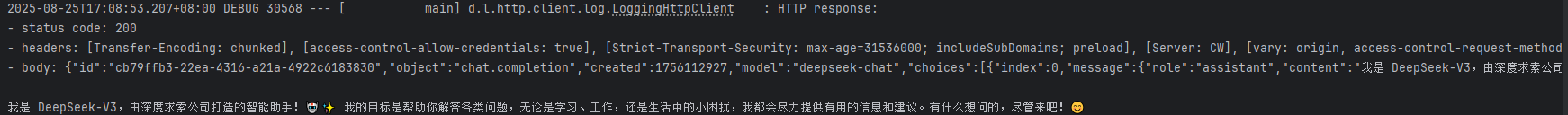

2.4、测试

/**

* 整合SpringBoot

*/

@Autowired

private OpenAiChatModel openAiChatModel;

@Test

public void testSpringBoot() {

// 向模型提问

String answer = openAiChatModel.chat("你是谁?");

// 输出结果

System.out.println(answer);

}

如下报错,重启 IDEA 就可以:

1330

1330

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?