一、Ollama 是什么

Ollama 是一个本地部署大模型的工具。使用 Ollama 进行本地部署有以下多方面的原因:

- 数据隐私与安全:对于金融、医疗、法律等涉及大量敏感数据的行业,数据安全至关重要。

- 离线可用性:在网络不稳定或无法联网的环境中,本地部署的 Ollama 模型仍可正常运行。

- 降低成本:云服务通常按使用量收费,长期使用下来费用较高。而 Ollama 本地部署,只需一次性投入硬件成本,对于需要频繁使用大语言模型且对成本敏感的用户或企业来说,能有效节约成本。

- 部署流程简单:只需通过简单的命令 “ollama run < 模型名>”,就可以自动下载并运行所需的模型。

- 灵活扩展与定制:可对模型微调,以适配垂直领域需求。

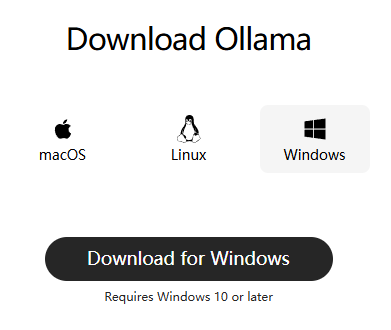

二、Windows 上安装 Ollama

官网: https://ollama.com/,下载对应版本,直接安装即可。

三、在 Ollama上部署 DeepSeek

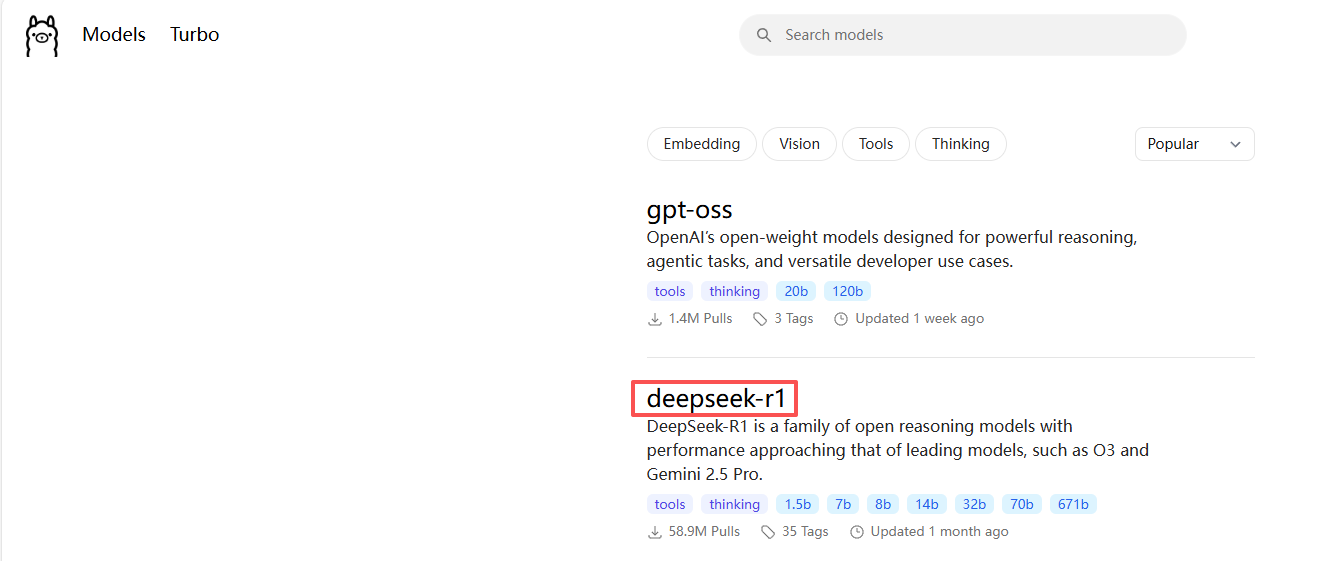

(1)查看模型列表,选择要部署的模型,模型列表:https://ollama.com/search

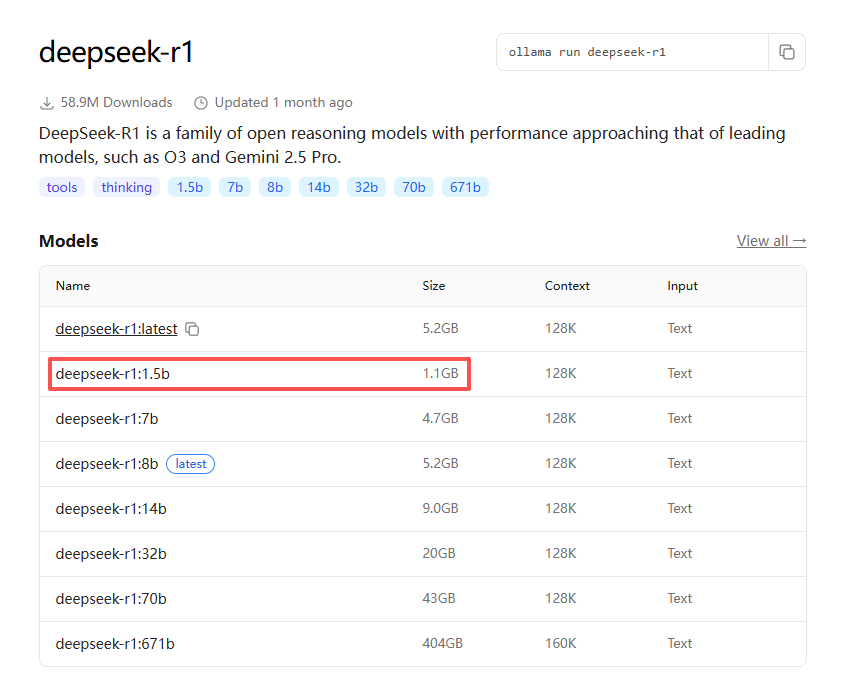

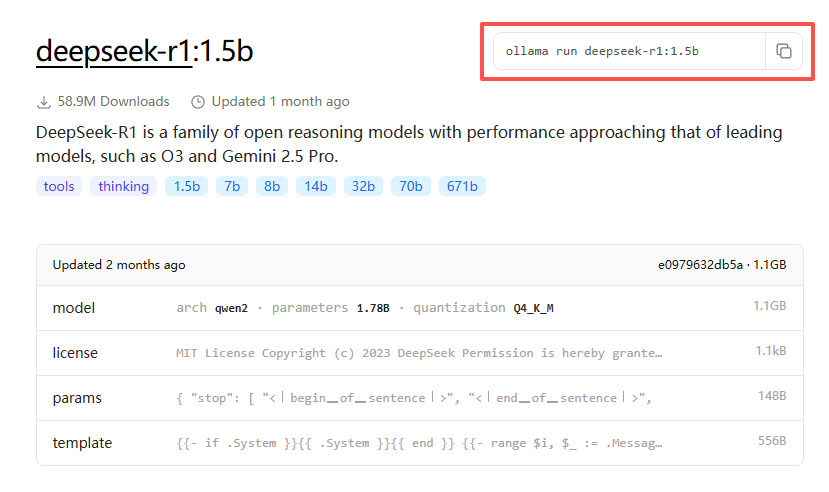

(2)选择资源所需最小的 deepseek-r1:1.5b 做实验

b 是 billion 十亿的意思,1.5b 也就是大模型训练的参数是 15 亿。

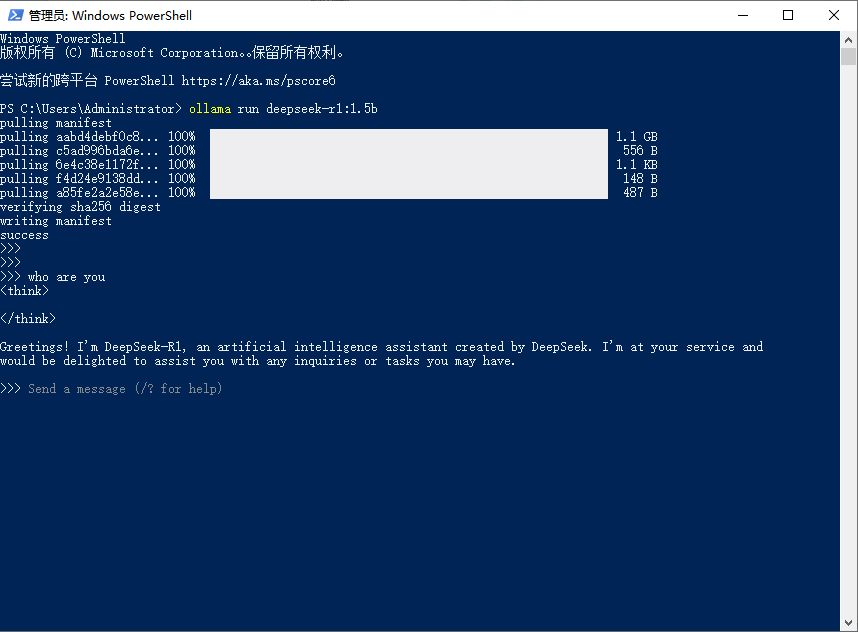

(3)执行命令:ollama run deepseek-r1:1.5 运行大模型。如果是第一次运行则会先下载大模型

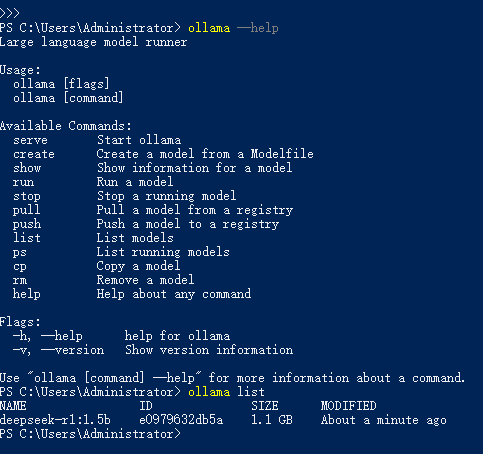

四、常用命令

五、接入 Ollama

参考文档:https://docs.langchain4j.dev/integrations/language-models/ollama

5.1、引入依赖

<!-- 接入ollama -->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-ollama-spring-boot-starter</artifactId>

</dependency>

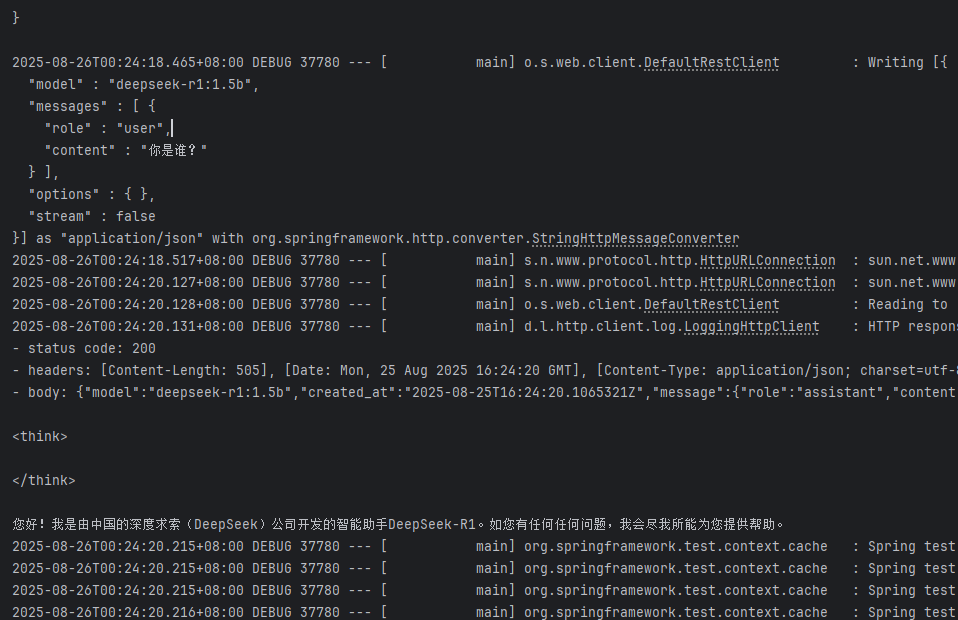

5.2、配置模型参数

#ollama

langchain4j.ollama.chat-model.base-url=http://localhost:11434

langchain4j.ollama.chat-model.model-name=deepseek-r1:1.5b

langchain4j.ollama.chat-model.log-requests=true

langchain4j.ollama.chat-model.log-responses=true

5.3、创建测试用例

/**

* ollama接入

*/

@Autowired

private OllamaChatModel ollamaChatModel;

@Test

public void testOllama() {

//向模型提问

String answer = ollamaChatModel.chat("你是谁?");

//输出结果

System.out.println(answer);

}

308

308

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?