哈喽这里是海绵

“轻松更换图片的背景 ”

今天,我们将带您探索如何利用Stable Diffusion,利用现有图像指定更换图像的背景构图信息,也就是将两张图像进行融合从而达到更换图像背景的目的。

实战体验

—

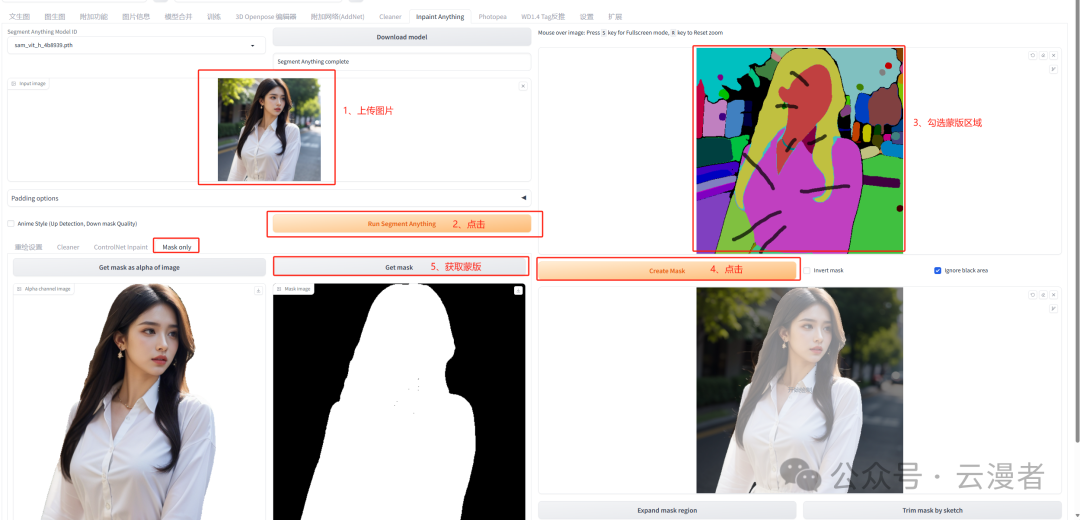

1、制作局部重绘蒙版

这里生成蒙版使用的是插件Inpaint Anything,所以没有安装该插件的需要先进行该插件的安装。蒙版制作步骤如下所示:

-

在输入图像中,上传对应的图片

-

点击按钮 Run Segment Anything,生成对应的预览图

-

圈定需要生成蒙版的区域

-

点击 Create Mask 按钮,获取圈选的区域

-

在Mask Only 标签中,点击Get Mask获取蒙版图像,并下载保存到本地

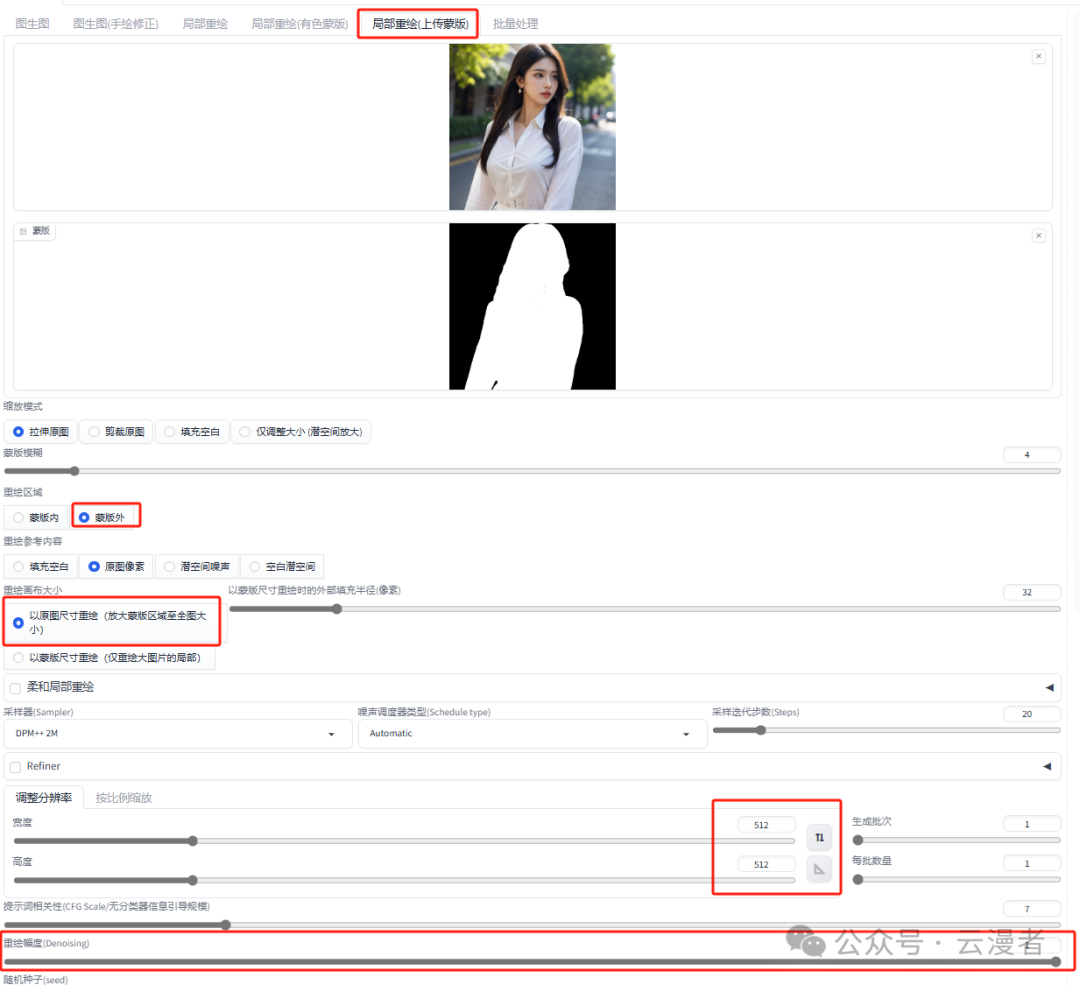

2、蒙版局部重绘

在图生图标签页中选择局部重绘(上传蒙版),并上传人物图像和蒙版图像。

操作注意:

-

重绘区域选择蒙版外,也就是非蒙版区域

-

重绘幅度设置大一些,大于0.75。这里我直接设置到1

-

ControlNet局部重绘设置

ControlNet图像参考(Reference)设置

上传需要替换的背景图像

ControlNet线稿(Lineart)设置

上传需要替换的背景图像,并生成图像的线稿图

绘图

到这里使用指定图像更换背景就基本完成了,剩下就是多次生成图像并选择一张满意的图像,然后再做最后的放大拟合处理。

正向主体提示语,包含人物和背景的描述

Best quality,masterpiece,ultra high res,(photorealistic:1.4),raw

photo,1girl,long hair,(black hair:1.3),(beauty:1.3),blue eyes,stand on the

plateau,

生成的图像效果图如下所示:

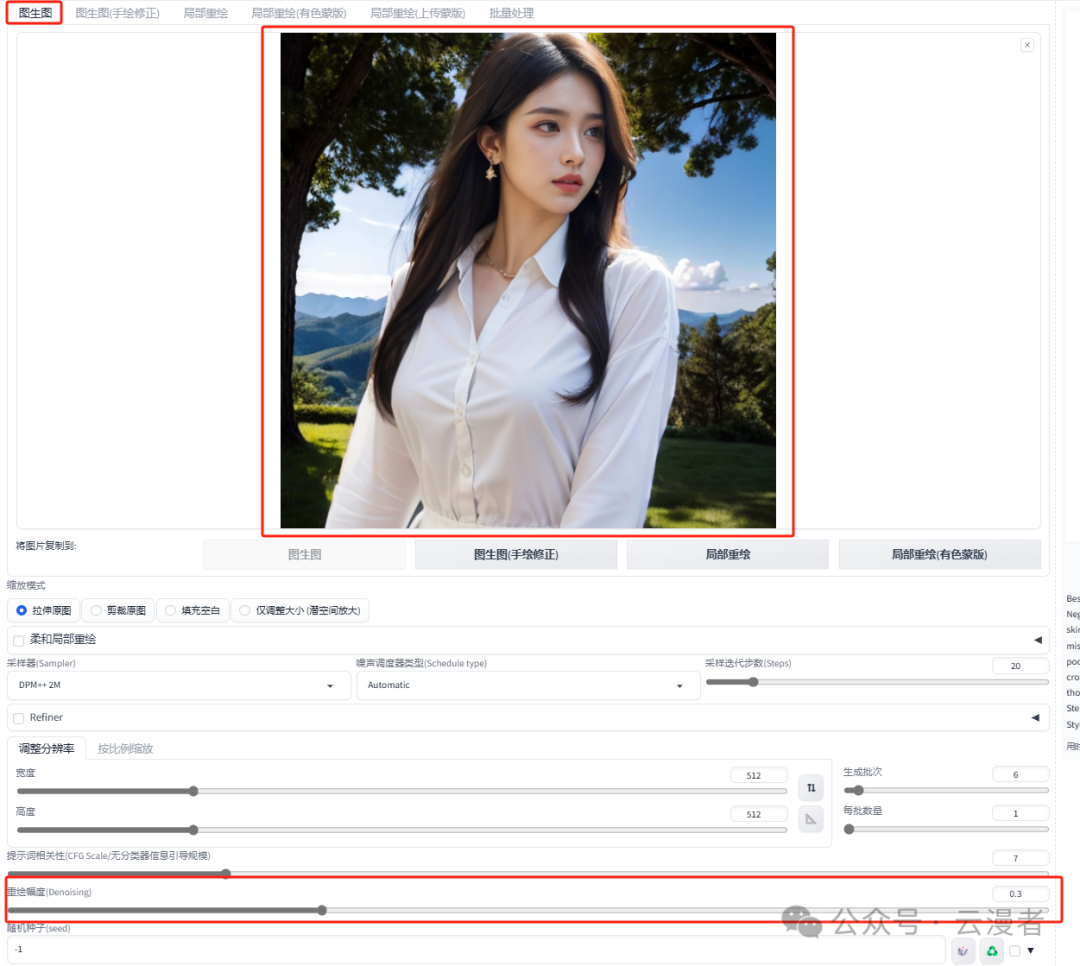

3、图像放大拟合

将比较满意的图像发送到图生图中进行放大处理。

操作注意:

-

关闭所有的ControlNet

-

重绘幅度设置为0.3

-

勾选Tiled Diffusion,并设置放大倍数为1.5

-

勾选Tiled VAE

图生图设置:

Tiled Diffusion & Tiled VAE设置:

输出效果图:

效果图:**

目前 ControlNet 已经更新到 1.1 版本,相较于 1.0 版本,ControlNet1.1 新增了更多的预处理器和模型,每种模型对应不同的采集方式,再对应不同的应用场景,每种应用场景又有不同的变空间

我花了一周时间彻底把ControlNet1.1的14种模型研究了一遍,跑了一次全流程,终于将它完整下载好整理成网盘资源。

其总共11 个生产就绪模型、2 个实验模型和 1 个未完成模型,现在就分享给大家,点击下方卡片免费领取。

1. 线稿上色

**方法:**通过 ControlNet 边缘检测模型或线稿模型提取线稿(可提取参考图片线稿,或者手绘线稿),再根据提示词和风格模型对图像进行着色和风格化。

**应用模型:**Canny、SoftEdge、Lineart。

Canny 示例:(保留结构,再进行着色和风格化)

2. 涂鸦成图

方法:通过 ControlNet 的 Scribble 模型提取涂鸦图(可提取参考图涂鸦,或者手绘涂鸦图),再根据提示词和风格模型对图像进行着色和风格化。

应用模型:Scribble。

Scribble 比 Canny、SoftEdge 和 Lineart 的自由发挥度要更高,也可以用于对手绘稿进行着色和风格处理。Scribble 的预处理器有三种模式:Scribble_hed,Scribble_pidinet,Scribble_Xdog,对比如下,可以看到 Scribble_Xdog 的处理细节更为丰富:

Scribble 参考图提取示例(保留大致结构,再进行着色和风格化):

3. 建筑/室内设计

**方法:**通过 ControlNet 的 MLSD 模型提取建筑的线条结构和几何形状,构建出建筑线框(可提取参考图线条,或者手绘线条),再配合提示词和建筑/室内设计风格模型来生成图像。

**应用模型:**MLSD。

MLSD 示例:(毛坯变精装)

4. 颜色控制画面

**方法:**通过 ControlNet 的 Segmentation 语义分割模型,标注画面中的不同区块颜色和结构(不同颜色代表不同类型对象),从而控制画面的构图和内容。

**应用模型:**Seg。

Seg 示例:(提取参考图内容和结构,再进行着色和风格化)

如果还想在车前面加一个人,只需在 Seg 预处理图上对应人物色值,添加人物色块再生成图像即可。

5. 背景替换

**方法:**在 img2img 图生图模式中,通过 ControlNet 的 Depth_leres 模型中的 remove background 功能移除背景,再通过提示词更换想要的背景。

**应用模型:**Depth,预处理器 Depth_leres。

**要点:**如果想要比较完美的替换背景,可以在图生图的 Inpaint 模式中,对需要保留的图片内容添加蒙版,remove background 值可以设置在 70-80%。

Depth_leres 示例:(将原图背景替换为办公室背景)

6. 图片指令

**方法:**通过 ControlNet 的 Pix2Pix 模型(ip2p),可以对图片进行指令式变换。

应用模型:ip2p,预处理器选择 none。

**要点:**采用指令式提示词(make Y into X),如下图示例中的 make it snow,让非洲草原下雪。

Pix2Pix 示例:(让非洲草原下雪)

7. 风格迁移

**方法:**通过 ControlNet 的 Shuffle 模型提取出参考图的风格,再配合提示词将风格迁移到生成图上。

**应用模型:**Shuffle。

Shuffle 示例:(根据魔兽道具风格,重新生成一个宝箱道具)

8. 色彩继承

**方法:**通过 ControlNet 的 t2iaColor 模型提取出参考图的色彩分布情况,再配合提示词和风格模型将色彩应用到生成图上。

**应用模型:**Color。

Color 示例:(把参考图色彩分布应用到生成图上)

这份完整版的ControlNet 1.1模型我已经打包好,需要的点击下方插件,即可前往免费领取!

这里就简单说几种应用:1. 人物和背景分别控制

2. 三维重建

3. 更精准的图片风格化

4. 更精准的图片局部重绘

以上就是本教程的全部内容了,重点介绍了controlnet模型功能实用,当然还有一些小众的模型在本次教程中没有出现,目前controlnet模型确实还挺多的,所以重点放在了官方发布的几个模型上。

同时大家可能都想学习AI绘画技术,也想通过这项技能真正赚到钱,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学,因为自身做副业需要,我这边整理了全套的Stable Diffusion入门知识点资料,大家有需要可以直接点击下边卡片获取,希望能够真正帮助到大家。

现在AI绘画还是发展初期,大家都在摸索前进。

但新事物就意味着新机会,我们普通人要做的就是抢先进场,先学会技能,这样当真正的机会来了,你才能抓得住。

如果你对AI绘画感兴趣,我可以分享我在学习过程中收集的各种教程和资料。

学完后,可以毫无问题地应对市场上绝大部分的需求。

这份AI绘画资料包整理了Stable Diffusion入门学习思维导图、Stable Diffusion安装包、120000+提示词库,800+骨骼姿势图,Stable Diffusion学习书籍手册、AI绘画视频教程、AIGC实战等等。

完整版资料我已经打包好,点击下方卡片即可免费领取!

【Stable Diffusion学习路线思维导图】

【Stable Diffusion安装包(含常用插件、模型)】

【AI绘画12000+提示词库】

【AI绘画800+骨骼姿势图】

【AI绘画视频合集】

这份完整版的stable diffusion资料我已经打包好,点击下方卡片即可免费领取!

1638

1638

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?