### AlexNet概述

AlexNet是一种深度卷积神经网络,在2012年的ImageNet大规模视觉识别挑战赛(ILSVRC)上取得了显著的成绩[^1]。该模型由Alex Krizhevsky, Ilya Sutskever 和 Geoffrey E. Hinton设计。

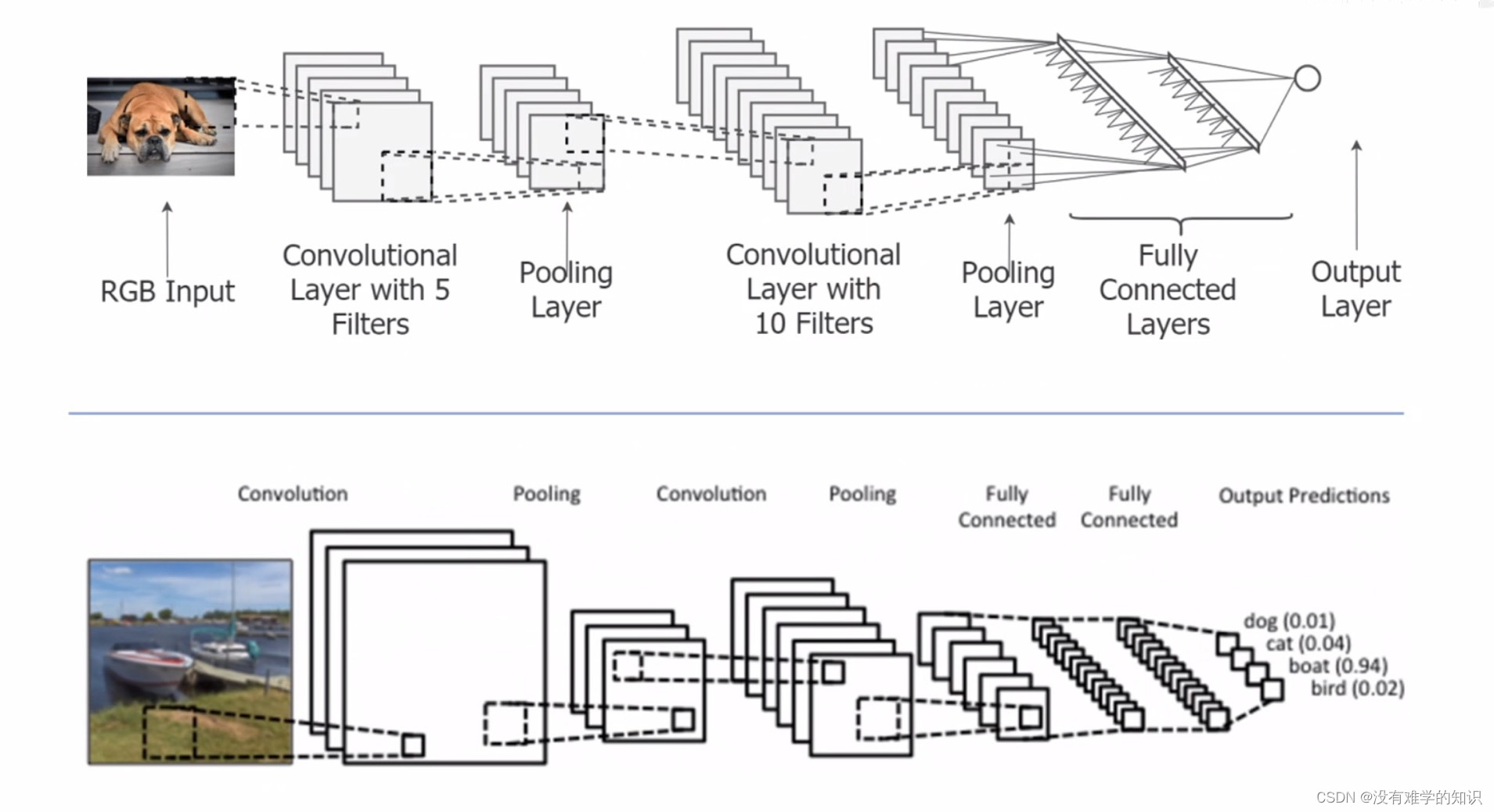

### 架构特点

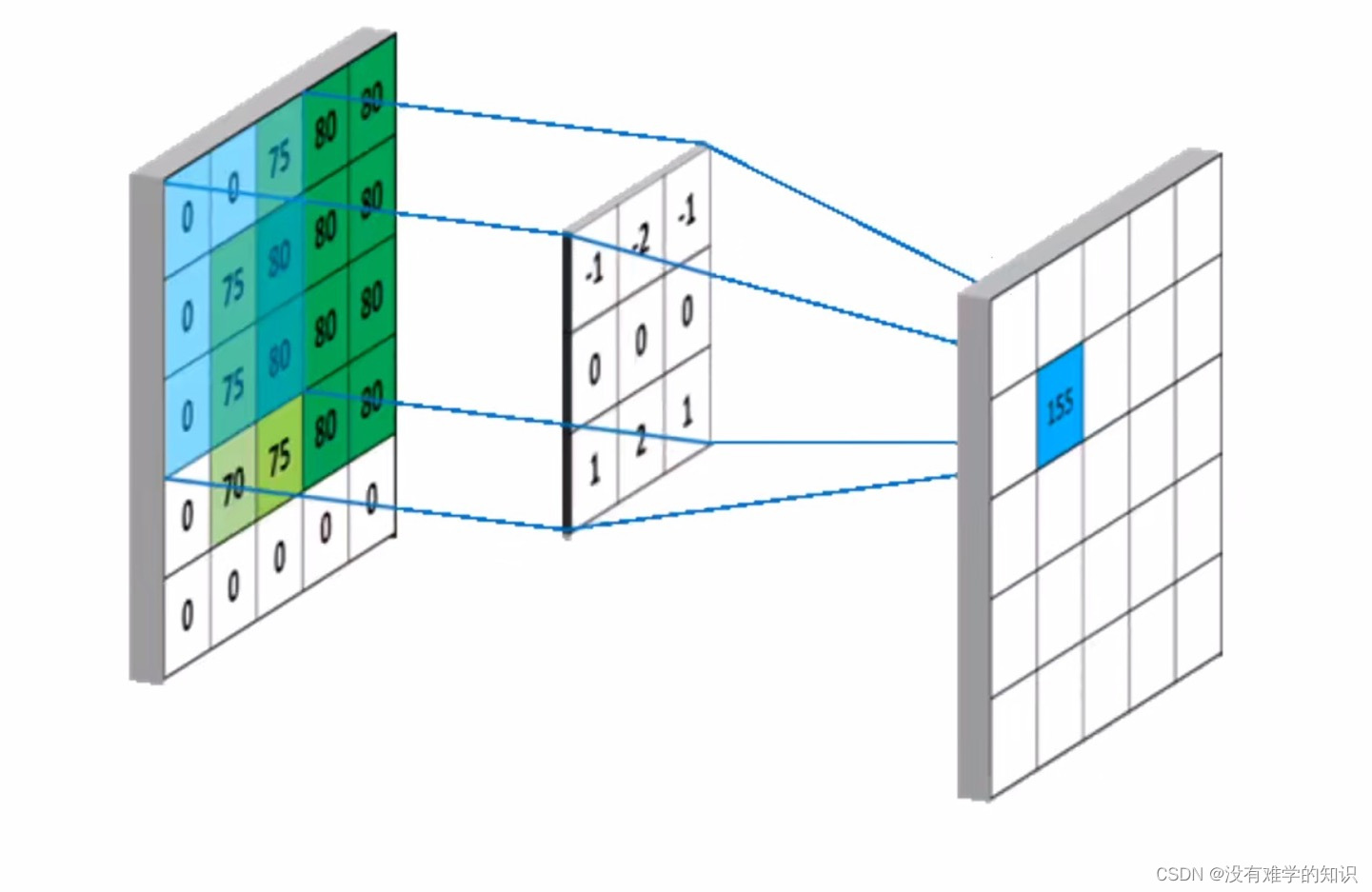

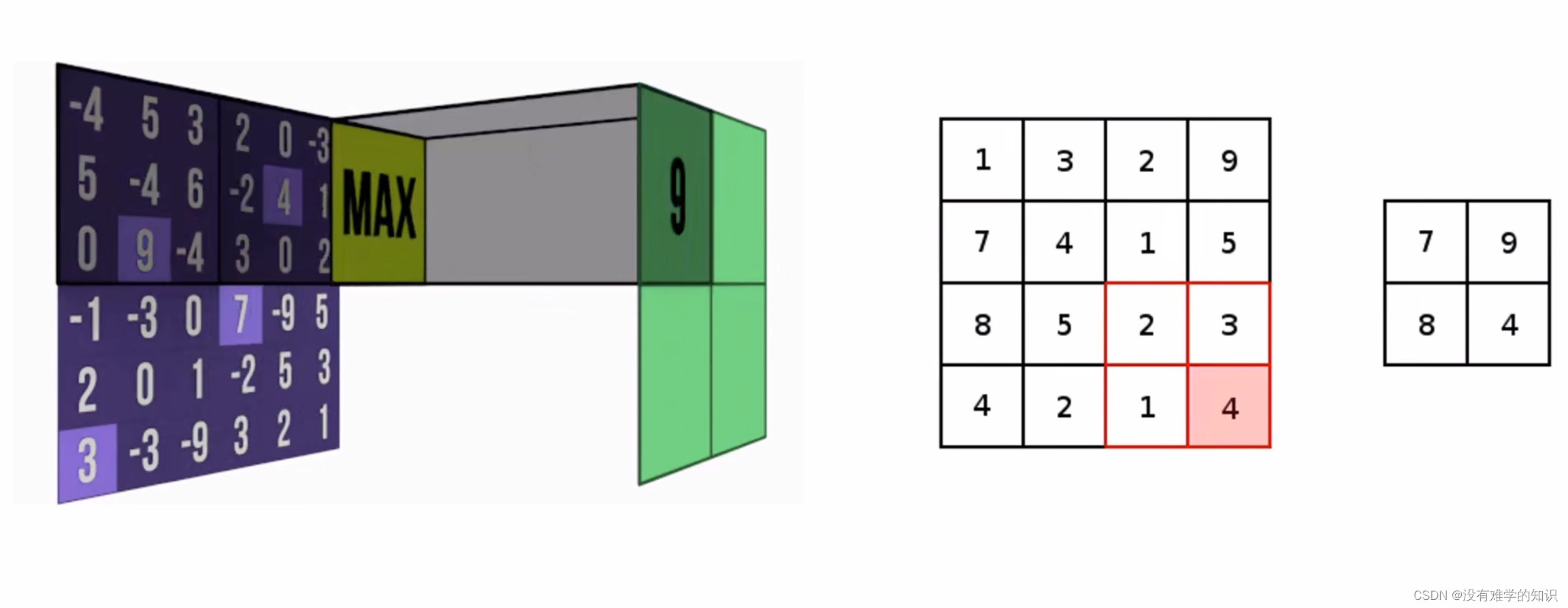

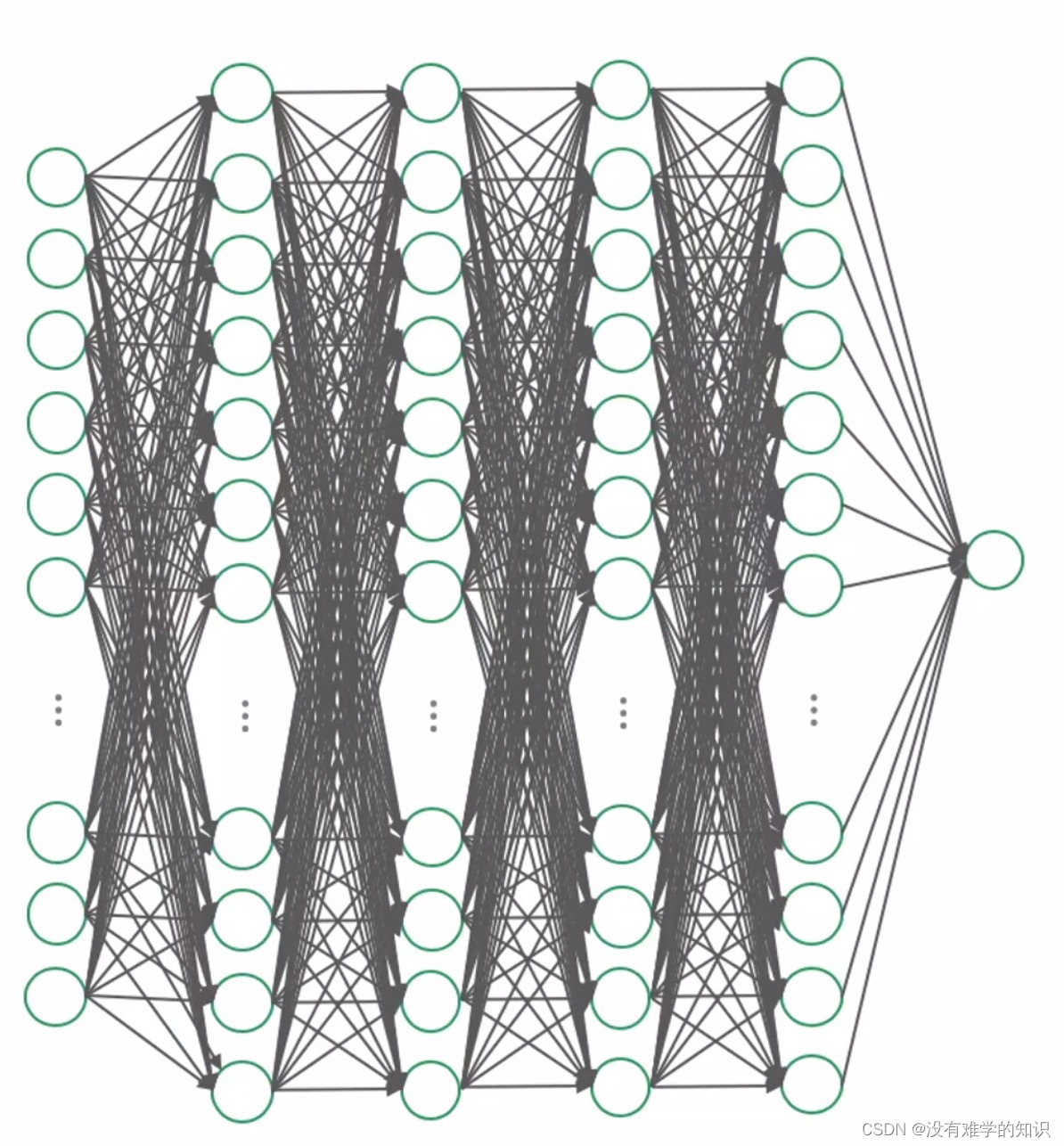

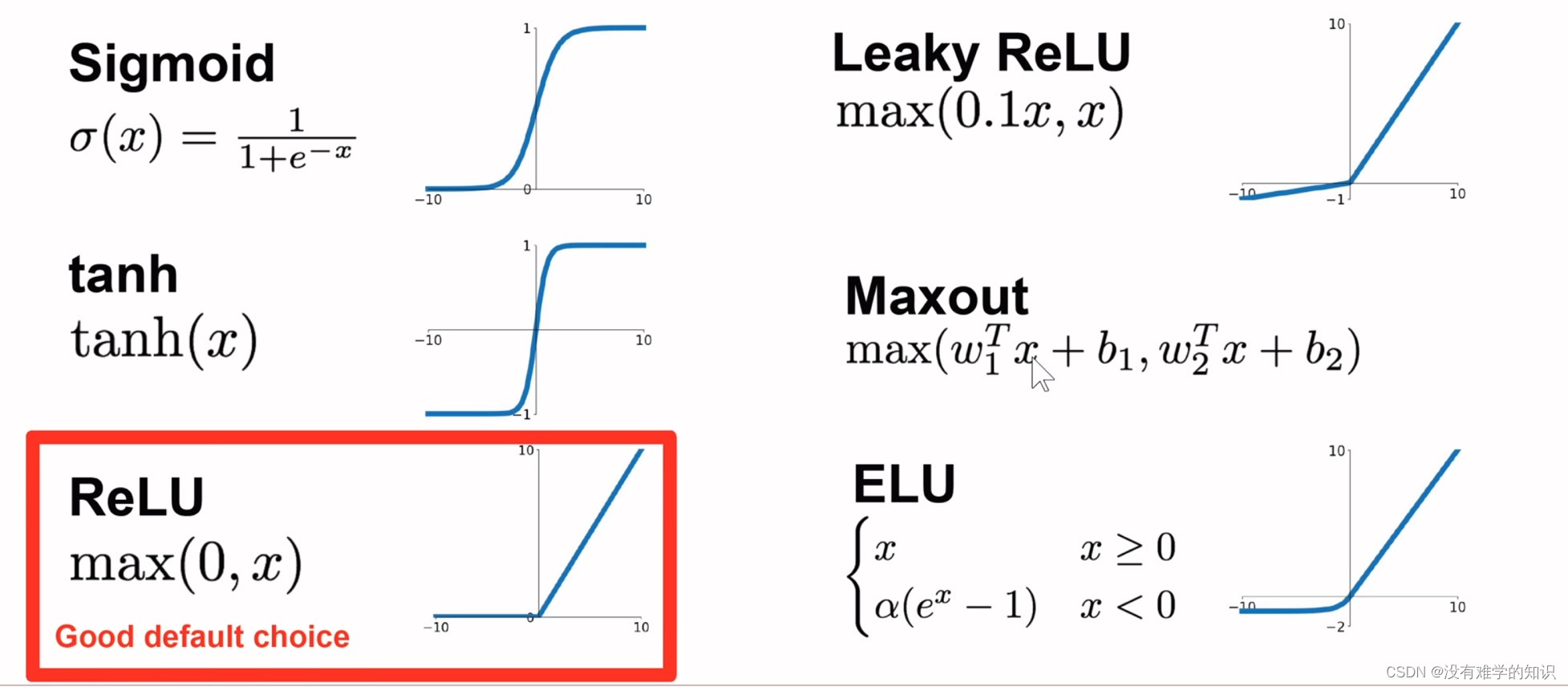

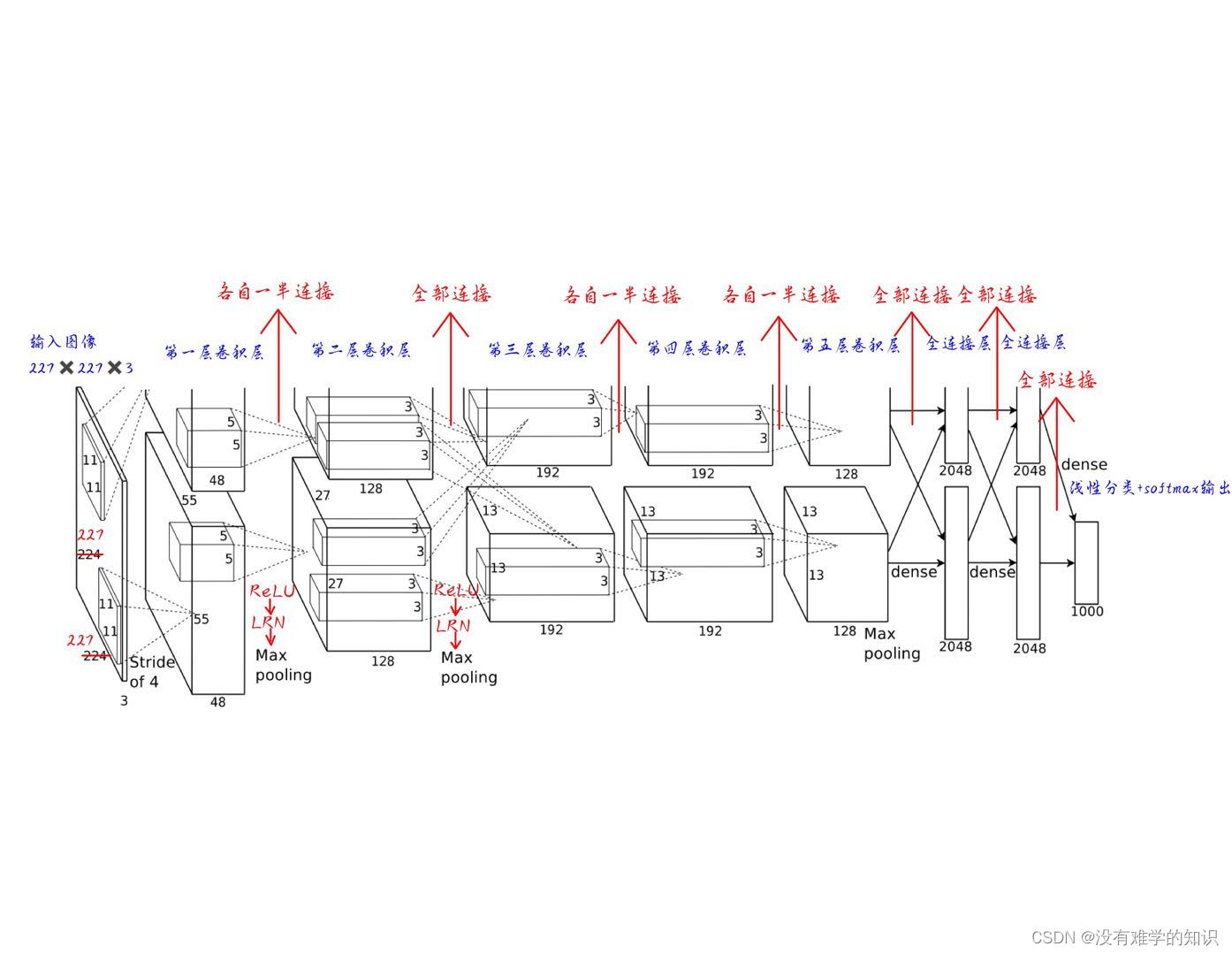

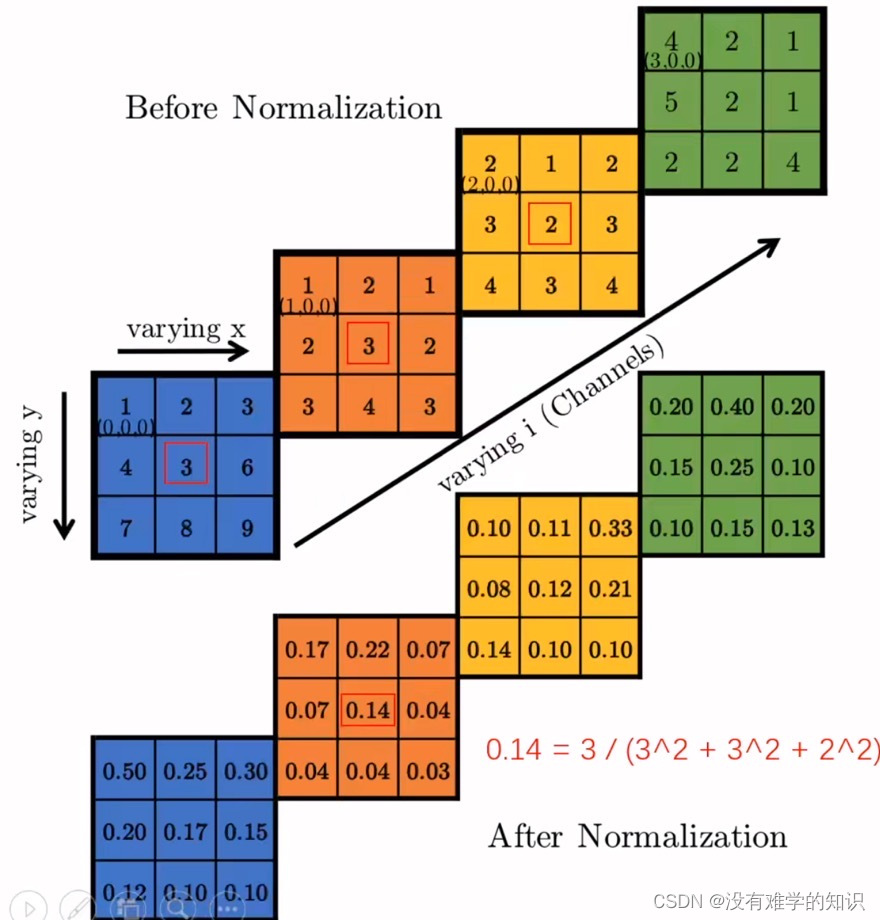

AlexNet包含了八层带有参数的学习层——五层卷积层和三层全连接层。输入图像尺寸为227×227像素,经过一系列操作最终映射到1000类标签的概率分布上。为了加速训练过程并减少过拟合风险,采用了ReLU激活函数以及Dropout技术来随机丢弃部分节点[^1]。

```python

import torch.nn as nn

class AlexNet(nn.Module):

def __init__(self, num_classes=1000):

super(AlexNet, self).__init__()

self.features = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=11, stride=4, padding=2),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=3, stride=2),

# 更多卷积层...

)

self.classifier = nn.Sequential(

nn.Dropout(),

nn.Linear(256 * 6 * 6, 4096),

nn.ReLU(inplace=True),

nn.Dropout(),

nn.Linear(4096, 4096),

nn.ReLU(inplace=True),

nn.Linear(4096, num_classes),

)

def forward(self, x):

x = self.features(x)

x = x.view(x.size(0), 256 * 6 * 6)

x = self.classifier(x)

return x

```

### 实现方式

在实现方面,AlexNet利用GPU的强大计算能力进行了高效的矩阵运算处理。通过使用CUDA库可以在NVIDIA图形处理器上获得更快的速度提升。此外还应用了数据增强方法如水平翻转和平移裁剪等手段扩充训练集规模以提高泛化性能[^1]。

### 应用场景

作为早期成功的CNN之一,AlexNet被广泛应用于各种计算机视觉任务当中,比如物体检测、分类、分割等领域。它不仅推动了深度学习领域的发展,也为后续更先进的模型提供了宝贵的经验和技术基础[^1]。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1256

1256

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?