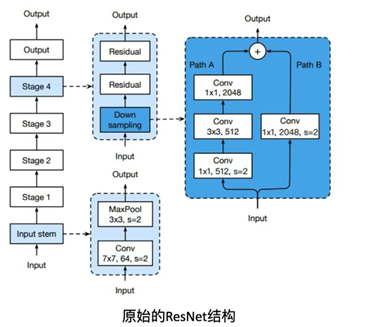

Resnet的基础结构包括了:卷积-最大池化-4次残差卷积-平均池化与全连接 四个部分,如下图所示:

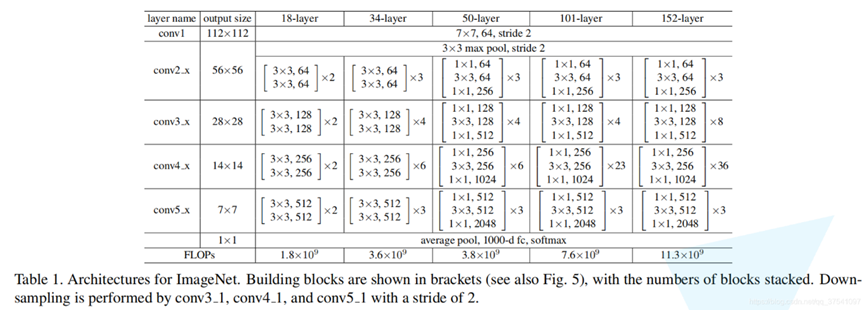

其中不同层数之间(18,34,50,101,152)的结构差异主要出现在残差卷积部分。

如上图所示,Resnet接受224 * 224 * 3的图像输入,在经过input stem(7 * 7 * 64步长为2的卷积与3 * 3步长为2的最大池化后),可以得到56 * 56 * 64的特征图输出。这一步主要是为了降低图像分辨率以减少计算,同时增加通道数和最大池化来提取更丰富更显著的特征。接下来,这个特征图就会被送往残差卷积部分进行更深入的特征提取。

每个Stage根据Resnet层数的不同会分为两类:

- Basic Block

适用于18/34层结构,其捷径分支(Path B)包含两种选择:一种直接相加,一种降尺寸升维相加。其中直接相加是Residual部分,而每个Stage的第一个Residual块由于需要对前一个Stage的特征图输入进行降尺寸升维,所以其捷径分支会与一般直接相加的残差块有所不同,我们称其为Down Sampling Residual。

那么,残差模块的优势在哪里?

(1)传统的深层网络中,随着层数增加,梯度在反向传播中会逐渐变小或变大,造成梯度消失或梯度爆炸。而残差模块则可以改善这个问题。为什么呢?

我们首先分析梯度消失或者梯度爆炸问题本身。在神经网络训练中,我们通过反向传播来更新参数。梯度即为损失函数对参数的导数(下图中w即为参数,L为损失函数,η为学习率)。梯度可以指导我们向最小的Loss的移动,类似求函数切线然后不断逼近函数最小值。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1001

1001

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?