文章目录

0 前言

🔥这两年开始毕业设计和毕业答辩的要求和难度不断提升,传统的毕设题目缺少创新和亮点,往往达不到毕业答辩的要求,这两年不断有学弟学妹告诉学长自己做的项目系统达不到老师的要求。并且很难找到完整的毕设参考学习资料。

为了大家能够顺利以及最少的精力通过毕设,学长分享优质毕业设计项目提供大家参考学习,今天要分享的是

🚩 毕业设计 深度学习yolo藻类细胞检测识别(科研辅助系统)(源码+论文)

🥇学长这里给一个题目综合评分(每项满分5分)

难度系数:3分

工作量:4分

创新点:5分

🧿 项目分享:见文末!

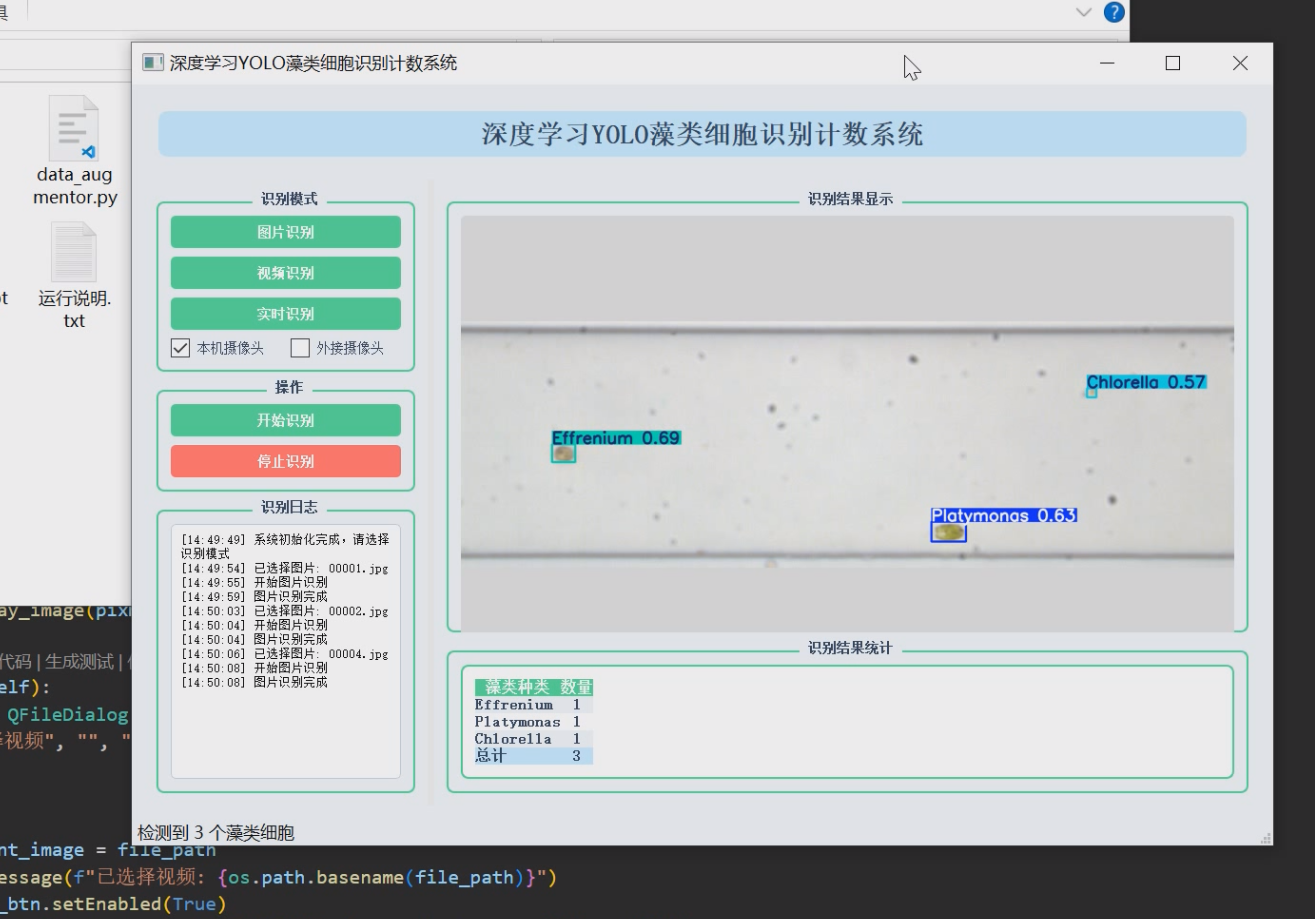

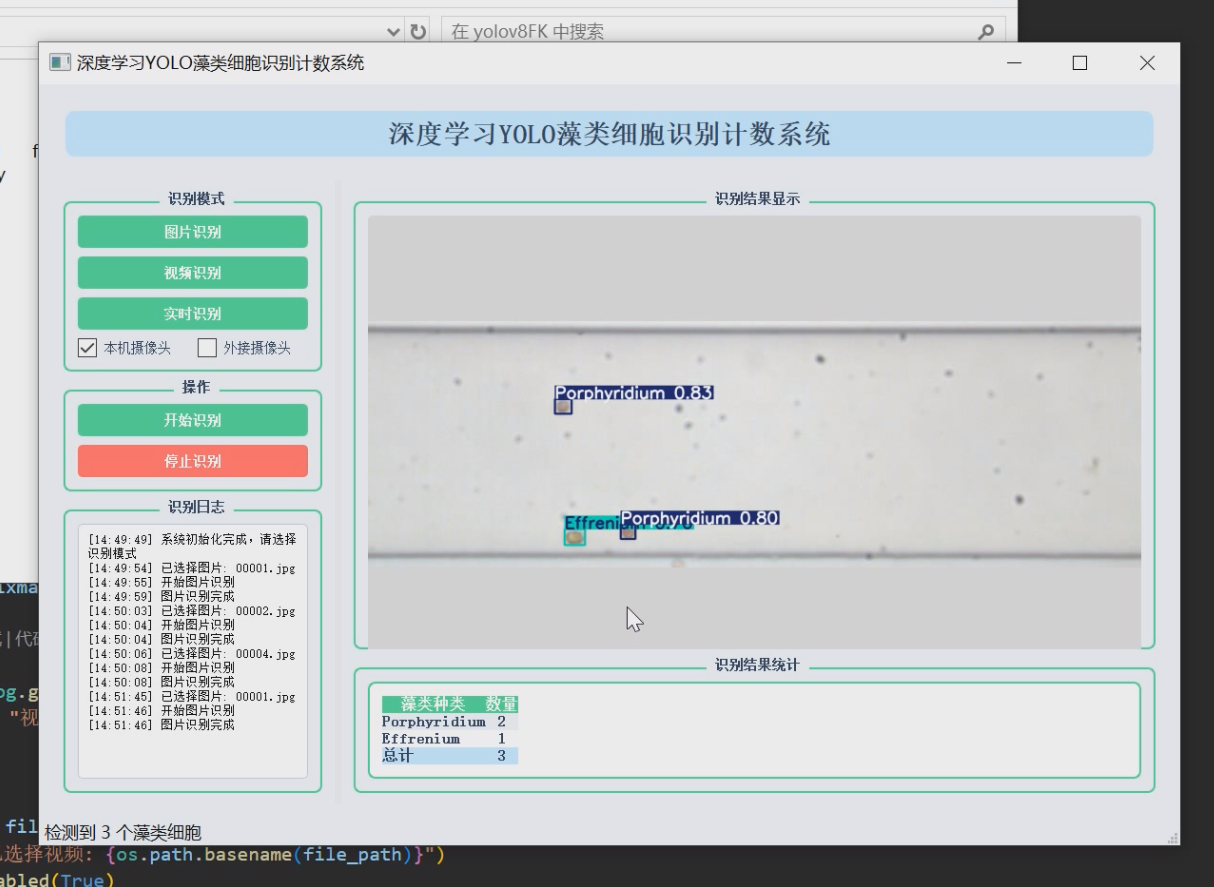

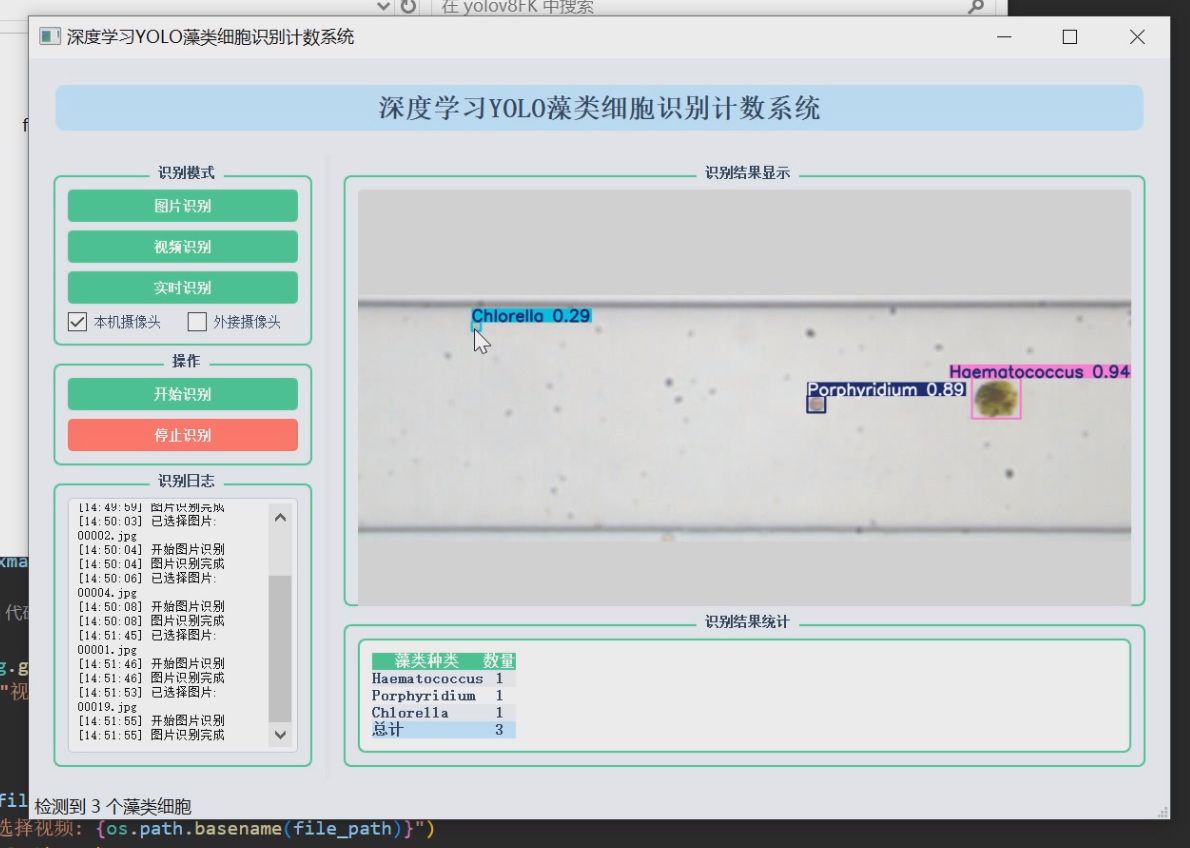

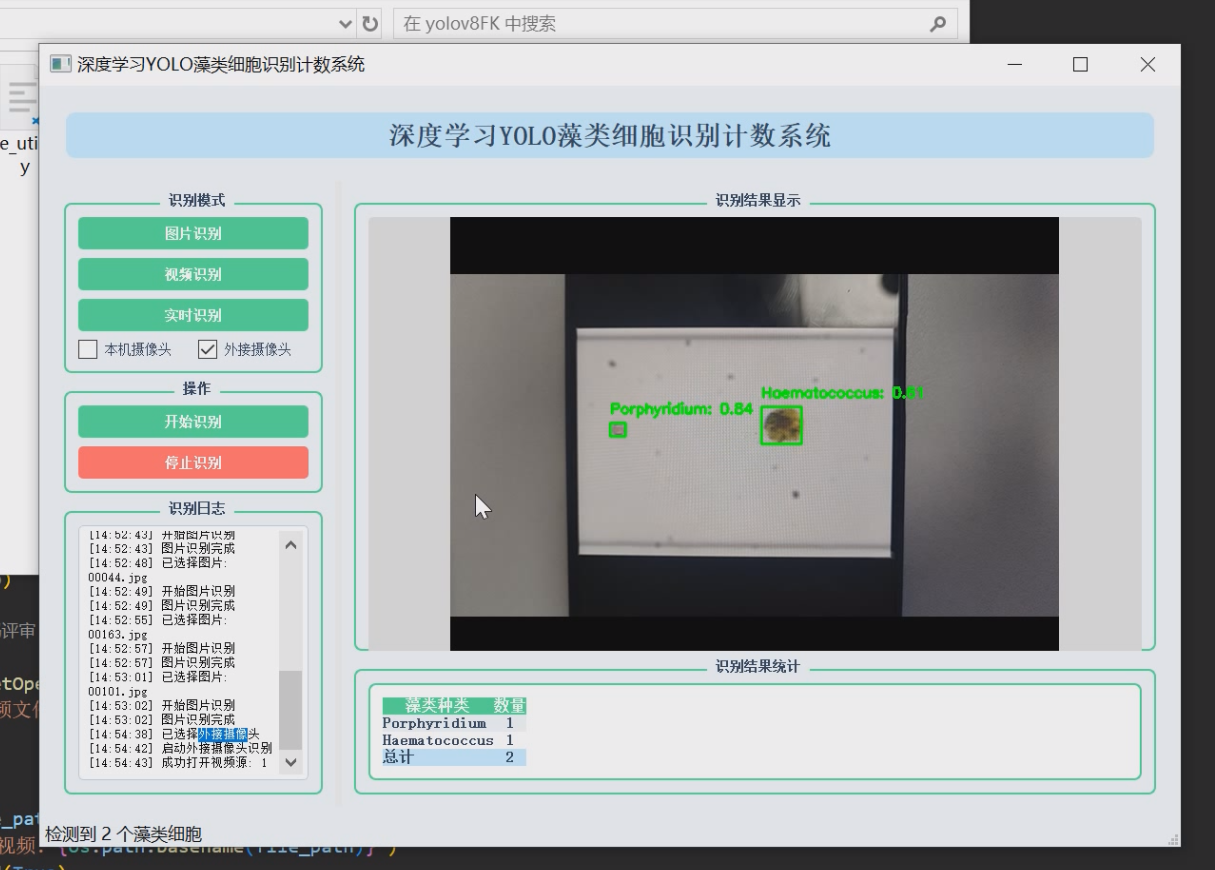

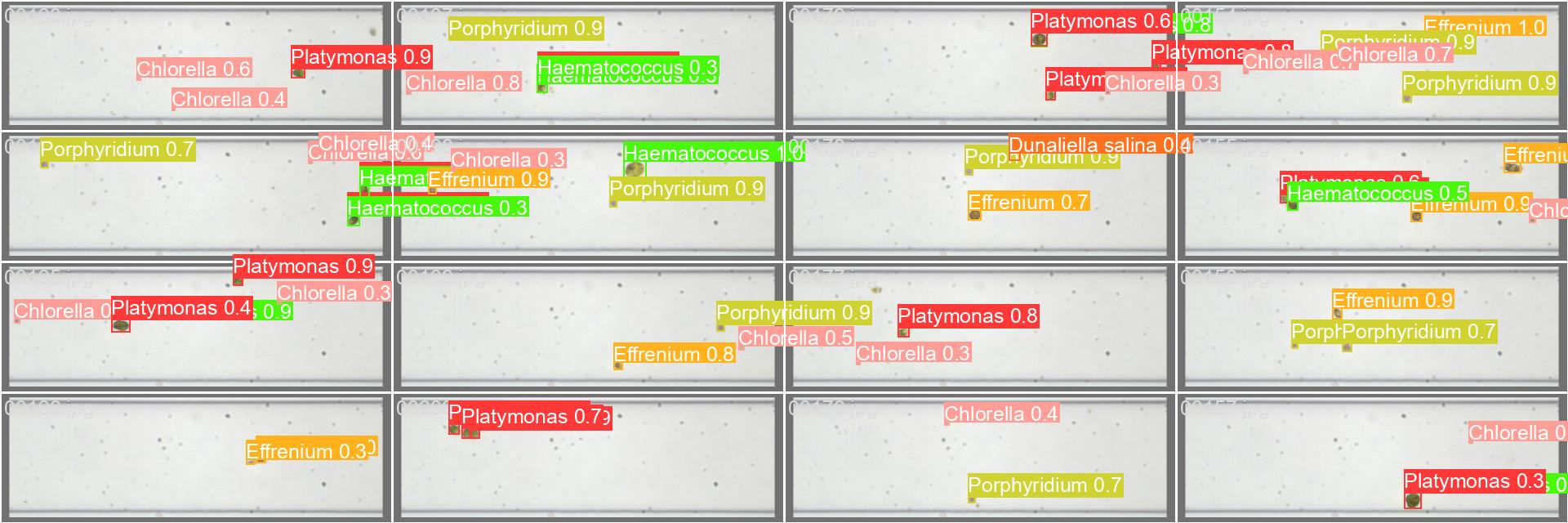

1 项目运行效果

2 课题背景

2.1 水环境监测的重要性

随着全球水资源污染问题日益严重,水环境监测已成为环境保护领域的核心任务。藻类作为水生态系统中的初级生产者,其种群结构和数量变化直接反映水体营养状态和污染程度。根据世界卫生组织统计,全球约40%的饮用水源受到藻类过度繁殖的威胁,其中蓝藻水华产生的微囊藻毒素更被列为2B类致癌物。我国生态环境部发布的《2022年中国海洋环境状况公报》显示,近海藻华发生频次较十年前增长67%,凸显藻类监测的紧迫性。

2.2 传统检测方法的局限性

当前藻类监测主要依赖人工显微镜检测,存在三大技术瓶颈:

- 效率低下:单样本检测需30-50分钟,华东环境监测中心数据显示,技术人员日均仅能完成8-10个样品的完整分析,难以满足大规模监测需求。

- 主观性强:不同操作者对藻类形态特征的判断差异可达20%-30%,美国EPA研究报告指出,人工分类的组内变异系数(CV)高达35%。

- 标准化困难:传统方法依赖专家经验,发展中国家监测机构间数据可比性不足,全球藻类监测网络(GMN)评估显示实验室间偏差超过40%。

2.3 技术发展趋势

计算机视觉技术为藻类检测带来新机遇:

- 机器学习阶段:2010-2015年主要采用SVM等传统算法,中科院水生所开发的CellCounter系统对单细胞藻类识别准确率达82%,但特征工程依赖人工设计。

- 深度学习突破:2016年后CNN架构显著提升性能,MIT团队采用ResNet50在PhytoImage数据集上实现89%分类准确率。

- 实时检测需求:YOLO等单阶段检测器更适合动态监测,荷兰Deltares研究所将YOLOv5应用于浮游植物监测,帧处理速度提升至23FPS。

2.4 项目研究价值

本系统的创新价值体现在三个维度:

-

技术创新:

- 首次将YOLOv8应用于淡水藻类检测

- 开发轻量化模型适配边缘计算设备

- 创新性融合形态学特征与深度特征

-

应用创新:

- 支持显微镜/水下相机/无人机多源数据

- 实现从实验室分析到原位监测的跨越

- 构建标准化藻类数据库(计划收录200+物种)

-

社会效益:

- 使单样检测时间缩短至3分钟以内

- 预计降低监测成本60%以上

- 为蓝藻水华早期预警提供技术支撑

2.5 国内外研究现状

2.5.1 国际进展

- 美国EPA开发PhytoVision系统(基于Mask R-CNN)

- 欧盟H2020项目AI4Water实现多参数联合监测

- 日本东京大学藻类自动识别装置获2022年国际水展金奖

2.5.2 国内现状

- 中科院太湖站建立藻类图像数据库(含150种)

- 中国环科院发布《藻类智能监测技术指南》(试行)

- 华为云与珠江所合作开发AI识别模型(准确率91.2%)

2.6 技术挑战

仍需解决的关键问题:

- 微小藻类(<10μm)的检测精度不足

- 群体藻类的分割困难(如微囊藻群体)

- 复杂背景下的特征干扰

- 模型在跨水域场景的泛化能力

本课题将重点突破这些技术瓶颈,推动藻类监测从经验判断向智能分析的范式转变。

3 设计框架

3.1 整体架构图

3.2 技术栈组成

- 核心算法:YOLOv8s (轻量化版本)

- 界面框架:PyQt5 (Python 3.9)

- 图像处理:OpenCV 4.5

- 数据可视化:Matplotlib 3.6

- 硬件加速:CUDA 11.7 (NVIDIA GTX 1660)

3.3 模型训练模块

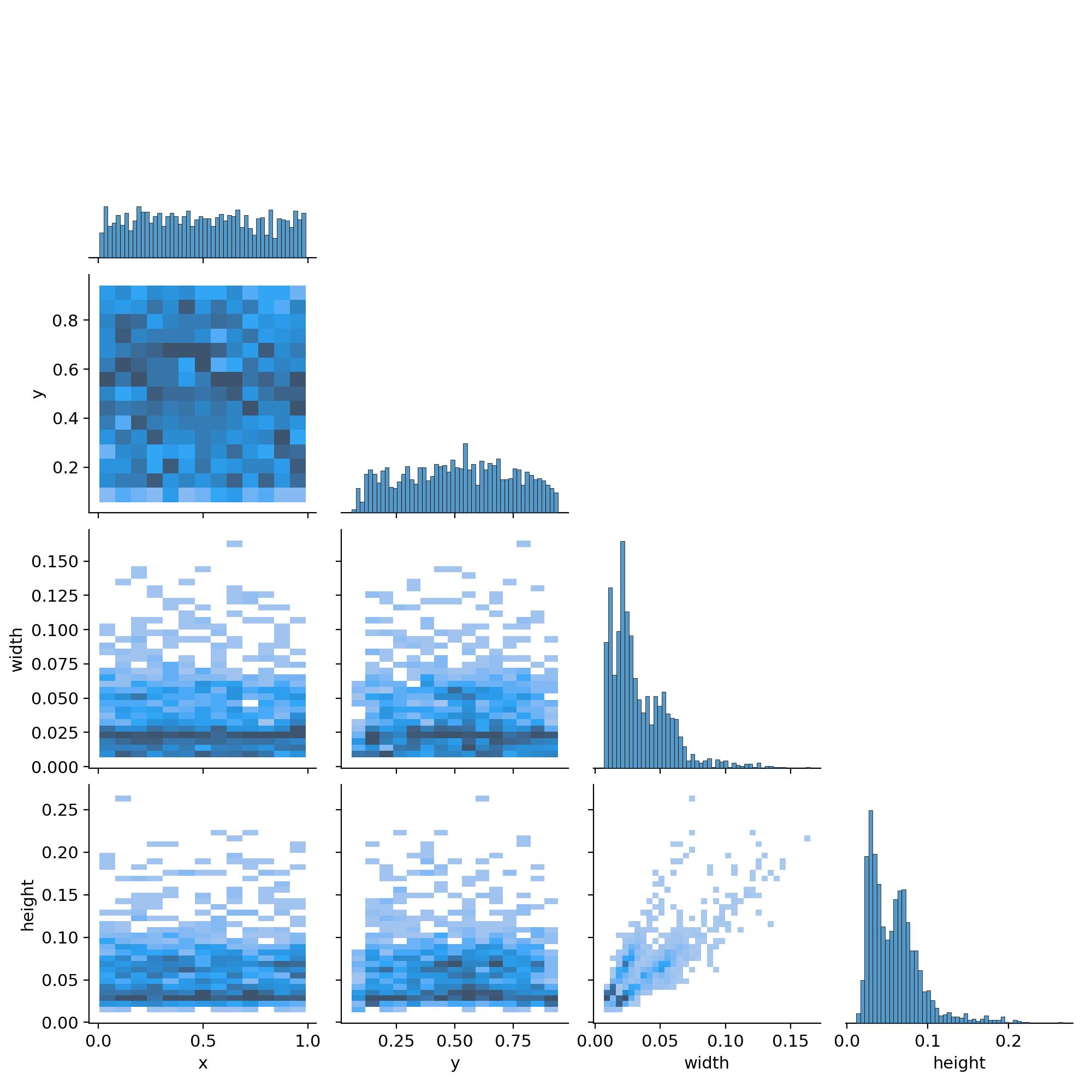

3.3.1 数据处理流程

# 伪代码:数据预处理

for image, label in dataset:

# 数据增强

image = random_perspective(image) # 随机透视变换

image = mosaic_augment(images=[image]) # Mosaic增强

# 归一化

image = image / 255.0

label = convert_to_yolo_format(label)

3.3.2 训练参数配置

# yolov8s.yaml

train:

epochs: 100

batch: 16

lr0: 0.01

augment: True # 启用自动增强

val:

split_ratio: 0.2

3.4 UI交互模块

3.4.1 界面组件树

MainWindow

├── VideoDisplay (QLabel)

├── ControlPanel (QGroupBox)

│ ├── ModelSelect (QComboBox)

│ ├── SourceSwitch (QButtonGroup)

│ └── StatsToggle (QCheckBox)

└── ChartArea (QGraphicsView)

3.4.2 状态管理逻辑

# 伪代码:视频流处理

class VideoThread(QThread):

def run(self):

while capturing:

frame = capture_frame()

results = model.predict(frame)

emit:

- 检测框图层

- 分类统计字典

- FPS性能数据

3.5 实时检测流程图

3.6 图表更新逻辑

# 伪代码:动态柱状图

def update_chart(count_dict):

ax.clear()

classes = list(count_dict.keys())

counts = list(count_dict.values())

bars = ax.bar(classes, counts)

# 设置颜色映射

for bar, cls in zip(bars, classes):

bar.set_color(COLOR_MAP[cls])

canvas.draw() # 重绘画布

3.7 多线程架构

主线程:UI渲染

└── 子线程1:视频捕获

└── 子线程2:模型推理

└── 子线程3:数据持久化

3.8 内存管理策略

- 视频帧缓存:环形缓冲区(最大5帧)

- 模型输出:零拷贝共享内存

- 图表数据:双缓冲机制

3.9 数据导出格式

{

"timestamp": "2023-11-15T14:30:00",

"detections": [

{"class": "Chlorella", "count": 42},

{"class": "Cyclotella", "count": 15}

],

"fps": 24.6

}

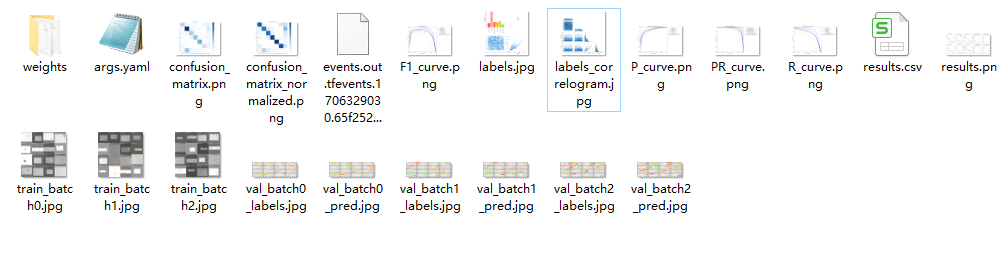

4 最后

项目包含内容

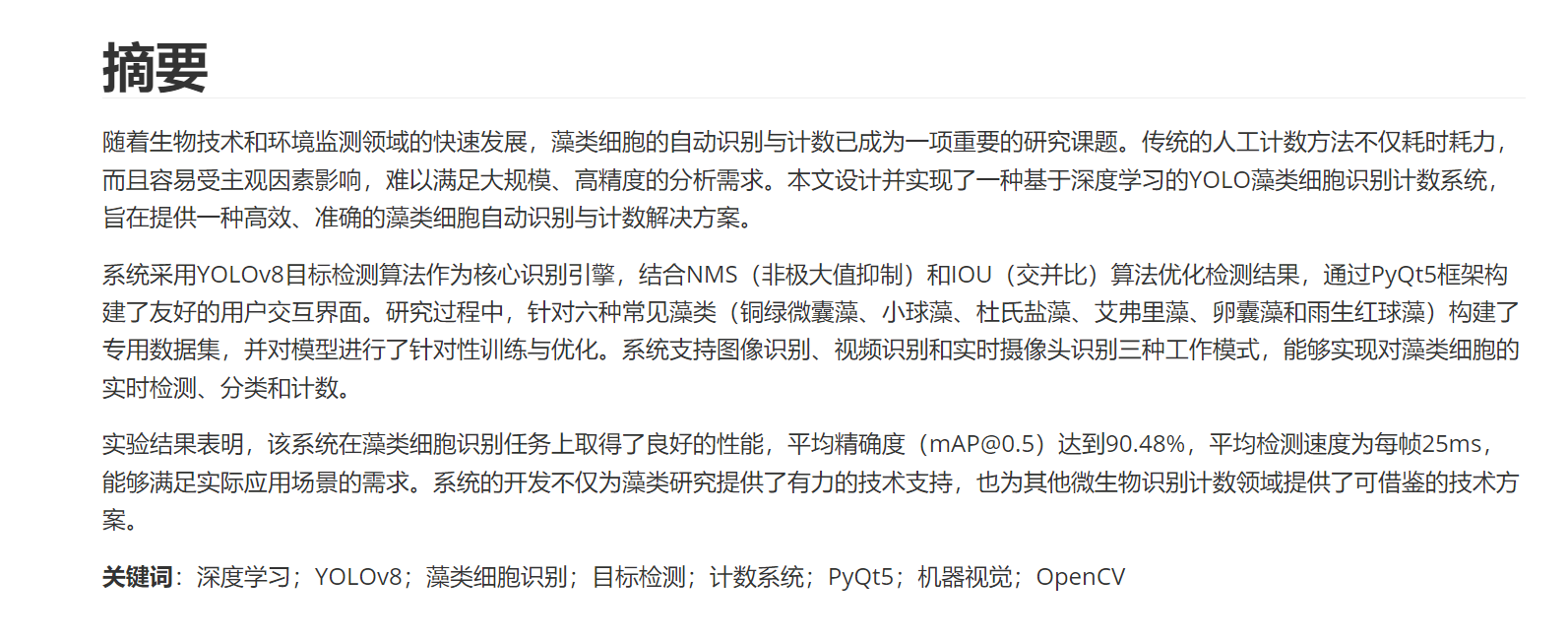

论文摘要

🧿 项目分享:大家可自取用于参考学习,获取方式见文末!

深度学习YOLO实现藻类细胞检测识别

深度学习YOLO实现藻类细胞检测识别

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?