Deep leaerning

1958 感知机(逻辑回归)

1969 感知机算法无法解决线性不可分

1980 多层感知机 DNN

1986 反向传播 三层以上的网络效果不好

1989 1hidden layer 效果就很好

2006 RBM

2009 GPU 加速

2011 语音识别

2012 图像识别

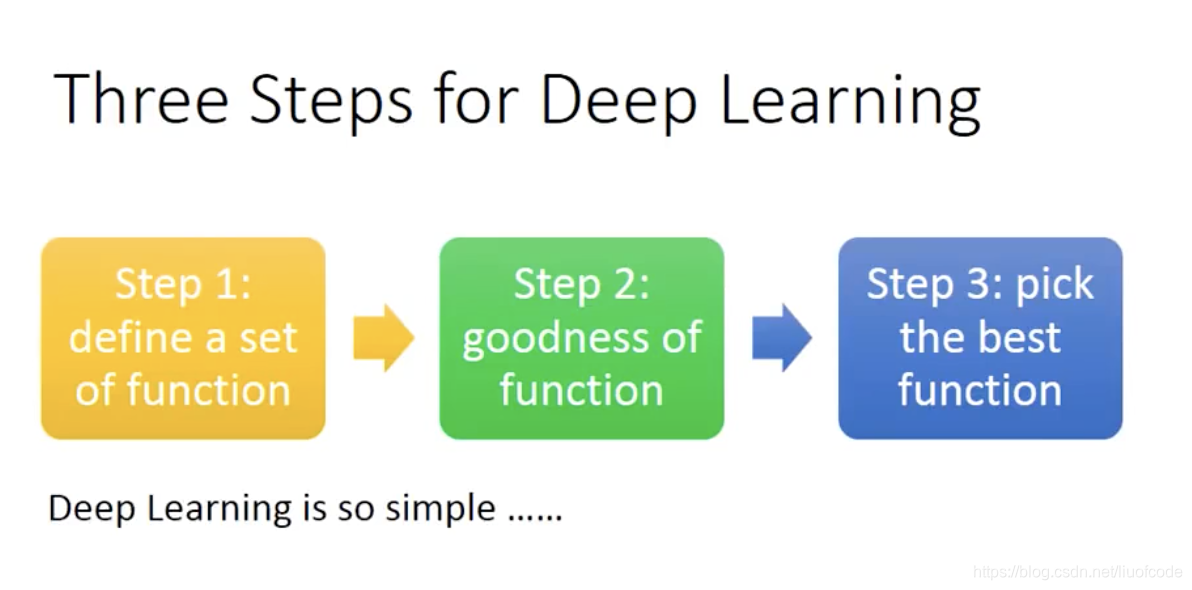

全链接神经网络

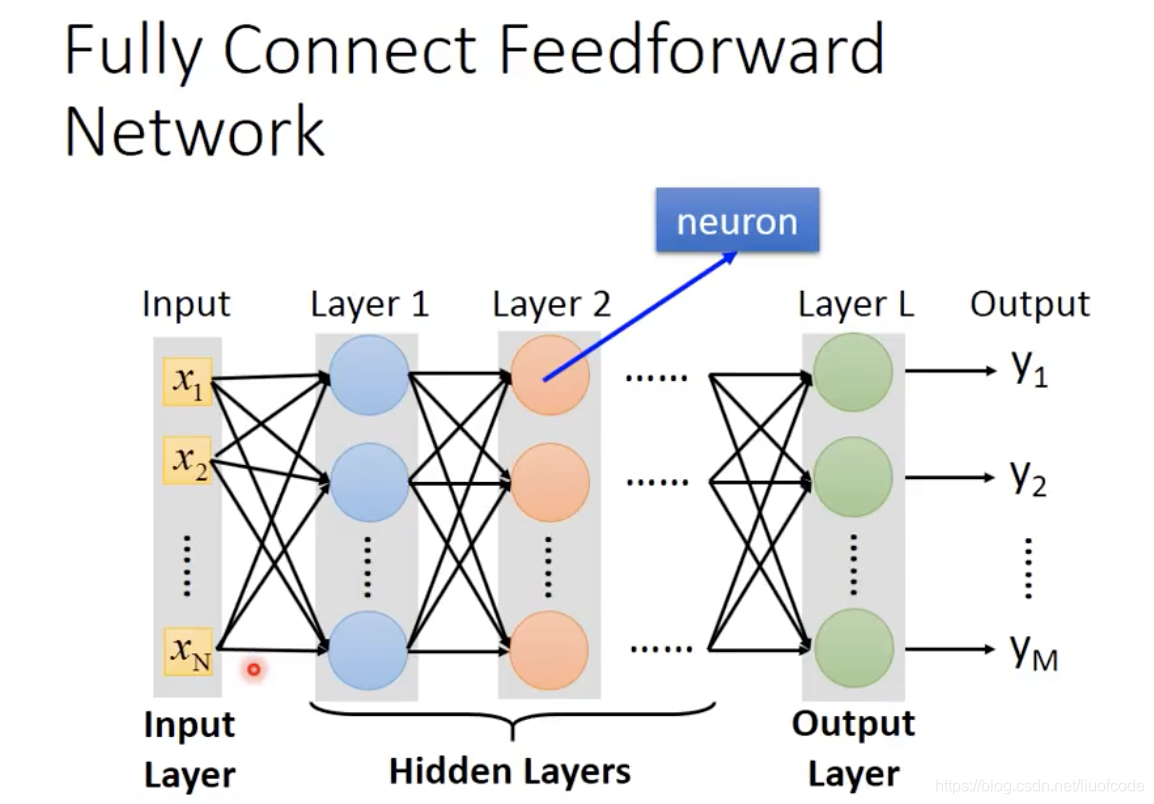

Input vector Output vector

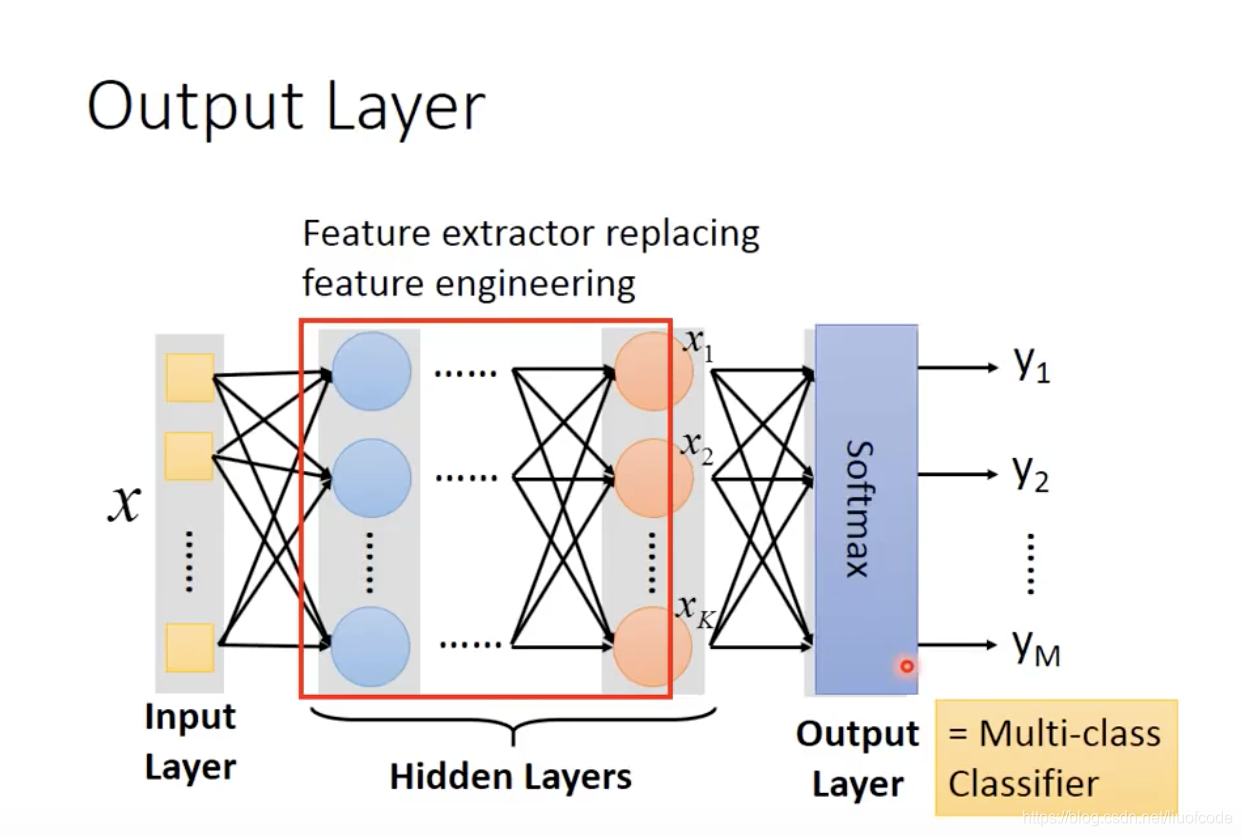

多个Hidden layer 就是深度学习

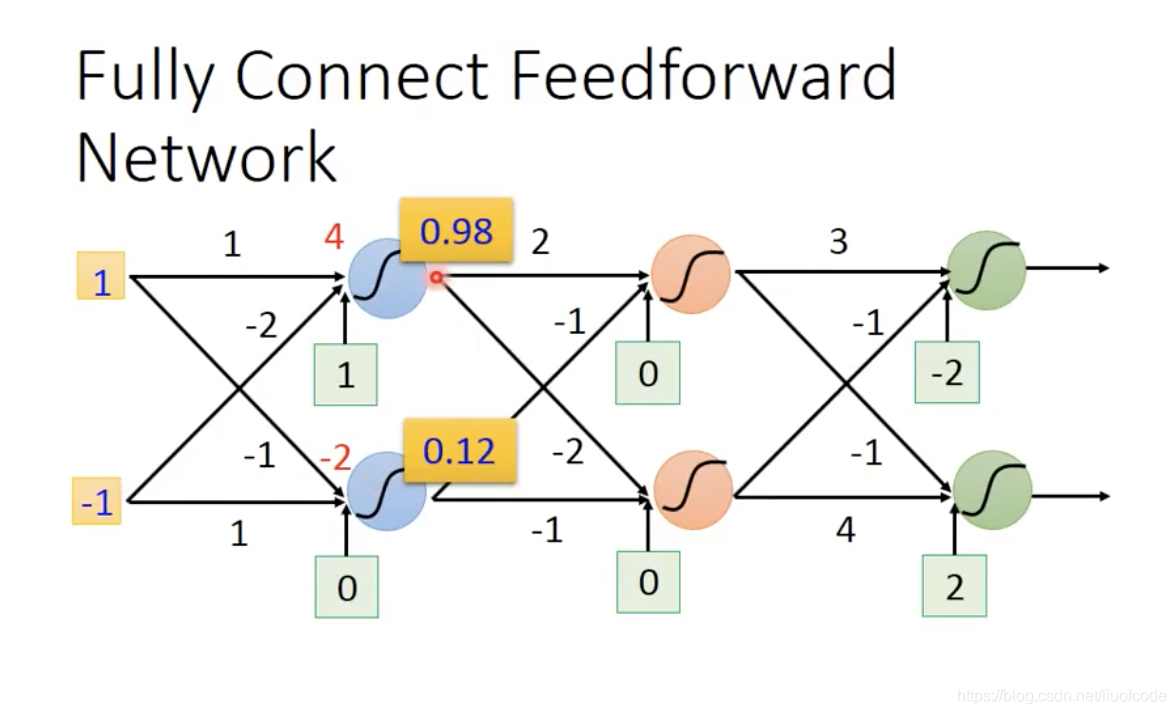

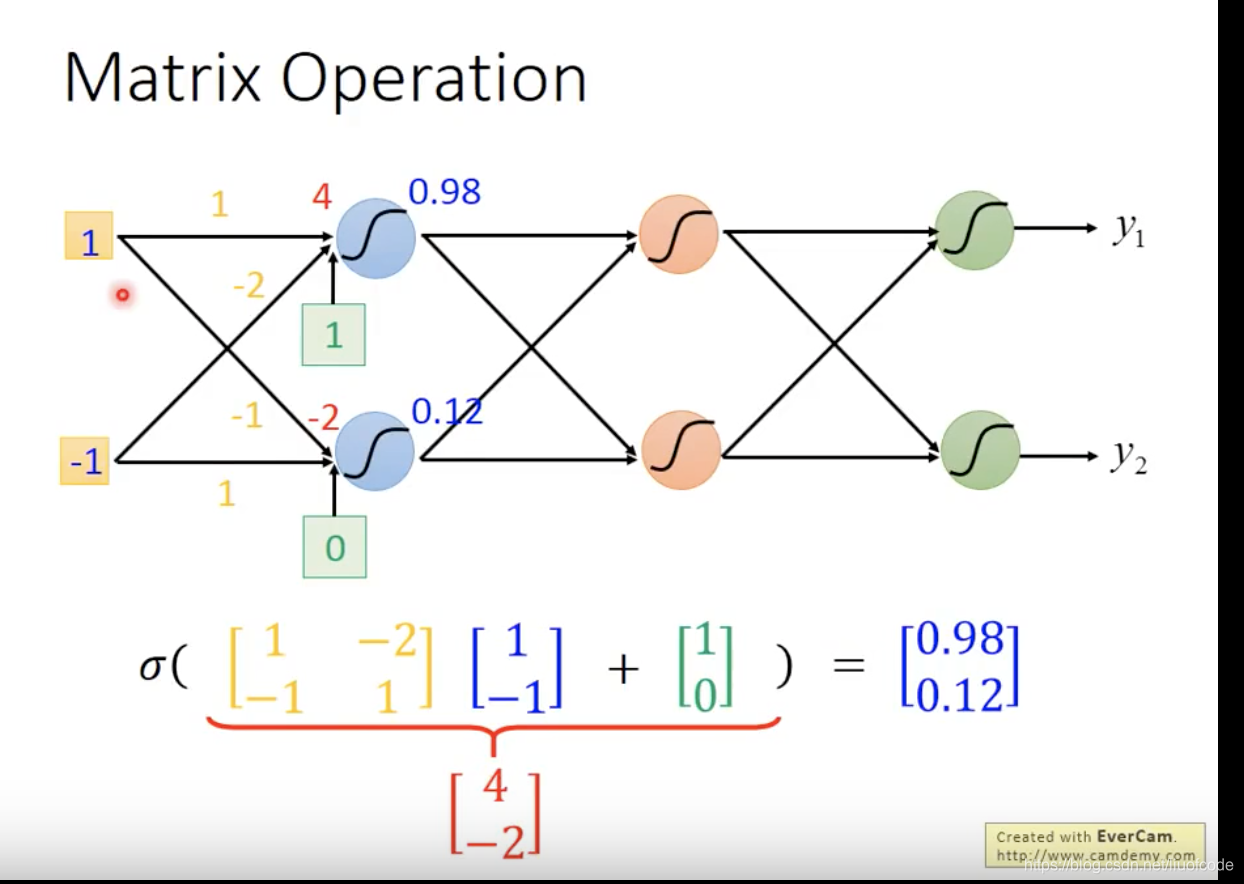

Matrix operation

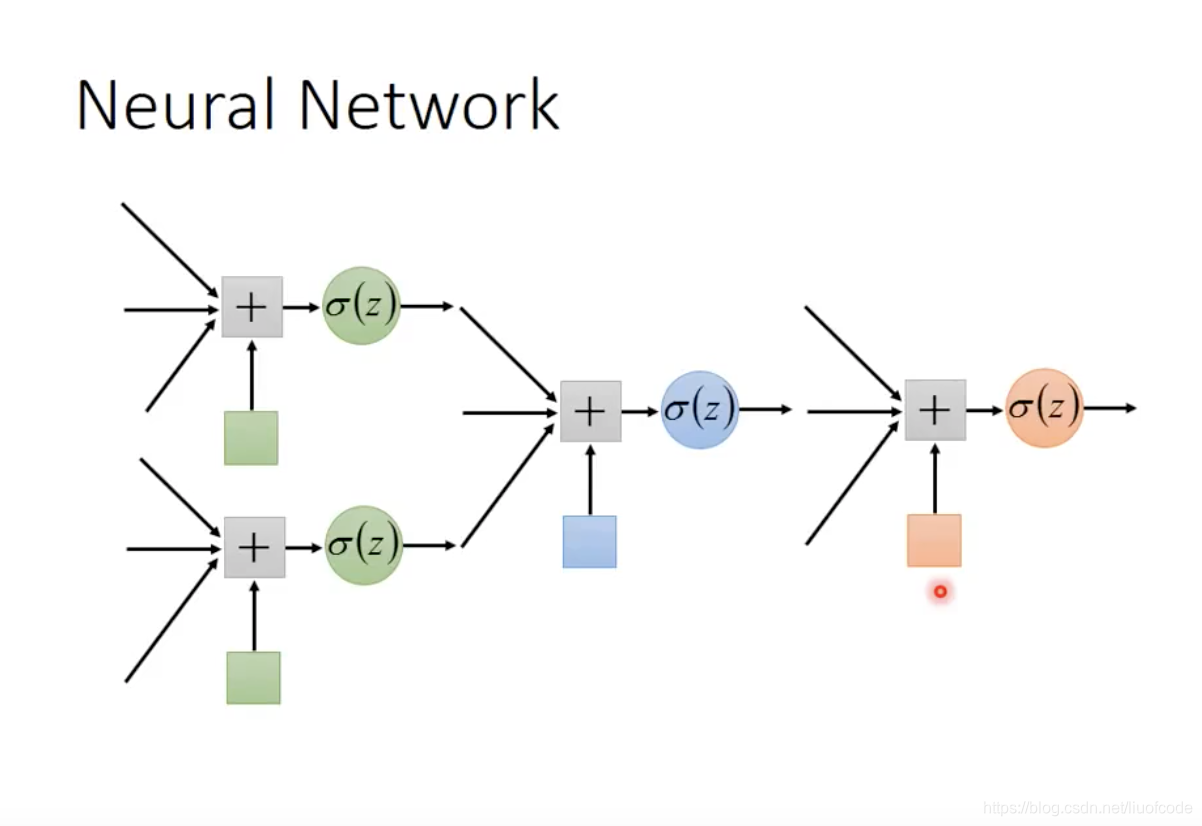

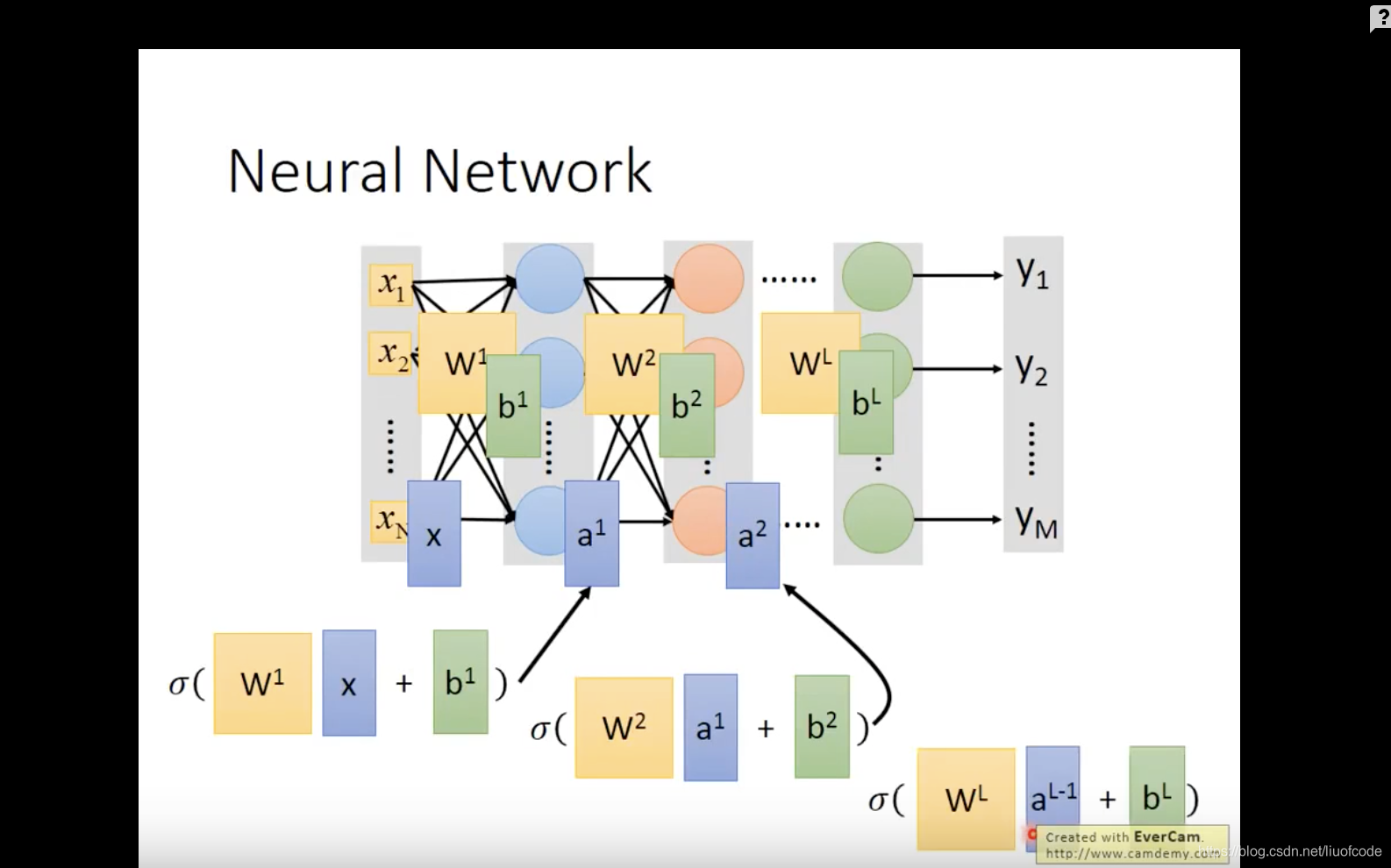

Neural network

Neural Network的结果 是一连串的矩阵想乘

Hidden layer 可以看作新的特征

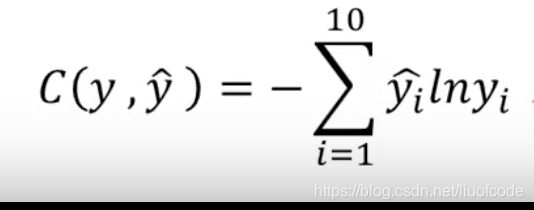

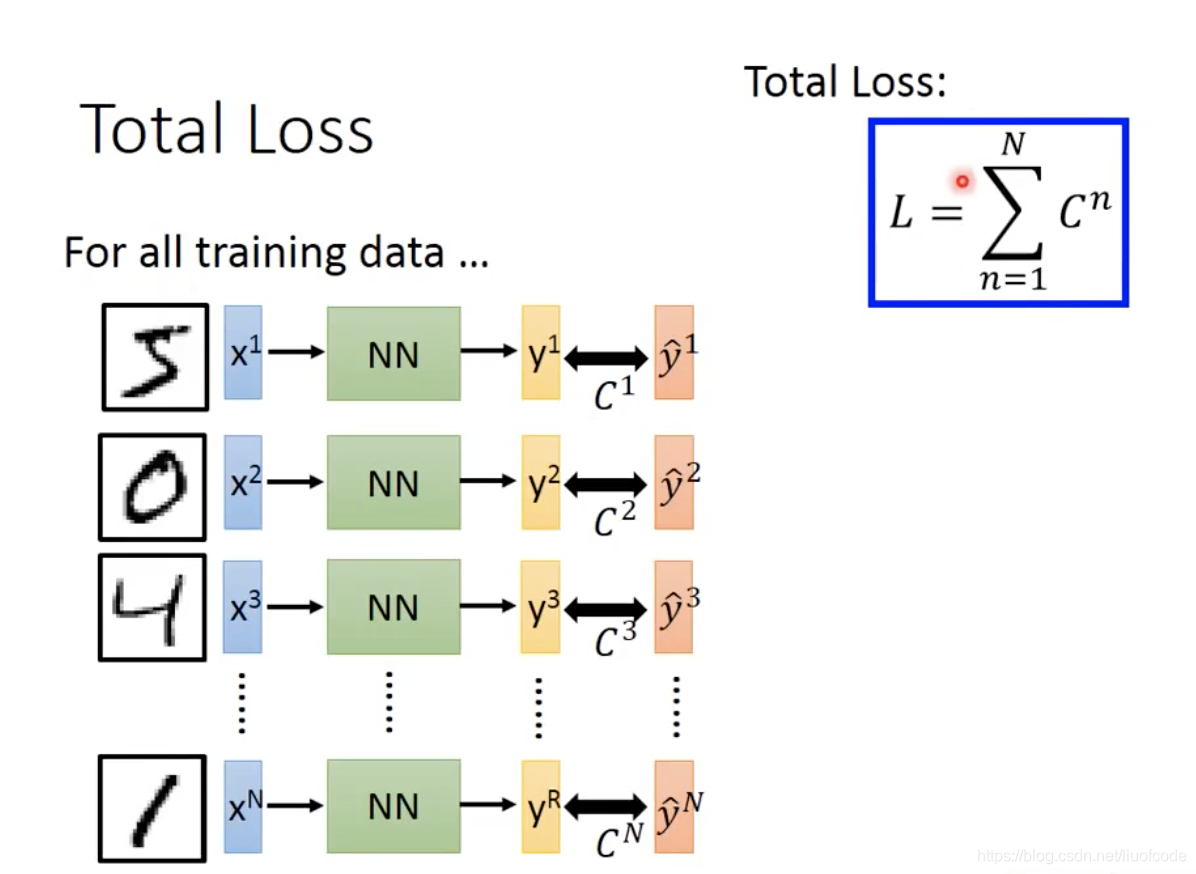

Loss

total loss

模型训练的方法 反向传播

链式求导和批量梯度下降

首先设置所有的layer 的weight 的初始值

然后计算出模型的输出值

通过通过如果loss 很大,不满足要求

通过最后一层求偏导,然后进行梯度下降,并一直往前更新,直到更新到input 层,

然后计算新的权重的神经网络的loss,

如果满足要求,该模型就是我们想要的模型,如果不满足则重复操作

2643

2643

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?