目录

二、第二根支柱:告别“信息过载”——独创的“迭代式”思考模式

2.2 DeepResearch的智慧:“分阶段复盘,轻装上阵”

三、第三根支柱:从“心法”到“修炼”——端到端训练与“基建为王”

🎬 攻城狮7号:个人主页

🔥 个人专栏:《AI前沿技术要闻》

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 阿里DeepResearch开源

📚 本期文章收录在《AI前沿技术要闻》,大家有兴趣可以自行查看!

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

前言:当AI不再是“问答机”,而是“研究员”

我们已经习惯了AI的有问必答,但如果问题本身就无比复杂,甚至连人类专家都需要花上数小时甚至数天去查阅资料、交叉验证、归纳总结呢?比如,“分析某地块最近两处房产的销售记录,找出价格更高者并说明成交金额”或者“结合最新判例和法条,论证某个法律纠纷中原告的行为是否违反资本维持原则”。

这些任务需要的不再是简单的信息检索,而是真正的研究能力。阿里巴巴最新开源的通义DeepResearch,正是为此而生。它彻底告别了“一问一答”的模式,进化为一位AI“研究员”。面对一个棘手的问题,它会自主规划研究路径,像人类专家一样工作:深度搜寻、多源验证、结构化归纳,最终生成一份有理有据、过程可溯的研究报告。

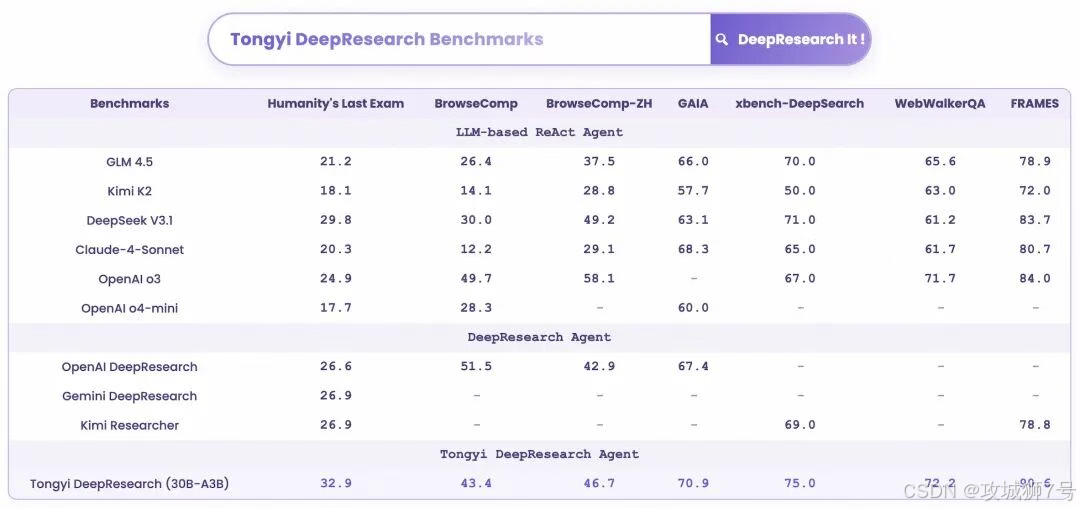

更惊人的是,这个仅需激活30亿参数的“轻量级”模型,在多个被誉为“AI高考”的权威榜单上,表现超越了基于OpenAI o3、DeepSeek V3.1等旗舰大模型构建的Agent。那么,这个AI“学霸”究竟是如何炼成的?阿里这次开源,给了我们一份详尽的“养成手册”。

一、第一根支柱:AI的“教材”革命——全自动合成数据炼金术

任何“学霸”的诞生,都离不开高质量的“教材”和“练习题”。在AI领域,这份“教材”就是训练数据。

1.1 痛点:昂贵且有限的人工“投喂”

传统上,训练AI Agent需要大量人工标注的数据,由人类专家一步步告诉模型在何种情况下应该采取何种行动。这个过程不仅成本高昂、耗时漫长,而且人类标注员的水平和耐心也决定了数据质量的上限。这套“手工作坊”式的生产方式,严重限制了AI Agent能力的进化。

1.2 阿里的解法:建造一个“博士级问题”的自动化工厂

通义DeepResearch团队的核心突破之一,就是构建了一套几乎完全摆脱人工依赖的全自动合成数据体系。他们的目标是,用机器源源不断地创造出比人类标注质量更高、规模更庞大、难度可控的训练“教材”。

这个“数据工厂”分为两个关键阶段:

(1)第一步:打下“学徒”基础 (Agentic CPT)

在正式解难题前,首先要让模型知道“什么是Agent”、“如何使用工具”。团队首次引入了“智能体增量预训练”(Agentic CPT)的概念。他们构建了一个庞大的“开放世界知识记忆库”,其中包含了海量文档、网页数据、知识图谱等,然后让AI自动从这个记忆库中生成无数基础的“问题-答案”对和“规划-推理-决策”的动作序列。

这个阶段就像是给一个AI“学徒”灌输了基础知识和工具使用方法,为后续的“专升博”打下了坚实的基础。

(2)第二步:系统性地制造“奥数题” (后训练数据)

基础打好后,如何让模型能力“百尺竿头,更进一步”?团队开发了一套可系统性提升问题复杂度的方案(以WebShaper等工作为代表),堪称“AI奥数题”自动出题机。

- 保证问题源于真实:从真实世界的网站和知识图谱出发,确保问题不是凭空捏造。

- 人为制造“迷雾”:在生成问题时,故意模糊或隐藏关键信息,强迫模型必须通过多步推理和探索才能找到答案。

- 难度可控升级:最关键的是,他们将“提升难度”这件事,建模成了一系列可控的“原子操作”。比如合并两个相似概念、增加一个约束条件等。通过这些操作的组合,可以像玩乐高一样,精准地控制每一道题的难度等级。

最终,这个自动化流程甚至能创造出需要跨学科知识、多源推理的“博士级”研究难题,从而不断将模型的能力推向极限。

二、第二根支柱:告别“信息过载”——独创的“迭代式”思考模式

有了顶级的“教材”,还需要高效的学习和思考方式。

2.1 传统Agent的困境:在无限扩展的“草稿纸”上迷失

许多顶尖的Agent在处理复杂任务时,采用的是一种“单窗口、线性累加”的信息处理模式。它们会将所有的中间思路、搜索到的网页、工具返回的结果,全部堆积在一个不断变长的单一上下文中。

这就像一个研究员在一张无限长的草稿纸上打草稿,从不整理。任务初期还好,但随着信息越来越多,这张“草稿纸”会变得混乱不堪,充斥着大量冗余、甚至矛盾的信息。最终,AI会面临“认知空间窒息”和“噪声污染”,导致推理能力下降,在长程、复杂的研究任务中“迷失”方向。

2.2 DeepResearch的智慧:“分阶段复盘,轻装上阵”

为了解决这个问题,DeepResearch在处理极端复杂任务时,会启动一种名为“迭代式深度研究范式”(Iterative Deep-Research Paradigm)的“深度模式”(Heavy Mode)。

它的核心思想是“综合与重构”,彻底抛弃了那张无限长的草稿纸。

(1)分解任务:将一个庞大的研究任务,分解为一系列独立的“研究回合”。

(2)精简工作区:在每一回合开始时,Agent不会加载上一回合所有的历史记录。相反,它会先进行“复盘”,只从上一轮的信息中提取最精华的结论和关键证据,构建一个全新的、轻量且专注的工作空间。

(3)专注执行:在这个干净的工作空间里,Agent再进行新一轮的“思考-综合-行动”循环,并将新的关键发现整合进一个不断演变的核心报告中。

这种“分阶段复盘、轻装上阵”的模式,让Agent在执行超长期任务时,始终能保持清晰的“认知焦点”和高质量的推理能力,不会被信息的洪流淹没。

三、第三根支柱:从“心法”到“修炼”——端到端训练与“基建为王”

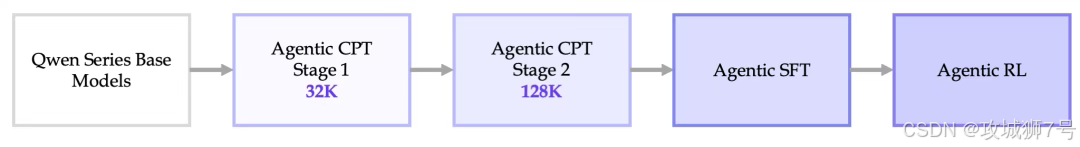

(1)贯穿全程的训练闭环:CPT → SFT → RL

如果说数据是“教材”,推理模式是“思考方法”,那么训练流程就是贯穿始终的“修炼心法”。团队打通了“Agentic CPT(增量预训练)→ SFT(监督微调)→ Agentic RL(强化学习)”的端到端全链路,让模型从一个基座开始,逐步学会基础技能,再通过模仿专家进行冷启动,最后在强化学习中实现自我探索和进化。

(2)一个反直觉的洞见:好数据和好环境比好算法更重要

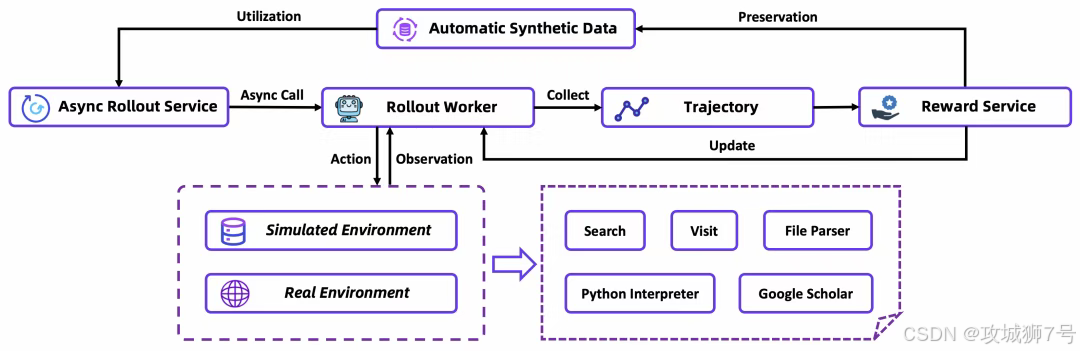

在最关键的强化学习环节,团队分享了一个至关重要的洞见:算法固然重要,但并非成功的唯一决定因素。数据质量和训练环境的稳定性,可能是决定项目成败的更关键一环。

他们发现,直接在人工标注的测试集(如BrowseComp)上训练模型,效果远不如使用他们自己合成的数据。原因是,人工数据规模有限且含有更多噪声,模型很难从中提炼出清晰的学习信号。而他们“数据工厂”生产的合成数据,提供了一致性更高的潜在分布,能让模型进行更有效的学习。

为了保障训练的稳定高效,他们构建了一套全栈式的基础设施“护城河”:包括离线仿真训练环境、稳定的工具沙盒、自动数据管理流程等。这确保了AI Agent的“修炼”过程不会被外界不稳定因素(如网络波动、API错误)所干扰。

四、从实验室到生活:AI“学霸”能做什么?

这些重磅研究,并非停留在论文里。通义DeepResearch早已走向落地,赋能阿里旗下多个产品。

你的专属出行规划师:“小高老师”:在高德地图中,DeepResearch能够理解并执行极其复杂的出行规划指令,比如“在西湖边上找家评分4.5以上的浙菜馆,得有儿童餐,而且从地铁站走过去不能超过1公里”,为你提供精准的个性化方案。

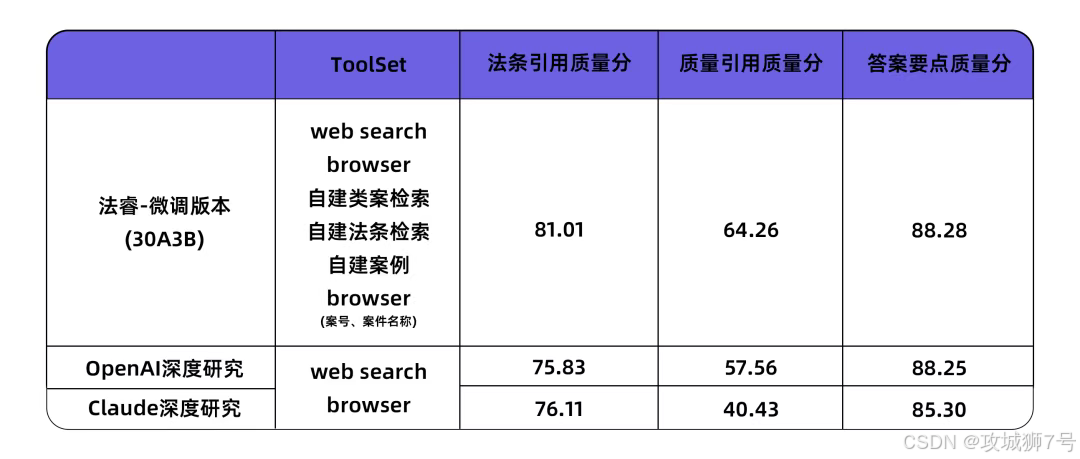

你的法律研究助理:“通义法睿”:在对专业性、准确性要求极高的法律领域,DeepResearch赋能的“通义法睿”能自动检索法条、类案和裁判文书,并进行深度归纳分析,其表现在关键指标上全面领先国际顶尖模型。

结语:开源的不仅是模型,更是一套“方法论”

通义DeepResearch的开源,是AI社区的一次重磅事件。它带来的不仅是一个在榜单上SOTA的模型,更重要的是,它慷慨地分享了其背后的全套“技术秘方”:如何系统性地解决数据瓶颈,如何设计更鲁棒的推理范式,以及如何搭建高效的训练闭环。

它证明了,通过卓越的系统工程和方法论创新,轻量级模型同样可以在“深度研究”这一Agent能力的珠穆朗玛峰上与巨头一较高下。这套全栈开源的“学霸养成手册”,无疑将激发全球开发者的创新,加速一个“人人皆可构建专属深度研究智能体”时代的到来。

GitHub:https://github.com/Alibaba-NLP/DeepResearch

Hugging Face:https://huggingface.co/Alibaba-NLP/Tongyi-DeepResearch-30B-A3B

魔搭社区:https://modelscope.cn/models/iic/Tongyi-DeepResearch-30B-A3B

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?