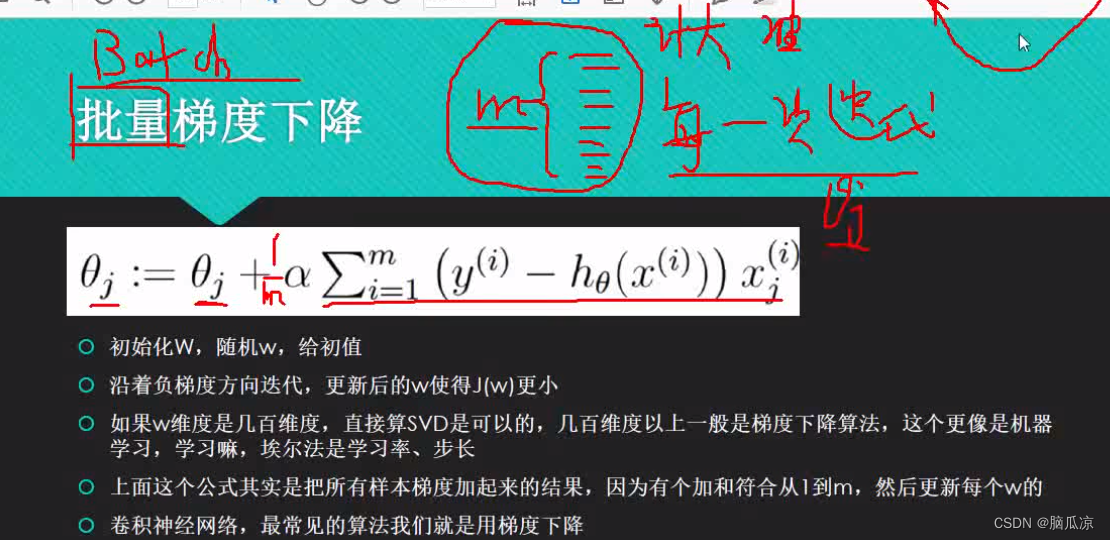

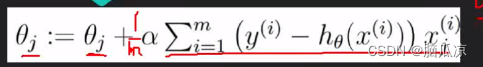

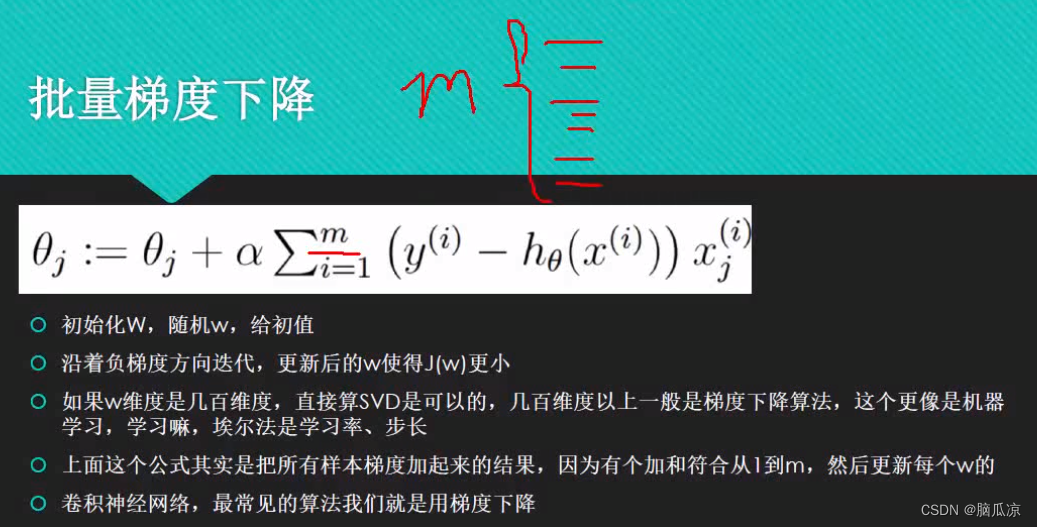

然后我们首先来看一下上一节说了,批量梯度下降处理,可以看到上面的公式

这里的thetaj: 就是下一个theta要求的,然后它 = thetaj + 阿尔法 注意阿尔法是 学习率

也就是之前我们说的,一维数据的时候 theta t+1 = theta - g .h 这里的h就是学习率,

也就是这里的阿尔法一个意思,然后后面的![]()

这个部分是学习率.

批量梯度下降,其实就是,每一个theta的获取,我们都带入m个样本数据,不是一样,我们,具体说是m行n列对吧,然后,以前我们是1维的,带入的就是1个

本文介绍了批量梯度下降和随机梯度下降两种优化算法,探讨了它们在机器学习中的应用。批量梯度下降通过全部样本计算梯度,适合大数据集但计算成本高;随机梯度下降每次仅用一个样本,速度快但可能偏离最优解。通过动态调整学习率,可以改善随机梯度下降的收敛速度。文中还提供了Python代码示例,展示了随机梯度下降的实现过程。

本文介绍了批量梯度下降和随机梯度下降两种优化算法,探讨了它们在机器学习中的应用。批量梯度下降通过全部样本计算梯度,适合大数据集但计算成本高;随机梯度下降每次仅用一个样本,速度快但可能偏离最优解。通过动态调整学习率,可以改善随机梯度下降的收敛速度。文中还提供了Python代码示例,展示了随机梯度下降的实现过程。

订阅专栏 解锁全文

订阅专栏 解锁全文

3712

3712

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?