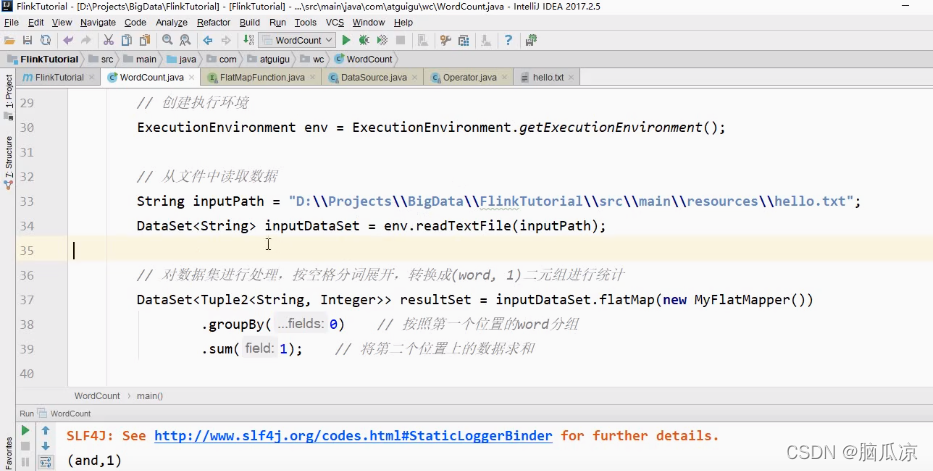

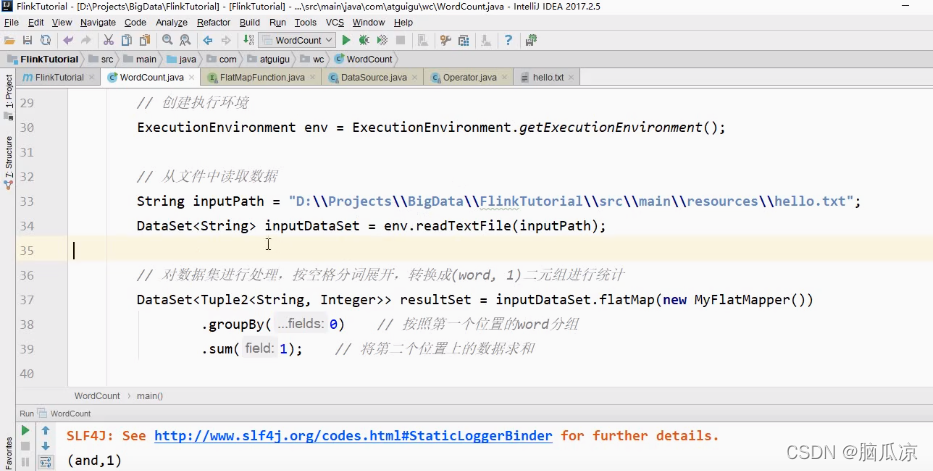

我们看一下,上一节我们用批处理的方式,来处理了一个wordcount文件,要知道批处理,是用来进行

离线数据处理,那些数据是死的放在那里的.然后这次我们来看,我们用flink提供的流式处理,来实现这个wordCount功能.

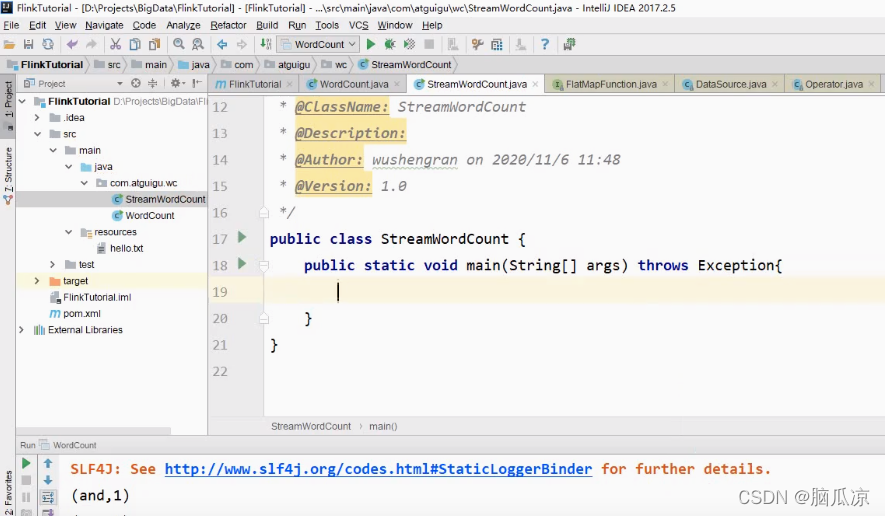

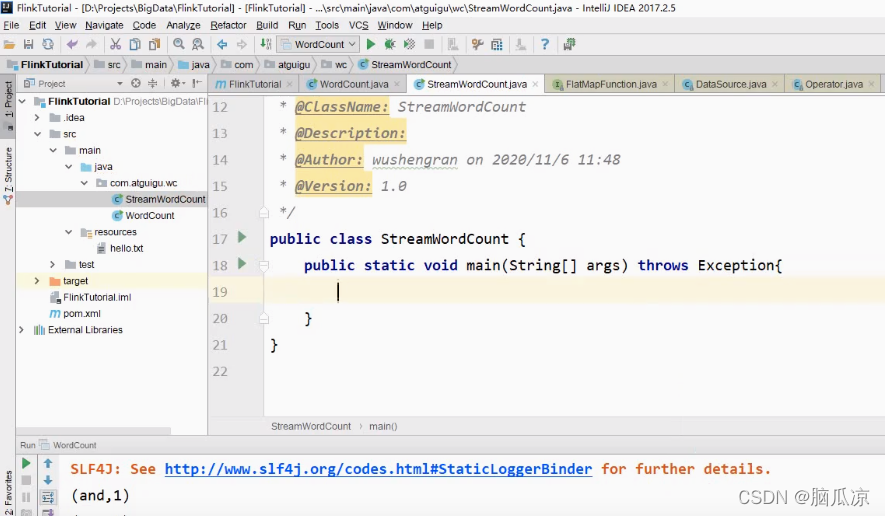

首先我们创建一个StreamWordCount这个类,然后,写一个main方法

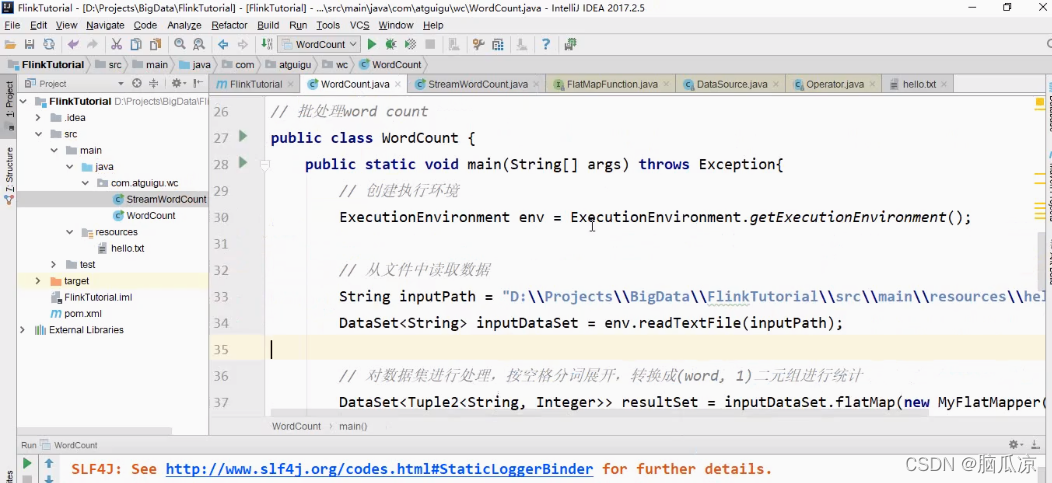

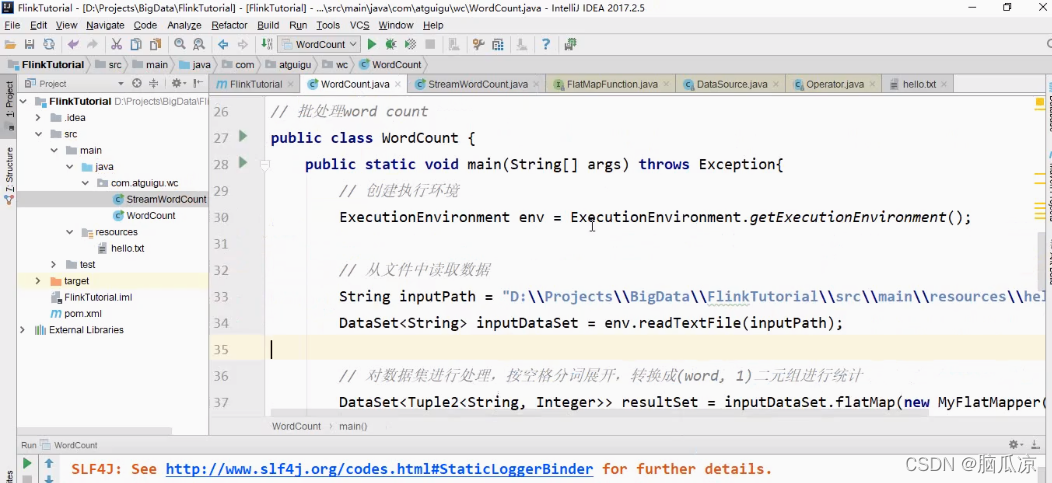

然后我们去看看之前批处理的WordCount,可以看到用的是一个批处理的执行环境

ExecutionEnvironment

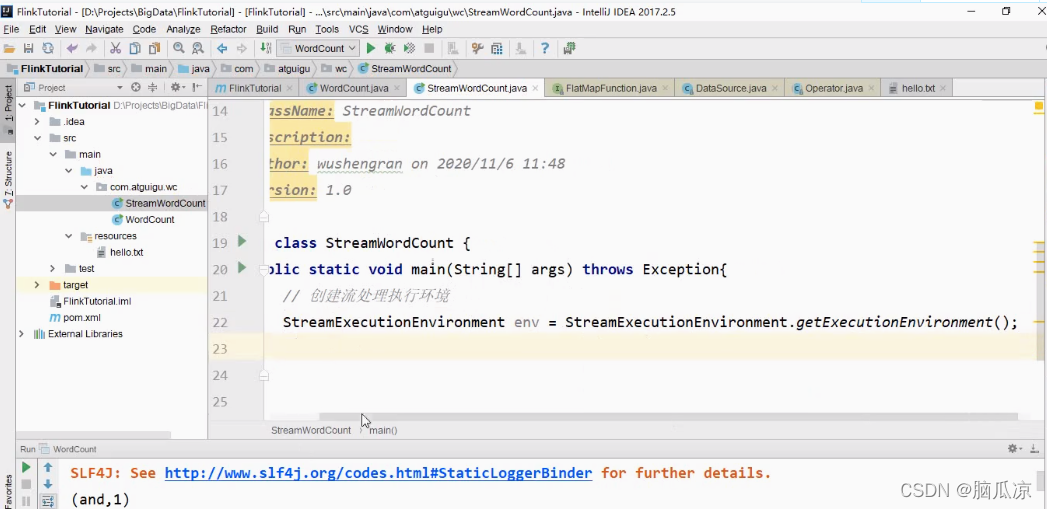

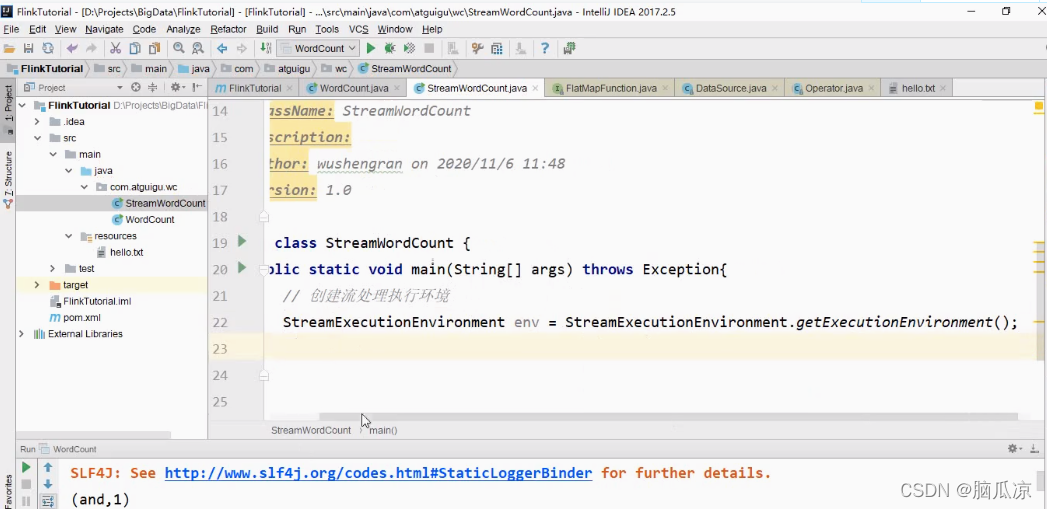

然后我们来看,流处理的,环境是

我们看一下,上一节我们用批处理的方式,来处理了一个wordcount文件,要知道批处理,是用来进行

离线数据处理,那些数据是死的放在那里的.然后这次我们来看,我们用flink提供的流式处理,来实现这个wordCount功能.

首先我们创建一个StreamWordCount这个类,然后,写一个main方法

然后我们去看看之前批处理的WordCount,可以看到用的是一个批处理的执行环境

ExecutionEnvironment

然后我们来看,流处理的,环境是

1543

1543

2320

2320

587

587

2823

2823

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?