文章概要

本教程介绍了一种使用“整合包”在本地部署和安装Stable Diffusion WebUI的方法,无需深入了解计算机知识,对新手非常友好。要注意的是,安装时需要预留100G到200G的磁盘空间,并且对电脑的显卡要求较高。

前言

本文介绍的工具是【绘世整合包】,由秋叶大佬开发,是目前市面上最简便的Stable Diffusion整合包之一。这个整合包跳过了大部分需要网络和Python知识的步骤,集成了过去几个月里AI绘画领域最核心的插件,如ControlNet,并且自带最新的深度学习模块。整合包能够与外部环境完全隔离,即便没有任何编程背景的人,也可以从零开始学习使用Stable Diffusion,并在几乎不需要进行额外设置的情况下,立即体验最新的技术成果。

什么是Stable Diffusion(SD)?

Stable Diffusion是于2022年发布的深度学习模型,用于将文本转换为图像。它是一种潜在扩散模型,由创业公司Stability AI与多个学术研究机构和非营利组织合作开发。目前,Stable Diffusion的源代码和模型已经开源,由AUTOMATIC1111在GitHub上维护,全球开发者正在共同推进其发展。虽然完整版对网络环境有一定要求,但国内开发者已经封装了多个本地化版本,极大地推动了其普及。

Stable Diffusion的一个重要特点是可以在本地离线运行,只需配备至少8GB显存的中档GPU即可。笔者建议显存最好为12GB以上。由于AI模型训练和生成的原理涉及软硬件结合的深度学习技术,因此通常需要使用NVIDIA显卡(如CUDA、CUDNN)以及Python相关的深度学习组件(如xformer、pytorch)。学习AI进阶知识时,经常需要掌握这些编程技术,这对新手来说可能会有一定难度。而使用绘世整合包,可以有效避免这些复杂操作,安装和使用更加简单明了。

SD的基本概念

- 大模型:是通过大量素材和SD基础模型(如SD1.5/SD1.4/SD2.1)进行深度学习后生成的,可以直接用于图像生成,决定了最终生成图像的大方向。大模型的文件格式通常为CKPT或SAFETENSORS。

- VAE:类似于滤镜的功能,它是对大模型的补充,能够稳定图像的色彩范围。通常也以CKPT或SAFETENSORS格式存在。

- LoRA:是一种模型插件,是基于某个大模型进行深度学习后生成的小模型。需要配合大模型使用,可以在一定范围内影响生成图像的风格,或者增加大模型中不存在的元素。如果LoRA基于SD基础模型进行训练,那么它在不同大模型之间切换时具有较好的通用性;但如果基于特定大模型进行训练,则在配合该大模型使用时可能会有更好的效果。

- ControlNet:这是一个强大的插件,使Stable Diffusion能够通过现有图像提取线条或景深信息,然后反向应用于图像处理,使生成效果更具指导性。

- Stable Diffusion Web-UI(SD-WEBUI):由开源社区的AUTOMATIC1111开发的基于Stability AI算法的开源软件,允许用户在浏览器中通过图形界面控制Stable Diffusion。

绘世整合包的优势

绘世整合包解决了使用WebUI时对网络和Python环境的高要求。它内置了与系统隔离的Python环境,并集成了Git工具,用户无需了解这些软件的使用方法即可运行程序。这样一来,大大降低了使用门槛,使更多的人能够轻松体验AI图像生成的乐趣。

一、Stable Diffusion

下载百度网盘下载链接在文末尾

二、Stable Diffusion 安装

我们可以先安装启动器的运行依赖,并解压包本体。

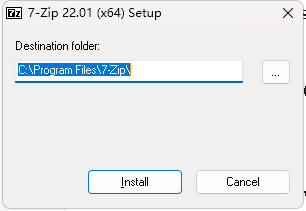

第一步:打开“启动器运行依赖-dotnet-6.0.11.exe”来安装。

第二步:解压“sd-webui-aki

注意:当我们解压好启动器本体的时候,暂时还不要启动,先一起把模型安装了。

第三步:导入核心数据。

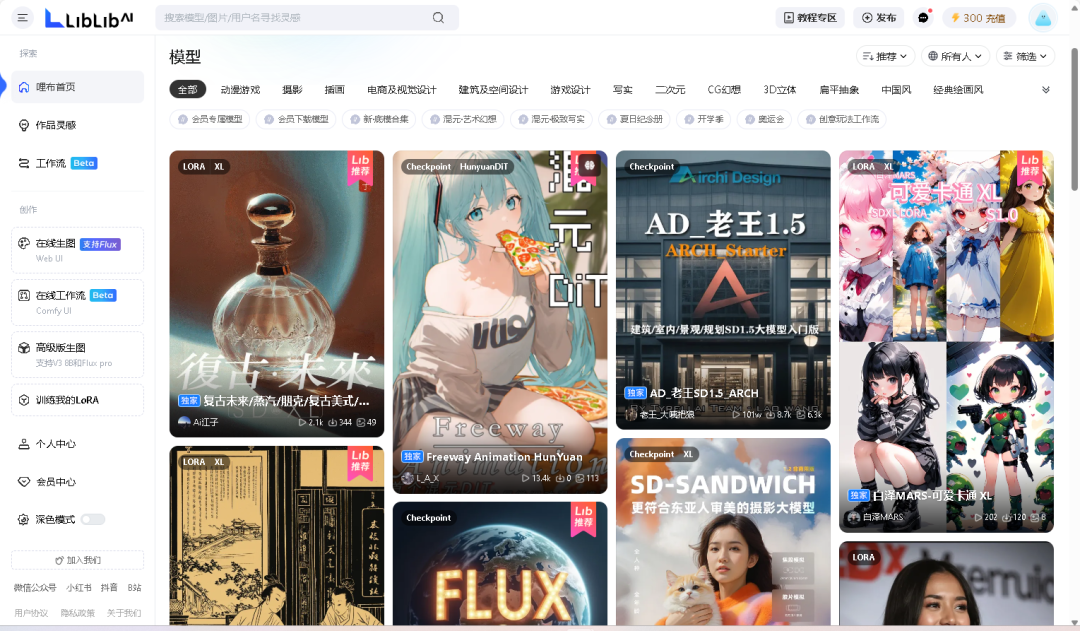

1、下载“推荐大模型”文件夹中的模型。大模型可以在https://www.liblib.art/下载

2、并把文件夹里的所有模型

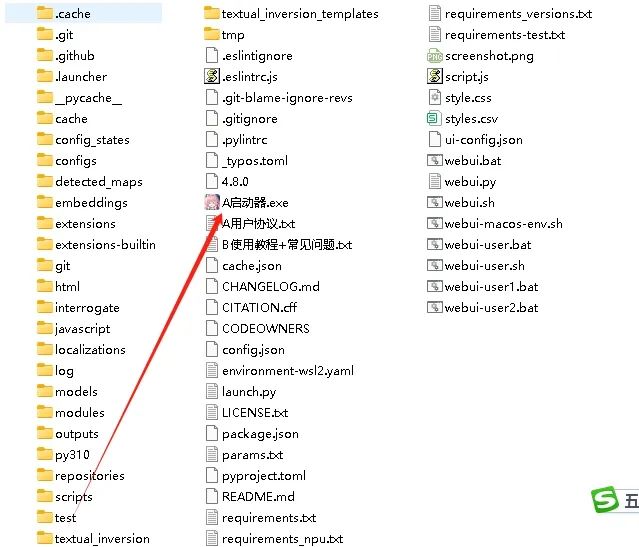

放在这个目录下:\sd-webui-aki-v4\models\Stable-diffusion

3、同时,还要下载ControlNet模型。

4、ControlNet模型文件夹里的所有内容,放在这个目录下:\sd-webui-aki-v4\models\ControlNet

5、最后,需要单独下载推荐LoRA。

6、这些LoRA是笔者为了方便小伙伴们取用改了名的,需要全部放在这个目录下:sd-webui-aki-v4\extensions\sd-webui-additional-networks\models\lora

三、Stable Diffusion 使用教程开启软件运行。

解压并导入完毕上述数据之后,就可以点开启动器了。

1、在安装目录下往下拉,找到这个“A启动器.exe",双击。

2、再点击右下角的一键启动。

3、再让这个界面多跑一会儿。

4、就可以看到它自动在浏览器中打开了一个新的网页,就算是启动成功了。

注意:

有时候会出现警告错误或缺少模块,但是又不会影响正常运行。如果它没自动打开,可以手工去浏览器输入网址:http://127.0.0.1:7860

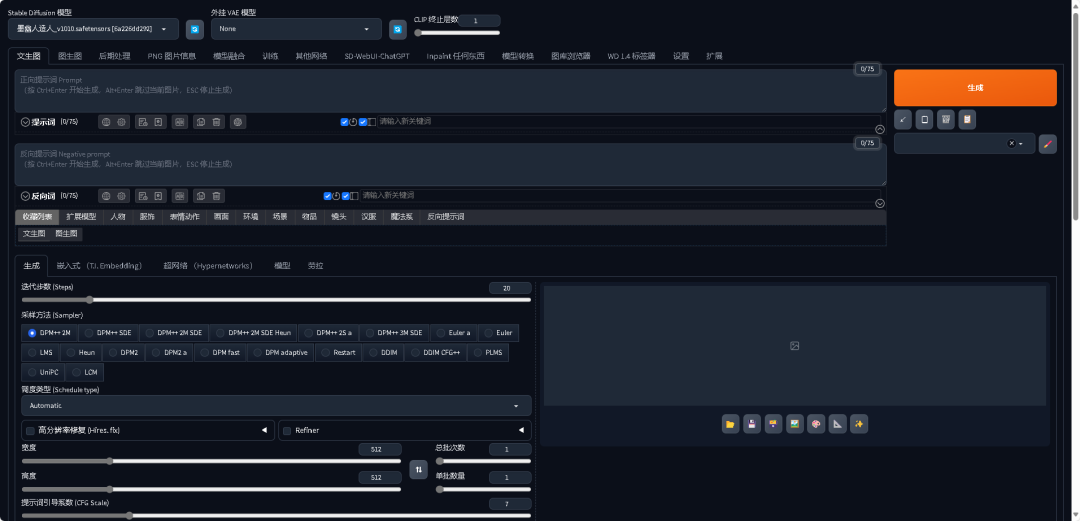

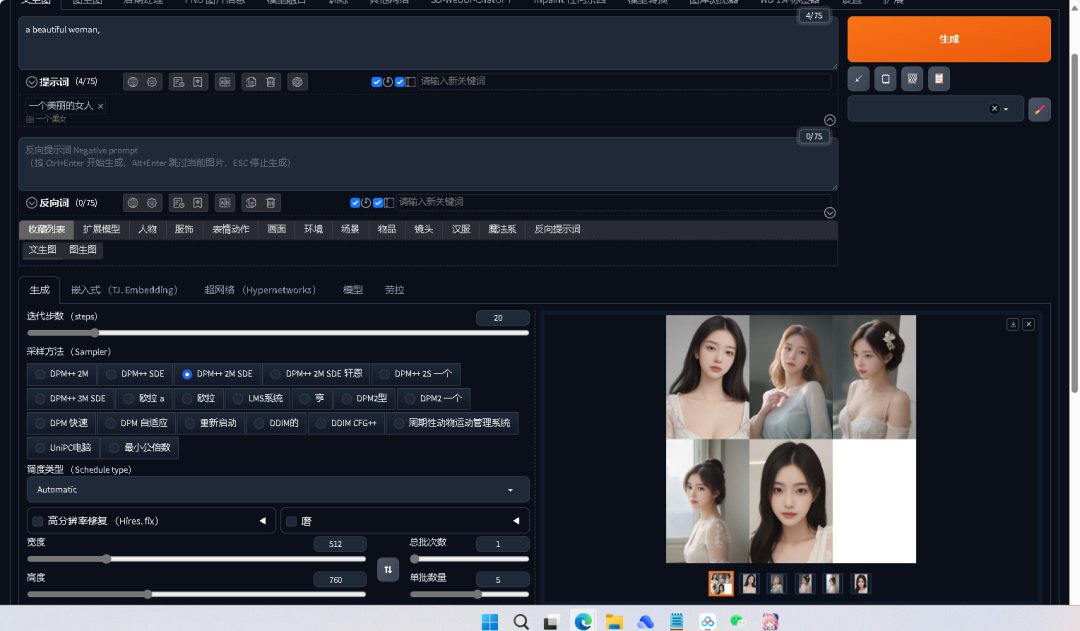

5、最终的效果。例如:输入一个关键词“一个美女”,点击“生成”,结果效果图如下:

总结:

不过这玩意10G,加了一些lora,controNet,大模型,一下子就70个G,效果还不错,不过大部分都是civitai中直接下载别人训练好的模型。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

需要的可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

1.stable diffusion安装包 (全套教程文末领取哈)

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

2.stable diffusion视频合集

我们在学习的时候,往往书籍代码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入门stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?