前面我们学习了如何使用 ControlNet 的姿势约束,通过姿势约束控制出图的人物姿势和原图一致。

Stable Diffusion ControlNet 姿势约束终篇,解锁任意手部形状,实现手部自由

但有的时候我们不仅仅是需要想要和原图姿势一致,还需要调整人物的姿势,想要实现这种功能按照之前学习的内容就只能通过不断的调整提示词来控制。

今天要学习的 ControlNet OpenPose Editor 就可以很好的解决这个问题,从而实现姿势自由了!

一 OpenPose Editor

我们可以将 OpenPose 理解成是对 ControlNet 姿势约束的一大增强。前面我们学习了 DWOpenPose,通过 DWOpenPose 可以更好的提取到图片手部的细节。但终究还是直接提取,不能很好的自己编辑姿势。

而 OpenPose 则可以很好的支持通过导入图片识别姿势的同时,也能够直接编辑骨骼图,通过对骨骼图的编辑,可以实现任意姿势的图片。

要注意的是不管是 DWOpenPose 还是 OpenPoseEditor ,都只是在提取或者说是制作姿势特征图。而对特征图的识别和渲染方式没有改变,都是通过 control_v11p_sd15_openpose 实现。

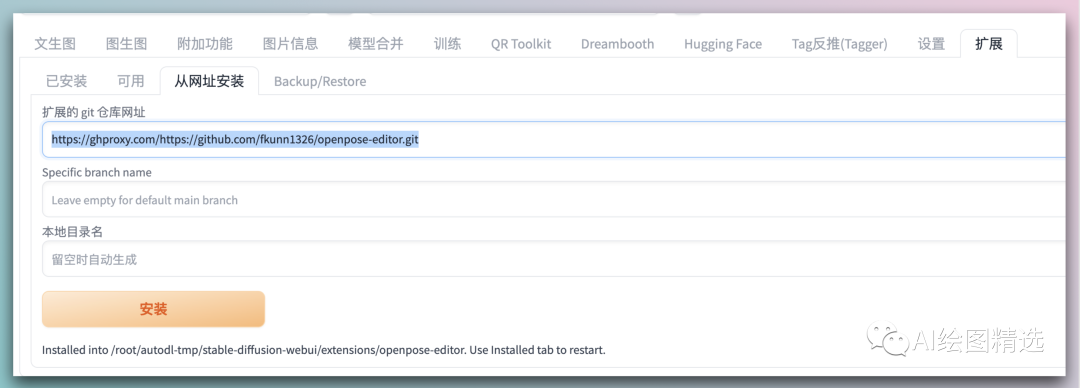

安装安装和其他插件的安装一直,将安装连接 https://ghproxy.com/https://github.com/fkunn1326/openpose-editor.git 直接贴上去,通过网址安装。(安装完成后记得重启)

安装完成重启后就可以在 web ui 上看到 OpenPose编辑器 的菜单

二 功能介绍

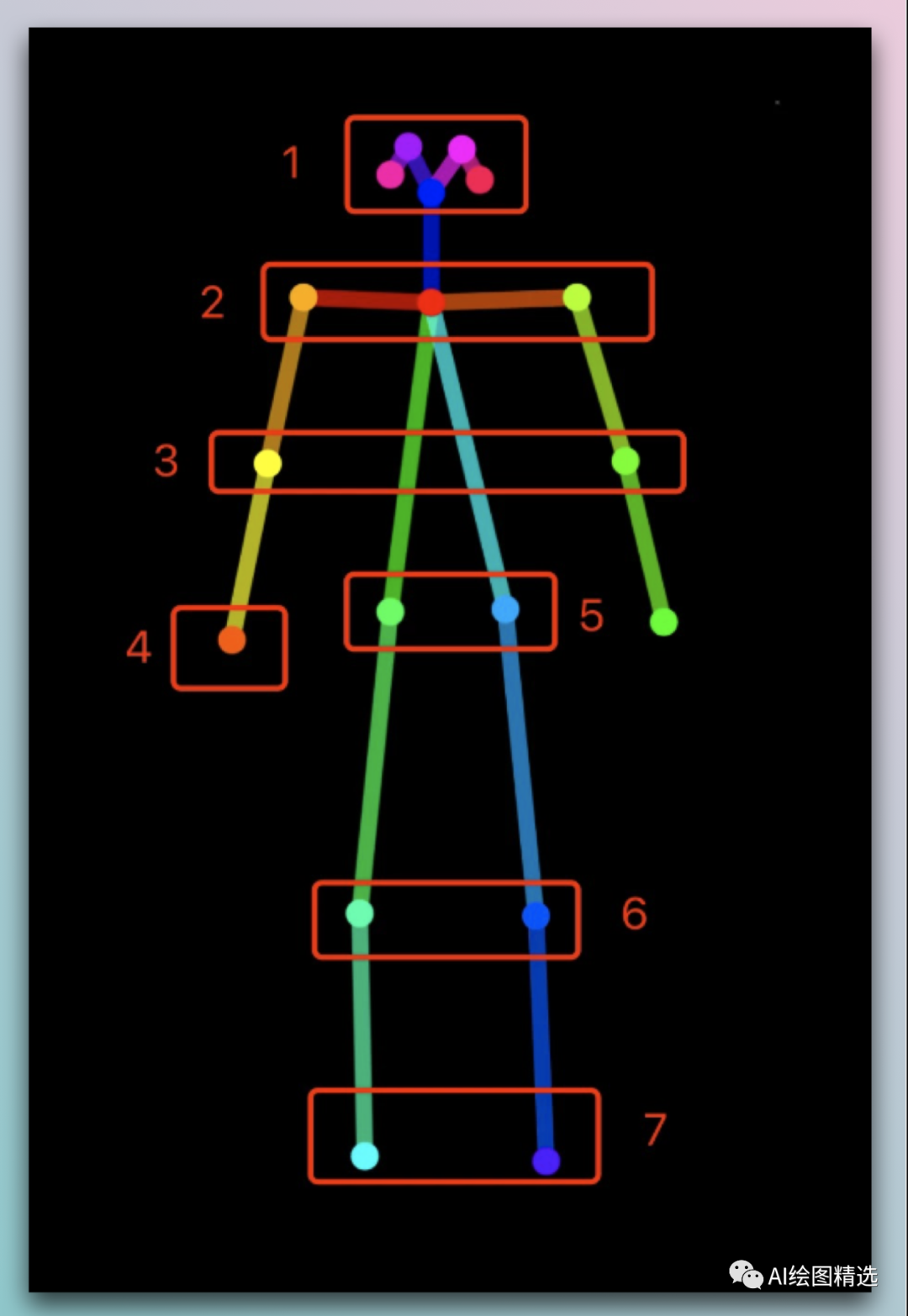

骨骼图

其中对应序号的人体位置:

- 1:眼睛

- 2:肩关节

- 3:肘关节

- 4:腕关节

- 5:髋关节

- 6:膝关节

- 7:踝关节 可以直接通过鼠标来控制对应的人体位置。

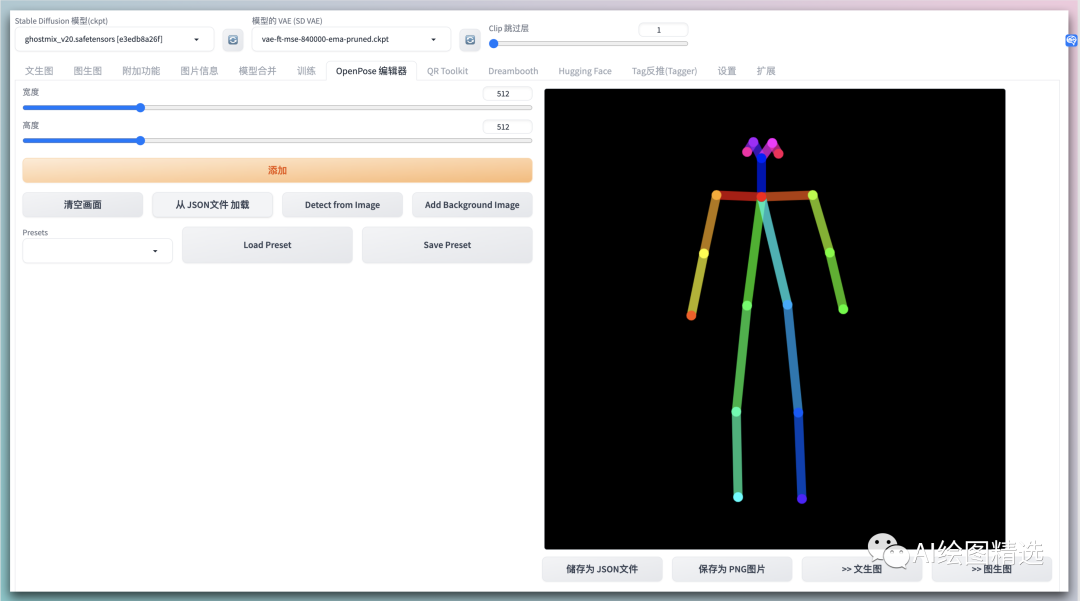

页面功能

其中:

- 宽度&高度:可以调整右侧画面的长宽比,可以根据成图时画面的尺寸比例进行设置

- 添加:在右侧画面中新增一个骨架

- 清空画面:点击后会一键清空右侧所有内容

- 从JSON文件加载:从电脑中选择JSON文件进行加载

- Detect from Image:可以导入一张图片,SD会自动读取人物骨骼姿态,读取成功后可以进行二次编辑和调整

- Add Background Image:可以导入一张图片作为背景,再根据背景图片调整骨架

- Load Preset:加载预设

- Save Preset:保存预设(点击后会把右侧的骨架信息作为预设进行保存)

- 储存为JSON文件:点击按钮后,会把上方骨架信息保存为JSON文件,后续可直接导入文件

- 保存为PNG图片:保存图片到本地电脑中

- 文生图:把骨架信息导入到文生图的ControlNet中

- 图生图:把骨架信息导入到图生图的ControlNet中

三 使用

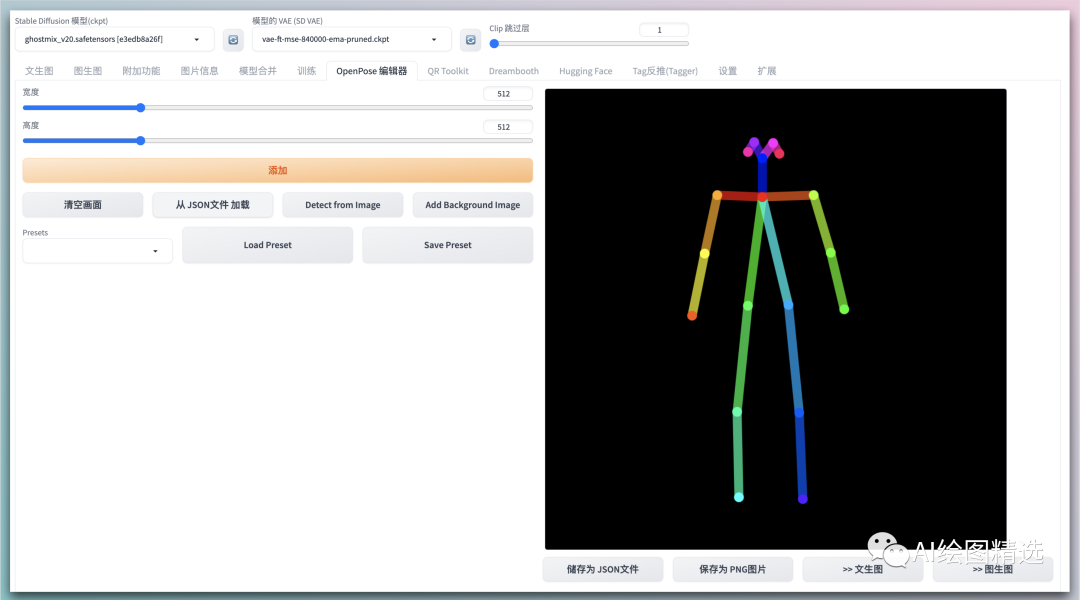

我们通过一个例子快速学习 OpenPoseEditor,先上模特图。 放入到编辑器中,OpenPoseEditor 可以自动提取骨骼图

放入到编辑器中,OpenPoseEditor 可以自动提取骨骼图

我们可以随意的调整下骨骼图,紧接着发送到 文生图

在文生图的 ControlNet 中可以看到 OpenPose 中有发送过来的特征图(切记不要选择预处理器)

随便写点提示词,见证奇迹的时候到了!

正向提示词:3man,(masterpiece:1,2),best quality,best detail,

male focus,suspenders,grey pants,3boys,play basketball,

先不看手部,对于整体姿势的控制还是很到位的。而手部的控制,同样可以配套的手部骨骼图,这块在后续再细聊!

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

需要的可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

1.stable diffusion安装包 (全套教程文末领取哈)

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

843

843

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?