1. 什么是集成学习?

组合多个弱学习器,形成一个强学习器。常见的集成学习思想:bagging,boosting,stacking

2. bagging方法

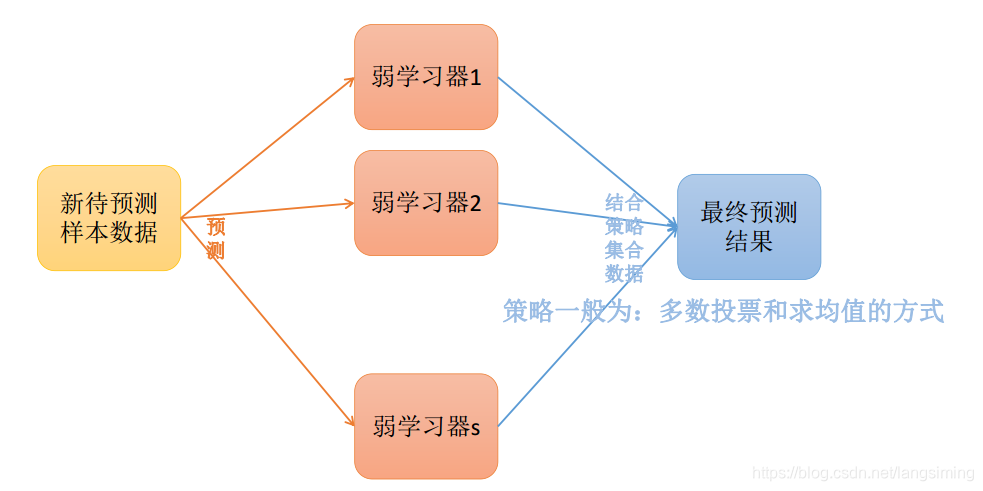

思想:采用又放回抽样的方式,从原始数据集抽出s个新的数据集来训练s个分类器。利用bagging训练出来的模型,在对新的数据集进行预测时,会采用多数投票的方式或者是求平均值的方式。

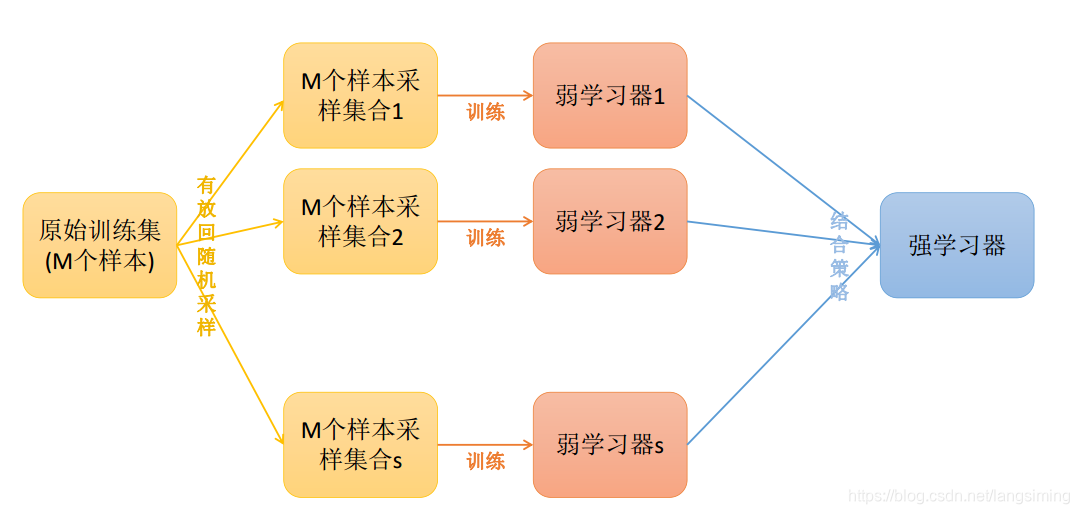

下图简单介绍了,bagging训练的过程:

下图简单介绍了,bagging预测的过程:

3. 随机森林

随机森林,是bagging算法中的一种,它有着如下的特性:

a.采用bootstrap的方式抽取n个样本

b.从所有属性中随机选择k个属性,采用最佳分割点的方式来创建决策树

c.重复上面的步骤创建m棵决策树

d.这m棵决策树形成随机森林,通过投票的方式来决定数据属于哪一类

常见的RF变种算法如下:Extra Tree,Totally Random Trees Embedding(TRTE),Isolation Forest(用于异常点检测)

4. extra tree

Extra Tree是RF的一个变种,原理基本和RF一样,区别如下:

1. RF会随机采样来作为子决策树的训练集,而Extra Tree每个子决策树采用原始数

据集训练;

2. RF在选择划分特征点的时候会和传统决策树一样,会基于信息增益、信息增益率、

基尼系数、均方差等原则来选择最优特征值;而Extra Tree会随机的选择一个特征值

来划分决策树。

Extra Tree因为是随机选择特征值的划分点,这样会导致决策树的规模一般大于

RF所生成的决策树。也就是说Extra Tree模型的方差相对于RF进一步减少。在某

些情况下,Extra Tree的泛化能力比RF的强

624

624

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?