1. 什么是信息熵?

描绘一组事件的发生的可能性之间的差异。如果一组事件发生的可能性相差不大,那么这组事件的信息熵会比较大。如果这组事件中每个事件发生的可能性差距很大,那么信息熵就会比较少。

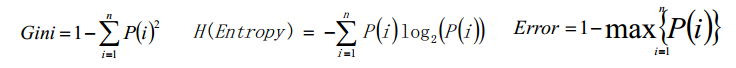

公式:

2. 什么是条件熵?

给定条件X的情况下,随机变量Y的信息熵就叫做条件熵。

3. 什么是决策树?

决策树(Decision Tree)是在已知各种情况发生概率的基础上,通过构建决策树来

进行分析的一种方式,是一种直观应用概率分析的一种图解法。

4. 决策树构建的过程

a. 可以将每一个特征属性看做是一个节点

b. 计算每一个节点的纯度,将纯度最高的那个特征属性作为当前节点

5. 决策树特征属性类型

根据特征属性的类型不同,在构建决策树的时候,采用不同的方式,具体如下:

属性是离散值,而且不要求生成的是二叉决策树,此时一个属性就是一个分支

属性是离散值,而且要求生成的是二叉决策树,此时使用属性划分的子集进行测试,按照

“属于此子集”和“不属于此子集”分成两个分支

属性是连续值,可以确定一个值作为分裂点split_point,按照>split_point和

<=split_point生成两个分支

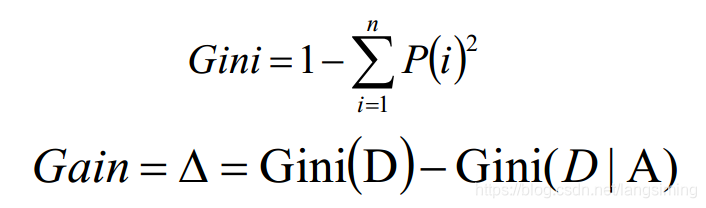

6. 决策树量化纯度

决策树的构建是基于样本概率和纯度进行构建操作的,那么进行判断数据集是否

“纯”可以通过三个公式进行判断,分别是Gini系数、熵(Entropy)、错误率,这

三个公式值越大,表示数据越“不纯”;越小表示越“纯”;实践证明这三种公

式效果差不多,一般情况使用熵公式

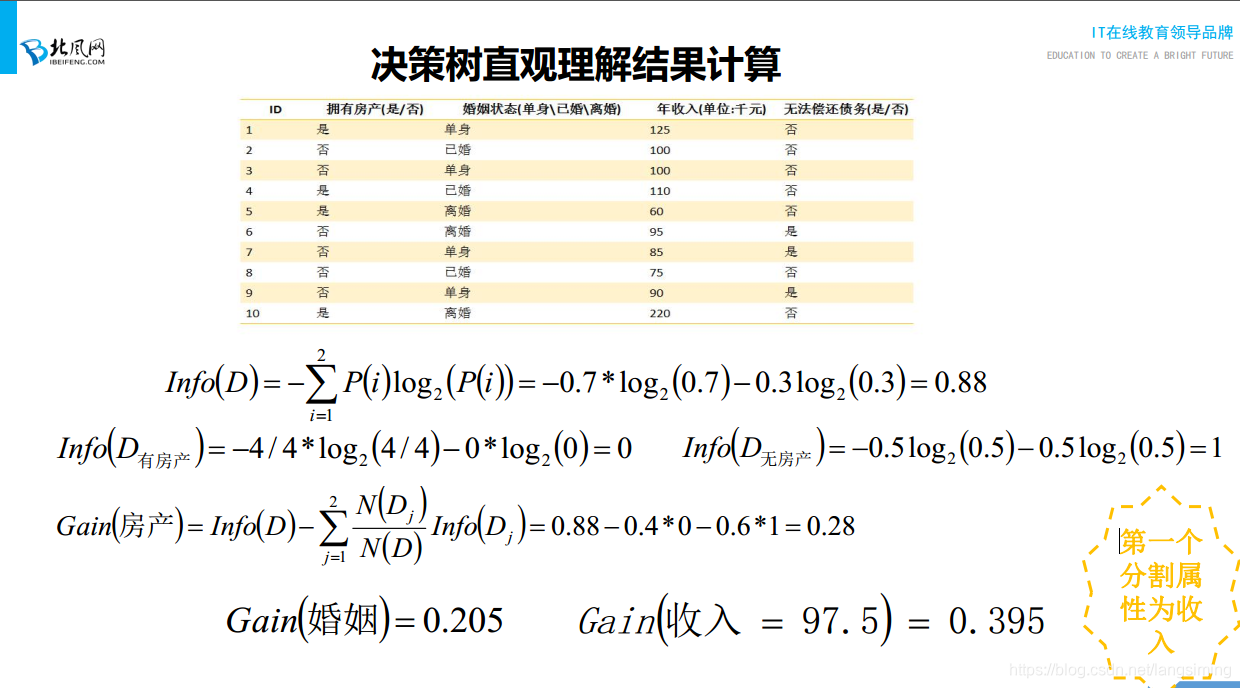

7. 举例

gain = 因变量的熵值-某个属性下的条件熵值

8. 决策树生成算法有哪些?

ID3, C4.5, CART

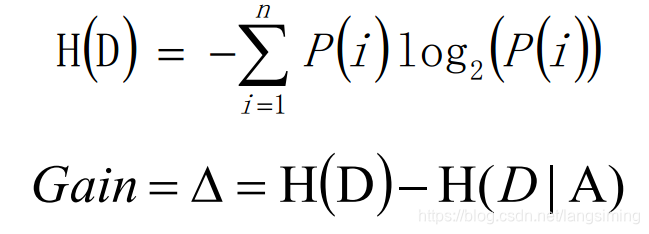

9. ID3算法的介绍和优缺点

ID3算法是决策树的一个经典的构造算法,内部使用信息熵以及信息增益来进行

构建;每次迭代选择信息增益最大的特征属性作为分割属性

优点:

决策树构建速度快;实现简单;

缺点:

计算依赖于特征数目较多的特征,而属性值最多的属性并不一定最优

ID3算法不是递增算法

ID3算法是单变量决策树,对于特征属性之间的关系不会考虑

抗噪性差

只适合小规模数据集,需要将数据放到内存中

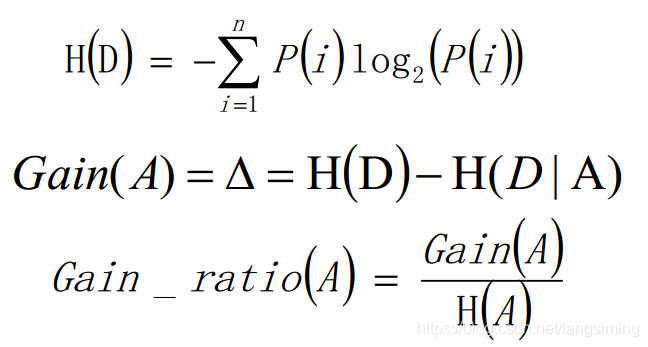

10. C4.5算法介绍和优缺点

在ID3算法的基础上,进行算法优化提出的一种算法(C4.5);现在C4.5已经是特

别经典的一种决策树构造算法;使用信息增益率来取代ID3算法中的信息增益,

在树的构造过程中会进行剪枝操作进行优化;能够自动完成对连续属性的离散化

处理;C4.5算法在选中分割属性的时候选择信息增益率最大的属性,涉及到的公

式为:

优点:

产生的规则易于理解

准确率较高

实现简单

缺点:

对数据集需要进行多次顺序扫描和排序,所以效率较低

只适合小规模数据集,需要将数据放到内存中

11. CART算法

使用基尼系数作为数据纯度的量化指标来构建的决策树算法就叫做

CART(Classification And Regression Tree,分类回归树)算法。CART算法使用

GINI增益作为分割属性选择的标准,选择GINI增益最大的作为当前数据集的分

割属性;可用于分类和回归两类问题。强调备注:CART构建是二叉树。

ID3、C4.5、CART分类树算法总结

ID3和C4.5算法均只适合在小规模数据集上使用

ID3和C4.5算法都是单变量决策树

当属性值取值比较多的时候,最好考虑C4.5算法,ID3得出的效果会比较差

决策树分类一般情况只适合小数据量的情况(数据可以放内存)

CART算法是三种算法中最常用的一种决策树构建算法。

三种算法的区别仅仅只是对于当前树的评价标准不同而已,ID3使用信息增益、

C4.5使用信息增益率、CART使用基尼系数。

CART算法构建的一定是二叉树,ID3和C4.5构建的不一定是二叉树。

12. 分类树和回归树的区别

分类树采用信息增益、信息增益率、基尼系数来评价树的效果,都是基于概率值

进行判断的;而分类树的叶子节点的预测值一般为叶子节点中概率最大的类别作

为当前叶子的预测值。

在回归树种,叶子节点的预测值一般为叶子节点中所有值的均值来作为当前叶子

节点的预测值。所以在回归树中一般采用MSE作为树的评价指标,即均方差。

一般情况下,只会使用CART算法构建回归树。

13. 决策树优化策略

剪枝优化

决策树过渡拟合一般情况是由于节点太多导致的,剪枝优化对决策树的正确率影响是比较

大的,也是最常用的一种优化方式。

Random Forest

利用训练数据随机产生多个决策树,形成一个森林。然后使用这个森林对数据进行预测,

选取最多结果作为预测结果。

14. 决策树的剪枝

决策树的剪枝是决策树算法中最基本、最有用的一种优化方案,主要分为两大类:

前置剪枝:在构建决策树的过程中,提前停止。结果是决策树一般比较小,实践证明这种

策略无法得到比较好的结果。

后置剪枝:在决策树构建好后,然后再开始裁剪,一般使用两种方式:1)用单一叶子节点

代替整个子树,叶节点的分类采用子树中最主要的分类;2)将一个子树完全替代另外一棵

子树;后置剪枝的主要问题是计算效率问题,存在一定的浪费情况。

后剪枝总体思路(交叉验证):

由完全树T0开始,剪枝部分节点得到T1,在此剪枝得到T2.....直到仅剩树根的树Tk

在验证数据集上对这k+1个树进行评价,选择最优树Ta(损失函数最小的树)

决策树剪枝过程

a. 对于给定的决策树T0

b. 计算所有内部非叶子节点的剪枝系数

c. 查找最小剪枝系数的节点,将其子节点进行删除操作,进行剪枝得到决策树Tk;如果存在

d. 多个最小剪枝系数节点,选择包含数据项最多的节点进行剪枝操作

c. 重复上述操作,直到产生的剪枝决策树Tk只有1个节点

d. 得到决策树T0T1T2....Tk

f. 使用验证样本集选择最优子树Ta

15. ID3、C4.5、CART分类树算法总结

| 算法 | 支持模型 | 树结构 | 特征选择 | 连续值处理 | 缺失值处理 | 剪枝 | 特征属性多 次使用 |

| ID3 | 分类 | 多叉树 | 信息增益 | 不支持 | 不支持 | 不支持 | 不支持 |

| C4.5 | 分类 | 多叉树 | 信息增益率 | 支持 | 支持 | 支持 | 不支持 |

| CART | 分类、 回 归 | 二叉树 | 基尼系数、 均方差 | 支持 | 支持 | 支持 | 支持 |

1917

1917

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?