一、mAP

1.1 mAP 是一个用来量度物体检测(如Faster R-CNN, SSD,Yolo等)精度时的一个重要性能度量标准。

mAP is the metric to measure the accuracy of object detectors like Faster R-CNN, SSD, etc. It is the average of the maximum precisions at different recall values.

若一个待检测的物体为狗,我们将被正确识别的狗,即检测为狗实际也为狗,称为True positives。将被正确识别的猫,即检测为猫实际也为猫,称为True negatives。被错误识别为狗的猫称为 False positives,被错误识别为猫的狗称为 False negatives。

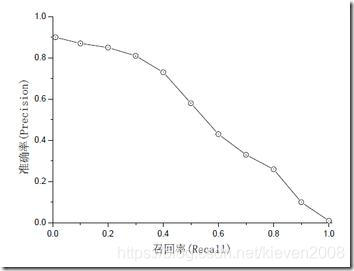

图3. 物体检测的P-R曲线图

AP代表曲线的面积,综合考量了不同召回率下的准确率,不会对P与R有任何偏好。每个类别的AP是相互独立的,将每个类别的AP进行平均,即可得到mAP。除了求面积的方式,还可以使用11个不同召回率对应的准确率求平均的方式求AP。

准确率和召回率是互相影响的,因为如果想要提高准确率就会把预测的置信率阈值调高,所有置信率较高的预测才会被显示出来,而那一些正确正预测(True Positive)可能因为置信率比较低而没有被显示了。一般情况下准确率高、召回率就低,召回率低、准确率高,如果两者都低,就是网络出问题了。一般情况,用不同的阀值,统计出一组不同阀值下的精确率和召回率。

1.2、影响 mAP 的因素

一般来说影响 mAP 的原因有很多,主要有以下几个:

- 不好的训练数据。

- 训练数据不够多。

- 标注的框不准确。

- 数据的多变性。

有的时候增加训练数据可能 mAP 并不会增加多少。当然了,使用表现更好的网络,其 mAP 自然地也会更加的高。

二、ROC, AUC

ROC的全名叫做Receiver Operating Characteristic,ROC关注两个指标:

True Positive Rate ( TPR ) = TP / [ TP + FN] ,TPR代表能将正例分对的概率(召回率)

False Positive Rate( FPR ) = FP / [ FP + TN] ,FPR代表将负例错分为正例的概率

图4. ROC曲线

用ROC curve来表示分类器的performance很直观好用。可是,人们总是希望能有一个数值来标志分类器的好坏。

于是Area Under roc Curve(AUC)就出现了。顾名思义,AUC的值就是处于ROC curve下方的那部分面积的大小。通常,AUC的值介于0.5到1.0之间,较大的AUC代表了较好的Performance。

676

676

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?