分享一下我老师大神的人工智能教程!零基础,通俗易懂!http://blog.youkuaiyun.com/jiangjunshow

也欢迎大家转载本篇文章。分享知识,造福人民,实现我们中华民族伟大复兴!

———-

1. Task complexity

task complexity包括step complexity(可以并行成几个操作) & work complexity(总共有多少个工作要做)。

e.g. 下面的tree-structure图中每个节点表示一个操作数,每条边表示一个操作,同层edge表示相同操作,问该图表示的task的step complexity & work complexity分别是多少。

Ans:

step complexity: 3;

work complexity: 6。

下面会有更具体的例子。

2. Reduce

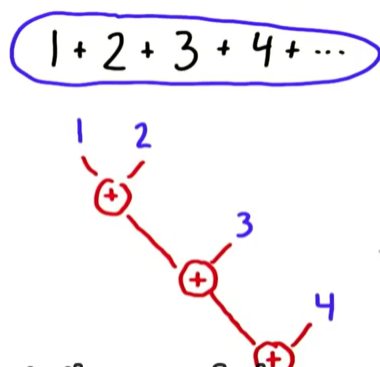

引入:我们考虑一个task:1+2+3+4+…

1) 最简单的顺序执行顺序组织为((1+2)+3)+4…

2) 由于operation之间没有依赖关系,我们可以用Reduce简化操作,它可以减少serial implementation的步数。

2.1 what is reduce?

Reduce input:

- set of elements

- reduction operation

- binary: 两个输入一个输出

- 操作满足结合律: (a@b)@c = a@(b@c), 其中@表示operator

e.g +, 按位与 都符合;a^b(expotentiation)和减法都不是

2.1.1 Serial implementation of Reduce:

reduce的每一步操作都依赖于其前一个操作的结果。比如对于前面那个例子,n个数相加,work complexity 和 step complexity都是O(n)(原因不言自明吧~)我们的目标就是并行化操作,降下来step complexity. e.g add serial reduce -> parallel reduce。

本文详细介绍了CUDA中的Reduce、Histogram的基础算法,包括串行与并行实现,探讨了不同实现方法的工作复杂度和适用场景。通过对Reduce的step complexity和work complexity分析,展示了如何通过并行化降低复杂度。Histogram的并行实现中,讨论了使用原子操作、局部内存加Reduce以及排序后再Reduce的方法。最后,文章总结了GPU基础算法的重要性和实际应用。

本文详细介绍了CUDA中的Reduce、Histogram的基础算法,包括串行与并行实现,探讨了不同实现方法的工作复杂度和适用场景。通过对Reduce的step complexity和work complexity分析,展示了如何通过并行化降低复杂度。Histogram的并行实现中,讨论了使用原子操作、局部内存加Reduce以及排序后再Reduce的方法。最后,文章总结了GPU基础算法的重要性和实际应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?