作者 | Hedy 来源 | AI产品进化录 管理洞察AI+

咨询合作| 13699120588

文章仅代表作者本人观点

AI Agent开发的四大核心支柱:

从提示词到多Agent协作的系统化路径

大家好,我是AI产品经理Hedy!

过去一年,AI Agent从一个技术概念,迅速演变为产品落地的核心载体。

但现实是:

-

有人用简单Prompt就做出了高效Agent;

-

有人堆了几十个工具,却连基本任务都跑不通;

-

有人高喊多Agent协作,结果系统混乱、互相干扰。

为什么差距这么大?

因为AI Agent不是调个模型再接个工具就能跑起来的玩具,

而是一个需要系统工程思维的复杂智能体。

经过对数十个成功/失败案例的分析,我们提炼出AI Agent开发的四大核心支柱:

-

结构化提示词工程(链式设计与路由)

-

上下文工程(RAG与智能窗口管理)

-

工具系统设计(语义化工具与MCP协议)

-

多Agent协作(规划与自我完善)

这四大支柱,构成了从单点智能到系统智能的完整进阶路径。

无论你是刚入门的开发者,还是正在规划Agent产品的PM,都应该掌握。

第一支柱:结构化提示词工程

从单Prompt到可编排的推理链

真正的Agent需要的是可组合、可路由、可调试的提示结构。

✅ 核心理念:链式设计(Chaining)

-

将复杂任务拆解为多个子步骤

-

每个步骤由独立的Prompt模块处理

-

输出作为下一环节的输入

📌 示例:用户说:帮我分析这份财务报表

→ 拆解为:

-

提取关键指标(Prompt A)

-

对比行业均值(Prompt B)

-

生成风险提示(Prompt C)

✅ 进阶能力:动态路由(Routing)

-

根据用户意图或上下文,自动选择不同Prompt链

-

例如:

-

-

写报告 → 调用写作链

-

查数据 → 调用分析链

-

💡 产品价值:

提示词不再是一次性的,而是可维护、可迭代的产品模块。

第二支柱:上下文工程

让Agent记得住事

Agent最大的痛点是什么?

上下文爆炸 or 上下文丢失。

-

输入太长 → 模型截断,关键信息丢失

-

输入太短 → 忘记用户之前说了什么

解决方案不是堆叠更多Prompt,而是智能上下文管理。

✅ RAG:引入外部知识,但不止于此

-

传统RAG:检索+拼接 → 容易冗余、噪声大

-

智能RAG:

-

-

按任务相关性筛选片段

-

动态压缩上下文(如LLMLingua)

-

结合Merkle树跟踪代码变更(如Cursor)

-

✅ 智能窗口管理:动态裁剪上下文

-

保留:任务目标、关键决策、用户偏好

-

丢弃:已执行动作、无关对话、重复信息

-

工具:Sliding Window + 重要性评分机制

📌 关键洞察:

上下文需要恰到好处。

第三支柱:工具系统设计

从能调用到会调用

很多Agent失败,不是因为模型弱,

而是工具系统设计粗糙。

✅ 语义化工具描述(Tool Semantics)

-

工具不能只叫search或run_code

-

要提供清晰的语义描述,让模型理解何时用、怎么用

{

"name": "query_user_preferences",

"description": "获取用户的历史偏好,如预算范围、常用品牌、沟通风格",

"parameters": {"user_id": "str"}

}

✅ MCP协议:让工具调用可追溯、可协作

-

MCP(Model Context Protocol)记录每次工具调用的:

-

-

输入参数

-

执行结果

-

对任务状态的影响

-

-

支持任务中断后恢复、错误回滚、多Agent协同

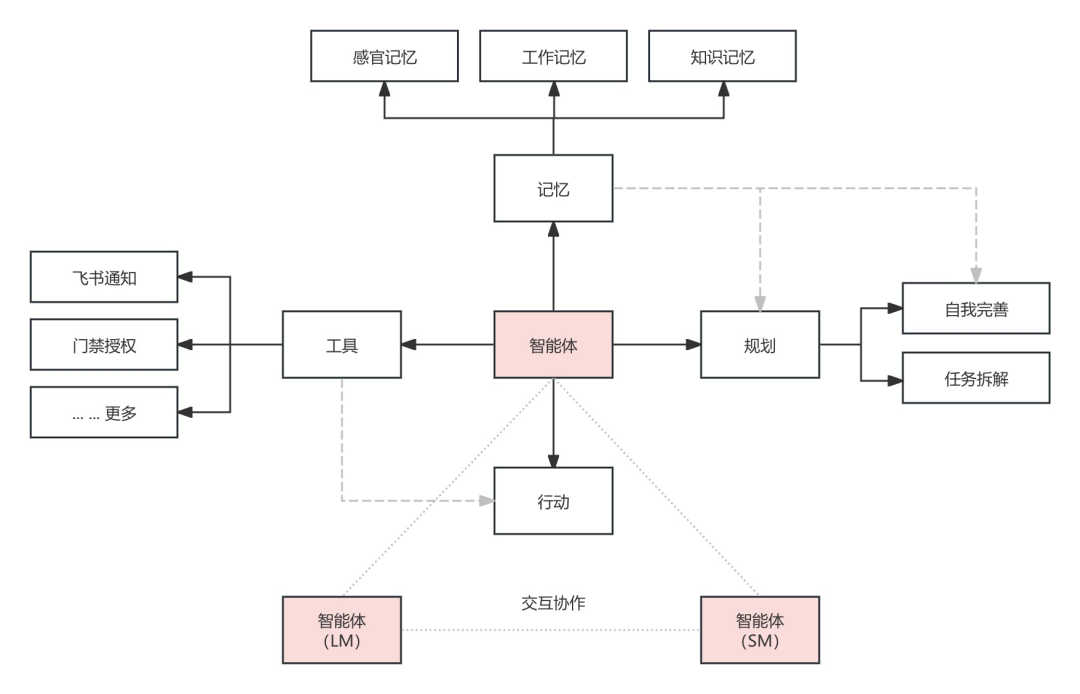

第四支柱:多Agent协作

从单打独斗到团队作战

当任务复杂度超过单个Agent能力时,

就需要引入多Agent架构。

但多Agent不等于多个模型同时跑。

✅ 核心设计原则:

-

角色分工

-

-

Planner(规划者):拆解任务、分配子目标

-

Executor(执行者):调用工具、完成具体操作

-

Critic(评估者):验证结果、触发修正

-

-

通信机制

-

-

通过共享上下文传递状态

-

避免各自为战或循环调用

-

-

自我完善闭环

-

-

Critic发现错误 → 触发Planner重新规划

-

形成执行-评估-修正循环

-

📌 真实案例:

某金融Agent系统中,

-

Researcher Agent 负责收集数据

-

Analyst Agent 负责生成报告

-

Compliance Agent 负责检查合规风险

三者通过MCP共享上下文,任务完成率提升40%。

四大支柱的进阶路径:你是哪个阶段?

|

阶段 |

特征 |

建议重点 |

|---|---|---|

|

入门期 |

能跑通单任务Agent |

掌握结构化提示词 + 基础RAG |

|

成长期 |

支持多工具、多轮对话 |

优化上下文管理 + 语义化工具设计 |

|

成熟期 |

复杂任务、高可靠性 |

引入MCP协议 + 错误恢复机制 |

|

领先期 |

多Agent协作、自主进化 |

构建规划-执行-评估闭环 |

📌 注意:

不要跳过基础,直接追求多Agent。

没有扎实的上下文和工具系统,多Agent只会更混乱。

写在最后:Agent的本质是系统,不是模型

很多人把AI Agent等同于更强的LLM,

但真正的差距,不在模型,而在系统设计。

-

提示词决定“怎么想”

-

上下文决定“记得什么”

-

工具决定“能做什么”

-

协作决定“能走多远”

这四大支柱,构成了AI Agent的操作系统级能力。

作为AI产品经理或开发者,

你的目标不是调出一个能聊天的模型,

而是构建一个可持续演进的智能系统。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

AI Agent成功的四大支柱

AI Agent成功的四大支柱

99

99

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?