今天给大家分享一个在面试中经常遇到的问题:Kafka 消息丢失该如何处理?

这个问题啊,看似简单,其实里面藏着很多“套路”。

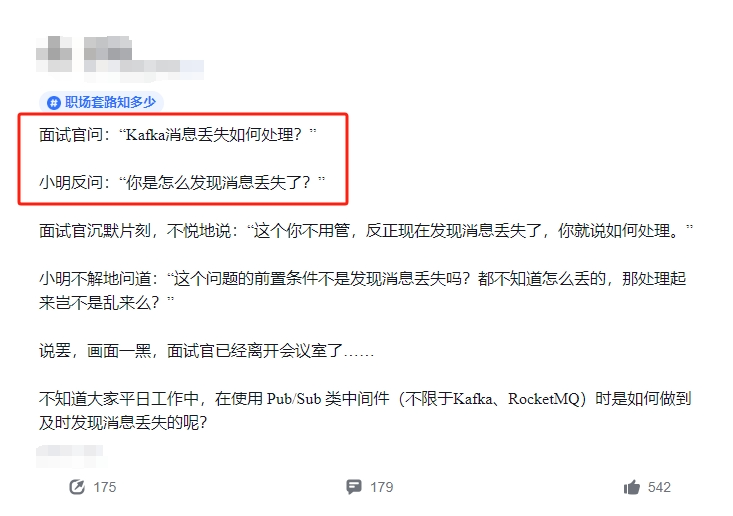

来,咱们先讲一个面试的“真实”案例。

面试官问:“Kafka 消息丢失如何处理?”

小明一听,反问:“你是怎么发现消息丢失了?”

面试官顿时一愣,沉默了片刻后,可能有点不耐烦,说道:“这个你不用管,反正现在发现消息丢失了,你就说如何处理。”

小明一头雾水:“问题是都不知道怎么丢的,处理起来岂不是瞎搞吗?”

画面一黑,面试官离开了会议室,留小明一个人凌乱在风中……

👀 这段子虽然搞笑,但实际工作中,确实“消息丢失”这个事儿有点让人摸不着头脑。

大家有没有想过:消息丢失的定义到底是什么?其实,发现消息丢失的过程,才是处理问题的关键!

在用 Pub/Sub 类中间件,比如 Kafka 或 RocketMQ 时,消息丢失可能有很多原因,包括生产者、消费者和网络传输等各个环节。

我们今天就结合实际工作中遇到的情况,聊聊到底怎么发现消息丢失,又该怎么处理。😎

首先,我们要搞清楚消息丢失的几种典型场景:

1.生产者消息发送失败:这个比较简单,如果生产者发消息时,网络抖动、服务宕机或 Kafka broker 挂了,那消息就丢了。

这时候生产者通常会重试,但是如果重试策略不当,还是可能丢消息。

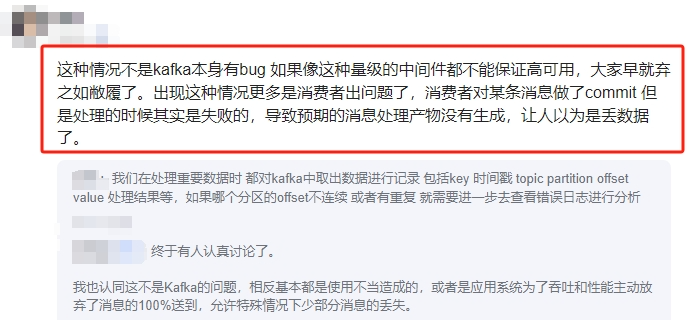

2.消费者消费消息失败:最常见的是消费者拉取了消息,但是业务处理失败,或者消费后没有提交 offset,导致消息“看似”消费了,实际根本没处理。

这种情况不算真正的消息丢失,但你业务数据不一致,这锅还是要 Kafka 来背。😂

3. 网络异常导致消息丢失:有时候消息发送成功了,但是因为网络问题,导致消费者没能拉到这些消息,这类情况更难排查。

OK,分析了几种可能性,接下来看看有哪些方法可以帮助我们及时发现这些问题。

1.监控和告警系统

监控是最基础的保障手段。一般来说,Kafka 提供了很多指标可以监控,比如生产端和消费端的吞吐量、消息积压(lag)情况、消费者组的 offset 等等。

通过这些监控指标,一旦消费端的消息积压开始异常增长,或者 offset 停滞不前,就说明很可能有消息丢失了。

很多公司会用 Prometheus + Grafana 来做监控和可视化,再配合告警系统(如 Alertmanager)实时提醒。

比如可以监控 `kafka_consumer_lag` 这个指标,一旦消息积压超过预设阈值,就触发告警。

# Prometheus 配置监控 Kafka 消费者积压

kafka_consumer_lag{consumer_group="your-consumer-group", topic="your-topic"} > 100

在工作中,这类告警往往是消息丢失的第一个信号,反应速度极快。

2.消息追踪机制

消息追踪就像在每个消息上打个“追踪码”,确保每条消息都能被追踪到。

具体做法是:生产者在发送每条消息时,生成一个唯一的 `message_id`,消费者在消费时同样记录消费的 `message_id`。

通过对比生产端和消费端的 ID,就可以发现有没有消息“掉队”了。

在实际应用中,通常会通过日志来记录这些 `message_id`,并定期检查对账,保证所有消息都正确处理了。

// 生产者发送消息时生成 message_id

String messageId = UUID.randomUUID().toString();

ProducerRecord<String, String> record = new ProducerRecord<>("your-topic", messageId, messageContent);

producer.send(record);

// 消费者消费消息时记录 message_id

public void consumeMessage(ConsumerRecord<String, String> record) {

String messageId = record.key(); // 获取 message_id

// 将 message_id 存储到日志或数据库中,用于后续追踪

log.info("Consumed message with ID: {}", messageId);

}

3.消息确认机制

Kafka 本身有个很经典的机制,就是手动提交offset。消费者在处理完消息后,才提交消费位置的 offset。

如果消费失败了,不提交 offset,Kafka 就会重新分配这条消息,避免消息丢失。

很多时候,消息丢失的“锅”其实是消费者自己在消费时出了问题,明明没处理完却偷偷提交了 offset,让 Kafka 以为消息已经处理完毕了。

手动提交 offset 就能很好地避免这种情况。

public void consumeMessages() {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

try {

// 处理消息逻辑

processMessage(record);

// 成功处理后提交 offset

consumer.commitSync();

} catch (Exception e) {

// 处理失败不提交 offset,Kafka 会重试

log.error("Failed to process message, will retry.", e);

}

}

}

4.消息重试和补偿机制

为了解决偶发性的消费失败,很多公司会为 Kafka 消费端加一个重试机制。

当消息处理失败时,重新将消息放回队列,或者放到一个死信队列(Dead Letter Queue, DLQ)里,然后专门处理这些异常消息。

// 如果消息处理失败,将其放回死信队列

try {

processMessage(record);

} catch (Exception e) {

producer.send(new ProducerRecord<>("dlq-topic", record.key(), record.value()));

}

这个方式虽然不能彻底避免消息丢失,但能保证消息不会轻易丢失,特别是一些重要业务场景中,消息的可靠性至关重要。

5.多副本存储

Kafka 还有一个核心功能,就是多副本机制,即消息在多个 broker 上都有副本。这样即使某个 broker 挂了,其他副本也能提供消息。

通过设置 `replication.factor` 参数,我们可以指定 Kafka 每条消息的副本数,确保即使一台机器挂了,消息也不会丢失。

# Kafka Topic 多副本配置

replication.factor=3

最后,真正发现消息丢失了,怎么办呢?这里有一些基本的补救措施:

1.检查消费端日志:首先要确定消息到底有没有消费。如果消费端日志显示消费失败,重新处理即可。

2.重发消息:如果消费端确实没处理成功,可以将消息重新发送到 Kafka,或者从备份中恢复并重放消息。

3.处理丢失后的补偿:业务上可能会涉及补偿措施,比如通知相关人员手动处理,或者对丢失的数据进行回补。

总之,消息丢失不算是特别常见的问题,但一旦遇到,还是需要冷静排查问题源头。

Kafka 等 Pub/Sub 中间件本身已经有比较强大的机制来应对这些场景,只要结合业务需求,做好监控和容错机制,基本都能把问题压到最小。

6760

6760

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?