一、本文介绍

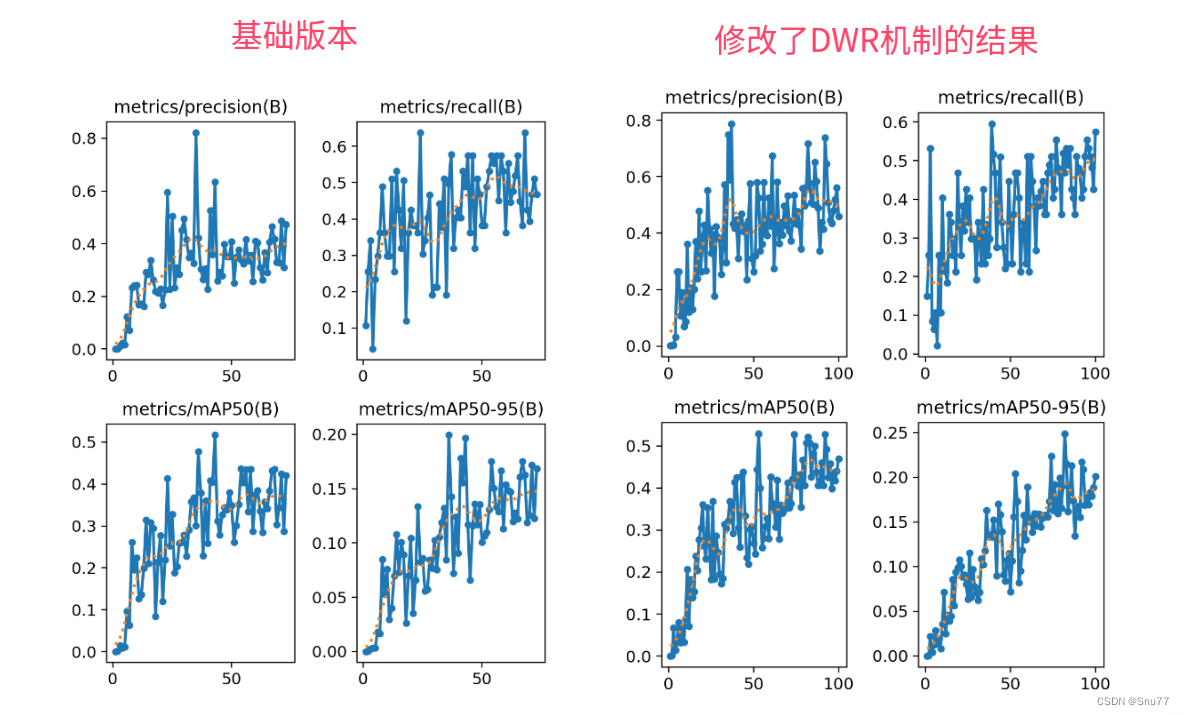

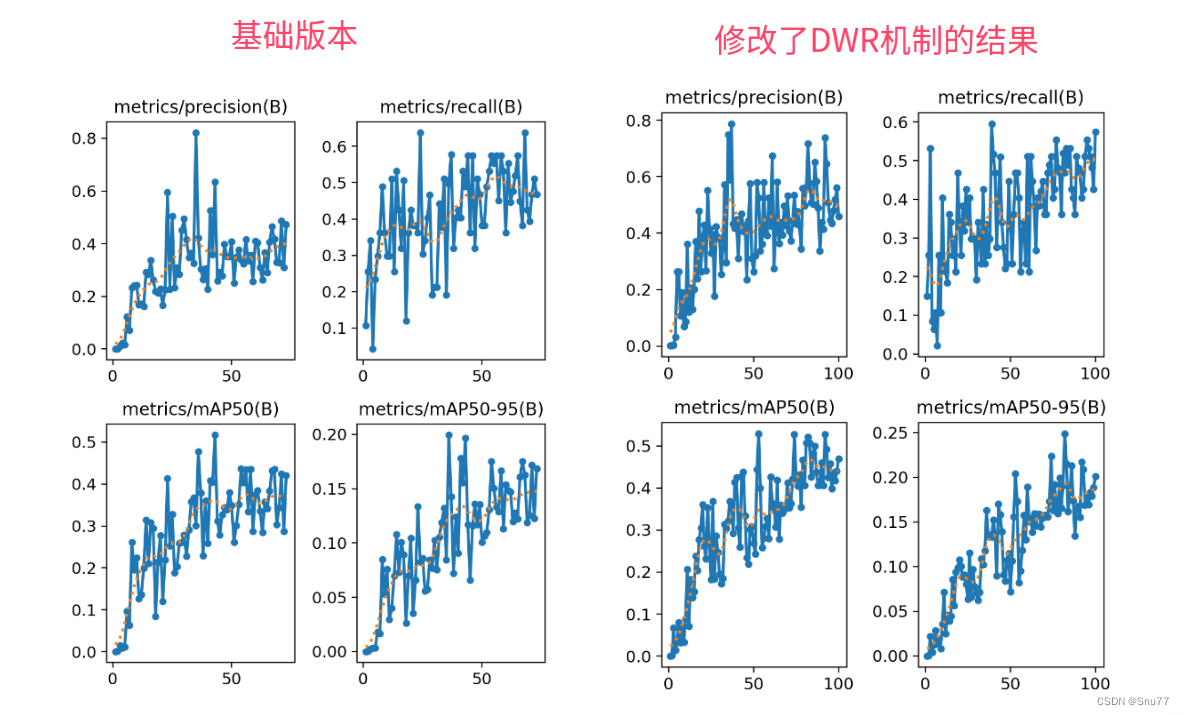

本文内容给大家带来的DWRSeg中的DWR模块来改进YOLOv11中的C2f和Bottleneck模块,主要针对的是小目标检测,主要创新点可以总结如下:多尺度特征提取机制的深入研究和创新的DWR模块和SIR模块的提出,这种方法使得网络能够更灵活地适应不同尺度的特征,从而更准确地识别和分割图像中的物体。 通过本文你能够了解到:DWRSeg的基本原理和框架,并且能够在你自己的网络结构中进行添加0。

目录

本文内容给大家带来的DWRSeg中的DWR模块来改进YOLOv11中的C2f和Bottleneck模块,主要针对的是小目标检测,主要创新点可以总结如下:多尺度特征提取机制的深入研究和创新的DWR模块和SIR模块的提出,这种方法使得网络能够更灵活地适应不同尺度的特征,从而更准确地识别和分割图像中的物体。 通过本文你能够了解到:DWRSeg的基本原理和框架,并且能够在你自己的网络结构中进行添加0。

目录

1544

1544

1870

1870

376

376

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?