在YOLOv10中引入MLCA(混合局部通道注意力)机制可以进一步提升模型的特征提取能力和检测性能,同时保持其轻量化特性。以下是实现MLCA注意力机制改进的具体方法:

### 1. MLCA模块的基本结构

MLCA机制的核心思想是结合局部空间信息和通道注意力机制,以增强对重要特征的关注能力。该模块通常由两个部分组成:

- **局部空间注意力**:通过卷积操作捕捉局部区域的空间相关性。

- **通道注意力**:使用全局平均池化(GAP)和全连接层来计算每个通道的重要性权重。

```python

import torch

import torch.nn as nn

class MLCA(nn.Module):

def __init__(self, channel, reduction=16):

super(MLCA, self).__init__()

self.local_conv = nn.Conv2d(channel, channel, kernel_size=3, padding=1, groups=channel)

self.global_avg_pool = nn.AdaptiveAvgPool2d(1)

self.fc = nn.Sequential(

nn.Linear(channel, channel // reduction, bias=False),

nn.ReLU(inplace=True),

nn.Linear(channel // reduction, channel, bias=False),

nn.Sigmoid()

)

def forward(self, x):

b, c, _, _ = x.size()

local_feat = self.local_conv(x)

global_feat = self.global_avg_pool(local_feat).view(b, c)

attention_weights = self.fc(global_feat).view(b, c, 1, 1)

return x * attention_weights.expand_as(x)

```

### 2. 将MLCA嵌入到YOLOv10中

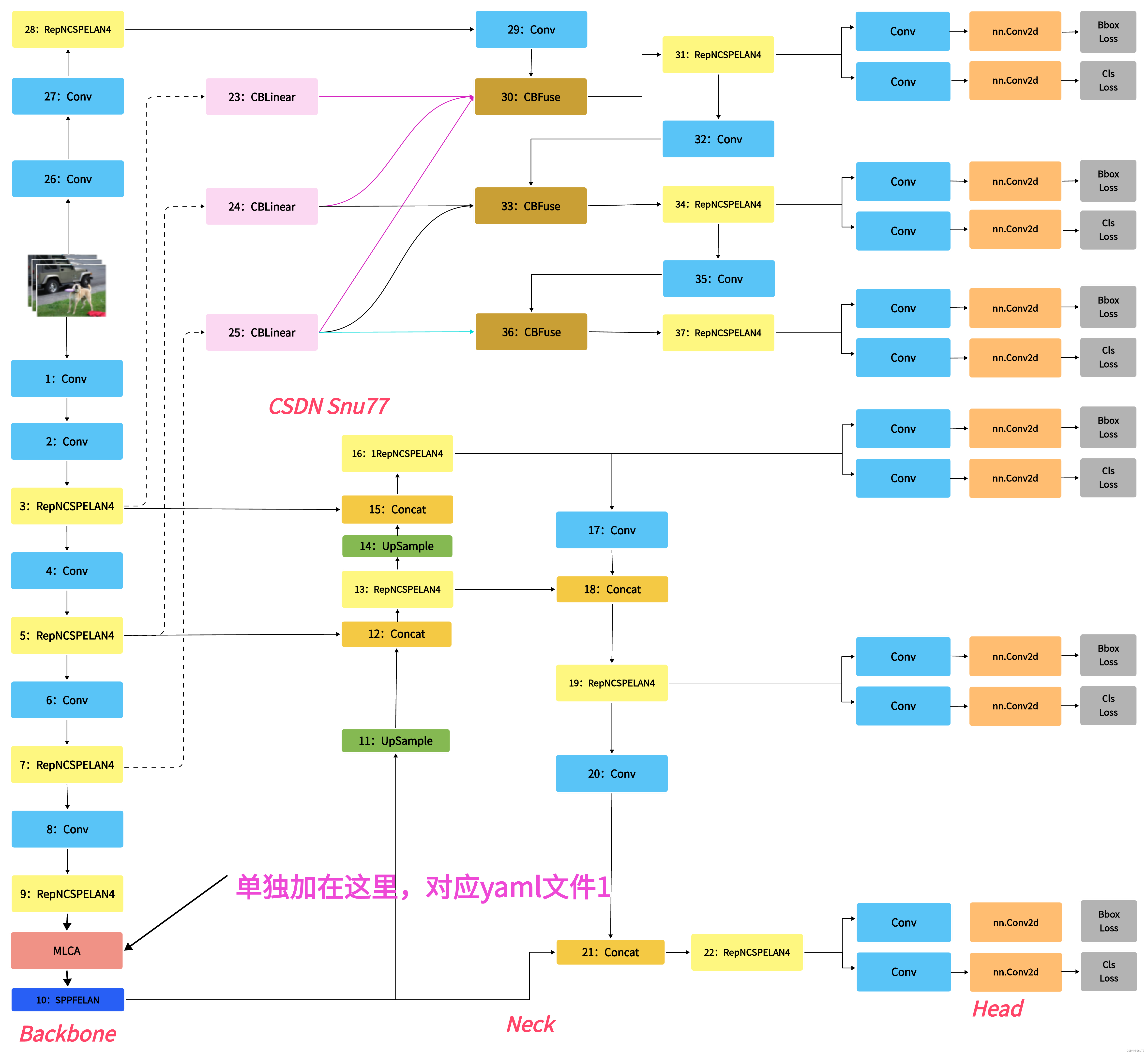

为了将MLCA模块集成到YOLOv10中,可以选择在网络的关键特征提取层后插入该模块。例如,在CSPDarknet主干网络或PANet特征金字塔中的某些位置加入MLCA模块,以增强特征表示。

#### 示例:在CSPBlock中添加MLCA

YOLOv10的基础模块通常是基于CSP(Cross Stage Partial)结构的,可以在CSPBlock中添加MLCA模块,如下所示:

```python

class CSPBlockWithMLCA(nn.Module):

def __init__(self, in_channels, out_channels, n=1, shortcut=True, expansion=0.5):

super(CSPBlockWithMLCA, self).__init__()

hidden_channels = int(out_channels * expansion)

self.conv1 = nn.Conv2d(in_channels, hidden_channels, kernel_size=1, stride=1, bias=False)

self.conv2 = nn.Conv2d(in_channels, hidden_channels, kernel_size=1, stride=1, bias=False)

self.bottlenecks = nn.Sequential(*[Bottleneck(hidden_channels, hidden_channels, shortcut) for _ in range(n)])

self.conv3 = nn.Conv2d(hidden_channels * 2, out_channels, kernel_size=1, stride=1, bias=False)

self.mlca = MLCA(out_channels)

def forward(self, x):

y1 = self.conv1(x)

y2 = self.bottlenecks(self.conv2(x))

out = torch.cat((y1, y2), dim=1)

out = self.conv3(out)

out = self.mlca(out)

return out

```

### 3. 修改YOLOv10配置文件

YOLO系列模型通常依赖于配置文件(如`yaml`文件)来定义网络结构。为了在YOLOv10中使用MLCA模块,需要修改相应的配置文件,指定在哪些层中使用MLCA。

例如,在YOLOv10的骨干网络或颈部网络部分添加MLCA模块:

```yaml

# Example modification in YOLOv10 config file

backbone:

# [from, number, module, args]

[[-1, 1, 'Focus', [3, 32, 3]],

[-1, 1, 'Conv', [32, 64, 3, 2]],

[-1, 3, 'CSPBlockWithMLCA', [64, 64]],

[-1, 1, 'Conv', [64, 128, 3, 2]],

[-1, 3, 'CSPBlockWithMLCA', [128, 128]],

...

]

neck:

[[-1, 1, 'PANet', []]]

```

### 4. 训练与评估

完成上述修改后,重新训练YOLOv10模型,并评估其在目标检测任务上的表现。可以通过比较mAP、FPS等指标来验证MLCA模块的有效性。根据实验结果,适当调整MLCA模块的位置和参数,以获得最佳性能。

---

本文介绍了如何在YOLOv9中应用MLCA(Mixed Local Channel Attention)以提高目标检测的精度。MLCA是一种轻量级的注意力机制,结合局部和全局特征以及通道和空间特征信息。文章详细阐述了MLCA的基本框架原理,并提供了添加MLCA的具体步骤,包括代码修改和yaml配置文件示例。通过实验,作者发现MLCA在增加少量参数的情况下能显著提升检测性能。

本文介绍了如何在YOLOv9中应用MLCA(Mixed Local Channel Attention)以提高目标检测的精度。MLCA是一种轻量级的注意力机制,结合局部和全局特征以及通道和空间特征信息。文章详细阐述了MLCA的基本框架原理,并提供了添加MLCA的具体步骤,包括代码修改和yaml配置文件示例。通过实验,作者发现MLCA在增加少量参数的情况下能显著提升检测性能。

订阅专栏 解锁全文

订阅专栏 解锁全文

9025

9025