论文题目:Fully Convolutional One-Stage Object Detection

论文链接:https://openaccess.thecvf.com/content_ICCV_2019/papers/Tian_FCOS_Fully_Convolutional_One-Stage_Object_Detection_ICCV_2019_paper.pdf

最近看了两篇anchor-free的detection论文,分别是CenterNet和这篇FCOS,其共性都使得网络免去对anchor的依赖,变得简单高效又不失精度。

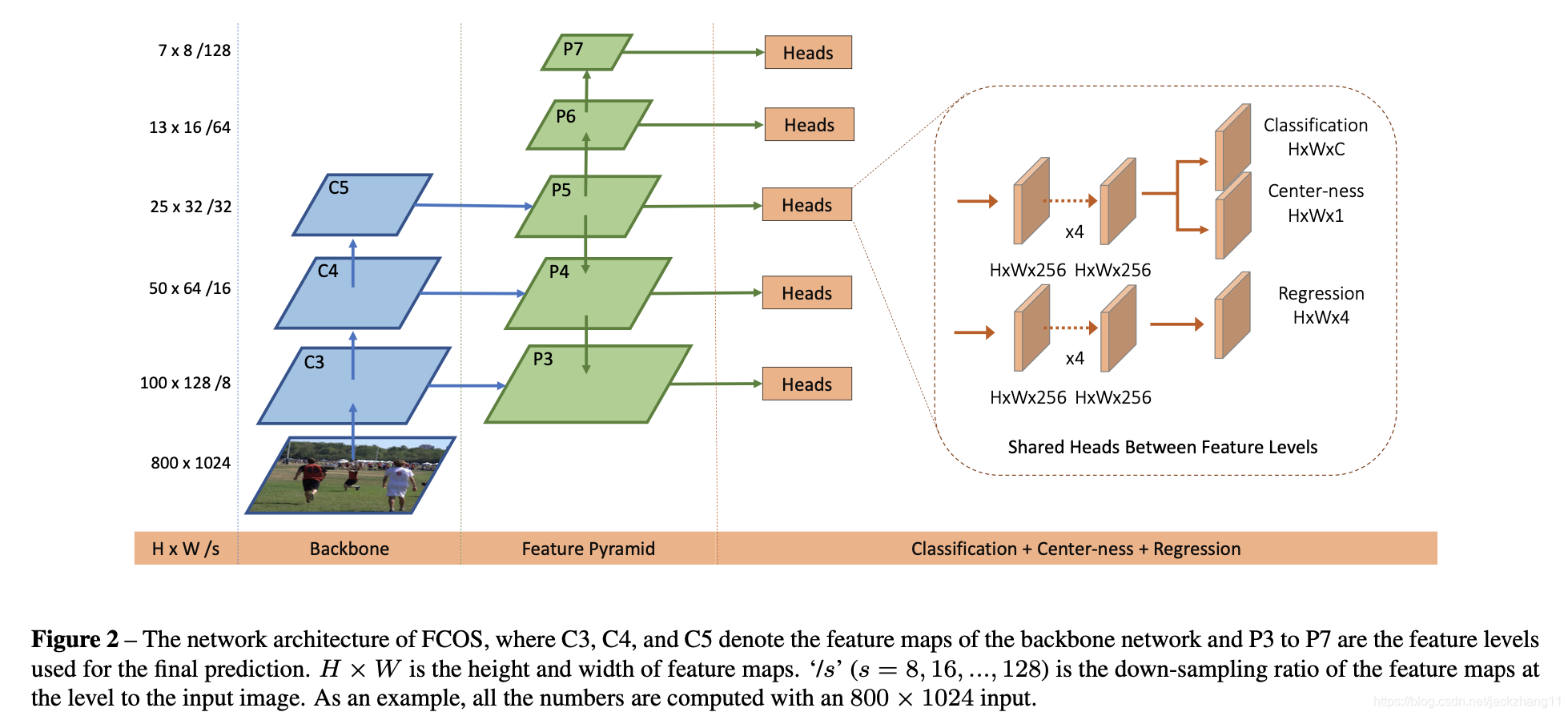

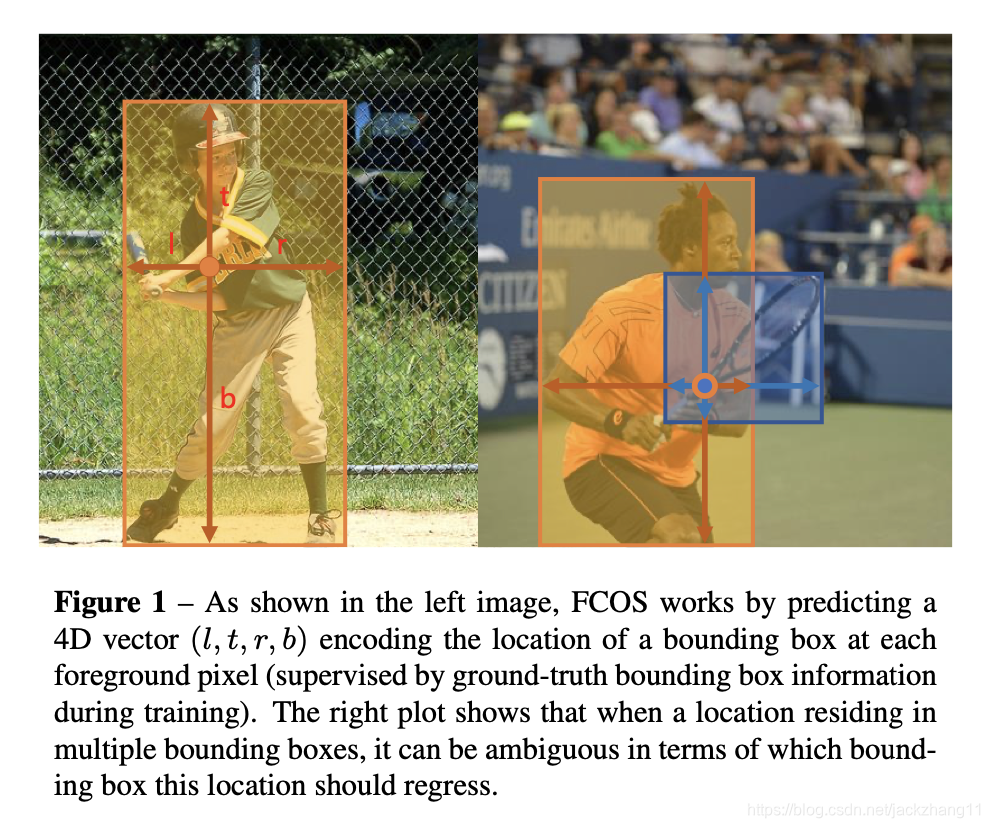

对于FCOS的backbone部分,采用了基于FPN的Resnet,输出为P3-P7这五个不同尺度的特征图,用于后续的预测。这里先拿某一个尺度的特征图为例。如果还原到原始image上的位置在GT的box内,则该点称为正样本,否则称为负样本。特征图后续接入预测head,该head主要负责预测两个部分,即对于feature map的每个点来说,输出预测instance位置大小的4d向量 t = ( l , t , r , b ) \bold t=(l,t,r,b) t=(l,t,r,b);以及类别置信向量 p \bold p p,对于coco数据集来说该向量维度是80。 t = ( l , t , r , b ) \bold t=(l,t,r,b) t=(l,t,r,b)每个维度的意义如下图Fig.1所示(代表中心点距离bbox左、上、右、下的距离,文中利用exp(x)将他们都映射到[0,∞) ):

因此再回过来看Fig.2,输出的4d位置向量 t x , y \bold t_{x,y} tx,y,倘若该位置属于正样本,那么他在「(x,y)到bounding box四条边的距离 t ∗ = ( l ∗ , t ∗ , r ∗ , b ∗ ) \bold t^{*}=(l^{*},t^{*},r^{*},b^{*}) t∗=(l

介绍FCOS,一种基于FPN的ResNet的全卷积、无锚框目标检测算法,通过预测实例位置及类别置信度,采用centerness概念提升检测效果。

介绍FCOS,一种基于FPN的ResNet的全卷积、无锚框目标检测算法,通过预测实例位置及类别置信度,采用centerness概念提升检测效果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

580

580

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?