激活函数

在之前的logistic和神经网络中,激活函数是sigmoid, 损失函数是平方函数。但是这并不是固定的。

激活函数的主要作用是提供网络的非线性建模能力。 只有加入了激活函数之后,深度神经网络才具备了分层的非线性映射学习能力。

常见的激活函数多是分段线性和具有指数形状的非线性函数。

损失函数

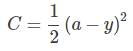

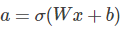

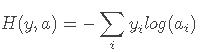

其中y是我们期望的输出,a为神经元的实际输出

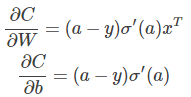

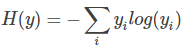

因为sigmoid函数的性质,导致σ′(z)在z取大部分值时会造成饱和现象,从而使得参数的更新速度非常慢,甚至会造成离期望值越远,更新越慢的现象。那么怎么克服这个问题呢?我们想到了交叉熵函数。我们知道,熵的计算公式是

而在实际操作中,我们并不知道y的分布,只能对y的分布做一个估计,也就是算得的a值, 这样我们就能够得到用a来表示y的交叉熵

1546

1546

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?