在当今技术飞速发展的时代,AI(人工智能)编程和开源编程实践已经成为科技界重要的主题。随着各种工具和框架的涌现,开发者们面临着前所未有的机遇与挑战。在这篇文章中,我们将深入探讨以下几个方面:最新的技术趋势、AI技术在实际项目中的应用、以及个人在开源社区中的经验与见解,旨在激发更多人在编程与AI领域的创作潜能。

如果您喜欢此文章,请收藏、点赞、评论,谢谢,祝您快乐每一天。

一、深入剖析最新的技术趋势

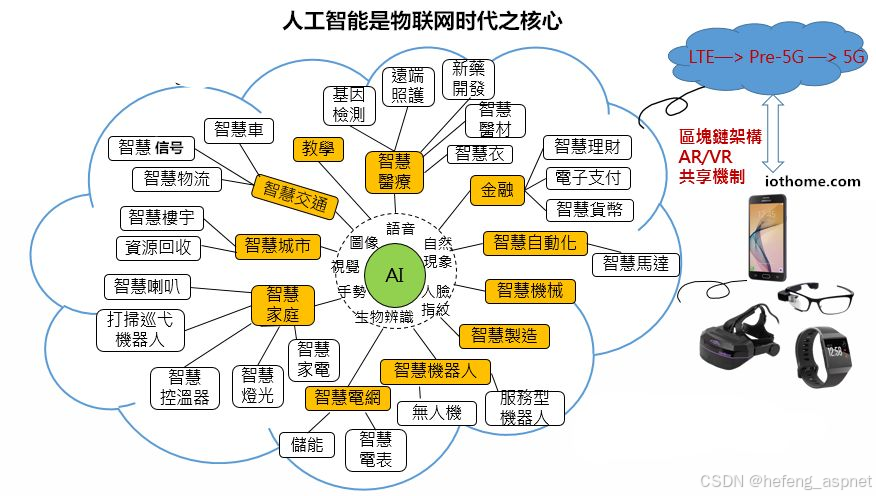

近年来,深度学习和机器学习技术已经成为AI领域的核心。尤其是生成式对抗网络(GANs)、变换器模型(Transformers)等算法的广泛应用,使得图像生成、自然语言处理等领域取得了显著的突破。例如,OpenAI的GPT-3模型推出后,引发了对自然语言生成的广泛关注,其在文本写作、对话系统中的表现令人惊艳。这些技术的不断演进,促使了更多行业对AI解决方案的探索,从医疗诊断到金融分析,AI无所不在。

生成式对抗网络(GANs)、变换器模型(Transformers)等算法代码示例:

生成式对抗网络(GANs)代码示例

以下是一个简单的GAN示例,使用Keras构建一个生成器和判别器来生成手写数字(MNIST 数据集)。

import numpy as np

import matplotlib.pyplot as plt

from keras.datasets import mnist

from keras.models import Sequential

from keras.layers import Dense, Reshape, Flatten

from keras.optimizers import Adam

# 载入 MNIST 数据集

(X_train, _), (_, _) = mnist.load_data()

X_train = X_train.astype(np.float32) / 255.0

X_train = X_train.reshape(X_train.shape[0], 784) # 扁平化

# GAN 参数

latent_dim = 100

adam = Adam(lr=0.0002, beta_1=0.5)

# 构建生成器

generator = Sequential([

Dense(256, activation='relu', input_dim=latent_dim),

Dense(512, activation='relu'),

Dense(1024, activation='relu'),

Dense(784, activation='sigmoid'), # 输出为784维的(x, y)

Reshape((28, 28))

])

# 构建判别器

discriminator = Sequential([

Flatten(input_shape=(28, 28)),

Dense(512, activation='relu'),

Dense(256, activation='relu'),

Dense(1, activation='sigmoid') # 输出为[0,1]

])

# 编译判别器

discriminator.compile(loss='binary_crossentropy', optimizer=adam, metrics=['accuracy'])

# GAN 模型

discriminator.trainable = False

gan_input = Input(shape=(latent_dim,))

generated_image = generator(gan_input)

gan_output = discriminator(generated_image)

gan = Model(gan_input, gan_output)

gan.compile(loss='binary_crossentropy', optimizer=adam)

# 训练 GAN

def train_gan(epochs, batch_size):

for epoch in range(epochs):

# 训练判别器

idx = np.random.randint(0, X_train.shape[0], batch_size)

real_images = X_train[idx]

noise = np.random.normal(0, 1, (batch_size, latent_dim))

fake_images = generator.predict(noise)

d_loss_real = discriminator.train_on_batch(real_images, np.ones((batch_size, 1)))

d_loss_fake = discriminator.train_on_batch(fake_images, np.zeros((batch_size, 1)))

d_loss = 0.5 * np.add(d_loss_real, d_loss_fake)

# 训练生成器

noise = np.random.normal(0, 1, (batch_size, latent_dim))

g_loss = gan.train_on_batch(noise, np.ones((batch_size, 1)))

if (epoch + 1) % 1000 == 0:

print(f"Epoch: {epoch + 1}, D Loss: {d_loss[0]}, G Loss: {g_loss}")

# 开始训练

train_gan(epochs=10000, batch_size=128)

变换器模型(Transformers)代码示例

以下是一个使用PyTorch的变换器模型的示例,演示如何创建一个简单的文本分类模型。

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, Dataset

from transformers import BertTokenizer, BertModel

# 定义一个简单的数据集

class TextDataset(Dataset):

def __init__(self, texts, labels):

self.texts = texts

self.labels = labels

self.tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

def __len__(self):

return len(self.texts)

def __getitem__(self, idx):

text = self.texts[idx]

label = self.labels[idx]

inputs = self.tokenizer(text, return_tensors='pt', padding=True, truncation=True, max_length=512)

return inputs, label

# 定义变换器模型

class TransformerModel(nn.Module):

def __init__(self):

super(TransformerModel, self).__init__()

self.bert = BertModel.from_pretrained('bert-base-uncased')

self.fc = nn.Linear(self.bert.config.hidden_size, 1) # 假设是二分类

def forward(self, inputs):

outputs = self.bert(**inputs)

return self.fc(outputs.pooler_output)

# 初始化数据集和模型

texts = ["I love programming.", "I hate bugs."]

labels = [1, 0]

dataset = TextDataset(texts, labels)

dataloader = DataLoader(dataset, batch_size=2)

model = TransformerModel()

optimizer = optim.Adam(model.parameters(), lr=1e-5)

criterion = nn.BCEWithLogitsLoss()

# 训练模型

for epoch in range(5):

for inputs, labels in dataloader:

optimizer.zero_grad()

outputs = model(inputs[0])

loss = criterion(outputs.squeeze(), torch.FloatTensor(labels).unsqueeze(1))

loss.backward()

optimizer.step()

print(f"Epoch [{epoch + 1}], Loss: {loss.item()}")

# 调用模型进行推断(在此示例中省略了代码)

以上示例简单实现了基本的GAN和Transformers模型。实际使用时,您可能需要根据具体任务进行优化和调整参数。

此外,增强学习(Reinforcement Learning)也在人机交互、自动驾驶等领域展现出巨大的潜力。随着算力的提升、数据的丰富以及模型设计的优化,未来我们可以期待AI在更多复杂环境中的表现。

二、分享AI技术在实际项目中的创新应用

在实际项目中,AI技术的应用不仅仅局限于理论研究,更是在实际场景中展现其价值。以医疗影像分析为例,许多医院开始利用AI技术来辅助医生进行疾病的早期检测。通过训练深度学习模型分析成千上万的医学图像,AI能够在工作效率和准确率上大幅提升。例如,使用卷积神经网络(CNN)进行肺癌筛查,研究表明其准确率已接近人类医生。

示例代码:使用CNN进行医疗影像分类

首先,请确保安装了所需的库:

pip install tensorflow keras opencv-python matplotlib

数据目录结构

你的数据目录应该按照以下结构组织:

data/

train/

class1/

image1.jpg

image2.jpg

...

class2/

image1.jpg

...

validation/

class1/

image1.jpg

...

class2/

image1.jpg

...

代码示例

以下是实现卷积神经网络的完整代码示例:

import numpy as np

import matplotlib.pyplot as plt

from tensorflow.keras.preprocessing.image import ImageDataGenerator

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense, Dropout

from tensorflow.keras.callbacks import EarlyStopping

# 数据增强与预处理

train_datagen = ImageDataGenerator(

rescale=1./255, # 将像素值缩放到[0,1]

rotation_range=20,

width_shift_range=0.2,

height_shift_range=0.2,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True,

fill_mode='nearest' # 填充模式选择

)

validation_datagen = ImageDataGenerator(rescale=1./255)

# 训练和验证数据生成器

train_generator = train_datagen.flow_from_directory(

'data/train', # 训练数据集的路径

target_size=(150, 150), # 所有图像调整为150x150大小

batch_size=32,

class_mode='binary' # 如果是二分类问题,使用'binary'

)

validation_generator = validation_datagen.flow_from_directory(

'data/validation', # 验证数据集的路径

target_size=(150, 150),

batch_size=32,

class_mode='binary'

)

# 构建CNN模型

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(150, 150, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Conv2D(64, (3, 3), activation='relu'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Conv2D(128, (3, 3), activation='relu'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(256, activation='relu'))

model.add(Dropout(0.5)) # 防止过拟合

model.add(Dense(1, activation='sigmoid')) # 二分类

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

early_stopping = EarlyStopping(monitor='val_loss', patience=5)

history = model.fit(

train_generator,

steps_per_epoch=train_generator.samples // train_generator.batch_size,

validation_data=validation_generator,

validation_steps=validation_generator.samples // validation_generator.batch_size,

epochs=25,

callbacks=[early_stopping]

)

# 可视化训练过程

# 绘制准确率

plt.figure(figsize=(12, 4))

plt.subplot(1, 2, 1)

plt.plot(history.history['accuracy'], label='Training Accuracy')

plt.plot(history.history['val_accuracy'], label='Validation Accuracy')

plt.title('Model Accuracy')

plt.ylabel('Accuracy')

plt.xlabel('Epoch')

plt.legend()

# 绘制损失值

plt.subplot(1, 2, 2)

plt.plot(history.history['loss'], label='Training Loss')

plt.plot(history.history['val_loss'], label='Validation Loss')

plt.title('Model Loss')

plt.ylabel('Loss')

plt.xlabel('Epoch')

plt.legend()

plt.show()

代码说明

-

数据增强:

- 使用 `ImageDataGenerator` 进行数据增强,以提高模型的泛化能力,随机变换(如旋转、平移、缩放等)图像。

-

构建CNN模型:

- 使用Keras的 `Sequential` 模型,构建一个典型的卷积神经网络,包含卷积层、池化层、全连接层和Dropout层。

-

编译与训练模型:

- 编译模型时指定优化器、损失函数和评估指标。模型训练过程中使用早停(`EarlyStopping`)来防止过拟合。

-

可视化结果:

- 在训练结束后,使用Matplotlib绘制训练和验证的准确率及损失值随时间的变化图,以便更好地理解模型的学习过程。

注意事项

- 请确保数据集中的类已经正确定义,并且每个类都包含足够的图像进行训练和验证。

- 上述代码适合于二分类情况。对于多分类问题,请将 `class_mode` 更改为 `'categorical'`,并在最后一层将激活函数改为 `softmax` 并适配损失函数为 `categorical_crossentropy`。

- 此示例中的超参数(如卷积层的数量、神经元的数量、批量大小和训练轮数等)可以根据具体任务进行调整。

另一例子是智能客服系统,结合NLP技术的AI能够有效地回答用户问题并提供支持,减轻了人工客服的压力。这些应用不仅提高了效率,也优化了用户体验,显示出AI技术在提升业务价值方面的巨大潜力。

以下是智能客服系统的创新应用示例,以及结合NLP技术的代码示例:

1. 智能客服系统概述

智能客服系统通常包括以下功能:

- 用户意图识别:理解用户的输入,识别其背后的意图。

- 实体识别:提取用户输入中的特定信息(如日期、地点等)。

- 问答系统:根据知识库回答用户的问题。

- 对话管理:管理对话状态,保持对话的连贯性。

2. 技术栈

在实现智能客服系统时,可以采用以下技术:

- NLP 库:如 spaCy、NLTK、Hugging Face Transformers。

- 聊天框架:如 Rasa、Microsoft Bot Framework、Dialogflow。

- 后端框架:如 Flask、Django(Python)。

- 数据库:用于存储用户信息、聊天记录和知识库。

3. 基本示例

下面是一个用Python实现的简化版智能客服系统的代码示例,使用了Hugging Face的Transformers库来处理用户输入。

安装依赖

在开始之前,需要确保已安装以下库:

pip install transformers torch flask

代码示例

from flask import Flask, request, jsonify

from transformers import pipeline

app = Flask(__name__)

# 初始化问答模型

qa_pipeline = pipeline("question-answering")

# 简单的知识库

knowledge_base = {

"What is your return policy?": "You can return any item within 30 days of purchase.",

"How can I track my order?": "You can track your order using the tracking link sent to your email.",

"What are your customer service hours?": "Our customer service is available from 9 AM to 5 PM, Monday through Friday.",

}

@app.route('/chat', methods=['POST'])

def chat():

user_input = request.json.get('message')

# 本示例简单匹配知识库的问题

for question in knowledge_base:

if question.lower() in user_input.lower():

return jsonify({"response": knowledge_base[question]})

# 如果知识库没有匹配到,使用问答模型

answer = qa_pipeline(question=user_input, context=" ".join(knowledge_base.keys()))

return jsonify({"response": answer['answer']})

if __name__ == '__main__':

app.run(port=5000)

4. 使用示例

在终端运行该Flask应用后,可以通过HTTP POST请求进行交互。

请求示例:

curl -X POST -H "Content-Type: application/json" -d '{"message": "What is your return policy?"}' http://localhost:5000/chat

响应示例:

{

"response": "You can return any item within 30 days of purchase."

}

5. 扩展功能

-

用户意图识别:可以使用训练好的分类模型(如BERT)对用户意图进行分类。

-

对话状态管理:可以使用Rasa等框架实现对话状态管理,使对话更有连贯性。

-

实体识别:使用spaCy提取用户询问中的关键信息,以获得更好的上下文理解。

-

知识库扩展:可以通过数据库管理系统将知识库信息存储和查询,实现动态更新。

智能客服系统利用AI及NLP技术可以大幅提升客户服务的效率和质量。通过不断优化模型和扩充知识库,可以建立一个更加智能、准确的客服助手。

三、分享在开源社区中的宝贵经验与深刻洞察

如作为一个活跃的开源社区参与者,我们应该深知开源的重要性。开源不仅促进了技术的透明化与共享,更是推动了创新的动力。在过去的几年中,也参与了部分开源项目,从中获得了许多宝贵的经验。

首先,开源项目带给我们最大的收获是技术能力的提升。通过阅读源代码、参与讨论以及解决问题,会让我们对编程语言和框架的理解加深了很多。其次,开源促进了全球开发者的协作,通过社区的反馈,我们能及时调整自己的思路和方法,这种思想的碰撞极大地拓宽了我们的视野。

最后,开源的热情与活跃的氛围也在不断激励我们去学习更前沿的技术。参与贡献代码的过程中,与其他开发者的互动让我们了解到行业的动态发展趋势,推动我们不断进步。

总结

在这个充满机遇的时代,无论你是AI领域的新手,还是经验丰富的技术创作者,都应抓住这个开源与AI融合的趋势。通过不断学习和实践,我们不仅能够提升自身的技术能力,也能为社会带来更多的价值。希望这篇文章能够激发您在编程与AI领域的无限创作潜能,期待在开源社区中与您共同成长!

如果您喜欢此文章,请收藏、点赞、评论,谢谢,祝您快乐每一天。

AI编程与开源实践探索

AI编程与开源实践探索

950

950

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?