先说明一下,本人云服务器是centos 4核8G无GPU,为了部署方便借助宝塔,不知道如何下载安装宝塔的可以去宝塔官网,傻瓜式安装

1.安装ollama 和dify (注意如果安装失败,需要配置加速URL)

2.ollama 安装模型

需要安装2类模型,这里我装了deepseekr1和bge-m3(Embedding模型)

3.配置dify

因为我的dify是绑定到8081端口,所以我的dify访问地址是:ip:8081/apps,第一次登录需要设置管理员账号

设置好管理员账号,登录进入然后去设置页面设置模型商

如果模型列表显示模型未配置,先进行模型商的安装

如果安装不成功,可以进行手动安装,点击上面的详情里面可以下载difypkg格式的文件,导入下面的本地插件进行安装,安装好之后回到刚才设置的页面,选择刚安装的ollama

接下来就是添加模型

模型名称就是之前安装的如果不知道,可以docker登录 然后输入ollama list可以列出你所安装的模型,基础url就是你的当前ip:11434,下面默认点保存如下

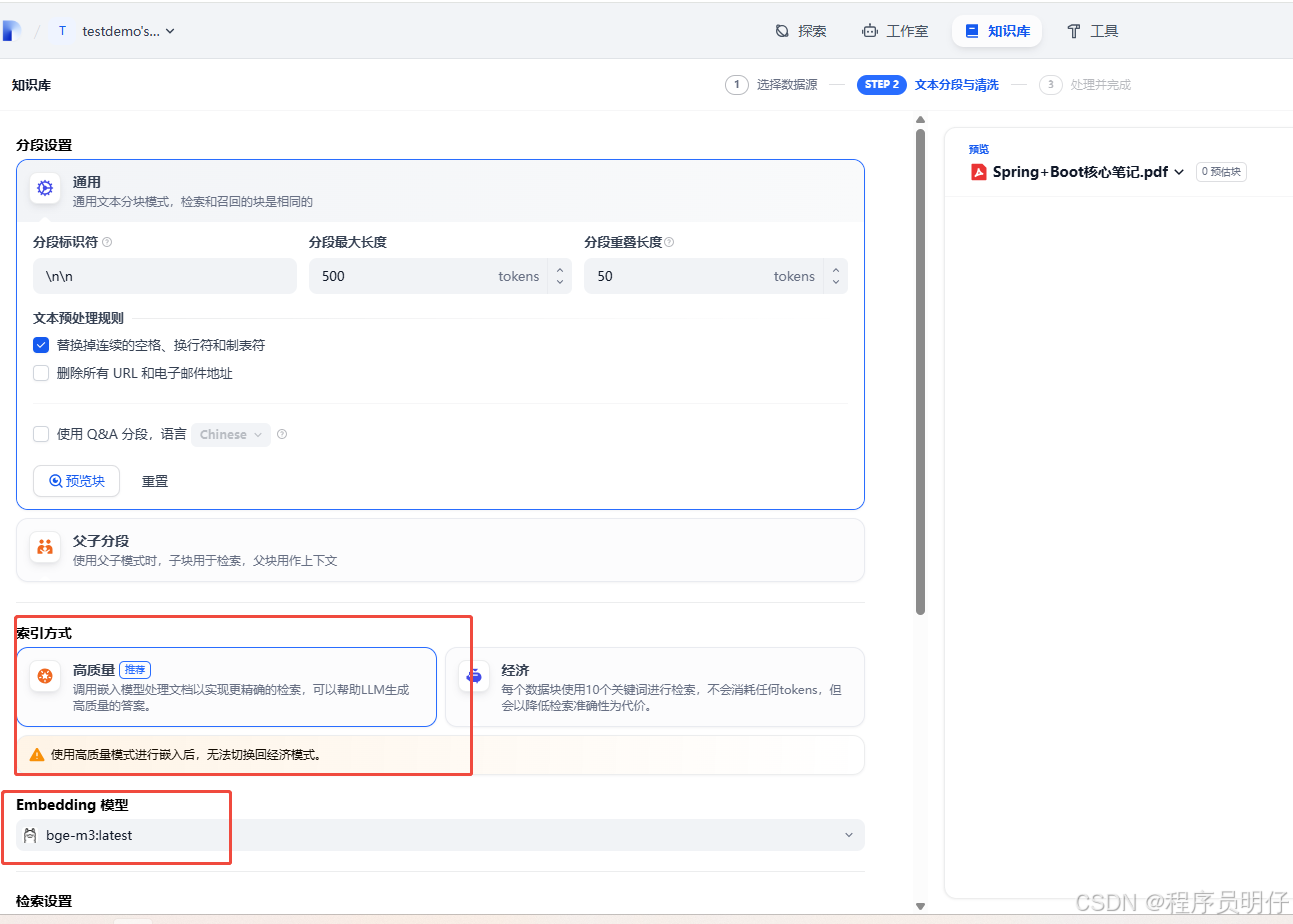

4.上传知识库

注意选择embedding模型,保存,等待解析完成

注意选择embedding模型,保存,等待解析完成

5.新增聊天助手

这里选择知识库,保存之后

可以直接部署网站也可以api调用

点击运行可以测试一下效果,如果打不开注意添加上绑定的端口

具体部署问题可以搜索订阅号 “AI大模型机器人” 找我免费咨询

3953

3953

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?