当 OpenVINO 不支持你所部署模型算子时,你该如何做?

- 1. 前言

- 2. 提交Issues

- 3. 编译OpenVINO源码

-

- 3.1 下载源码

- 3.2 修改源码

- 3.3 源码编译

- 3.4 获取编译后的动态链接库

- 4. 实际项目测试

- 5. 总结

1. 前言

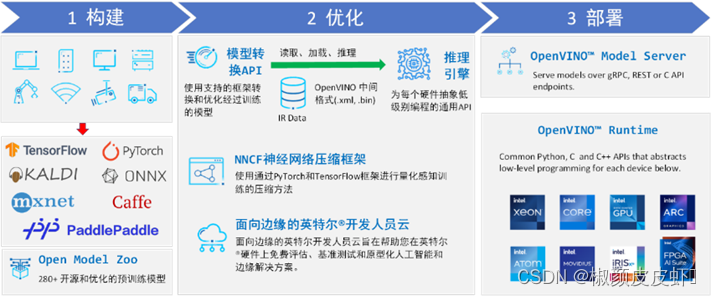

英特尔发行版 OpenVINO™工具套件基于oneAPI 而开发,可以加快高性能计算机视觉和深度学习视觉应用开发速度工具套件,适用于从边缘到云的各种英特尔平台上,帮助用户更快地将更准确的真实世界结果部署到生产系统中。通过简化的开发工作流程, OpenVINO™可赋能开发者在现实世界中部署高性能应用程序和算法。

OpenVINO™ 2023.2于2023年11月16日发布,该工具包带来了挖掘生成人工智能全部潜力的新功能。更多的生成式 AI 覆盖和框架集成,以最大限度地减少代码更改,并且扩展了对直接 PyTorch 模型转换的模型支持。支持更多新的模型,包括 LLaVA、chatGLM、Bark和 LCM等著名模型。支持更广泛的大型语言模型 (LLM)和更多模型压缩技术,支持运行时推理支持以下 Int4 模型压缩格式,通过神经网络压缩框架 (NNCF) 进行本机 Int4 压缩等一系列新的功能。

通过最新的OpenVINO™更新信息,我们可以看出,OpenVINO™其实是在不断更新迭代,并且适配更多新的模型。其主要原因是不少新出现的模型可能会带来更多新的算子,而OpenVINO™可能会在后续的版本更新中才会适配。但如果我们当前阶段需要使用OpenVINO™部署该深度学习模型,那我们该怎么做?

其实对于一些编程大佬,以及对OpenVINO™有深入研究的人,他们可以对OpenVINO™源码进行修改,然后自己写模型算子,添加到OpenVINO™中。但是,开发算子的门槛是很高的,对于大多数开发者来说,这是很困难很难实现的。

在之前部署RT-DETR模型时,我也遇到了该模型在OpenVINO™使用GPU设备部署出现算子不支持问题。因此在该文章中,我将结合该问题的解决过程,向大家展示对于大多数开发者,如何解决模型部署时出现算子不匹配问题。

项目首发网址:

本文介绍了如何处理OpenVINO不支持模型算子的问题,包括提交GitHubIssues寻求帮助、源码编译及动态链接库替换,以实现在实际项目中部署模型。

本文介绍了如何处理OpenVINO不支持模型算子的问题,包括提交GitHubIssues寻求帮助、源码编译及动态链接库替换,以实现在实际项目中部署模型。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5472

5472

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?