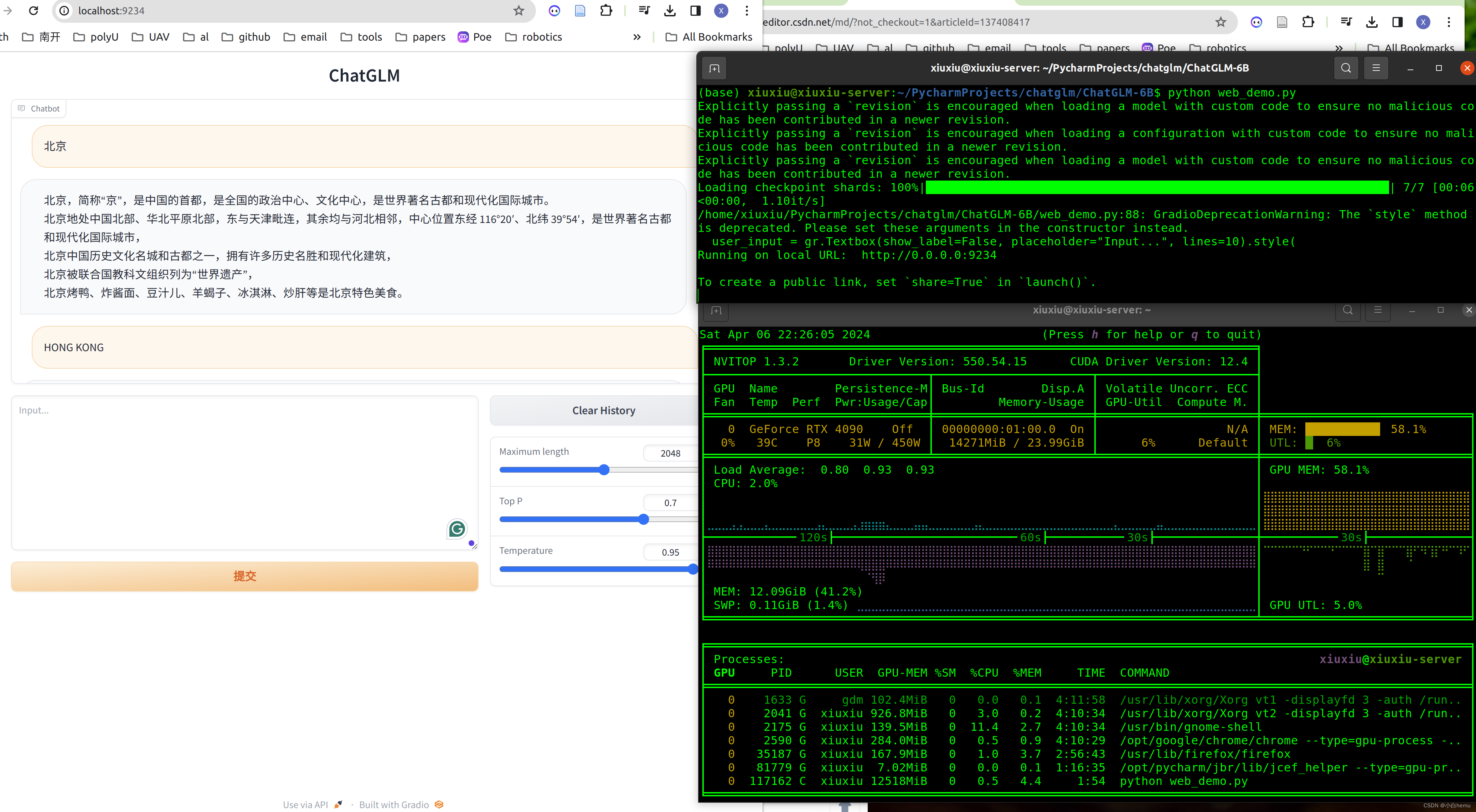

ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。

项目代码https://github.com/THUDM/ChatGLM-6B

权重开放:https://huggingface.co/THUDM/chatglm-6b

复现过程:

# 新建chatglm环境

conda create -n chatglm

# 激活chatglm环境

conda activate chatglm

# 安装PyTorch环境,按需求https://pytorch.org/:

这里我是:

python 3.11.7

torch 2.2.1

torchvision 0.17.1

# 安装gradio用于启动图形化web界面

pip install gradio

# 安装运行依赖

git clone https://github.com/THUDM/ChatGLM-6B.git

pip install -r requirement.txt

报错信息在这里注意一下版本问题,我踩到了pydantic的报错,找了很久,最后发现是版本问题.

T

本文档详细介绍了如何复现ChatGLM-6B,一个62亿参数的双语对话语言模型。通过使用模型量化技术,该模型可以在消费级显卡上本地部署。复现过程中需要注意pydantic版本问题,以及如何下载权重并配置项目。此外,还提供了关于在web_demo.py中调整参数以适应不同显存需求的说明,并提到了使用ToolAlpaca进行微调的可能性。

本文档详细介绍了如何复现ChatGLM-6B,一个62亿参数的双语对话语言模型。通过使用模型量化技术,该模型可以在消费级显卡上本地部署。复现过程中需要注意pydantic版本问题,以及如何下载权重并配置项目。此外,还提供了关于在web_demo.py中调整参数以适应不同显存需求的说明,并提到了使用ToolAlpaca进行微调的可能性。

订阅专栏 解锁全文

订阅专栏 解锁全文

611

611

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?