1、摘要部分

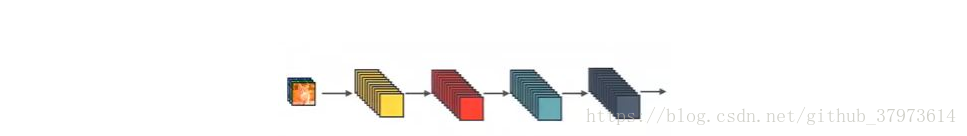

卷积网络现在做得越来越深,精确,并且训练起来越来越高效。本文根据这一个结论,提出了一种稠密卷积神经网络(DenseNet)。传统的L层卷积神经网络又L个连接——位于每一层和它后面一层,而我们的神经网络有,对于每一层,其输入的特征是之前的所有层,而它自己的输出特征则作为之后所有层的输入。

2、Advantage

- alleviate the vanishing-gradient problem

- improve flow of information

- requires few parameters

- feature reuse

3、DenseNet与ResNet对比

作者主要受到ResNet和Highway Networks的启发,下面来看看结构。

本文介绍了DenseNet稠密卷积神经网络,该网络通过连接每一层到后续所有层来缓解梯度消失问题,促进信息流动,减少参数并实现特征复用。与ResNet对比,DenseNet由稠密块和过渡层组成,其中过渡层用于调整特征图大小。尽管DenseNet训练时内存需求较高,但其高效的结构和加速收敛的特性使其在深度学习中具有独特优势。

本文介绍了DenseNet稠密卷积神经网络,该网络通过连接每一层到后续所有层来缓解梯度消失问题,促进信息流动,减少参数并实现特征复用。与ResNet对比,DenseNet由稠密块和过渡层组成,其中过渡层用于调整特征图大小。尽管DenseNet训练时内存需求较高,但其高效的结构和加速收敛的特性使其在深度学习中具有独特优势。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?