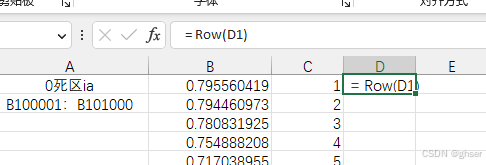

1.C3 = Row(C3)

2. CTRL+G(定位)到C50000

3. 按CTRL+SHIFT+上箭头键,这时选中了A3到A50000

4. 选中需要填充的列区域,按住 ctrl+D 键,填充完成; 如果填充的是行区域,是按住 ctrl+R 键

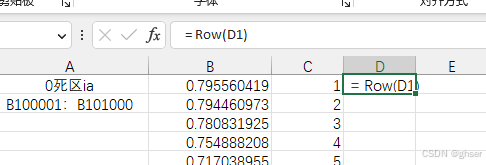

1.C3 = Row(C3)

2. CTRL+G(定位)到C50000

3. 按CTRL+SHIFT+上箭头键,这时选中了A3到A50000

4. 选中需要填充的列区域,按住 ctrl+D 键,填充完成; 如果填充的是行区域,是按住 ctrl+R 键

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?