AI服务器市场近年来呈现出蓬勃发展的态势,出货量持续攀升,成为推动数据中心升级和人工智能应用落地的关键力量。英伟达作为全球领先的GPU制造商,在AI服务器领域占据着举足轻重的地位。其凭借强大的计算能力和高效的并行处理架构,为AI服务器提供了核心动力,几乎成为行业的标配。从入门级到高端旗舰,英伟达推出了多款型号的GPU。周末简单研究了一下这些型号:

|

型号 |

架构 | 显存类型 |

容量 |

带宽 |

其他主要特性 |

|

GB300 |

Blackwell |

HBM3e |

288GB |

16TB |

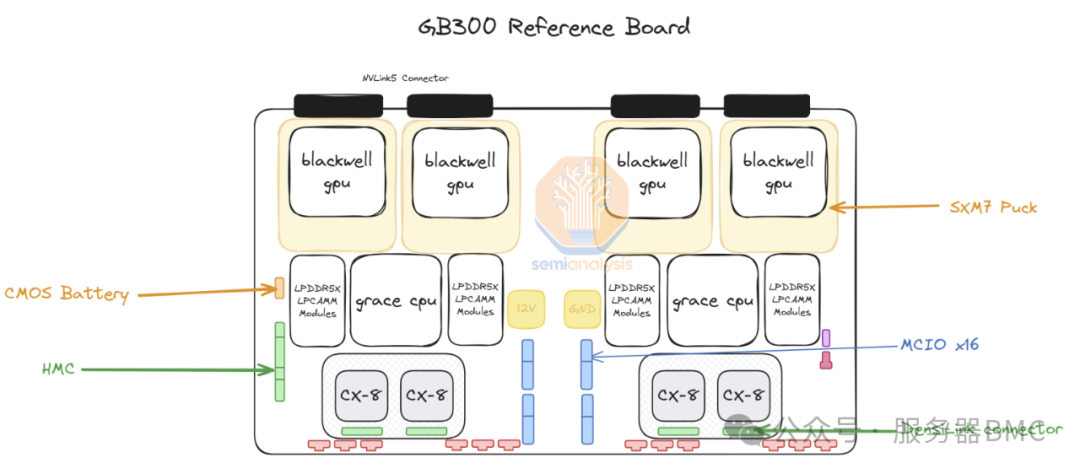

GB300则采用了一体化的板卡设计,集成了2个Grace CPU和4个GPU |

|

B300 |

Blackwell Ultra |

HBM3e |

288GB |

8TB |

更先进的Blackwell Ultra架构和更高的晶体管数量,FP4算力提升约50%,功耗从B200的1200W增加到1400W |

|

GB200 |

Blackwell |

HBM3e |

192GB |

16 TB |

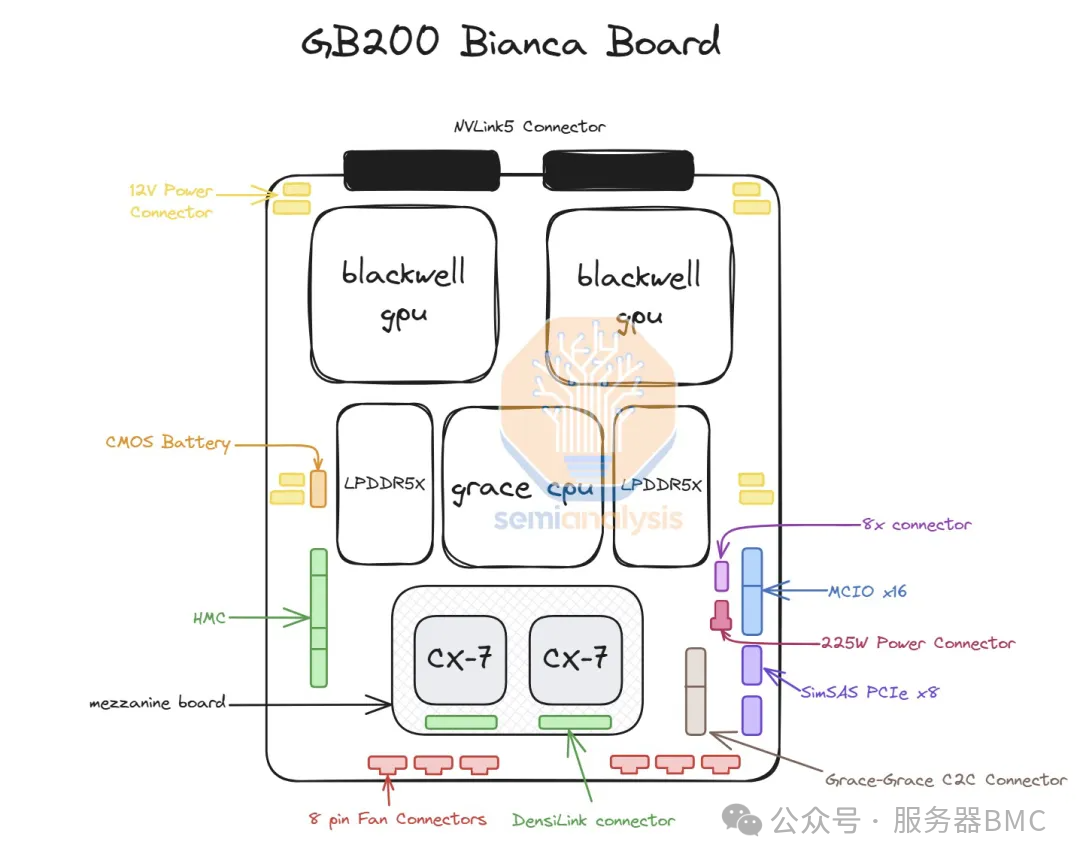

由2个B200 GPU和1个Grace CPU组合而成,专为高性能AI应用设计 |

|

B200 |

Blackwell |

HBM3e |

192GB |

8TB |

高性能AI芯片,FP16算力是H100的2倍以上,TDP为1000W |

|

H200 |

Hopper |

HBM3e |

141GB |

4.8 TB |

升级了GPUU显存,是H100的升级款产品 |

|

H100 |

Hopper |

HBM3 |

80 GB |

3TB |

支持PCIe 5.0和NVLink 8.0技术,专为AI和高性能计算优化 |

|

A100 |

Ampere |

HBM2e |

80 GB |

2TB |

支持PCIe 4.0和第三代NVLink互连技术 |

|

RTX 4090 |

Ada Lovelace |

GDDR6X |

24 GB |

1TB |

配备GDDR6X显存,支持DirectX12 Ultimate,用于高端游戏和图形工作站 |

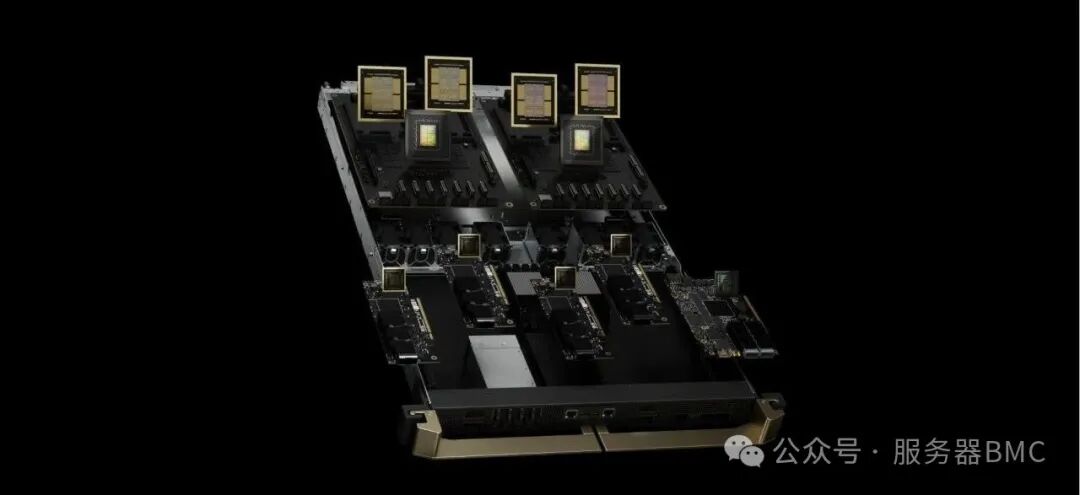

英伟达在 GB200 和 B200 发布仅 6 个月后,他们就向市场推出了一款全新的 GPU,名为 GB300 和 B300。二者除了芯片本身有升级外,板卡架构上也有很大变化。如下图所示:

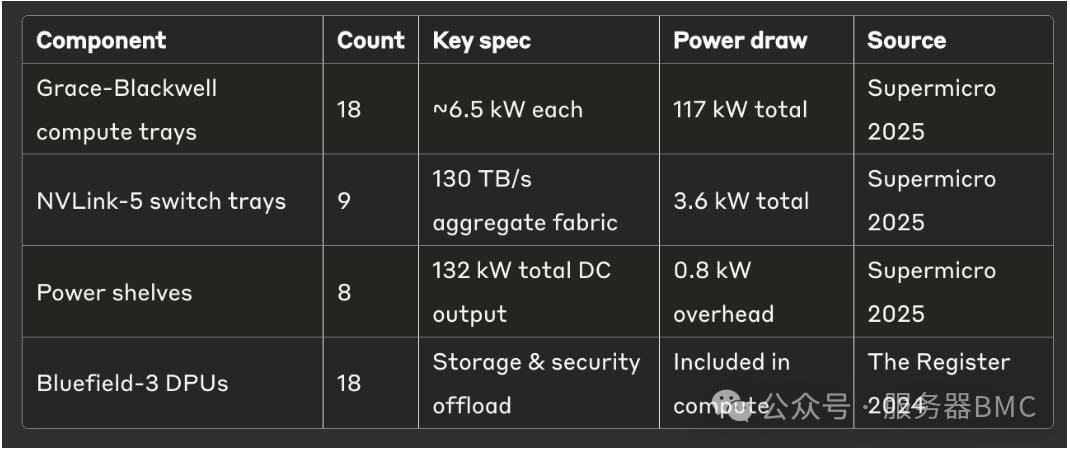

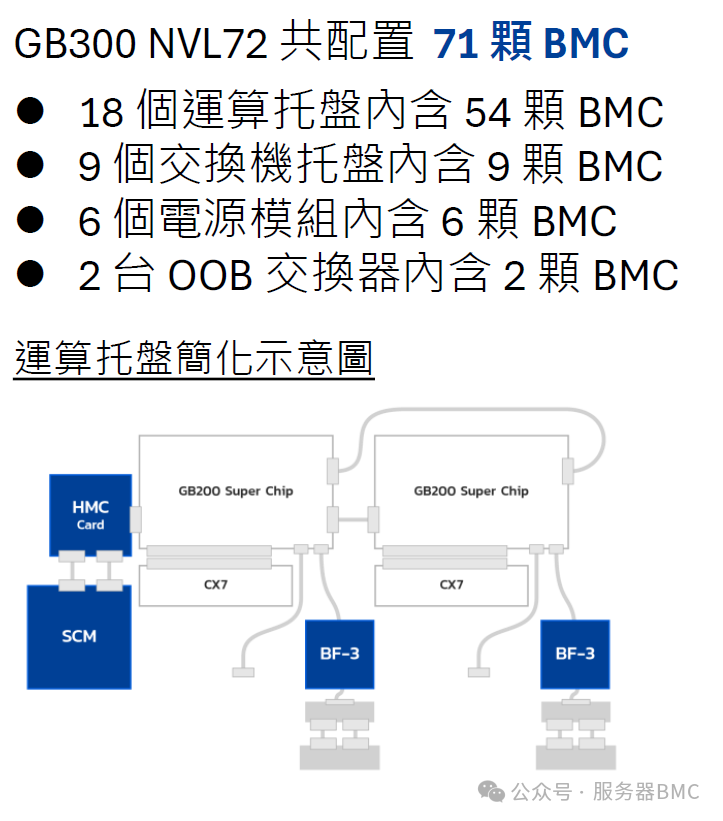

针对GB300/200,英伟达也推出了GB300/200 NVL72。GB300 NVL72 采用机柜级扩展设计,将大量的 GPU、CPU、DPU 等组件集成在一个机柜中,形成一个强大的计算集群。通过先进的 NVLink 技术和高速网络设备,实现了组件之间的高效通信和协同工作,确保了系统的整体性能和稳定性。

根据网上信息反馈,整个机柜中有18个GPU computer tray,9个switch tray,6个Power shelves,2个OOB交换机。好像也有其他配置方式,如下图:

每个GPU Computer tray大概需要三个BMC

每个switch tray大概需要一个BMC

每个电源模组内大概有一个BMC

每个OOB交换机大概需要一个BMC

所以一个NVL72要71个BMC芯片,此数据参考5月底中国台湾公司在香港开会的宣传:

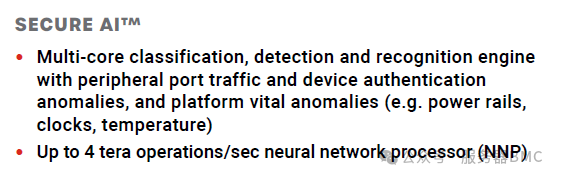

按照网上的信息,GB300上的BMC好像来自美国初创公司,有更好的安全性和人工智能特性,而非 GB200 的 2600。

我对AI服务器了解不多。如有错误请指正,以上仅供参考。

875

875

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?