摘要:我们提供了一个学习框架,该框架学习从单个图像中恢复3D形状,姿势和纹理,并在没有ground truth 3D shape,多视图,相机视点或关键点监督的情况下对图像集进行训练。我们在“综合分析”框架中解决这个高度受限的问题,目标是预测形状,纹理和相机视点的相似性,这些形状,纹理和相机视点可能会产生具有各种已习得的类别特定先验的图像(??)。我们在本文中的特殊贡献是提出了一个像机分布的表示形式,我们称其为“camera-multiplex””。我们没有选择点估计,而是保留了一组在训练过程中进行了优化的相机假设,以在给出当前形状和纹理的情况下最好地解释图像。我们称此方法为无监督的特定类别网格重建(U-CMR),并在CUB,Pascal 3D和新的Web抓取的数据集上展示定性和定量结果。我们获得了目前最好的相机预测结果,并表明我们可以使用图像集学习预测整个对象的各种形状和纹理,而无需任何关键点注释或3D ground truth。

1 introduction

近年来,使用深度网络从2D图像推断3D形状取得了很大进展。这些方法基于所使用的监督信号分为两类(a)ground truth的3D模型(可在诸如ShapeNet之类的CAD模型集合中使用)(b)相同对象的多个视图,可以通过不同视图的对应性,使用深度学习或经典技术(例如形状雕刻或运动结构)来学习3D形状。但是,我们需要这些监督吗?

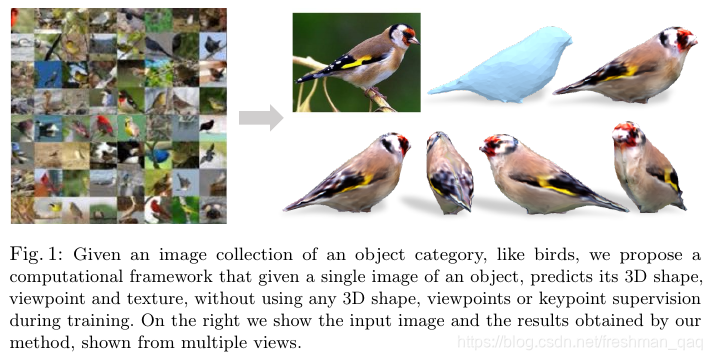

在互联网上可以轻松找到大量属于特定类别的对象(例如鸟,汽车或椅子)的图像集合。首先我们关注鸟类,对于鸟类,存在如图1(左)所示的CUB [35]这样的数据集。请注意,这是“多实例单视图”设置。对于每个鸟类实例,我们只有一个视图,并且即使多个实例是同一类鸟,每只鸟类的形状也略有不同。与具有“单实例多视图”的经典SFM相比,我们的目标是“ 3Dfy”这些鸟。从单个图像中恢复3D形状及其纹理贴图,然后可以从不同的相机视角对其进行渲染,如图1(右)。 Kanazawaet等人的“类别特定的网格重构”[15]工作介绍了这种特定的公式。 他们的算法(CMR)是我们工作的灵感。甚至更早的Cashman和Fitzgibbon [3]在分析海豚图像上的工作表明,通过“具有形状类别的可变形模板模型”的“综合分析”范式可以使人在优化框架中推断3D形状。

令人遗憾的是,这些方法虽然开创性地利用了一些有用的监督信息。这包括(1)类别的平均形状(2)每个实例的剪影(3)各种实例上标记的关键点(例如,每只鸟的喙尖)。其中,最需要的是标注的关键点。整个类别仅需要一个平均形状,有时使用非常通用的初始化(例如球体)就足够了。可以通过例如Mask R-CNN的实例分割网络来标记剪影(或许也可以用与类别无关的方式)。但是在每个实例上都标注关键点是一个很大的工作量。对于像人类这样的单个类别,可以证明这一努力是合理的,但是对于我们可能想要“ 3Dfy”的数千个类别,我们承受不起。是的,我们可以通过网络标记关键点,但要进行训练需要关键点标签!近年来,在无监督的关键点检测方面已经做出了一些努力[13],但是到目前为止,这些方法学习的是依赖于视点的关键点,这些关键点在存在180度旋转的情况下常常会混淆。

在本文中,我们提出了一种方法,即U-CMR(适用于无监督CMR),它使我们能够训练一个函数,该函数可以将图像分解为3D形状,纹理和相机,并且设置与CMR大致相似[15],只是我们替换了整个类别都需要具有单个3D模板形状的关键点注释。事实证明,要恢复相机(使用类似SFM的技术)需要关键点注释,如果我们没有关键点注释,则必须同时解决形状和纹理问题。不幸的是,将“综合分析”范式扩展到还可以恢复摄像机是相当困难的。从直觉上讲,这是由于可能的摄像机视点空间的不连续和多模态。虽然形状和纹理具有平滑,表现良好的优化表面,但可以进行梯度下降优化,这并不适合可能的相机空间。相机的两种最可能的解释可能位于视域的相对侧,在这种情况下,不可能像优化深度网络的能量格局时那样以迭代方式接近最佳相机。这通常会使相机预测陷入bad的局部最小值。我们对这个问题的解决方案是为每个训练实例维护一组可能的相机假设,这就是我们所谓的“camera-multiplex”。这让人联想到粒子滤波方法,其思想是保持分布而不是过早地选择点估计。我们可以迭代地优化形状,纹理以及摄影机的多重性。第3节中提供了更多详细信息。

我们评估了4类3D形状,姿势和纹理重构的方法:CUB-200-2011鸟类[35],PASCAL-3D [38]汽车,摩托车和我们刮掉的鞋子的新数据集来自网络。我们显示,天真地预测形状,相机和纹理会直接导致退化的解决方案,其中形状是扁平的,相机会崩溃为单一模式。我们定量评估了最终的摄像机预测,其中在这种没有关键点注释的弱监督设置下,所提出的camera-multiplex方法获得了最好的结果。我们表明,尽管缺乏视点和关键点,我们仍可以学习合理的3D形状空间,接近通过使用关键点监督的先前方法获得的形状[15]。

2 相关工作

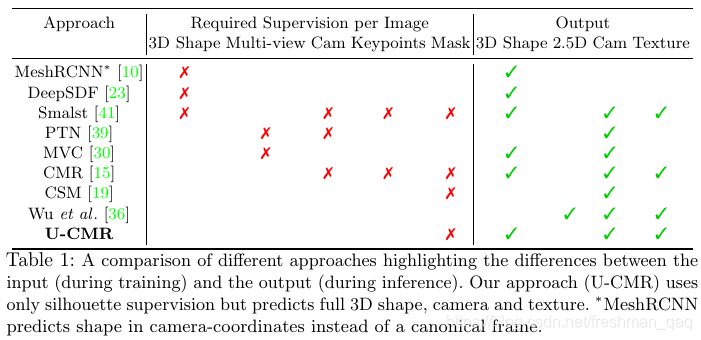

最近的基于深度学习的3D重建方法可以按所需的监督信号和系统输出进行分类。在表1中对此进行了说明。较早的方法提出了假设图像[5,9,7,31,10]是有3D形状监督的,这些方法可以在ShapeNet [37]和SunCG [27]等合成数据集上使用。一些方法使用从现实世界收集的数据来生成合成数据集,以训练他们的模型[4,33,41]。但是,由于ground truth 3D形状的成本很高或无法获得,特别是在大规模情况下,需要3D监督严重地限制了这些方法。因此,接下来的方法探索了更自然的监督形式,即可以使用同一对象的多个视图。其中一些方法采用类似于传统MVS或可见外壳(由空间物体的所有已知侧影轮廓线决定的该物体的凸包)的已知视点[39,16,32]。其他方法探讨了未知视点设置的问题[30,12,8]。这些方法假定多视图轮廓,图像和/或深度图像可用,并训练它们的模型,以便预测的3D形状在投影或可微分的渲染后重建图像。[21,18,20]已经探索了多种可区分的渲染机制。

尽管可以在现实世界中获得多视图图像,但是大部分是无约束收集单视图图像,而不是同时获得同一实例的多个视图。对于形状可能随时间变化的非刚性物体,也是通过这种方法获取图像的。传统的从运动中恢复非刚性结构[29]也属于此类别,其中输入是对应的跟踪集点[29,6]或2D关键点[34,22]。较早的方法将可变形的3D模型[1,17,3,14]拟合到2D关键点和mask。Kanazawaet al.[15] 提出的CMR是一种基于学习的框架,其中从单个图像预测3D形状,纹理和相机姿态,并在具有已知mask和关键点注释的单视图图像集合的这种设置下进行训练。虽然这是朝着正确方向迈出的一步,但关键点注释的要求仍然很严格。最近,Kulkarniet等人。 [19]绕过了关键点的这种要求,从具有mask监督和模板3D形状的一组图像集中学习对象的密集规范表面映射。他们专注于预测图像上的表面对应关系,并在训练过程中学习预测相机的视点,但不学习预测3D形状。当我们解决一个不同的问题时,我们在相同的必需监督下进行操作。因此,我们在预测的摄像机质量上与CSM进行了定量比较,其中我们的方法获得了更好的摄像机预测。请注意,最近有几种方法可以将图像分解成2.5D表面特性、相机和来自单眼图像集合的可见区域的纹理,而无需使用任何mask[28,26,36]。然而,这些方法主要在人脸上被证明。在这项工作中,我们从单个图像中恢复了完整的3D表示和纹理。

3 方法

3.1准备工作

本文介绍了一种无监督学习框架,用于从单个图像中恢复3D形状、纹理和相机视点,无需3D ground truth、多视图或关键点监督。提出了一种名为“camera-multiplex”的相机分布表示,以处理相机视点的不连续和多模态问题。通过在CUB、Pascal 3D和自建数据集上的实验,证明了无监督方法在相机预测方面的优势,展示了在无关键点注释的情况下学习多样3D形状和纹理的能力。

本文介绍了一种无监督学习框架,用于从单个图像中恢复3D形状、纹理和相机视点,无需3D ground truth、多视图或关键点监督。提出了一种名为“camera-multiplex”的相机分布表示,以处理相机视点的不连续和多模态问题。通过在CUB、Pascal 3D和自建数据集上的实验,证明了无监督方法在相机预测方面的优势,展示了在无关键点注释的情况下学习多样3D形状和纹理的能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

499

499

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?