Paper : Hierarchical Graph Representation Learning with Differentiable Pooling

Code :

摘要

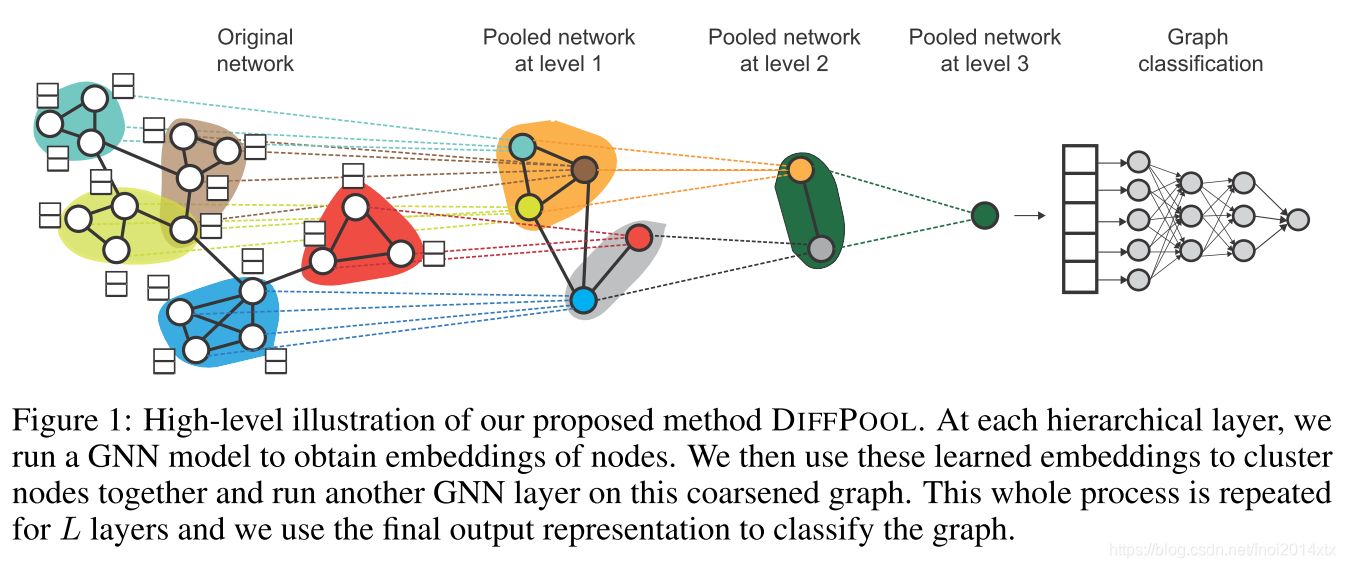

对于Graph Classification 任务来说,GNN的最后一步需要关注图数据的全局信息,既包含图的结构信息,也包含各个节点的属性信息。如果采用一次性全局池化的方法聚合点上的特征表示,并没有将图的结构考虑进去,而且可能在节点重编号后聚合的结果会发生改变,也就是说聚合过程中依赖节点顺序。在CNN模型中,通常采用的做法是通过层次化池化机制来逐渐提取全局信息,作者仿照CNN提出了一种层次化图聚类的方式,支持添加到GNN模型中进行端到端的学习。

每层将该层的节点映射到若干个cluster中,作为下一层输入的节点。

定义

定义图 G G G 表示为 ( A , F ) (A,F) (A,F) ,其中 A ∈ { 0 , 1 } n × n A\in\{0,1\}^{n\times n} A∈{ 0,1}n×n 表示邻接矩阵, F ∈ R n × d F\in \mathbb R^{n\times d} F∈Rn×d 表示节点的特征矩阵。图分类任务定义为学习一个映射 f : G → Y f : \mathcal G \rightarrow \mathcal Y f:G→Y,这需要首先学习图的整体特征表示,即 f ′ : G → R D f' : \mathcal G\rightarrow \mathbb R^{D} f′:G→RD

图神经网络的数学表示为

H ( k ) = M ( A , H ( k − 1 ) ; θ ( k ) ) H^{(k)} = M(A,H^{(k-1)};\theta^{(k)}) H(k)=M(A,H(k−1);θ(k))

其中, H ( k ) ∈ R n × d H^{(k)}\in \mathbb R^{n\times d} H(k)∈Rn×d, H ( 0 ) = F H^{(0)} = F H(0)=F,一种常见的GNN模型表示为

H ( k ) = ReLU ( D ~ − 1 2 A ~ D ~ − 1 2 H ( k − 1 ) W ( k − 1 ) ) H^{(k)} = \text{ReLU}(\widetilde D^{-\frac{1}{2}}\widetilde A\widetilde D^{-\frac{1}{2}}H^{(k-1)}W^{(k-1)}) H(k)=ReLU(D −21

Hierarchical Graph Representation Learning

Hierarchical Graph Representation Learning

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1618

1618

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?