📌 友情提示:

本文内容由银河易创AI(https://ai.eaigx.com)创作平台的gpt-4-turbo模型生成,旨在提供技术参考与灵感启发。文中内容或观点需结合实际情况验证,建议读者通过官方文档或实践进一步确认其准确性。

随着人工智能技术的飞速发展,大语言模型(Large Language Model,LLM)逐渐成为自然语言处理(NLP)领域的核心技术之一。从最早的统计模型到如今的深度学习大规模预训练模型,LLM的演进历程不仅推动了AI研究的进步,也带来了丰富的实际应用。然而,尽管LLM取得了显著成就,其落地实施依然面临着诸多挑战。本文将深入探讨大语言模型的发展历程,并分析其在实际应用中的主要挑战与解决方案。

一、大语言模型的演进

大语言模型的演进历程是人工智能领域的一次深刻变革。以下是大语言模型从诞生到如今的一些关键发展节点。

1. 早期统计语言模型(统计学习时代)

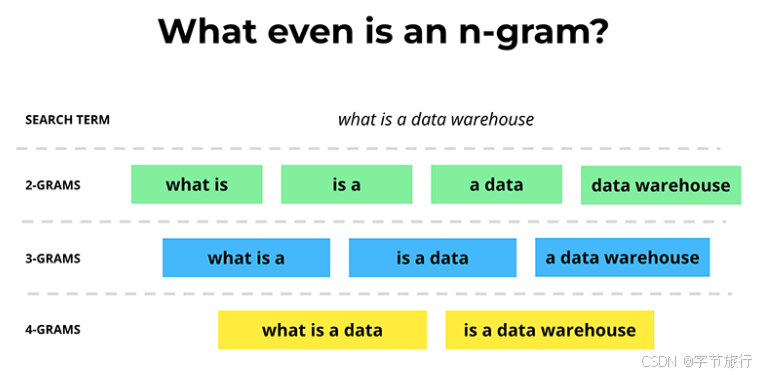

大语言模型的雏形可以追溯到20世纪80年代和90年代的统计语言模型。这些模型主要依赖于词汇的共现统计,运用了如n-gram、最大熵模型(MaxEnt)等算法。尽管这些模型简单,但它们为后来的神经网络模型打下了基础。统计语言模型在当时的机器翻译、语音识别等应用中起到了重要作用。

代表性技术:

- n-gram模型:通过计算词序列的频率来预测下一个词的概率。

- 最大熵模型:通过统计信息和特征工程来建立模型,优化预测结果。

虽然这些方法在当时具备一定的实用性,但其效果远远不如后来的神经网络方法,且缺乏对语言深层次结构的理解。

2. 神经网络模型的兴起(深度学习时代)

进入21世纪后,深度学习的崛起为大语言模型带来了巨大的变革。深度神经网络能够自动学习数据中的复杂模式和表示,极大地提升了语言模型的表现。

代表性技术:

- Word2Vec(2013) :通过训练神经网络,将单词映射到连续向量空间中,从而获得词嵌入(word embeddings)。这种方法解决了统计模型中“词汇稀疏性”的问题,并大幅提升了NLP任务的效果。

- GloVe(2014) :另一种基于矩阵分解的词嵌入方法,通过全局统计信息捕捉单词之间的语义关系。

- Seq2Seq(2014) :基于循环神经网络(RNN)和长短期记忆网络(LSTM)的序列到序列模型,推动了机器翻译等任务的发展。

神经网络通过学习语言的隐含模式,开始能够处理更复杂的NLP任务,但仍存在一定的局限性,例如处理长文本和捕捉语言长程依赖的能力不足。

3. Transformer与自注意力机制(Attention机制)

2017年,Google提出了Transformer模型,标志着大语言模型的又一次飞跃。Transformer采用了全新的自注意力机制(Self-Attention),通过并行计算和长程依赖建模,克服了RNN和LSTM在处理长序列时的局限性。Transformer不仅提升了计算效率,还让大规模并行训练成为可能,极大地推动了深度学习在NLP领域的应用。

代表性技术:

- BERT(2018) :基于Transformer的双向编码器预训练模型,通过大规模的无监督预训练,BERT能捕捉文本中的上下文信息,显著提升了文本分类、命名实体识别等任务的效果。

- GPT系列(2018-2023) :OpenAI提出的生成式预训练模型(Generative Pretrained Transformer),尤其是GPT-3以其1750亿的参数和强大的文本生成能力,成为了大语言模型的代表之一。

GPT系列模型采用了单向自回归方式,通过大规模的预训练,能够在多种NLP任务中展现出卓越的性能。GPT-3被认为是迄今为止最强大的语言模型之一,但其巨大的计算资源需求和训练成本也使得落地应用面临挑战。

4. 大语言模型的商业化与多模态发展(现阶段)

近年来,随着GPT系列的不断更新,BERT、T5等大语言模型的开源和商用化,使得大语言模型的应用进入了一个新的阶段。这些模型不仅能够进行自然语言处理,还开始与计算机视觉、语音识别等多模态技术结合,拓展了应用的广度。

例如,OpenAI的ChatGPT和DALL·E,不仅支持文本生成,还能够生成图片和图像描述,展现了跨领域的强大能力。大语言模型的能力逐渐扩展到代码生成、医学问诊、法律分析等专业领域,甚至能够进行人类语言与机器语言之间的翻译。

二、大语言模型的落地挑战

尽管大语言模型在许多领域展现了惊人的能力,但其商业化落地仍然面临着多方面的挑战。以下是大语言模型落地应用中遇到的一些主要问题:

1. 计算资源与成本

大语言模型的训练和推理需要巨大的计算资源,尤其是像GPT-3这样的模型,其需要数百台高性能计算机和巨量的GPU资源。训练一个类似GPT-3规模的模型,其成本可能高达数百万美元。虽然云计算服务提供商提供了弹性的计算资源,但这依然是小型公司和团队的巨大障碍。

- 解决方案:利用高效的分布式训练和混合精度训练等技术来降低训练成本;此外,随着硬件技术(如TPU、GPU)不断升级,计算成本逐步降低,但仍然需要大规模的基础设施支持。

2. 模型的可解释性和透明度

大语言模型,如GPT-3和BERT,虽然在许多任务中表现优秀,但它们本质上是“黑箱”模型。即使是开发者也很难精确理解其推理过程,尤其是在生成文本时,模型的决策往往不可解释。这给在医疗、法律、金融等高风险领域的应用带来了风险。

- 解决方案:开发可解释AI(XAI)技术,提升模型决策的透明度,例如通过层级可视化、注意力权重分析等方式帮助用户理解模型的决策机制。

3. 数据偏见与伦理问题

大语言模型的训练通常基于海量的互联网数据,这些数据中往往包含了社会的偏见和不公正。当模型在生成文本或决策时,可能会无意中传播种族、性别、文化等方面的偏见,甚至产生有害内容。

- 解决方案:进行数据清洗与去偏处理,确保训练数据的多样性和公正性;同时,增加伦理审查与AI道德框架,确保模型的公平性与无害性。

4. 隐私和安全问题

大语言模型训练需要大量的个人数据,这引发了隐私和安全问题。用户数据可能被滥用,尤其是在社交平台、医疗领域等涉及敏感信息的场景中。与此同时,恶意用户可能利用大语言模型进行钓鱼攻击、虚假信息生成等活动。

- 解决方案:采用差分隐私(Differential Privacy)等技术保护用户数据的隐私;同时,开发基于可信度验证的模型安全性机制,防止模型被用于恶意用途。

5. 领域适应与精细化调优

虽然大语言模型在通用任务中表现优异,但在特定行业或专业领域中,模型的表现仍然存在局限性。例如,在医疗、法律等领域,模型可能无法理解专业术语或行业惯例。

- 解决方案:进行领域适应性训练,通过微调(fine-tuning)技术使模型在特定领域中更加精确,或者利用小模型与大模型相结合的方式,提升专业领域的模型性能。

三、大语言模型的技术实现与优化

大语言模型(LLM)是现代人工智能的基石之一,其核心技术涉及深度学习、自然语言处理(NLP)以及大规模分布式计算等多个领域。在这一部分,我们将深入探讨大语言模型的技术实现细节,包括模型架构、训练方法、优化策略以及常见的技术难题。

1. 模型架构:Transformer与自注意力机制

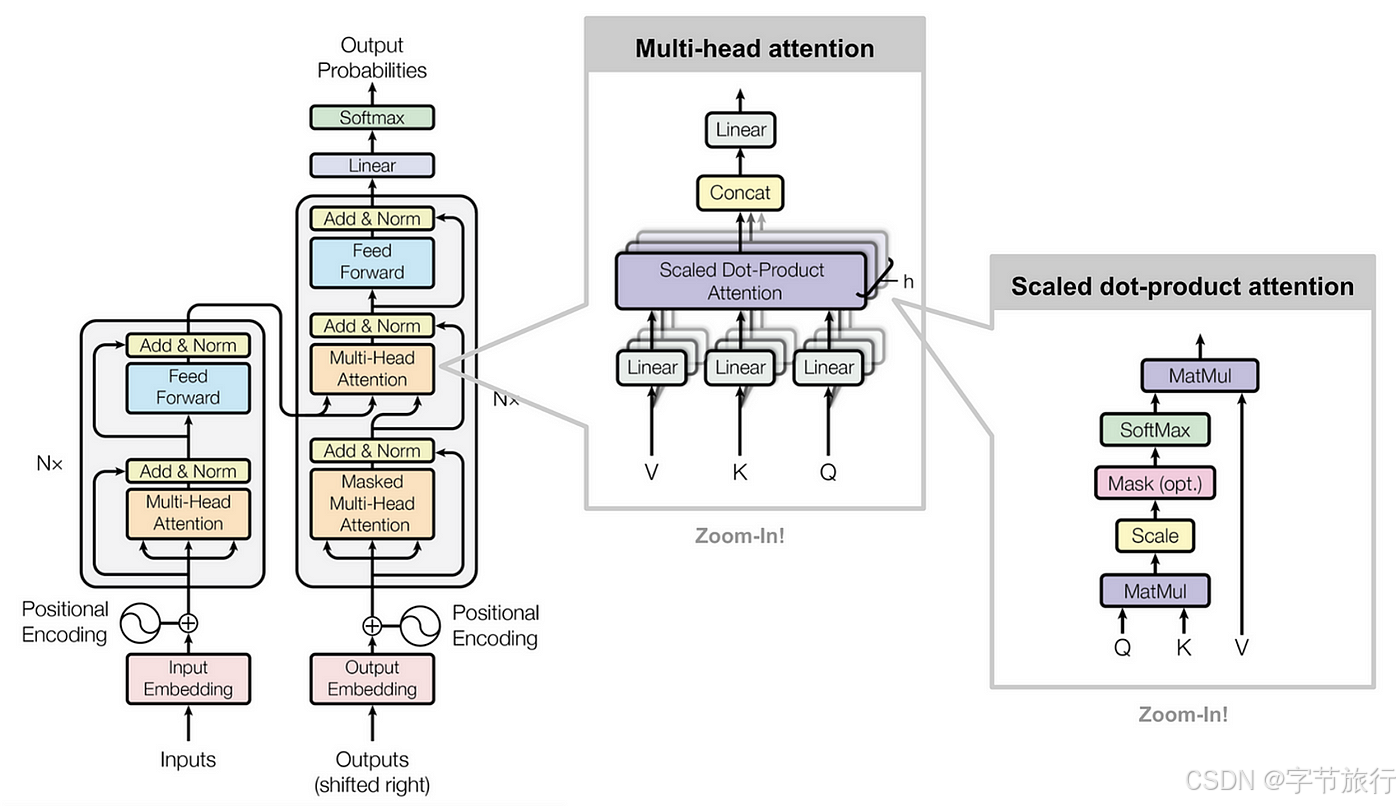

大语言模型的核心技术基础是Transformer架构,它自2017年《Attention is All You Need》一文发表以来,迅速成为NLP领域的标准模型。Transformer架构的核心创新是自注意力机制(Self-Attention),它通过计算词与词之间的关系来捕捉上下文信息,从而能够并行处理整个句子或文档,避免了传统RNN和LSTM在处理长文本时的计算瓶颈。

1.1 自注意力机制

自注意力机制的核心思想是,通过对输入序列中的每个词计算与其它词的“注意力权重”,来动态调整每个词的表示。具体来说,自注意力机制通过以下步骤计算:

- Query(Q)、Key(K)、Value(V) :每个输入词首先通过线性变换得到三个向量,分别表示查询、键和值。

- 计算注意力分数:通过查询向量与所有键向量的点积计算出每个词的注意力分数,然后经过softmax归一化得到权重。

- 加权求和:最终的输出是对所有值向量的加权求和,权重由注意力分数决定。

自注意力机制允许每个词根据其与其他词的关系来调整自己的表示,使得模型能够有效捕捉长程依赖。

1.2 多头注意力机制

为了让模型能够学习不同子空间的信息,Transformer引入了多头注意力机制(Multi-Head Attention)。通过并行计算多个不同的注意力头(Head),每个头可以专注于捕捉不同类型的语义关系,然后将各个头的输出拼接起来,形成最终的表示。这种方式使得模型可以并行处理多种不同的关系和特征,提升了模型的表达能力。

2. 训练方法与预训练-微调策略

大语言模型的训练方法通常采用预训练-微调(Pretraining-Finetuning)策略,尤其是在BERT、GPT等模型中得到了广泛应用。

2.1 预训练阶段

在预训练阶段,模型通常通过大量的无标注文本进行自监督学习,学习语言的基本结构和语法规律。常见的预训练任务包括:

- 掩蔽语言建模(Masked Language Modeling,MLM) :BERT采用了MLM任务,即随机掩盖输入文本中的某些词,模型的目标是预测这些被掩盖的词。

- 自回归语言建模(Autoregressive Language Modeling) :GPT采用自回归语言建模任务,即通过已知的上下文来预测下一个词。

通过这些自监督任务,模型能够捕捉到丰富的语言特征,为下游任务提供强大的预训练知识。

2.2 微调阶段

在微调阶段,预训练模型会在特定的下游任务上进行训练,如文本分类、情感分析、命名实体识别等。微调的过程通常较为高效,因为模型已经在预训练阶段学习了大量的通用语言知识,因此微调时只需较少的标注数据即可获得较好的效果。

- 微调技巧:在微调过程中,常常采用学习率衰减、权重正则化等策略来防止过拟合,提高模型在特定任务中的泛化能力。

3. 模型优化:大规模训练与分布式计算

大语言模型通常包含数十亿甚至数百亿的参数,这使得训练过程需要大量的计算资源和存储。为了解决这一问题,采用了分布式训练和模型并行化等技术。

3.1 分布式训练

大语言模型的训练需要在多个GPU或TPU上进行并行计算。常见的分布式训练技术包括:

- 数据并行(Data Parallelism) :将训练数据划分为多个小批次,分配到不同的计算节点上,每个节点计算自己的梯度并与其他节点同步更新参数。

- 模型并行(Model Parallelism) :当模型过大,单个设备无法加载时,模型的不同部分可以分配到不同的设备上进行计算。

- 混合并行(Hybrid Parallelism) :结合了数据并行和模型并行,适用于极大规模的模型。

例如,GPT-3采用了大规模的分布式训练,通过数百个GPU节点的协同计算,才能在合理的时间内完成训练任务。

3.2 混合精度训练

混合精度训练(Mixed Precision Training)是一种提高训练效率的方法,通过使用16位浮点数(FP16)代替32位浮点数(FP32)来进行训练,能够显著降低内存消耗并提高计算速度,同时在保持训练精度的情况下减少计算资源的消耗。

3.3 梯度累积

由于大语言模型的训练批次通常非常大,直接将所有数据喂入模型会导致显存溢出。为了解决这个问题,采用了梯度累积技术。具体来说,训练过程中会将多个小批次的梯度累积在内存中,直到累积一定数量后再进行一次梯度更新,这样可以有效地降低内存需求。

4. 常见技术难题及解决方案

4.1 内存和计算资源瓶颈

大语言模型通常包含数以亿计的参数,训练和推理过程需要巨大的计算资源。单机训练的能力有限,且随着模型规模的扩大,计算资源的需求呈指数级增长。

- 解决方案:通过分布式训练、混合精度训练、模型量化等技术来减少计算和存储需求。此外,云计算平台和专用硬件(如TPU、GPU)提供了强大的计算支持。

4.2 训练时间长

大规模语言模型的训练时间通常非常长,可能需要数周甚至数月。随着模型规模的增大,训练时间也会成倍增加。

- 解决方案:采用更加高效的优化算法(如AdamW)、分布式训练、预训练阶段使用无标签数据等方法来缩短训练时间。此外,利用更高效的硬件(如TPU、GPU)和并行化技术,能够显著加速训练过程。

4.3 模型的泛化能力

尽管大语言模型在多个NLP任务中表现出色,但它们的泛化能力仍然是一个挑战。由于预训练模型通常是在大规模的通用数据上训练的,它们在特定领域或小样本任务中的表现可能不尽如人意。

- 解决方案:通过领域适应(Domain Adaptation)和微调技术,利用少量的标注数据对模型进行定制化训练,以提升模型在特定任务或行业中的性能。

5. 未来的发展趋势

随着技术的不断进步,大语言模型将继续演进。未来,随着更高效的训练方法、更加优化的模型架构和硬件技术的出现,LLM将能够以更加低廉的成本、更高效的方式服务于各类实际应用。与此同时,如何解决模型的可解释性、降低偏见、提升安全性等问题,仍然是大语言模型未来发展的重要方向。

四、未来展望

尽管大语言模型面临诸多挑战,但它们的潜力依然巨大。随着技术的不断进步,未来大语言模型有可能在更多的领域发挥重要作用,尤其是在跨模态AI、智能代理、自动化编程等方面。此外,随着计算能力的提升和算法的优化,未来的LLM可能会更加高效和普适,能为各行各业带来更多的创新机会。

总的来说,大语言模型的演进和应用仍处于快速发展阶段。随着技术的进步,我们可以期待它在现实世界中的落地和创新应用,推动智能化时代的到来。

3413

3413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?