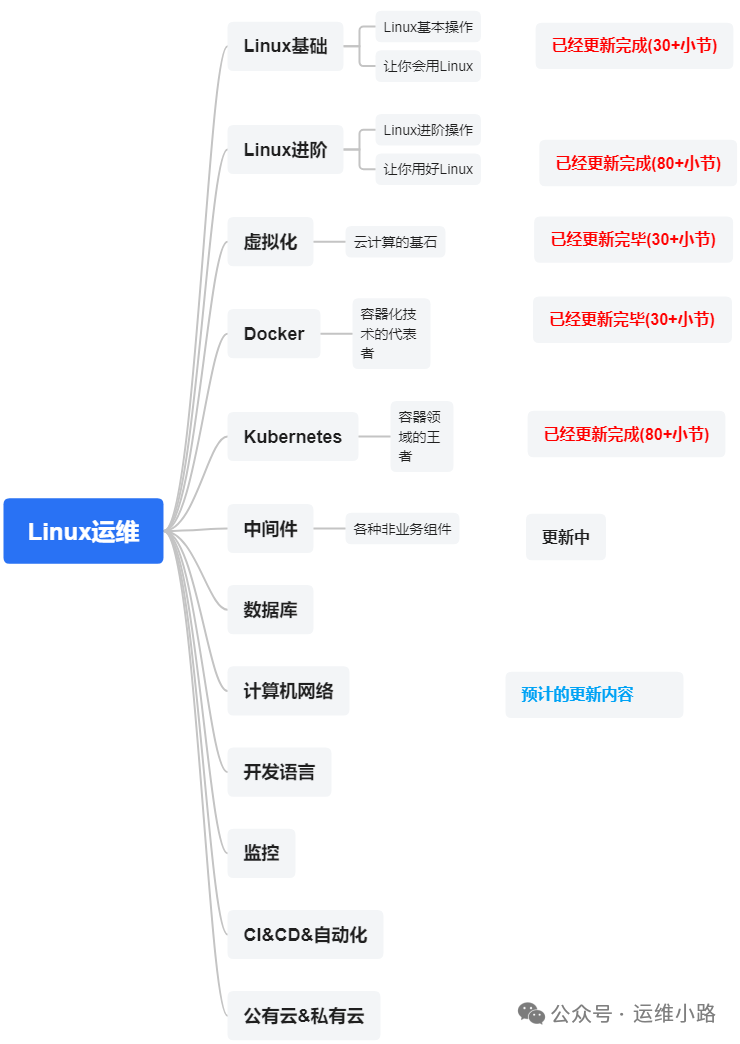

作者介绍:简历上没有一个精通的运维工程师。请点击上方的蓝色《运维小路》关注我,下面的思维导图也是预计更新的内容和当前进度(不定时更新)。

中间件,我给它的定义就是为了实现某系业务功能依赖的软件,包括如下部分:

Kafka(本章节)

在我以前的工作中遇到过多次数据库迁移,如果数据库是一样的,其实相对都是比较简单的。因为基本上都可用利用数据库自身的同步原理就可以实现,但是现实中还有需求就是异构数据库的迁移。就好比Oracle到MYSQL,当然这里我为了简单,我这里用了简单的MYSQL迁移到PG。

原理

生产者从MYSQL读取数据,然后写入Kafka集群。

消费者从Kafka里面消费数据,然后写入PG数据库。

环境准备

一个MYSQL数据库,里面有一个库,一个表,表里面有部分数据。

一个PG数据库,里面已经提前创建了和MYSQL同样的库表(无数据)。

一个Kafka集群。

实施

生产者

生产者代码,这里为了省事,把数据库信息和Kafka信息都直接写在代码里面,由于临时测试,甚至没有手工创建Topic。以下代码使用DeepSeek生成。

# mysql_to_kafka_producer.py

import json

import time

from mysql.connector import connect

from kafka import KafkaProducer

class MysqlKafkaProducer:

def __init__(self):

# ========== 硬编码配置 ==========

self.mysql_config = {

'host': 'localhost',

'user': 'root',

'password': '@Cc123456',

'database': 'testdb'

}

self.kafka_config = {

'bootstrap_servers': ['192.168.31.143:9092'],

'topic': 'user-migration-topic'

}

# ========== 初始化连接 ==========

self.mysql_conn = connect(**self.mysql_config)

self.producer = KafkaProducer(

bootstrap_servers=self.kafka_config['bootstrap_servers'],

value_serializer=lambda v: json.dumps(v).encode('utf-8'),

acks=1,

retries=3

)

self.last_id = 0

def _load_offset(self):

"""简单模拟断点记录"""

try:

with open('last_id.txt', 'r') as f:

self.last_id = int(f.read().strip())

except:

pass

def _save_offset(self):

with open('last_id.txt', 'w') as f:

f.write(str(self.last_id))

def run(self):

self._load_offset()

cursor = self.mysql_conn.cursor(dictionary=True)

try:

while True:

cursor.execute('''

SELECT id, username, email, age,

created_at, updated_at

FROM users

WHERE id > %s

ORDER BY id

LIMIT 100

''', (self.last_id,))

batch = cursor.fetchall()

if not batch:

print("-[INFO]- 没有新数据,等待10秒...")

time.sleep(10)

continue

for record in batch:

# 转换时间格式

record['created_at'] = record['created_at'].isoformat()

record['updated_at'] = record['updated_at'].isoformat()

self.producer.send(

topic=self.kafka_config['topic'],

key=str(record['id']).encode(),

value=record

)

self.last_id = record['id']

self.producer.flush()

self._save_offset()

print(f"-已同步至ID: {self.last_id}-")

finally:

cursor.close()

self.mysql_conn.close()

self.producer.close()

if __name__ == '__main__':

print(">>> 启动MySQL到Kafka的生产者 <<<")

MysqlKafkaProducer().run()#Kafka日志 显示创建Topic数据

[2025-05-25 00:11:56,271] INFO Creating topic user-migration-topic with configuration {} and initial partition assignment HashMap(0 -> ArrayBuffer(0)) (kafka.zk.AdminZkClient)

[2025-05-25 00:11:56,383] INFO [ReplicaFetcherManager on broker 0] Removed fetcher for partitions Set(user-migration-topic-0) (kafka.server.ReplicaFetcherManager)

[2025-05-25 00:11:56,391] INFO [Log partition=user-migration-topic-0, dir=/tmp/kafka-logs] Loading producer state till offset 0 with message format version 2 (kafka.log.Log)

[2025-05-25 00:11:56,394] INFO Created log for partition user-migration-topic-0 in /tmp/kafka-logs/user-migration-topic-0 with properties {} (kafka.log.LogManager)

[2025-05-25 00:11:56,395] INFO [Partition user-migration-topic-0 broker=0] No checkpointed highwatermark is found for partition user-migration-topic-0 (kafka.cluster.Partition)

[2025-05-25 00:11:56,395] INFO [Partition user-migration-topic-0 broker=0] Log loaded for partition user-migration-topic-0 with initial high watermark 0 (kafka.cluster.Partition)运行程序就会开始读取数据到Kafka。当然这里有很多坑,如果只是为了演示是没有问题的。

[root@localhost ~]# python3 prod.py

>>> 启动MySQL到Kafka的生产者 <<<

-已同步至ID: 100-

-[INFO]- 没有新数据,等待10秒...

-[INFO]- 没有新数据,等待10秒...

-[INFO]- 没有新数据,等待10秒...

消费者

消费者代码,从Kafka里面的Topic数据,然后写入本地的PG数据库。以下代码基于通义生成(我都是几个AI混合到一起用)。

import json

import time

import psycopg2

from kafka import KafkaConsumer

from datetime import datetime

from dateutil import parser # 新增日期解析库

class KafkaPostgresConsumer:

def __init__(self):

# ========== 硬编码配置 ==========

self.kafka_config = {

'bootstrap_servers': ['192.168.31.143:9092'],

'topic': 'user-migration-topic',

'group_id': 'user-migration-group1'

}

self.pg_config = {

'host': 'localhost',

'port': 5432,

'user': 'postgres',

'password': 'your_pg_password',

'database': 'migration_db'

}

# ========== 初始化连接 ==========

self.consumer = KafkaConsumer(

self.kafka_config['topic'],

bootstrap_servers=self.kafka_config['bootstrap_servers'],

group_id=self.kafka_config['group_id'],

auto_offset_reset='earliest', # 从最早的消息开始消费

enable_auto_commit=False, # 手动提交偏移量

value_deserializer=lambda v: json.loads(v.decode('utf-8'))

)

self.pg_conn = psycopg2.connect(**self.pg_config)

self.pg_cursor = self.pg_conn.cursor()

# 创建目标表(如果不存在)

self._create_table()

def _create_table(self):

"""确保目标表存在"""

create_table_sql = """

CREATE TABLE IF NOT EXISTS users (

id INTEGER PRIMARY KEY,

username VARCHAR(50) NOT NULL,

email VARCHAR(100) UNIQUE NOT NULL,

age INTEGER,

created_at TIMESTAMP NOT NULL,

updated_at TIMESTAMP NOT NULL,

kafka_consumed_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP

)

"""

try:

self.pg_cursor.execute(create_table_sql)

self.pg_conn.commit()

print("-目标表已创建/验证-")

except Exception as e:

print(f"! 创建表失败: {str(e)} !")

self.pg_conn.rollback()

def _insert_or_update_record(self, record):

"""插入或更新PG记录(UPSERT操作)"""

upsert_sql = """

INSERT INTO users (id, username, email, age, created_at, updated_at)

VALUES (%s, %s, %s, %s, %s, %s)

ON CONFLICT (id) DO UPDATE

SET

username = EXCLUDED.username,

email = EXCLUDED.email,

age = EXCLUDED.age,

updated_at = EXCLUDED.updated_at

"""

try:

# 使用 dateutil 解析 ISO 格式日期(兼容 Python 3.6)

created_at = parser.isoparse(record['created_at'])

updated_at = parser.isoparse(record['updated_at'])

self.pg_cursor.execute(upsert_sql, (

record['id'],

record['username'],

record['email'],

record['age'],

created_at,

updated_at

))

return True

except Exception as e:

print(f"! 处理记录失败 (ID: {record.get('id', 'N/A')}): {str(e)} !")

self.pg_conn.rollback()

return False

def run(self):

"""主循环:从Kafka消费并写入PostgreSQL"""

print(f"-开始消费主题: {self.kafka_config['topic']}-")

processed_count = 0

batch_size = 100 # 每处理多少条记录后提交一次

try:

while True:

# 使用轮询方式获取消息(非阻塞)

batch = self.consumer.poll(timeout_ms=5000, max_records=batch_size)

if not batch:

print("-[INFO]- 等待新数据中...")

time.sleep(2)

continue

for tp, messages in batch.items():

for message in messages:

record = message.value

if self._insert_or_update_record(record):

processed_count += 1

# 手动提交偏移量(处理完一个分区批次后)

self.consumer.commit()

# 定期提交事务(每批处理完)

self.pg_conn.commit()

print(f"-已处理 {processed_count} 条记录,最后ID: {record['id']}-")

processed_count = 0 # 重置计数器

except KeyboardInterrupt:

print("\n-用户中断,退出程序-")

except Exception as e:

print(f"! 发生错误: {str(e)} !")

finally:

# 确保最后提交

self.pg_conn.commit()

# 清理资源

self.consumer.close()

self.pg_cursor.close()

self.pg_conn.close()

print("-资源已释放-")

if __name__ == '__main__':

print(">>> 启动 Kafka 到 PostgreSQL 数据同步消费者 <<<")

try:

KafkaPostgresConsumer().run()

except Exception as e:

print(f"!! 启动失败: {str(e)} !!")启动消费者

[root@localhost ~]# python3 cour.py

>>> 启动 Kafka 到 PostgreSQL 数据同步消费者 <<<

-目标表已创建/验证-

-开始消费主题: user-migration-topic-

-已处理 100 条记录,最后ID: 300-

-[INFO]- 等待新数据中...

-[INFO]- 等待新数据中...

-[INFO]- 等待新数据中...本次演示只是为大家提供Kafka的解决问题的思路。

运维小路

一个不会开发的运维!一个要学开发的运维!一个学不会开发的运维!欢迎大家骚扰的运维!

关注微信公众号《运维小路》获取更多内容。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?