大家好,我是编程乐趣。

DeepSeek大火,网络上也看到很多人分享本地部署心得。但想要更细了解,还是要自己本地部署一次。

我这次部署目标,就是在局域网服务器部署,并让局域网其他电脑可以直接访问。

选择方案也是当前非常流行的:Ollma+Page Assist浏览器插件。

一、安装Ollama

Ollama作为本地部署大模型的方案,还是非常不错的。

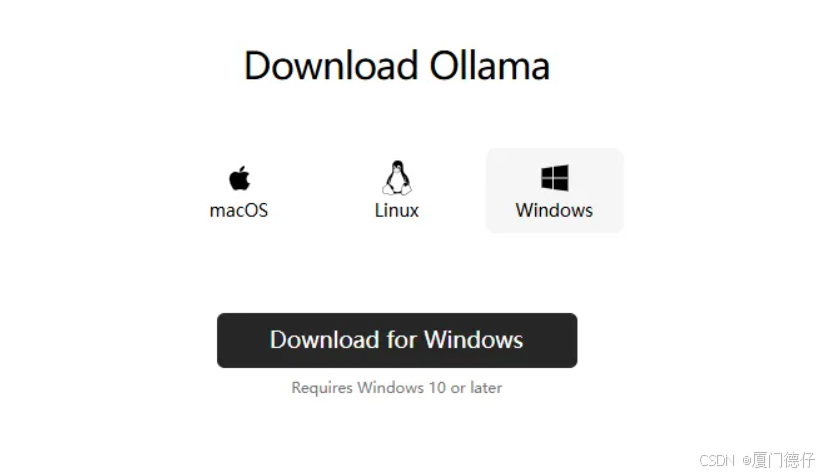

1、跨平台:支持 macOS、Linux 和 Windows。

2、市面主流开源模型都支持:包括Llama 3.3, DeepSeek-R1, Phi-4, Gemma 2等54个开源模型。

3、REST API:Ollama提供对外API能力,想要自己开发客户端、或者集成到应用系统都是非常方便的。

4、生态完善:众多开源Web项目、开源桌面软件支持Ollama,还有终端工具、移动应用、开发工具库等开源项目。

下载地址:https://ollama.com/download

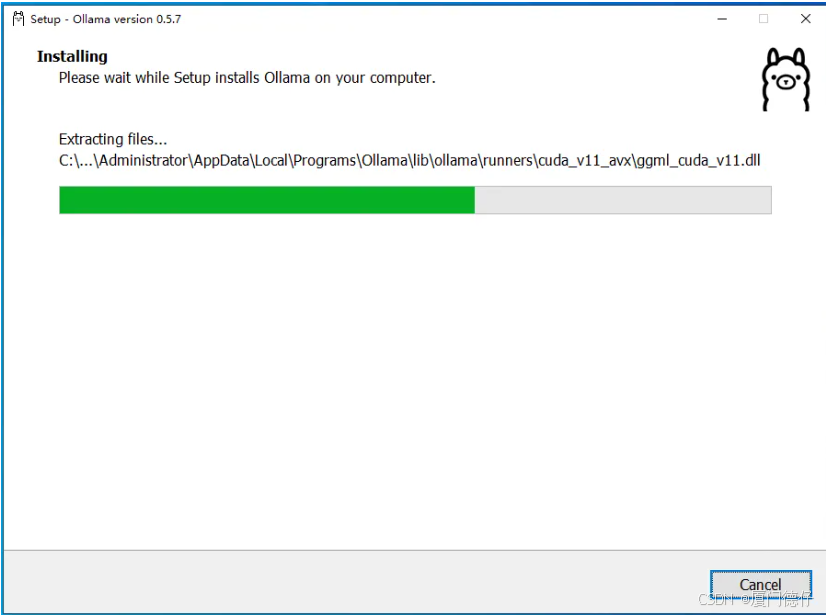

安装Ollama还是比较简单的,下载安装包后,直接安装就行。我这边选择的是Windows版本。

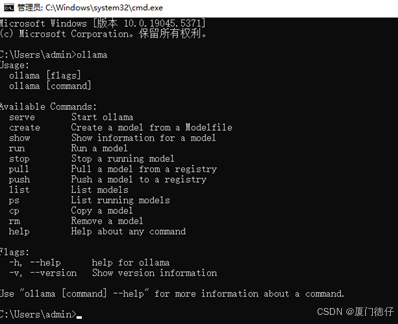

然后输入:ollama ,显示有很多可选命令表示安装成功了

二、修改Ollama默认配置

Ollama安装后,我们还需要根据需求修改对应的配置。

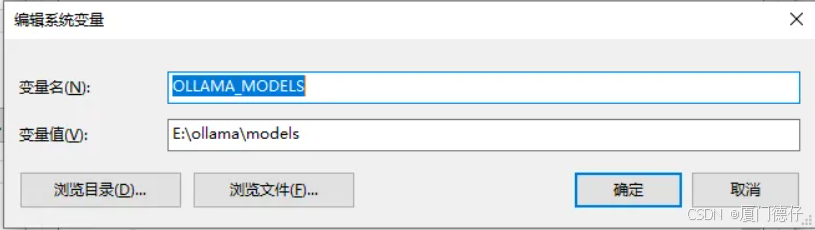

我们使用Ollama时,需要从网络下载大模型,默认存储在C盘,很容易导致C盘空间不足。

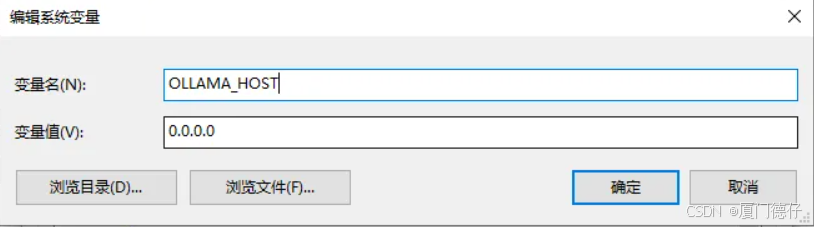

可以通过修改系统环境变量,来修改配置。

添加环境变量:OLLAMA_MODELS,并指定模型路径。

添加环境变量:OLLAMA_HOST,并允许外部访问,这边填写:0.0.0.0,代表允许任何电脑访问。

修改配置后,记得重启Ollama。

我暂时就需要这两个,其他更多配置信息,大家可以查看官方文档:

https://github.com/ollama/ollama/tree/main/docs

三、下载并安装模型

Ollama支持模型非常多,我们这边选择

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5097

5097

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?