摘要

由于计算和内存成本有限,现有的包含完整图数据的图神经网络无法扩展。因此,在大规模图数据中捕获丰富的信息仍然是一个巨大的挑战。对于无监督的网络嵌入方法,它们过分强调了节点的接近性,其学习到的表示几乎不能直接应用于下游的应用程序任务。近年来,新兴的自我监督学习为解决上述问题提供了一个潜在的解决方案。然而,现有的自监督工作也适用于完整的图数据,在定义基于互信息的损失项时,它偏向于适应全局或非常局部的(1跳邻域)图结构。

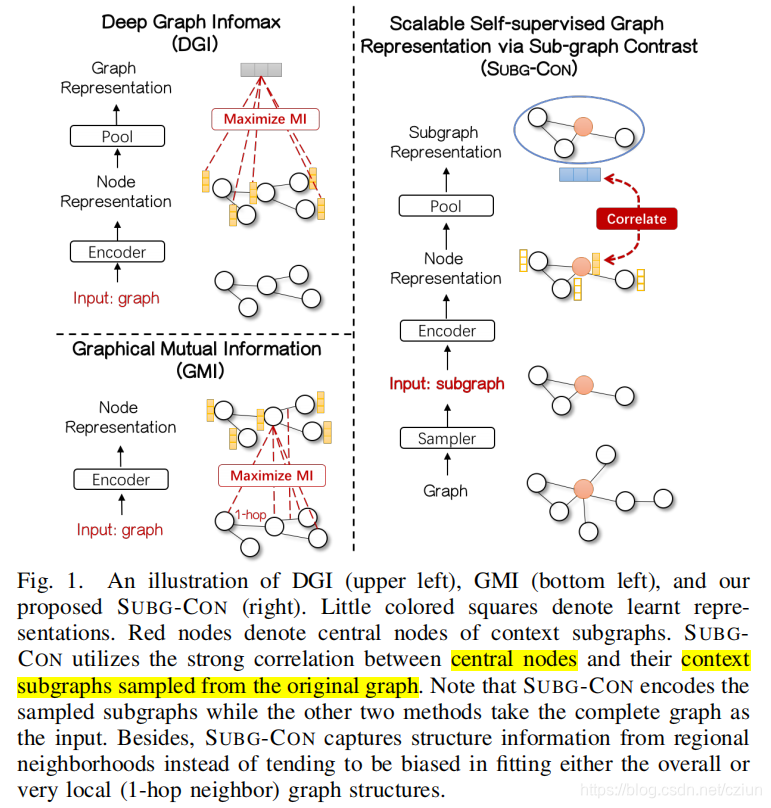

本文提出了一种新的基于子图对比度的自监督表示学习方法,即SUBG-CON,利用中心节点与其采样子图之间的强相关性来获取区域结构信息。SUBG-CON不是学习完整的输入图数据,而是使用一种新的数据增强策略,通过基于从原始图中采样的子图定义的对比损失来学习节点表示。

与现有的图表示学习方法相比,SUBG-CON在监督需求较弱、模型学习可扩展性和并行化方面具有显著的性能优势。在来自不同领域的多个真实世界的大规模基准数据集上,与经典的和最先进的图表示学习方法相比,大量的实验验证了我们的工作的有效性和有效性。

1 引言

直观地说,节点和它们的区域邻居更相关,而其他非常远的节点几乎不影响它们,特别是在大规模图中。因此,由区域邻居组成的子图在为节点表示学习提供结构上下文方面起着关键作用。

SUBG-CON考虑了中心节点与其区域子图(包括直接邻居和其他更远的节点)之间的强相关性,如图1所示。

更具体地说,我们首先引入了一种基于子图采样的图数据增强策略。将中心节点及其密切相关的周围节点从原始图中采样,组成上下文子图。然后,将这些子图输入GNN编码器,获得中心节点的表示,池化后得到子图的表示。最后,在潜在空间中引入对比损失,训练编码器区分生成的正样本和负样本(稍后引入),以便充分区分具有不同区域结构的节点。

与之前在完整的图结构上运行的方法相比,SUBG-CON可以在较低的时间和空间成本下,以较小的大小和较简单的结构捕获上下文子图中的区域信息。此外,基于采样的子图实例,SUBG-CON易于并行化,这对于大型图数据至关重要。

2 方法

2.1 基于子图的自监督表示学习

G = { X , A } \mathcal{G}=\{\pmb{X},\pmb{A}\} G={ XXX,AAA}

特征矩阵: X = { x 1 , x 2 , . . . , x N } \pmb{X}=\{\pmb{x}_1,\pmb{x}_2,...,\pmb{x}_N\} XXX={ xxx1,xxx2,...,xxxN}, N N N是图中的节点数, x i ∈ R F \pmb{x}_i∈\mathbb{R}^F xxxi∈RF表示节点 i i i的 F F F维特征向量。

邻接矩阵: A ∈ R N × N \pmb{A}∈\mathbb{R}^{N×N} AAA∈RN×N,本文假设图是未加权的。

对于中心节点 i i i,设计了一个子图采样器 S \mathcal{S} S,即数据增强的代理,从原始图中提取其上下文子图 X i ∈ R N ′ × F \pmb{X}_i∈\mathbb{R}^{N'×F} XXXi∈RN

本文提出了一种新的自监督图表示学习方法SUBG-CON,利用子图采样和对比学习策略,针对大规模图数据的效率与模型扩展性问题。通过上下文子图的抽取、编码和对比损失优化,SUBG-CON在保持低时空成本的同时,提升了节点表示的有效性。实验证明,SUBG-CON在多个领域基准上优于经典和先进方法,显示出良好的性能和可扩展性。

本文提出了一种新的自监督图表示学习方法SUBG-CON,利用子图采样和对比学习策略,针对大规模图数据的效率与模型扩展性问题。通过上下文子图的抽取、编码和对比损失优化,SUBG-CON在保持低时空成本的同时,提升了节点表示的有效性。实验证明,SUBG-CON在多个领域基准上优于经典和先进方法,显示出良好的性能和可扩展性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1279

1279

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?