大语言模型LLMBook

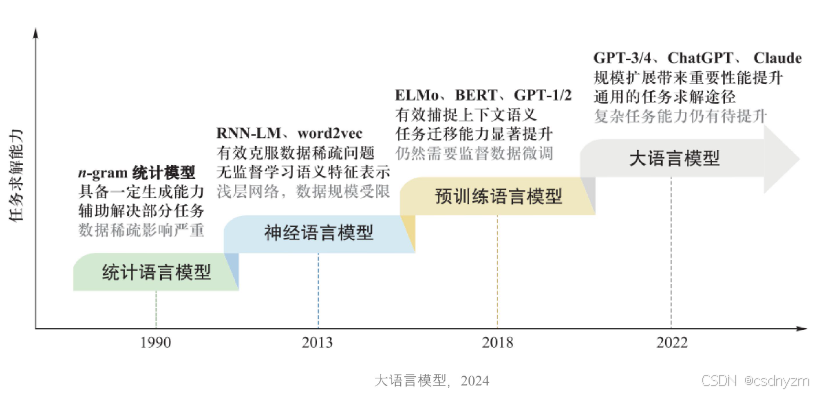

1.1语言模型发展历程

1 统一语言模型SLM

- n-gram语言模型:基于马尔科夫链假设

- 求解参数 最大似然估计

- Laplace smoothing:解决样本中没有出现词对的问题

- back-off:当n元语言不存在下个预测,可以退成更低阶元语言模型

- interpolation:可以混合不同阶数的语言模型

建模自然语言文本生成概率的模型

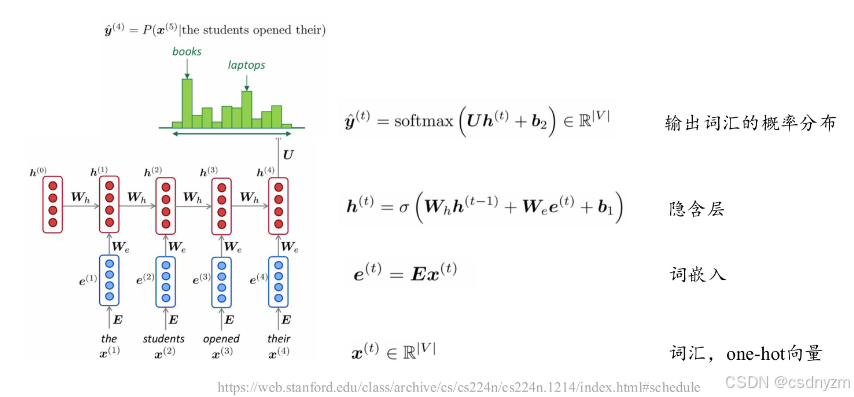

2 神经语言模型NLM

-

RNN:上一个的输出和本个词向量同作为输入传入

-

Word2Vec:实现了词向量的高维稀疏到低维稠密

- CBOW:周围词汇影响目标词义

- Skip-gram:目标词义影响周围词义

3 预训练语言模型PLM

- 大量语料的无监督学习

- 自回归GPT、GPT2

- 自编码BERT、RoBERT

4 大语言模型

- 大参数:百亿、千亿甚至万亿,最低也是十亿

- 大数据:数据数量和质量决定了模型的能力

- 大算力:大参数和大数据决定了必然会用到大算力

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?