目录

前言

1. 何为文心千帆

2. 核心亮点

2.1 第三方大模型

2.2 Prompt模板

2.3 安全可靠

3. 一站式服务

3.1 数据管理

3.2 数据标注

3.3 数据处理

3.4 数据训练

3.5 模型纳管

3.5.1 模型评估

3.5.2 模型压缩

3.6 服务发布

总结

前言

众多AI大模型不断涌现,一时不知如何挑选,畏惧尝试又期盼适配自身产品。

算法、算力、数据等参数常用于评判的标准。放眼大部分产品,平台所具备的算力、服务企业的能力以及技术的丰富度,文心千帆即为首选,有着文心一言的优质大模型以及主流的第三方开源大模型(预测服务、Prompt工程),庞大的客户量,运维已久的数据量。

技术丰富、一站式服务、生态化建设等成就文心千帆的可视化AI平台,每一次的更新迭代可以说都带来诸多亮点,这一次带来了两大亮点:

- 第三方大模型:支持更多主流的开源大模型,目前达到33个(此次迭代新增Llama2模型,后续融入更多开源大模型)。

- prompt模板库:帮助开发者更好的调用,称得上国内最多最全的模板库。

通过文心千帆服务体验申请(

https://cloud.baidu.com/survey/qianfan.html)的官网地址申请公测权限,填写基本信息之后,工作人员会在三小时内进行审核。

1. 何为文心千帆

文心千帆大模型平台是面向企业开发者的一站式大模型开发及服务运行平台。数据管理、自动化模型SFT以及推理服务云端部署一站式大模型定制服务,助力各行业的生成式AI应用需求落地。

该平台的功能和生态非常丰富,涵盖了数据管理、模型训练、模型评估等多个方面,这为开发者提供了强大的工具和资源,让更多开发者可以轻松应用大模型技术,专注自身开发的能力。

结合自身经验之谈,谈谈我对文心千帆整体功能的理解:

- 数据管理:一站式服务,以可视化界面进行展示,让开发者更好的理解其魅力。

- 模型训练:训练自身的应用场景模型,并根据自身需求和数据特定进行优化。

- 模型评估:模型评估可让开发者选择合适的模型,模型压缩可让成本和效率都达到优化。

- 第三方大模型:为开发者提供更多模型选择,根据自身需求构建个性化应用,极大方便开发者的创作需求。

诸多底层技术的支撑,让训练与推理性能大幅提升,千亿模型分布式并行训练加速能力和算力利用率大幅提升,加快快速应用编排,逐渐变成一个超级系统。

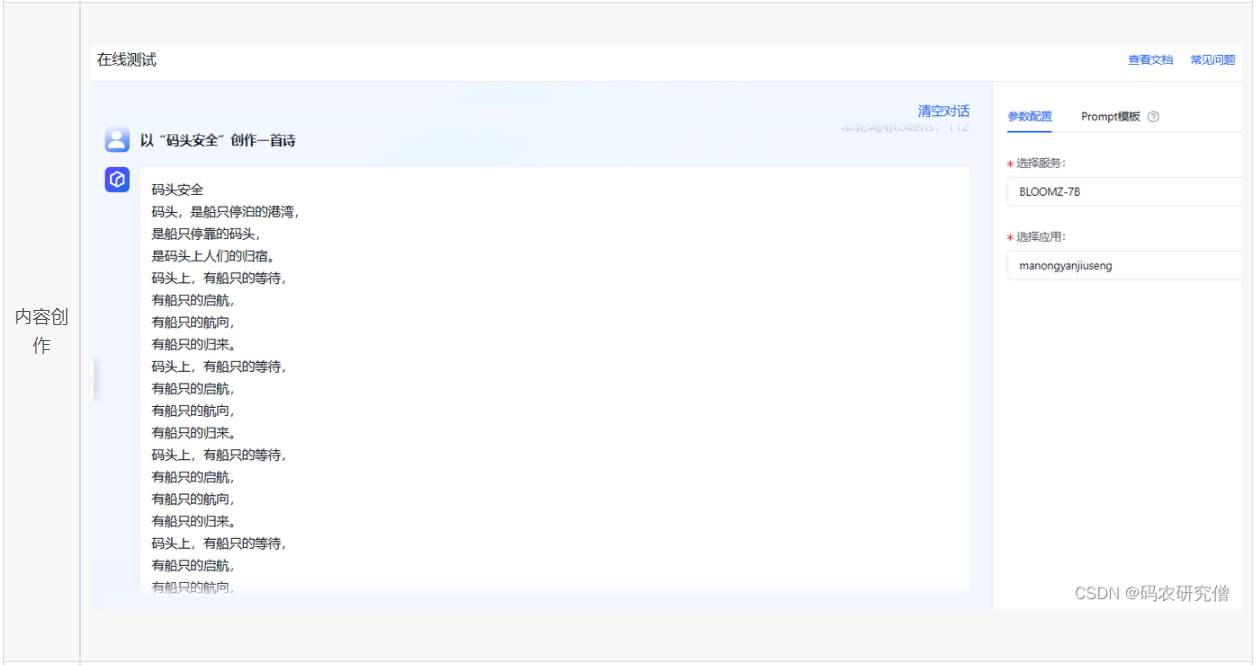

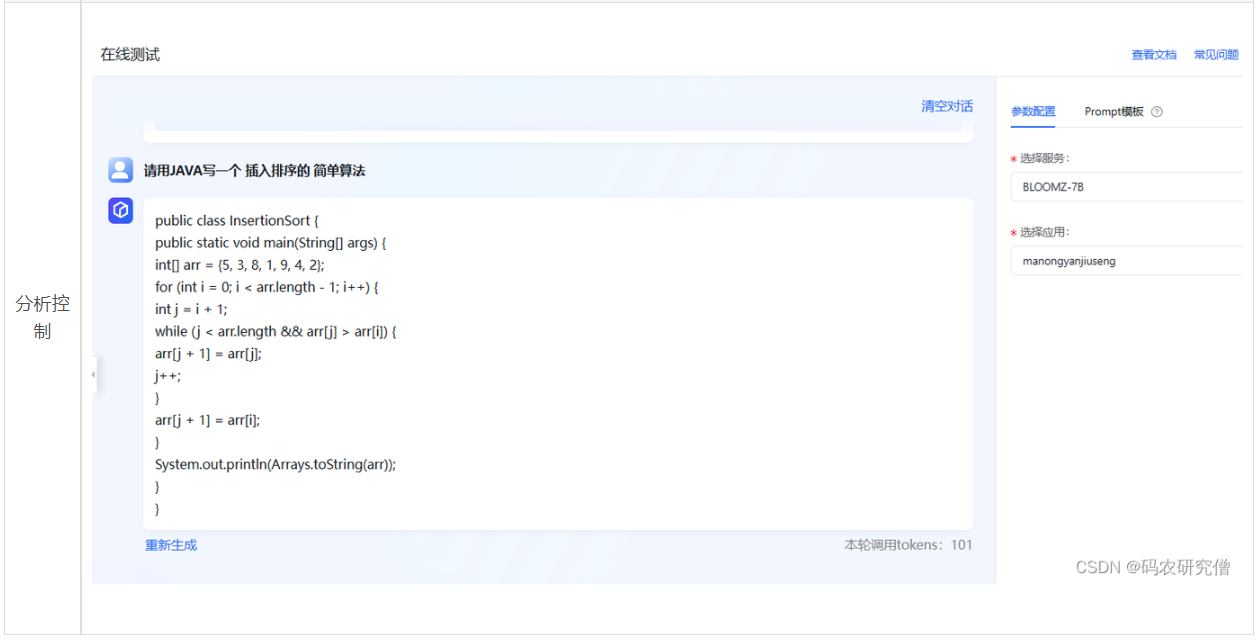

面向不同的企业需求,文心千帆提供不同的功能服务,通过文心一言企业级推理云服务,并进行业务集成。其平台适用于对话沟通、内容创作、分析控制等业务场景,特别是工业级别的场景中,本身百度拥有几十年的搜索引擎,在数据层面的提炼已经精湛高超。

选择的服务不同,AI回复的示例会有所差距,快来体验下吧!!!

2. 核心亮点

这一次的更新迭代,可以看到文心千帆的界面增加了一些组件,特别是第三方大模型、Prompt工程。整体一番体验下来,感触非常深,毕竟有大厂先迈出先例,这是为开发者谋福利。

第三方大模型有多种模型种类,且提供多种API接口,涵盖广泛的功能和应用场景,为开发者提供丰富的选择和灵活性,目前已达到33个。

Prompt模板是目前国内最全的模板,拥有103个,覆盖了大部分的场景,这极大降低大模型的门槛。

2.1 第三方大模型

文心千帆提供了一定的大模型种类,涵盖了多种功能和应用场景,针对不同的需求,可以选择相应的API接口来满足任务的要求。每种接口在可视化的平台都有相应的注释说明,极大降低开发者门槛。

结合自身的经验,给出主流的API接口应用场景:

- ERNIE-Bot和ERNIE-Bot-turbo:覆盖海量中文数据,具有更强的对话问答、内容创作生成等能力。ERNIE-Bot-turbo有更高的响应速度,可应用在实时性比较高的应用场景。

- BLOOMZ-7B:支持多语言,广泛应用于跨语言的文本处理任务。

- Embedding-V1:适用于文本搜索、信息推荐、知识挖掘等场景。

- Prompt:模板包含多种任务和应用场景,对于开发者来说可以获得有价值的资源(文心千帆的一大亮点!)。

- Llama2:适用于编码、推理应用场景,目前也延伸出比较多的版本(Llama-2-7b-chat为高性能版本,Llama-2-13b-chat为性能与效果均衡版本,Llama-2-70b-chat为高精度效果版本)。

为了测试其接口的有效性,服务是否鉴权。简单做了一个小测试,在左侧栏目创建应用之后,通过API接口进行调用,获取对应的access_token。调用接口的示例代码,平台也为开发者一键提供示例:示例代码。

平台的扩展性极强,不仅支持定制模型接口,而且接口调用成功之后,其代码终端会有显示调用结果,其可视化界面有每个接口被调用的次数。这让更多开发者只需专注自身的开发功能,而不用在意大模型平台的功能。

单看这一次的更新,增添了Llama2模型与API接口,可见文心千帆平台的快速更新迭代,逐渐支持更多第三方主流开源大模型,这是一个非常值得关注的点,为开发者提供更多的关注和挑战,有助于推动AI技术的发展和应用。

其大模型的种类涵盖对话问答、内容创作、多语言处理、文本搜索和知识挖掘等多个领域,更好的为数据进行训练。再者通过对这些接口的灵活应用,开发者可以实现各种AI应用需求的落地和创新。

2.2 Prompt模板

之所以说Prompt模板是文心千帆的一大亮点,是因为他拥有国内最多最全的Prompt模板,且种类齐全。我们都知道在自然语言生成(NLG)任务中,更优质、更准确的Prompt能够帮助模型生成更具连贯性和准确性的文本。这足以证明文心千帆在这一方面花了很大的功夫。

大模型会基于prompt所提供的信息,生成对应的文本或者图片。

之后通过左侧栏目的在线测试调用Prompt模板,检验其是否可靠正确。

为了做一个简单的对比,将没有Prompt模板与Prompt模板的生成内容进行比较,发现有Prompt模板生成的token数据,逻辑流畅,有理有据,而没有Prompt模板的言简意赅甚至过于简易。

我们深度剖析该Prompt模板的内容。

我希望你充当一个电影评论家。你将编写一篇引人入胜和有创意的影评。你可以涵盖诸如情节、主题和基调、演技和角色、方向、配乐、电影摄影、制作设计、特效、剪辑、节奏、对话等主题。但最重要的方面是强调电影给你的感觉。什么是真正引起你的共鸣。你也可以对电影进行批评。请避免剧透。电影名称是{content}

证实Prompt模板均符合如下特征:

- 正确的语法、用词以及标点。

- 避免歧义,简洁易懂。

- 拥有更完整的信息。

总的来说,其Prompt模板拥有如下功能:

- 支持定义模板后在在线服务-在线测试器中快速使用

- 通过Prompt模板的云服务调用获取模板

单看可视化界面,整体排版格局清爽,以标签的方式进行搜索,也可以名称的方式搜索,这极大降低AI入门槛。

2.3 安全可靠

该平台在安全方面采取多种措施,提供丰富的功能性和灵活性,对于开发者来说这是一个值得信赖的平台。同时,安全措施本身为客户和开发者提供安全可信的体验。

其多重保障主要通过文心一言企业级服务、百度智能云安全控制机制以及文心底层内容安全功能。(对推理内容进行审核与敏感词过滤,确保安全可信。)

- 完善的鉴权与流控安全机制:预防未授权的访问和防范滥用。

- 自带敏感词过滤、增强审核安全:过滤不当内容,确保内容的质量和安全性。

3. 一站式服务

百度文心大平台的完整流程包括数据导入、数据标注、训练配置、模型纳管、服务发布以及在线测试。可视化的界面以及组件很好的诠释零门槛入门AI,从零开始构建数据集、模型训练以及部署。

为了将其整套流程串通,创建属于自身的数据集并进行模型训练,以下步骤中融入了自身的体会。

3.1 数据管理

通过如下界面创建自身的数据集,针对每种数据集,可视化平台都加上注释,方便更多零门槛的人员步入这个平台。该数据集有两种标注类型,分别为文本对话以及query问题集。

注意事项:如果当前数据小于32条,无法启动训练,可视化界面会进行提示,可通过数据补充或者数据处理。

整体一番体验下来,无标注的信息支持多种数据格式,平台的设计达到人性化。

3.2 数据标注

可视化平台进行在线标注以及修改标注,可以说很人性化,无需在专门的格式文件修改再二次上传,这不仅方便开发者,也足以说明该平台的超级系统。

3.3 数据处理

数据清洗和数据增强是非常主要的步骤,极大影响开发者的内容创作。

我们先看平台对于这两功能的可视化界面:

- 数据清洗:提升内容质量,降低噪音干扰,增强数据的适应性,也提高模型的泛化性。

- 数据增强:对数据集进行扩充,提高模型的泛化能力。

总的来说,平台对内容创作的数据处理考虑很周全。后续开发者也可反馈需要处理的选项,这也是开发者与平台的双向增益。

3.4 数据训练

文心千帆为开发者提供了强大的工具和资源,合理利用平台的资源可以充分发挥该模型以及数据的优势,为自身的创作内容带来极大的助力。单看其可视化界面可以看到选项以及功能都非常丰富。

发布成功数据之后,通过平台提供的预训练大模型进行配置参数。创建任务并调整训练配置,其中各个参数都在可视化的界面中进行注释,这极大降低AI开发门槛。

我们都知道模型的训练,训练集和测试集都有一定的比例分配。在可视化的平台中,只需配置数据的来源以及比例,平台即可一键分配。

比如如下界面,设置比例20,则表示选定数据集版本总数的80%作为训练集,20%作为验证集。

使用SFT进行训练,训练结束之后可看到模型的评估报告以及训练日志。

模型调优之后,可将模型进行发布。

总的来说,整体界面功能组件都很齐全,完美适配大模型的训练、多领域的应用,多语言的支持。作为大平台模型训练,后续模型的更新迭代,极大适应不断变化的市场需求和技术发展。

3.5 模型纳管

模型仓库中的模型评估、模型压缩为开发者提供了一套完整的模型管理工具,有利于优化模型的性能和效果,并支持模型的迭代和优化。

可以看到如下界面,每个模型都可新增版本进行管理,其任务列表中展示了模型不同版本、各类任务的记录。

3.5.1 模型评估

模型评估可以帮助开发者了解生成的大模型性能表现,支持模型之间的对比和选择,提高内容创作和服务的质量。(目前文心千帆仅支持对基础模型为BLOOMZ-7B的模型进行评估,后续会持续更新)。

在该平台中,需要注意的是,模型评估的时间和数据集量是成正比的,虽然模型评估时间会随着数据集增加而增加,但较小的数据集会导致模型评估报告失效,因为无法反映模型的真实性能。

在图例下方还有错例分析,展示BLUE-4指标较低的样本,以便用户针对性分析和迭代模型。

为避免对页面性能造成影响,每个模型最多展示2000条错例样本。

总的来说,模型评估的结果,可以让开发者更好的优化和不断提升自已的模型和内容创作,其错例分析也是非常不错的功能,让开发者了解模型的不足和局限性,以此不断改进模型提高自身的能力。

3.5.2 模型压缩

模型压缩通过量化压缩等工具提升大模型的推理速度(当前仅支持对基础模型为BLOOMZ-7B的模型进行压缩,后续会持续更新)。

总的来说,可以更好的应对大规模数据和实时服务需求,通过选择合适的源模型和压缩策略,更好的优化其模型。

3.6 服务发布

将训练完成的模型部署在百度云服务器,实现高效的预测服务。开发者通过云服务器接口轻松调用模型,快速响应用户需求(目前仅支持私有资源池,后续会开放公共资源池)。

对于计费的项目,购买时间越长,可以购买的算力资源也就越多,意味着QPS可以申请的越高。

发布成功的服务之后可通过可视化界面管理,通过上线、下线以及指定版本进行操作。甚至数据发布之后,可能个别回答不满意需要调整,这时需要用到数据回流,其数据回流的循环迭代方式有助于持续改进和优化模型。

总的来说,可视化界面管理和数据回流为开发者提供了强大的工具和方法来管理和优化预测服务。

总结

文心千帆一站式大模型定制服务在AI应用领域中提供了丰富的功能和优势。这对于开发者来说,有很大的吸引力。整体一番体验下来,可视化界面组件分类清晰,大部分功能都增加上注释,方便零门槛的AI开发者。

丰富的技术支持、完整的服务内容和强大的生态建设。其提供的Prompt模板为开发者提供了更多的灵活性和创作能力,助力各行各业的生成式AI应用需求落地。作为AI开发者来说,文心千帆这个平台非常有吸引力,值得选择,将开发者与平台与时俱进双向发展,极大促进AI技术的应用和发展。

20万+

20万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?