本文来源公众号“集智书童”,仅用于学术分享,侵权删,干货满满。

原文链接:https://mp.weixin.qq.com/s/ArMN7QUb18RjRF6Z7C-Gbw

Image

文章篇幅略长,分为上、中和下!

作者推出 Qwen3-VL,这是迄今为止 Qwen 系列中能力最强的视觉-语言模型,在广泛的多模态基准测试中均展现出卓越性能。该模型原生支持高达 256K tokens 的交错上下文(interleaved context),可无缝融合文本、图像与视频。

模型家族包含密集型(2B/4B/8B/32B)与混合专家(Mixture-of-Experts, MoE)两种架构(30B-A3B/235B-A22B),以适应不同延迟-质量权衡需求。

Qwen3-VL 实现了三大核心能力:

-

1. 显著增强的纯文本理解能力,在多个场景下超越同类纯文本 Backbone;

-

2. 强大的长上下文理解能力,原生支持文本及交错多模态输入的 256K token 窗口,能够忠实保留、检索并跨长文档与视频进行交叉引用;

-

3. 在单图、多图及视频任务中均展现出先进的多模态推理能力,在 MMMU 与视觉数学基准(如 MathVista 和 MathVision)等综合性评测中表现领先。

在架构层面,作者引入三项关键升级:

-

1. 改进的交错式 MRoPE(interleaved-MRoPE),显著增强图像与视频中的时空建模能力;

-

2. 引入 DeepStack 集成,有效利用多层级 ViT 特征,强化视觉-语言对齐;

-

3. 基于文本的时间对齐机制,从 T-RoPE 演进为显式的文本时间戳对齐,实现更精确的时序定位。

为平衡纯文本与多模态学习目标,作者采用平方根重加权(square-root reweighting)策略,在不损害文本能力的前提下显著提升多模态性能。作者将预训练阶段扩展至 256K token 上下文长度,并将后训练阶段分为“非思考型”(non-thinking)与“思考型”(thinking)两种变体,以满足不同应用场景需求。此外,作者在后训练阶段投入更多计算资源,进一步提升模型表现。

在同等 token 预算与延迟约束下,Qwen3-VL 在密集型与混合专家(MoE)架构中均实现了更优性能。作者展望 Qwen3-VL 成为现实工作流中图像引导推理、Agent决策与多模态代码智能的基石引擎。

1 引言

视觉-语言模型(Vision–Language Models, VLMs)近年来取得了实质性进展,已从基础的视觉感知演进至跨图像与视频的High-Level多模态推理。VLMs的快速发展催生了下游应用的迅速扩展——包括长上下文理解、STEM推理、GUI理解与交互,以及 Agent 式工作流(agentic workflows)。至关重要的是,这些进展不应削弱底层大语言模型(Large Language Model, LLM)的语言能力;多模态模型在语言基准测试中应达到或超越仅文本模型的表现。

在本报告中,作者介绍了 Qwen3-VL 及其在通用任务与High-Level应用中的进展。基于 Qwen3 系列(Yang et al., 2025a),作者构建了四个密集模型(2B/4B/8B/32B)和两个混合专家(Mixture-of-Experts, MoE)模型(30B-A3B / 235B-A22B),每个模型均采用高达 256K tokens 的上下文窗口进行训练,以支持长文本理解。通过优化训练语料和训练策略,作者在视觉-语言(Vision-Language, VL)训练过程中有效保留了底层大语言模型(LLM)的语言能力,从而显著提升了整体性能。作者发布了非思考型与思考型两种版本;后者展现出更强的多模态推理能力,在复杂推理任务上取得了卓越表现。

作者首先介绍架构上的改进,这些改进涵盖三个组成部分:

-

1. 增强的位置编码。在 Qwen2.5-VL 中,作者采用 MRoPE 作为文本与视觉的统一位置编码方案。作者观察到,将嵌入维度按时间(t)、水平(h)和垂直(w)分组会导致频率谱分布不均衡,从而影响长视频的理解。因此,作者采用交错式 MRoPE,将 t,h 和 w 均匀分布于低频和高频带,从而获得更精确的位置表示。

-

2. 用于跨层融合的 DeepStack。为加强视觉-语言对齐,作者引入了开创性的 DeepStack(Meng et al., 2024)机制。视觉编码器不同层的视觉 token 通过轻量级残差连接路由至对应的 LLM 层,实现多层级融合,且无需引入额外的上下文长度。

-

3. 显式视频时间戳。作者用显式的时间戳 token 替代 Qwen2.5-VL 中通过位置编码实现的绝对时间对齐方式,以 Token 帧组,提供更简洁、更直接的时间表示。

此外,在优化方面,作者从每样本损失(per-sample loss)转向平方根归一化的每 token 损失(square-root-normalized per-token loss),该方法在训练过程中能更好地平衡文本与多模态数据的贡献。

为了构建一个更强大且鲁棒的视觉-语言基础模型,作者在数据质量、多样性和结构方面对训练数据进行了全面升级。关键改进包括:增强的字幕监督、扩展的全模态识别与光学字符识别(OCR)覆盖范围、结合3D/空间推理的标准化定位(grounding),以及新增的代码、长文档和时序定位视频语料库。作者进一步引入了思维链(chain-of-thought)推理机制,以及高质量、多样化的GUI-agent交互数据,以弥合感知、推理与行动之间的鸿沟。这些创新共同实现了更强的多模态理解能力、精准的定位能力,以及工具增强型智能。

作者的训练流程包含两个阶段:预训练(pretraining)和后训练(post-training)。预训练分为四个阶段:首先是一个预热对齐阶段,在此阶段仅更新合并模块(vision–language projection)层,其余模型参数保持冻结;随后进行全参数训练,逐步采用更大的上下文窗口,序列长度分别为 8K、32K 和 256K。后训练包含三个阶段:(i) 在长链式思维(long chain-of-thought)数据上进行监督微调,(ii) 从更强的教师模型(teacher models)进行知识蒸馏,(iii) 强化学习(reinforcement learning)。

上述创新使Qwen3-VL不仅具备强大的视觉-语言基础模型能力,更成为一个灵活的现实世界多模态智能平台,能够无缝整合跨多种应用领域的感知、推理与行动能力。在接下来的章节中,作者将介绍模型架构、训练框架以及广泛的评估结果,充分展示了其在文本、视觉和多模态推理基准测试中持续且具有竞争力的性能表现。

2 模型架构

Image

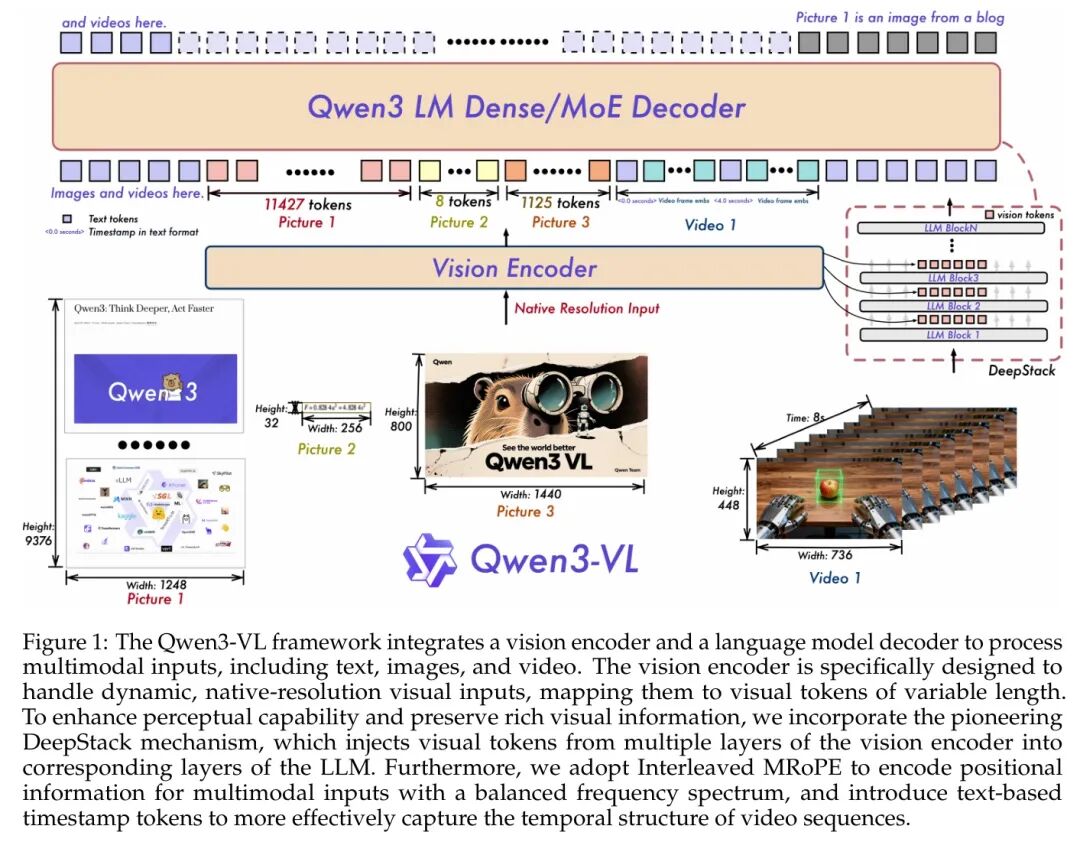

继 Qwen2.5-VL之后,Qwen3-VL 采用了一个包含三个模块的架构,分别为视觉编码器(vision encoder)、基于 MLP 的视觉-语言融合模块(MLP-based vision–language merger)以及大语言模型(Large Language Model, LLM)。图1 展示了该模型的详细结构。

大语言模型:Qwen3-VL 以三种密集型变体(Qwen3-VL-2B/4B/8B/32B)和两种 MoE(Mixture of Experts)变体(Qwen3-VL-30B-A3B、Qwen3-VL-235B-A22B)实现,均基于 Qwen3 Backbone 构建。旗舰模型 Qwen3-VL-235B-A22B 拥有总计 2350 亿参数,每 token 激活 220 亿参数。该模型在广泛的多模态任务中表现优于大多数视觉语言模型(Visual Language Model, VLM),并在多数语言基准测试中超越其纯文本对应模型。

视觉编码器:作者采用 SigLIP-2 架构作为视觉编码器,并基于官方预训练预训练权重进行初始化,继续以动态输入分辨率进行训练。为有效适应动态分辨率,作者采用 2D-RoPE(Rotary Position Embedding),并根据输入尺寸对绝对位置嵌入进行插值,遵循 CoMP的方法。具体而言,作者默认使用 SigLIP2-SO-400M 变体,并在小规模 LLM(2B 和 4B)中采用 SigLIP2-Large(300M)。

基于MLP的视觉-语言融合:与Qwen2.5-VL一致,作者采用两层MLP将视觉编码器输出的 视觉特征压缩为单个视觉 Token (visual token),其维度与语言模型(LLM)的隐藏层维度对齐。此外,作者部署了专用的融合模块以支持DeepStack机制,其具体细节详见第2.2节。

2.1 交错式 MRoPE

Qwen2-VL (Wang et al., 2024c) 引入了 MRoPE 来建模多模态输入的位置信息。在原始设计中,嵌入维度被划分为时间(t)、水平(h)和垂直(w)三个子空间,每个子空间分配了不同的旋转频率。这导致频率谱分布不均衡,后续研究已表明该问题会降低模型在长视频理解基准上的性能。为解决此问题,作者重新设计了频率分配策略,将 和 w 分量在嵌入维度上交错排列(Huang et al., 2025)。该方法确保了每个时空轴在低频和高频带中均得到均匀表示。由此产生的平衡频谱有效缓解了原始的谱偏差问题,显著提升了视频中的长距离位置建模能力。

2.2 DeepStack

作者受到DeepStack的启发,将视觉 Token (visual tokens)注入到大语言模型(LLM)的多个层级中。与原始的DeepStack方法不同,后者将多尺度视觉输入的 Token 进行堆叠,作者将其扩展为从视觉Transformer(Vision Transformer, ViT)的中间层提取视觉 Token 。这种设计能够保留从Low-Level到High-Level的丰富视觉信息。

具体而言,如图1所示,作者从视觉编码器的三个不同层级中选取特征。随后,专用的视觉-语言融合模块将这些多层级特征投影为视觉 Token (visual tokens),并直接添加到前三个大语言模型(LLM)层的对应隐藏状态中。

2.3 视频时间戳

在 中,采用了一种时间同步的 MRoPE 变体,以赋予模型时间感知能力。然而,作者发现该方法存在两个关键局限性:(1) 通过将时间位置 ID 直接绑定到绝对时间,该方法在处理长视频时会产生过大且Sparse的时间位置 ID,从而削弱模型对长时序上下文的理解能力。(2) 在该方案下实现有效学习需要在多种帧率(fps)下进行广泛且均匀的采样,显著增加了训练数据构建的成本。

为解决上述问题,作者采用基于文本 Token 的时间编码策略,即为每个视频时间片段(temporal patch)前缀一个以格式化文本字符串表示的时间戳——例如 seconds>。此外,在训练过程中,作者同时生成以秒(seconds)和 HMS(小时:分钟:秒)格式表示的时间戳,以确保模型能够学习理解多种时间码表示形式。尽管该方法会带来适度的上下文长度增加,但能够使模型更有效、更精确地感知时间信息,从而促进时间感知型视频任务(如视频定位和密集字幕生成)的性能提升。

3 预训练

3.1 训练配方

Image

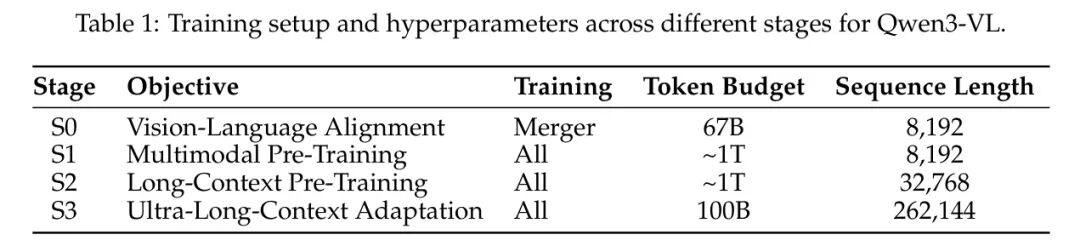

作者首先基于预训练的 SigLIP-2 模型,通过动态分辨率的连续训练来增强视觉编码器。整体 Qwen3-VL 模型采用三模块架构,包括该视觉编码器、基于 MLP 的视觉-语言融合模块,以及 Qwen3 大语言模型(LLM)主干。在此架构基础上,作者的预训练方法被系统地划分为四个不同阶段,旨在从基础对齐逐步构建长上下文理解能力。各阶段的概览如表1 所示。

-

• 阶段0:视觉-语言对齐。初始阶段(S0)旨在高效弥合视觉编码器与大语言模型(LLM)之间的模态鸿沟。关键在于,此阶段仅训练MLP融合模块(MLP merger)的参数,而视觉编码器和LLM主干网络的参数均保持冻结。作者采用了一个经过筛选的约670亿token的数据集,包含高质量的图像-标题对、视觉知识库以及光学字符识别(OCR)数据。所有训练均采用8,192的序列长度。这种“对齐优先”的方法在进入全参数训练之前,为跨模态理解建立了坚实的基础。

-

• 阶段1:多模态预训练。在初始对齐之后,阶段1(S1)进入全参数多模态预训练。在此阶段,作者解冻所有模型组件——视觉编码器、融合模块和大语言模型(LLM)——进行联合端到端训练。模型在约1万亿(1T)个 Token 的庞大且多样化的数据集上进行训练。为保持LLM强大的语言能力,数据混合由视觉-语言(VL)数据和纯文本数据组成。VL部分内容丰富多样,包含交错的图文文档、视觉定位任务、视觉问答(VQA)、STEM领域数据,以及少量视频数据,以引入时序理解能力。序列长度保持为8,192。

-

• 阶段2:长上下文预训练(Long-Context Pre-Training)。第二阶段(S2)旨在显著扩展模型的上下文处理能力。此阶段的一个关键变化是将序列长度增加至32,768(即原来的四倍),同时所有模型参数仍保持可训练状态。训练在约1T tokens的数据集上进行,并调整了数据混合比例以支持长上下文任务。文本数据的比例被提高,以增强对长篇文本的理解能力;而剩余的多模态(VL)数据则大幅增加了视频数据以及面向Agent的指令遵循数据。该阶段对于使模型能够处理并推理更长的视频以及复杂的多步骤任务至关重要。

-

• 阶段3:超长上下文适应。最终阶段(S3)是一个专门设计的阶段,旨在将模型的上下文窗口推至其操作极限。在此阶段,作者将序列长度大幅增加至262,144。模型在专为该目的精心筛选的100B token数据集上进行训练。该数据集仅包含文本数据和视觉-语言(VL)数据,重点聚焦于长视频和长文档理解任务。这一最终适应阶段进一步巩固了Qwen3-VL在处理和分析极长序列输入方面的能力,这是实现全面文档分析和长视频摘要等应用的关键能力。

3.2 预训练数据

3.2.1 图像描述与交错的文本-图像数据

为了构建一个用于通用视觉-语言理解的稳健基础模型,作者显著扩展并优化了两种核心数据模态:图像-标题对(image–caption pairs)以及交错排列的文本-图像序列(interleaved text–image sequences)。作者的策略强调高质量、多样化且语义丰富的多模态对齐,依托于专门设计的模型和严格的过滤流水线予以支持。

图像描述数据:作者从网络来源收集了一个大规模的当代图像-文本对语料库,其主要为中英双语数据,并采用多阶段精炼流程,核心为针对重描述任务微调过的专用 Qwen2.5-VL-32B 模型。该模型利用与每张图像关联的原始文本,生成更加全面、流畅且细粒度的描述——在丰富视觉元素的描述(如物体属性、空间布局及上下文语义)的同时,显著提升文本部分的语言质量与信息量。

去重操作仅在重新标注的文本上通过语义相似性度量执行,确保在不损失视觉多样性的情况下移除冗余样本。为进一步提升数据中代表性不足概念的覆盖范围,作者对视觉嵌入(visual embeddings)进行聚类,以识别数据分布中的Sparse区域,并实施针对性增强。最终得到一个高保真度的标注数据集,兼顾规模、多样性与描述粒度。

交错文本-图像数据:作者从近期的中文和英文网站收集了多样化的现实世界多模态文档。所有文档均通过一个轻量级基于Qwen的评分器进行领域分类,该评分器经过微调,用于细粒度的领域识别。基于跨领域的验证实验,作者系统性地排除了有害或低价值类别——如广告、推广内容和标题党——并使用相同的高效评分器过滤掉不 desirable 的样本。

对于书籍规模的交错数据,作者采用微调后的 Qwen2.5-VL-7B 模型进行高精度的多模态解析,精确提取并对齐文本与嵌入的图表、示意图及照片。为支持超长上下文建模,作者通过将连续页面合并为最长可达 256K tokens 的序列,构建了一个专用子集,同时保留自然的页面顺序和多模态一致性。

在预处理阶段,作者实施严格的质控措施:

-

1. 移除纯文本或对齐度低的片段;

-

2. 对超长书籍序列,要求最低页数和最低图像与文本比例,以确保上下文中始终存在有意义的视觉-文本交互。最终得到一个干净、多样且布局感知的交错语料库,专为基于事实的理解与长程多模态推理优化。

3.2.2 知识

世界知识对于多模态大语言模型(Multimodal Large Language Models, MLLMs)实现鲁棒的视觉理解、基于场景的推理以及实体感知的生成至关重要,这在多种下游任务中均发挥着关键作用。为了使 Qwen3-VL 具备对现实世界与虚构概念的全面理解能力,作者构建了一个大规模的预训练数据集,其核心围绕超过十几个语义类别中的明确实体展开,包括动物、植物、地标、食物,以及车辆、电子设备和服装等日常物品。

现实世界中的实体遵循长尾分布:显著的概念出现频率高且标注质量高,而大多数概念则较为罕见。为解决这一不平衡问题,作者采用基于重要性的采样策略。对高显著性实体进行更密集的采样,以确保充足的训练信号;而对低显著性实体则以较小的比例纳入训练,以保持广泛的覆盖范围,同时避免对训练过程造成过载。该方法有效平衡了数据质量、实用性和多样性。

所有保留的样本均经过多阶段精炼流程。除了标准的噪声和错位过滤外,作者还用更丰富的、由大语言模型(LLM)生成的描述替换原始或Sparse的标题(captions),例如通用的替代文本(alt-text)。这些增强后的标题不仅能够识别主要实体,还能描述其视觉属性、周围环境、空间布局以及与其他物体或行人的交互关系,从而提供更加完整且具有语境依据的文本表征。

这些努力共同产生了一个知识丰富、上下文感知且注重区分度的训练信号,显著提升了Qwen3-VL在现实场景中识别、推理并准确描述视觉概念的能力。

3.2.3 OCR、文档解析与长文档理解

OCR:为提升真实场景图像上的OCR性能,作者采用粗到细(coarse-to-fine)的流水线,构建了一个包含3000万条内部采集样本的数据集。该流水线通过整合专用于OCR的模型生成的伪标签(pseudo-labels)与Qwen2.5-VL的优化结果,对OCR标注进行精细化处理,整个过程无需任何人工标注。在Qwen2.5-VL支持的10种语言(不包括中文和英文)基础上,作者进一步扩展至29种新增语言,合成约3000万条高质量多语言OCR样本,并精心筛选超过100万张内部真实场景下的多语言图像。

文档解析:在文档解析任务中,作者从 Common Crawl 收集了 300 万份 PDF 文档,均匀分布在 10 种文档类型中(每类 30 万样本),并额外收集了 400 万份内部文档。首先,使用自研的版面模型预测文本与非文本区域的阅读顺序及边界框;随后,Qwen2.5-VL-72B 对各区域进行针对性识别。最终,将输出结果重新整合为具备位置感知与版面对齐特性的解析数据。

为确保在异构格式下具备鲁棒的解析能力,作者设计了一种统一的标注框架,支持两种表示形式:

-

• QwenVL-HTML,包含细粒度的、基于元素 Level 的边界框;

-

• QwenVL-Markdown,仅对图像和表进行定位,表以 LaTeX 格式编码。

作者构建了一个大规模的合成HTML语料库,包含精确的标注,并系统性地将其转换为Markdown格式。为进一步提升模型的泛化能力,作者在大量真实文档上生成伪标签,并进行质量过滤。最终的训练集结合了合成数据与高质量的伪标签数据,以增强模型的可扩展性与鲁棒性。

长文档理解:为了提升模型对多页PDF文档(通常包含数十页)的理解能力,作者利用大规模长文档数据语料库。首先,通过合并单页文档样本,合成长文档解析序列。在每个序列中,多个页面图像被置于开头,随后是通过OCR或HTML解析获得的对应文本。其次,作者构建了长文档视觉问答(VQA)数据集。具体而言,作者选取高质量的多页PDF文档,并生成多样化的VQA样本,要求模型在多个页面及异构文档元素(如图表、表、插图和正文)之间进行推理。作者精心平衡问题类型的分布,并确保支持性证据来自多种模态和布局组件,从而促进模型在长上下文中的鲁棒性、基于事实的多跳推理能力。

3.2.4 基于语义的定位与计数

视觉定位(Visual grounding)是多模态模型的一项基础能力,使模型能够准确识别、理解并定位从特定物体到任意图像区域的广泛视觉目标。在 Qwen3-VL 中,作者系统性地提升了模型的定位能力,并支持两种定位模态:边界框(bounding boxes)和点(points)。这些表示方式能够在多种场景和下游任务中实现对图像内容的精确且灵活的解析。此外,作者进一步扩展了模型的定位能力,支持计数功能,从而实现对视觉实体的量化推理。以下将简要介绍定位与计数任务的数据构建流程。

基于框的定位(Box-based Grounding):作者首先整合了广泛使用的开源数据集,包括 COCO、Objects365、OpenImages以及 。为进一步丰富数据多样性,作者开发了一种自动化合成流水线,能够在多种场景下生成高质量的物体标注。

该流水线分为三个阶段:

-

1. 利用 Qwen2.5-VL 从无标注图像中提取物体候选;

-

2. 使用开集检测器(特别是 Grounding DINO)和 Qwen2.5-VL 对这些候选进行定位与标注;

-

3. 对生成的标注进行质量评估,系统性地过滤掉低置信度或不准确的标注。通过这一方法,作者构建了一个大规模、高度多样化的基于框的定位数据集,覆盖了广泛的视觉上下文和物体类别。

基于点的定位(Point-based Grounding):为确保基于点的定位具有鲁棒性,作者构建了一个综合数据集,该数据集结合了公开可用的数据与合成生成的指向标注。

数据集整合了三个来源:

-

1. 来自 PixMo的公开指向与计数标注;

-

2. 从公开的目标检测与实例分割基准中提取的物体定位数据;

-

3. 由专门设计的合成流水线生成的高精度指向标注,该流水线旨在针对图像中的细粒度细节进行优化。

计数:在基础数据的基础上,作者精心筛选出一个高质量子集,作为计数数据集的基础,该数据集包含三种不同的任务形式:直接计数、基于框的计数以及基于点的计数。这三类任务共同构成了一个全面的计数数据集。

与 Qwen2.5-VL 不同,本版本采用归一化坐标系,其范围缩放至 [0, 1000]。该设计提升了对不同输入间图像分辨率和长宽比变化的鲁棒性,同时简化了后处理流程,并增强了预测坐标在下游应用中的可用性。

3.2.5 空间理解与3D识别

为了实现与物理世界的复杂交互,Qwen3-VL具备对空间上下文的深入理解能力。这使得模型能够解析空间关系、推理物体的可用性(affordances),并执行动作规划与具身推理(embodied reasoning)。此外,该模型还能从单张单目图像中估计物体的3D空间位置。为支持这些能力,作者构建了两个专注于空间理解(Spatial Understanding)与3D定位(3D Grounding)的综合性数据集。

空间理解。除了定位物体外,Qwen3-VL 还经过训练,能够推理2D场景中的空间关系、物体可操作性(affordance)以及可行的动作——这些能力对于具身智能(embodied AI)和交互式应用至关重要。为此,作者构建了一个专门的数据集,其内容超越了标准的视觉定位任务,包含以下三方面:(i) 关系标注(例如,“杯子在笔记本电脑的左侧”),(ii) 可操作性标签(例如,“可抓取”、“可按压”、“可坐”),以及 (iii) 依赖于动作条件的 Query ,需要进行规划(例如,“为了拿到显示器后面的书,我应该先移动什么?”)。这些样本来源于精心筛选的真实世界场景以及合成生成的布局,自然语言 Query 通过模板化方法与基于大语言模型(LLM)的方法自动生成,以确保 Query 的多样性与复杂性。关键的是,所有空间参照均以相对于其他物体或场景坐标系的方式表达,而非绝对坐标,从而促进模型进行稳健的关系推理。这种训练使 Qwen3-VL 不仅能够回答“在哪里”(where)的问题,还能回答“如何做”(how)和“可以做什么”(what can be done)的问题,为与视觉环境进行Agent(agentic)交互奠定了基础。

3D定位。为了进一步提升模型从图像中理解物理世界的能力,作者构建了一个专门用于3D视觉定位的预训练数据集。数据来源于公开的多样化室内与室外场景集合,并被重新组织为视觉问答(VQA)格式。每个样本包含:

-

1. 单视角相机图像,

-

2. 自然语言指代表达

-

3. 以结构化JSON格式表示的对应9-DoF 3D边界框标注,明确指定物体的空间位置和语义标签。

由于3D边界框来自多种传感器和数据源,其相机内参参数各异且存在固有噪声。为此,作者剔除了严重遮挡和不准确的标注,并遵循Omni3D的方法,将所有数据统一到一个虚拟相机坐标系中。此外,作者还合成了一大批描述性标题,以构建丰富的文本 Query 用于3D定位。这些描述不仅涵盖物体类别,还包含详细的属性、布局排列、空间位置、视觉可操作性以及与周围物体的交互关系,从而生成更加细粒度且具有强语义 Anchor 定性的指代表达。

3.2.6 代码

作者通过在训练语料库中引入两类与代码相关的数据,增强了Qwen3-VL系列在代码方面的专用能力,使模型能够在纯文本和视觉引导的上下文中读取、编写和推理程序。

仅基于文本的编程。作者复用了 Qwen3 和 Qwen3-Coder 系列中庞大的代码语料库。该大规模数据集涵盖了广泛的编程语言和领域,包括软件开发、算法问题求解、数学推理以及面向Agent的任务,为模型奠定了对代码语法、算法逻辑以及通用程序生成的基础理解。

多模态编码。为应对需要同时具备视觉理解与代码生成能力的任务,作者构建了一个涵盖多样化多模态编码任务的数据集。该数据集来源于开源数据集以及内部合成流水线,旨在训练模型联合理解视觉输入并生成功能性代码。数据覆盖多个关键任务,包括:将用户界面(UI)截图转换为响应式 HTML/CSS;从图像生成可编辑的 SVG 代码;解决视觉编程挑战;回答包含多模态信息的编程问题(例如附带图片的 StackOverflow 问答);以及将视觉表达形式(如流程图、图表和 LATEX 公式)转录为对应的代码或 Token 语言。这一创新的数据混合使 Qwen3-VL 能够在视觉感知与可执行逻辑之间建立桥梁。

3.2.7 视频

Qwen3-VL 的视频理解能力得到了显著提升,能够 robust 地建模帧间的时间动态性,精细感知空间关系,并对超长视频序列进行连贯的摘要生成。这一提升得益于一个数据处理流水线,其包含两项主要创新:

时间感知的视频理解。

(i) 密集字幕合成:针对长视频序列,作者采用短时到长时的字幕合成策略,生成整体性、时间戳交错且时序连贯的叙事级描述。利用自研的字幕生成模型,作者进一步生成细粒度标注,联合捕捉事件级的时间摘要与片段特定的视觉细节。

(ii) 空间-时间视频定位:作者精心构建并合成大规模视频数据,其标注层级涵盖物体、动作与行人,以增强模型的空间-时间定位能力,从而提升其细粒度视频理解性能。

视频数据平衡与采样。

(i) 源平衡(Source Balancing):为确保数据的平衡性与多样性,作者构建了一个大规模数据集,涵盖多种视频来源,包括教学内容、电影、第一人称视角录制等。通过基于元数据(如视频标题、时长、类别标签)的系统性筛选,实现数据集的平衡。

(ii) 长度自适应采样(Length-Adaptive Sampling):在预训练阶段,作者根据不同的序列长度约束,动态调整采样参数,如每秒帧数(fps)和最大帧数。这种自适应策略可缓解因采样方式不当(如帧率过低或空间分辨率过低)导致的信息丢失问题,从而更好地保留视觉细节并优化训练效率。

3.2.8 科学、技术、工程与数学(STEM)

多模态推理是 Qwen3-VL 的核心所在,其中 STEM 推理构成了其最为关键的部分。作者的理念遵循“分而治之”的策略:首先独立地构建细粒度的视觉感知能力和稳健的语言推理能力,随后以协同方式将二者融合,从而实现高效的多模态推理。

视觉感知数据。作者开发了一套专用的合成数据生成流水线,通过程序化(基于代码)渲染构建几何图形。利用该流水线,作者生成了:(i) 100万条点定位样本,例如交点、角点以及重心;(ii) 200万对面向感知的视觉问答对,旨在实现对图形的细粒度视觉理解。为获取高保真的文本描述,作者进一步实现了一个两阶段的图像字幕生成框架:首先进行初步生成,随后通过严格的基于模型的验证。两个阶段均采用专用模型的集成方法,以确保描述的准确性和细节粒度。该流程最终生成了一个包含600万条丰富标注的图形字幕数据集,覆盖多种STEM学科。

多模态推理数据。作者的多模态推理数据主要包含超过6000万道K–12及本科水平的练习题,这些题目经过严格的清洗与重构流程精心整理而成。在质量过滤阶段,作者剔除低质量样本,包括图像损坏、内容无关或答案不完整、错误的题目。在重构阶段,作者将题目在中文与英文之间进行翻译,并对答案格式进行标准化处理——如分步解答列表、数学表达式及符号表示等,以确保呈现的一致性与统一性。针对长链思维(CoT)推理数据,作者合成超过1200万个多模态推理样本,每个样本均配有图像。为保证推理过程的连贯性与丰富性,作者采用强推理模型生成的原始rollouts(轨迹)作为基础。为确保数据的可靠性与适用性,每个样本的推理轨迹均经过严格验证——结合基于规则的检查与基于模型的验证,并明确过滤掉包含模糊答案或语言混杂(code-switching)的实例。此外,为提升推理质量,作者通过拒绝采样(rejection sampling)仅保留具有挑战性的题目。

语言推理数据。除了多模态推理数据外,作者还引入了来自Qwen3的语言推理数据,因为多模态推理能力在很大程度上源于语言推理能力。

3.2.9 Agent

GUI:为了赋予Qwen3-VL在图形用户界面(GUI)中自主交互的Agent(agentic)能力,作者收集并合成大规模、跨平台的数据,覆盖桌面、移动和网页环境(Ye et al., 2025; Wang et al., 2025a; Lu et al., 2025)。在GUI界面感知方面,作者利用元数据、解析工具和人工标注构建了元素描述、密集标注(dense captioning)和密集定位(dense grounding)等任务,以实现对多样化用户界面的鲁棒理解。在Agent能力方面,作者通过自演化轨迹生成框架构建多步骤任务轨迹,并辅以针对性的人工审核;同时,作者精心设计并增强思维链(Chain-of-Thought)推理过程,以强化在真实场景执行中的规划、决策与反思性ego修正能力。

函数调用:为了实现具有多模态上下文的通用函数调用能力,作者构建了一个多模态函数调用轨迹合成流水线。作者首先使用具备能力的模型,基于图像生成用户 Query 及其对应的函数定义。随后,作者采样模型的函数调用及其推理过程,并合成函数响应。该过程持续重复,直到判断用户 Query 已被解决。在每一步之间,由于格式错误而产生的轨迹可被过滤掉。该流水线使作者能够从海量图像中构建大规模的多模态函数调用轨迹,而无需实现可执行函数。

在通用函数调用能力中,作者视搜索能力为促进现实场景中长尾实体知识整合的关键。在此情况下,作者通过在线图像搜索和文本搜索工具收集多模态事实查找轨迹,促使模型对不熟悉的实体执行搜索操作。通过这种方式,模型学会从网络中获取信息,从而生成更准确的响应。

4 训练后阶段

4.1 训练方案

作者的后训练(post-training)流程是一个三阶段过程,旨在提升模型对指令的理解与执行能力,增强其推理能力,并使其与人类偏好对齐。各阶段的具体数据和方法将在后续章节中详细说明。

监督微调(Supervised Fine-Tuning, SFT)。第一阶段旨在赋予模型遵循指令的能力,并激活其潜在的推理能力。该阶段分为两个阶段:初始阶段使用32k上下文长度,随后扩展至256k上下文窗口,重点处理长文档和长视频数据。为满足不同需求,作者将训练数据分为两类:面向非思考型模型的标准格式,以及面向思考型模型的思维链(Chain-of-Thought, CoT)格式,后者显式建模推理过程。

强到弱蒸馏(Strong-to-Weak Distillation)。第二阶段采用知识蒸馏,其中强大的教师模型将自身能力传递给作者的学生模型。关键在于,作者使用仅包含文本的数据来微调LLM Backbone 网络。该方法被证明非常有效,在以文本为中心和多模态任务中均显著提升了模型的推理能力。

强化学习(Reinforcement Learning, RL)。最终阶段利用RL进一步提升模型性能与对齐度。该阶段分为推理强化学习(Reasoning RL)和通用强化学习(General RL)。作者在涵盖文本和多模态领域的广泛任务上应用大规模强化学习,包括但不限于数学推理、光学字符识别(OCR)、视觉-语言对齐(grounding)以及指令遵循任务,以提升模型在细粒度能力上的表现。

4.2 冷启动数据

4.2.1 SFT 数据

作者的主要目标是赋予模型应对广泛现实场景的能力。在 基础能力的基础上——该模型已在约八个核心领域和三十个细粒度子类别中表现出色——作者战略性地扩展了其功能范围。这一扩展通过整合社区反馈、学术文献以及实际应用中的洞察实现,从而引入了一系列新能力。这些能力包括但不限于:面向具身智能的空间推理、面向细粒度视觉理解的图像引导推理、面向视频中鲁棒目标跟踪的时空定位,以及对涵盖数百页内容的长上下文技术文档的理解能力。基于这些目标任务,并以真实应用场景为依据,作者通过从开源数据集和网络资源中精心筛选与合成样本,系统性地构建了SFT数据集。这一针对性的数据工程工作对于确立 Qwen3-VL 作为更全面、更强大的多模态基础模型起到了关键作用。

该数据集包含约120万条样本,经过精心设计以促进强大的多模态能力。该数据集被划分为单模态和多模态数据,其中三分之一为纯文本条目,其余三分之二由图像-文本对和视频-文本对构成。多模态内容的整合旨在使模型能够理解复杂的现实场景。为确保全局适用性,该数据集不仅涵盖主要的中文和英文语料,还包含多样化的多语言样本,从而扩展其语言覆盖范围。此外,通过引入单轮和多轮对话,并将其置于从单图像到多图像序列的多种视觉场景中,数据集模拟了真实的对话动态。尤为重要的是,数据集还包含交错排列的图像-文本示例,旨在支持High-Level Agent 行为,例如工具增强的图像搜索和基于视觉的推理。这种异构的数据构成确保了全面的覆盖范围,并增强了数据集在训练可泛化且复杂的多模态 Agent 方面的代表性。

由于 Qwen3-VL 原生支持 256K token 的上下文长度,作者采用分阶段训练策略以优化计算效率。该策略包含两个阶段:第一阶段为单次训练周期,序列长度为 32K token;第二阶段则在完整的 256K token 长度下进行。在第二阶段,模型在一种课程学习(curriculum)策略下进行训练,该策略将长上下文输入与 32K token 长度的数据交替混合。长上下文输入包括数百页的技术文档、整本教科书以及长达两小时的视频内容。

训练数据的质量是决定视觉-语言模型性能的关键因素。来自开源和合成来源的数据集通常存在显著的变异性和噪声,包括冗余、无关或低质量的样本。为缓解这些缺陷,实施严格的数据过滤协议至关重要。因此,作者的数据精炼流程包含一个两阶段的过滤 Pipeline :Query过滤和Response过滤。

Query 过滤。在这一初始阶段,作者利用 Qwen2.5-VL 识别并剔除那些难以直接验证的 Query 。对于指令模糊的 Query ,仅进行最小程度的修改以提升清晰度,同时保留其原始语义意图。此外,所有源自网络且缺乏实质性内容的 Query 均被系统性地剔除。至关重要的是,所有剩余 Query 还需经过复杂度与上下文相关性的最终评估,以确保仅保留适当难度且相关性强的样本进入下一阶段。

响应过滤(Response Filtering)。此阶段融合了两种互补的策略:

-

• 基于规则的过滤:应用一组预定义的启发式规则,以消除存在定性缺陷的响应,例如重复、不完整或格式不正确的情况。为保持语义相关性并遵循伦理原则,作者还会丢弃任何偏离主题或可能生成有害内容的 Query -响应对。

-

• 基于模型的过滤:通过采用源自 Qwen2.5-VL 系列的 Reward 模型(reward models),对数据集进行进一步精炼。这些模型对多模态问答对进行多维度评估。具体而言:(a) 对答案根据正确性、完整性、清晰度和帮助性等多个标准进行评分;(b) 对于视觉基础任务,评估特别强调对视觉信息的准确理解与有效利用;(c) 该基于模型的方法能够检测出通常难以被基于规则的方法发现的细微问题,例如不恰当的语言混用或突兀的风格转变。

这一多维度过滤框架确保只有符合严格质量、可靠性及伦理完整性的数据才能进入SFT阶段。

4.2.2 Long-CoT 冷启动数据

作者思维模型的基础是一个精心构建的长链式思维(Long Chain-of-Thought, CoT)冷启动数据集,该数据集旨在激发并优化复杂推理能力。该数据集基于涵盖纯文本与多模态数据的多样化 Query 构建,视觉-语言样本与纯文本样本的比例保持在约1:1,以确保技能发展的均衡性。

多模态组件虽然涵盖了视觉问答(Visual Question Answering, VQA)、光学字符识别(Optical Character Recognition, OCR)、2D/3D定位(grounding)以及视频分析等成熟领域,但特别注重增强与STEM(科学、技术、工程和数学)及 Agent 型工作流(agentic workflows)相关的任务。这一战略重点旨在推动模型在需要复杂、多步骤推理的问题上的表现。纯文本部分则紧密参照Qwen3所使用的数据,包含数学、代码生成、逻辑推理以及通用STEM领域的挑战性问题。

为确保高质量并保持适当的难度水平,作者实施了严格的多阶段过滤协议。

-

• 难度筛选:作者有选择性地保留那些 Baseline 模型表现较差(通过率低)或生成更长、更详细回答的样本。这使得数据集包含当前模型真正难以应对的问题,从而提升了数据集的挑战性。

-

• 多模态必要性过滤:针对视觉-语言数学问题,作者引入了一个关键的过滤步骤:对于作者的 Qwen3-30B-nothink 模型在不依赖视觉输入的情况下也能正确解答的样本,作者予以剔除。这一措施确保剩余样本确实需要多模态理解能力,而不能仅通过文本线索解决。

-

• 响应质量控制:遵循 Qwen3 的方法论,作者对生成的响应进行净化处理。对于存在多个候选答案的 Query ,作者首先剔除包含错误最终结果的响应。随后,过滤掉表现出不良模式的响应,例如过度重复、语言混用不当,或在缺乏充分推理步骤的情况下明显存在猜测行为的答复。

这一严格的筛选流程生成了一个高质量、具有挑战性的数据集,专为推动High-Level多模态推理能力的自举(bootstrapping)而设计。

4.3 强到弱蒸馏

作者采用 Qwen3 中描述的强模型到弱模型蒸馏(Strong-to-Weak Distillation)流程,以进一步提升轻量级模型的性能。该蒸馏过程包含两个主要阶段:

-

• 离策略蒸馏(Off-policy Distillation):在第一阶段,由教师模型生成的输出被整合,用于提供响应蒸馏。这有助于轻量级学生模型获取基本的推理能力,为后续的在策略训练(on-policy training)奠定坚实基础。

-

• 在策略蒸馏(On-policy Distillation)中,第二阶段学生模型根据提供的 Prompt 生成响应。这些在策略(on-policy)序列随后用于微调学生模型。通过最小化KL散度来对齐学生模型和教师模型预测的logits。

4.4 强化学习

4.4.1 推理强化学习

作者在多样化的文本和多模态任务上训练模型,包括数学、编程、逻辑推理、视觉定位以及视觉谜题。每个任务的设计均确保其解决方案可以通过规则或代码执行器进行确定性验证。

数据准备

作者从开源和专有数据源中收集训练数据,并施加严格的预处理和人工标注,以确保高质量的强化学习(Reinforcement Learning, RL) Query 。对于多模态 Query ,作者使用最先进的视觉-语言模型(Qwen3-VL-235BA22B)的初步预训练权重,为每个 Query 生成16个响应;若所有响应均错误,则丢弃该 Query 。

随后,作者针对每个任务开展初步的强化学习(Reinforcement Learning, RL)实验,以识别并剔除改进潜力有限的数据来源。该过程共生成约 30K 个 RL Query ,覆盖多种文本及多模态任务。在训练每个模型时,作者为所有 Query 采样 16 个响应,并过滤掉通过率超过 的简单 Query 。作者将特定任务的数据集打乱并合并,构建混合任务批次,确保每项任务的样本比例保持一致且预先设定。该比例通过大量初步实验确定。

Reward 系统

作者实现了一个统一的 Reward 框架,以在所有任务中提供精确的反馈。该系统提供共享基础设施——包括数据预处理、实用函数以及 Reward 管理器,用于整合多种 Reward 类型——而核心 Reward 逻辑则按任务独立实现。作者使用任务特定的格式 Prompt (format prompts)来引导模型输出符合要求的格式,因此无需依赖显式的格式 Reward 。为缓解语言切换(code-switching)问题,当响应语言与 Prompt 语言不一致时,系统会施加惩罚。

强化学习算法 作者采用 SAPO,一种平滑且自适应的策略梯度方法,用于强化学习训练。SAPO 在多种文本和多模态任务中均表现出一致的性能提升,并适用于不同模型规模和架构。

4.4.2 通用强化学习

通用强化学习(General Reinforcement Learning, RL)阶段旨在提升模型的泛化能力与运行鲁棒性。为此,作者采用多任务强化学习范式,其中 Reward 函数基于监督微调(SFT)阶段的综合性任务构建,涵盖视觉问答(VQA)、图像描述(image captioning)、光学字符识别(OCR)、文档解析(document parsing)、视觉定位(grounding)以及钟表识别(clock recognition)。 Reward 机制的设计旨在优化模型性能的两个核心维度:

• 指令遵循:该维度评估模型对用户明确指令的遵守程度。它衡量模型处理内容、格式、长度及结构化输出(如JSON)等复杂约束的能力,确保生成的响应精确符合用户需求。

• 偏好对齐(Preference Alignment):对于开放式或主观性问题,该维度通过优化模型输出的有用性、事实准确性以及风格恰当性,使其与人类偏好保持一致。这有助于实现更自然、更具吸引力的用户交互体验。

此外,该阶段充当一种校正机制,用于消除在SFT(监督微调)过程中形成的强烈但存在缺陷的知识先验。作者通过引入专门设计的、可验证的任务来解决这一问题,这些任务旨在触发特定错误,例如违反直觉的物体计数和复杂的钟表时间识别。这种有针对性的干预旨在用事实性知识取代错误的先验知识。

另一个关键目标是缓解诸如不恰当的语言混合、过度重复和格式错误等不良行为。然而,这些问题的出现频率较低,使得通用的强化学习(Reinforcement Learning, RL)策略在样本利用效率上表现不佳。为克服这一局限,作者在该阶段构建了一个专用数据集。该数据集专门隔离了已知会引发此类不良行为的 Prompt (prompt)。通过这种聚焦训练,能够施加针对性且高频的惩罚机制,从而有效抑制这些残余错误。

强化学习(RL)过程的反馈通过一种混合 Reward 机制实现,该机制结合了两种互补的方法:

• 基于规则的 Reward (Rule-Based Rewards):对于具有可验证真实标签(ground truth)的任务(如格式合规性和指令遵循性),该方法能够提供明确且高精度的反馈。通过使用定义清晰的启发式规则,该方法为评估正确性提供了一种稳健的机制,并能有效缓解 Reward 劫持(reward hacking)问题,即模型可能利用学习到的 Reward 函数中的模糊性进行策略性欺骗。

• 基于模型的 Reward (Model-Based Rewards):该方法采用 Qwen2.5-VL-72B-Instruct 或 Qwen3 作为复杂的评判模型。这些评判模型将每个生成的响应与真实参考答案进行对比,从多个维度评估其质量。该方法在评估复杂或开放性任务时表现出更强的灵活性,尤其适用于那些难以通过严格、基于规则的匹配来评判的场景。它特别有效于减少误判为负例的情况,从而避免对格式或表达方式非传统的有效响应造成不合理的惩罚。

4.5 借助图像进行思考

受“用图像进行思考”(Wu et al., 2025a; Jin et al., 2025; Zheng et al., 2025; Lai et al., 2025)这一系列开创性工作的启发,作者通过一种两阶段训练范式,赋予 Qwen3-VL 类似的Agent(agentic)能力。

在第一阶段,作者合成一个冷启动的Agent数据集,包含约 个基础示例——主要为简单的两轮视觉问答任务,例如属性检测。随后,作者对 Qwen2.5-VL-32B 进行监督微调(SFT),以模拟视觉Agent的行为: 分析反馈并给出答案。为进一步提升其推理能力,作者采用多轮、工具融合的强化学习(RL)方法。

在第二阶段,作者将第一阶段训练得到的 Qwen2.5-VL-32B 视觉 Agent (visual agent)进行知识蒸馏,生成一个规模更大、多样性更高的数据集,包含约 120k 条多轮 Agent 交互(multi-turn agentic interactions),覆盖更广泛的视觉任务。随后,作者采用类似的冷启动 SFT 与工具集成的强化学习(tool-integrated RL)流程(此时同时使用蒸馏数据与合成数据)对 Qwen3-VL 进行后训练(post-training)。

多轮、工具集成的强化学习(RL)过程在两个阶段中几乎完全相同,仅在底层数据上有所差异。在 阶段,作者采用三种互补的 Reward 信号,以促进鲁棒的、基于工具的推理:

• Answer Accuracy Reward 使用 Qwen3-32B 来衡量最终答案是否正确。

• 多轮推理 Reward (Multi-Turn Reasoning Reward)利用 Qwen2.5-VL-72B 评估助手是否正确理解工具或环境反馈,并通过连贯、分步的推理得出答案。工具调用 Reward (Tool-Calling Reward)通过将实际工具调用次数与专家估算的目标次数进行比较,鼓励恰当的工具使用。该目标次数由 Qwen2.5-VL-72B 根据任务复杂度离线确定。

早期实验表明,模型倾向于退化为仅进行一次工具调用以获取前两项 Reward ,而无视任务的实际需求。为缓解这一问题,作者显式地引入工具调用 Reward (tool-calling reward),以促进与任务复杂度相适应的工具探索行为。

4.6 基础设施

作者在阿里云的PAI-Lingjun AI计算服务上训练Qwen3-VL系列模型,该服务提供了AI和高性能计算等计算密集型场景所需的高性能计算能力。

在预训练阶段,系统基于 MegatronLM 框架采用了一种混合并行策略,整合了张量并行(Tensor Parallelism, TP)、流水线并行(Pipeline Parallelism, PP)、上下文并行(Context Parallelism, CP)、专家并行(Expert Parallelism, EP)以及 ZeRO-1 数据并行(Data Parallelism, DP)。该配置在模型规模、计算负载与通信开销之间实现了细粒度的平衡,从而实现了高硬件利用率,并在高达 10,000 张 GPU 的规模下仍能保持高吞吐量与低通信延迟。

在局部部署与性能评估方面,作者采用基于 vLLM 或 SGLang 的部署策略。vLLM 利用 PagedAttention 实现内存高效的管理与高吞吐量推理,而 SGLang 在结构化生成和复杂 Prompt 处理方面表现优异。两者结合,提供了高效、稳定、灵活的模型推理与评估能力。

参考

[1]. Qwen3-VL Technical Report

THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。

1373

1373

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?