摘要

Dify是一个功能强大的开源AI应用开发平台,支持快速构建和部署各种AI应用。本文将详细介绍如何使用Docker Compose部署Dify平台,并针对部署过程中可能遇到的常见问题提供详细的排查和解决方法。通过实践示例、架构图和代码演示,帮助中国开发者特别是AI应用开发者快速掌握Dify平台的部署技巧,解决实际问题。文章将涵盖系统架构设计、部署配置、日志管理、问题排查、性能优化等关键环节,为读者提供一套完整的解决方案。

正文

第一章:引言与背景

随着人工智能技术的飞速发展,越来越多的企业和开发者开始构建基于AI的应用程序。然而,从零开始搭建一个完整的AI应用平台需要大量的时间和技术投入。Dify作为一个开源的AI应用开发平台,为开发者提供了快速构建和部署AI应用的能力。

Dify平台整合了多种AI模型和服务,支持可视化的工作流设计、模型管理、数据处理等功能。通过Docker Compose,开发者可以快速部署一个功能完整的Dify环境,大大降低了AI应用开发的门槛。

1.1 Dify平台的核心价值

Dify平台具有以下核心价值:

- 快速开发:提供可视化界面,支持拖拽式工作流设计

- 多模型支持:支持多种主流AI模型,包括OpenAI、Anthropic等

- 灵活部署:支持本地部署和云部署

- 易于扩展:提供插件机制,支持功能扩展

1.2 Docker Compose的优势

使用Docker Compose部署Dify平台具有以下优势:

- 简化部署:通过单一配置文件管理多个服务

- 环境一致性:确保开发、测试、生产环境的一致性

- 快速启动:一条命令即可启动整个平台

- 资源隔离:每个服务运行在独立的容器中

第二章:Dify平台架构详解

在部署Dify平台之前,我们需要了解其系统架构和各组件的功能。

2.1 Dify平台整体架构

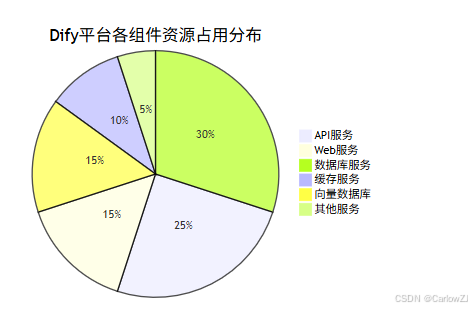

2.2 各组件功能说明

- API服务:核心业务逻辑处理,提供RESTful API接口

- Web服务:前端界面,提供用户交互界面

- PostgreSQL数据库:存储用户数据、应用配置、对话记录等

- Redis缓存:提供高速缓存,提升系统性能

- Weaviate向量数据库:存储和检索向量数据,支持语义搜索

- Sandbox安全沙箱:提供安全的代码执行环境

- 插件守护进程:管理外部插件的加载和执行

- Worker服务:处理异步任务和后台作业

- Worker Beat:处理定时任务和周期性作业

第三章:Docker Compose部署配置

Docker Compose使用docker-compose.yaml文件来定义服务、网络和卷。以下是一个完整的Dify平台部署配置示例:

# docker-compose.yaml

version: '3.8'

# 定义网络

networks:

dify_network:

driver: bridge

ipam:

config:

- subnet: 172.21.0.0/16

# 定义卷

volumes:

postgres_data:

driver: local

redis_data:

driver: local

weaviate_data:

driver: local

# 定义服务

services:

# PostgreSQL数据库

db:

image: postgres:15-alpine

container_name: dify_db

restart: always

ports:

- "5432:5432"

environment:

POSTGRES_USER: dify

POSTGRES_PASSWORD: difyPWD123

POSTGRES_DB: dify

volumes:

- postgres_data:/var/lib/postgresql/data

- ./init-scripts:/docker-entrypoint-initdb.d

networks:

- dify_network

healthcheck:

test: ["CMD-SHELL", "pg_isready -U dify"]

interval: 10s

timeout: 5s

retries: 5

logging:

driver: "json-file"

options:

max-size: "100m"

max-file: "10"

# Redis缓存

redis:

image: redis:6-alpine

container_name: dify_redis

restart: always

ports:

- "6379:6379"

volumes:

- redis_data:/data

networks:

- dify_network

command: redis-server --appendonly yes

healthcheck:

test: ["CMD", "redis-cli", "ping"]

interval: 10s

timeout: 5s

retries: 5

logging:

driver: "json-file"

options:

max-size: "50m"

max-file: "5"

# Weaviate向量数据库

weaviate:

image: semitechnologies/weaviate:1.19.0

container_name: dify_weaviate

restart: always

ports:

- "8080:8080"

environment:

QUERY_DEFAULTS_LIMIT: 25

AUTHENTICATION_ANONYMOUS_ACCESS_ENABLED: 'true'

PERSISTENCE_DATA_PATH: '/var/lib/weaviate'

DEFAULT_VECTORIZER_MODULE: 'none'

CLUSTER_HOSTNAME: 'node1'

# 解决setlocale问题

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

volumes:

- weaviate_data:/var/lib/weaviate

networks:

- dify_network

logging:

driver: "json-file"

options:

max-size: "100m"

max-file: "10"

# API服务

api:

image: langgenius/dify-api:0.5.0

container_name: dify_api

restart: always

ports:

- "5001:5001"

environment:

# 基础配置

DIFY_BIND_ADDRESS: 0.0.0.0

DIFY_PORT: 5001

# 数据库配置

DB_HOST: db

DB_PORT: 5432

DB_USERNAME: dify

DB_PASSWORD: difyPWD123

DB_DATABASE: dify

# Redis配置

REDIS_HOST: redis

REDIS_PORT: 6379

REDIS_DB: 0

REDIS_USE_SSL: 'false'

# Weaviate配置

WEAVIATE_ENDPOINT: http://weaviate:8080

# 安全沙箱配置

CODE_EXECUTION_ENDPOINT: http://sandbox:8194

# 插件配置

PLUGIN_MANAGER_ENDPOINT: http://plugin_daemon:5003

# 区域设置,解决setlocale问题

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

# 其他配置

EDITION: SELF_HOSTED

MODE: API

SECRET_KEY: sk-abc123def456ghi789

depends_on:

db:

condition: service_healthy

redis:

condition: service_healthy

weaviate:

condition: service_started

networks:

- dify_network

logging:

driver: "json-file"

options:

max-size: "100m"

max-file: "10"

healthcheck:

test: ["CMD", "curl", "-f", "http://localhost:5001/health"]

interval: 30s

timeout: 10s

retries: 3

# Web服务

web:

image: langgenius/dify-web:0.5.0

container_name: dify_web

restart: always

ports:

- "3000:3000"

environment:

# API地址配置

APP_API_URL: http://api:5001

NEXT_PUBLIC_API_URL: http://api:5001

NEXT_PUBLIC_EDITOR_API_URL: http://api:5001

# 区域设置,解决setlocale问题

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

depends_on:

- api

networks:

- dify_network

logging:

driver: "json-file"

options:

max-size: "50m"

max-file: "5"

# 安全沙箱

sandbox:

image: langgenius/dify-sandbox:0.2.12

container_name: dify_sandbox

restart: always

ports:

- "8194:8194"

environment:

SANDBOX_PORT: 8194

# 区域设置,解决setlocale问题

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

networks:

- dify_network

logging:

driver: "json-file"

options:

max-size: "50m"

max-file: "5"

# 插件守护进程

plugin_daemon:

image: langgenius/dify-plugin-daemon:0.2.0

container_name: dify_plugin_daemon

restart: always

ports:

- "5003:5003"

environment:

# 区域设置,解决setlocale问题

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

volumes:

- ./plugins:/app/plugins

networks:

- dify_network

logging:

driver: "json-file"

options:

max-size: "50m"

max-file: "5"

# Worker服务

worker:

image: langgenius/dify-api:0.5.0

container_name: dify_worker

restart: always

environment:

# 基础配置

DIFY_BIND_ADDRESS: 0.0.0.0

# 数据库配置

DB_HOST: db

DB_PORT: 5432

DB_USERNAME: dify

DB_PASSWORD: difyPWD123

DB_DATABASE: dify

# Redis配置

REDIS_HOST: redis

REDIS_PORT: 6379

REDIS_DB: 0

REDIS_USE_SSL: 'false'

# Weaviate配置

WEAVIATE_ENDPOINT: http://weaviate:8080

# 安全沙箱配置

CODE_EXECUTION_ENDPOINT: http://sandbox:8194

# 插件配置

PLUGIN_MANAGER_ENDPOINT: http://plugin_daemon:5003

# 区域设置,解决setlocale问题

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

# Worker配置

EXECUTOR_TYPE: worker

MODE: WORKER

EDITION: SELF_HOSTED

SECRET_KEY: sk-abc123def456ghi789

depends_on:

db:

condition: service_healthy

redis:

condition: service_healthy

weaviate:

condition: service_started

networks:

- dify_network

logging:

driver: "json-file"

options:

max-size: "100m"

max-file: "10"

command: celery -A app.celery worker -P gevent -c 10 -Q dataset,generation,mail

# Worker Beat服务

worker_beat:

image: langgenius/dify-api:0.5.0

container_name: dify_worker_beat

restart: always

environment:

# 基础配置

DIFY_BIND_ADDRESS: 0.0.0.0

# 数据库配置

DB_HOST: db

DB_PORT: 5432

DB_USERNAME: dify

DB_PASSWORD: difyPWD123

DB_DATABASE: dify

# Redis配置

REDIS_HOST: redis

REDIS_PORT: 6379

REDIS_DB: 0

REDIS_USE_SSL: 'false'

# 区域设置,解决setlocale问题

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

# Worker配置

EXECUTOR_TYPE: worker-beat

MODE: WORKER

EDITION: SELF_HOSTED

SECRET_KEY: sk-abc123def456ghi789

depends_on:

db:

condition: service_healthy

redis:

condition: service_healthy

networks:

- dify_network

logging:

driver: "json-file"

options:

max-size: "50m"

max-file: "5"

command: celery -A app.celery beat

# 配置卷

volumes:

postgres_data:

redis_data:

weaviate_data:

第四章:部署流程详解

4.1 环境准备

在开始部署之前,确保系统已安装以下工具:

# 检查Docker是否已安装

docker --version

# 检查Docker Compose是否已安装

docker-compose --version

# 如果未安装,可以使用以下命令安装(Ubuntu/Debian)

sudo apt-get update

sudo apt-get install -y docker.io docker-compose

# 启动Docker服务

sudo systemctl start docker

sudo systemctl enable docker

4.2 项目目录结构

创建以下目录结构:

dify-deployment/

├── docker-compose.yaml # Docker Compose配置文件

├── init-scripts/ # 数据库初始化脚本

├── plugins/ # 插件目录

├── logs/ # 日志目录

└── .env # 环境变量文件(可选)

4.3 启动服务

使用以下命令启动Dify平台:

# 进入项目目录

cd dify-deployment

# 启动所有服务(后台运行)

docker-compose up -d

# 查看服务状态

docker-compose ps

# 查看服务日志

docker-compose logs

4.4 验证部署

# 检查API服务是否正常

curl -f http://localhost:5001/health

# 检查Web服务是否正常

curl -f http://localhost:3000/

# 检查数据库连接

docker-compose exec db pg_isready -U dify

# 检查Redis连接

docker-compose exec redis redis-cli ping

第五章:日志管理与监控

5.1 Docker Compose日志查看

# 查看所有服务日志

docker-compose logs

# 查看最近100行日志

docker-compose logs --tail=100

# 实时查看日志

docker-compose logs -f

# 查看特定服务日志

docker-compose logs api

# 查看特定服务的最近50行日志

docker-compose logs --tail=50 api

5.2 日志分析工具

创建一个Python脚本用于分析Dify服务日志:

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

Dify日志分析工具

用于分析和监控Dify平台各服务的日志

"""

import subprocess

import re

import json

import time

from typing import Dict, List, Optional

from datetime import datetime

import logging

# 配置日志

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

logger = logging.getLogger(__name__)

class DifyLogAnalyzer:

"""Dify日志分析器"""

def __init__(self, project_name: str = "dify"):

"""

初始化日志分析器

Args:

project_name: Docker Compose项目名称

"""

self.project_name = project_name

self.services = [

'api', 'web', 'db', 'redis', 'weaviate',

'sandbox', 'plugin_daemon', 'worker', 'worker_beat'

]

self.error_patterns = [

r'ERROR',

r'error',

r'exception',

r'Exception',

r'failed',

r'Failed',

r'warning',

r'Warning'

]

def get_service_logs(self, service_name: str, lines: int = 100) -> Optional[str]:

"""

获取指定服务的日志

Args:

service_name: 服务名称

lines: 获取日志行数

Returns:

日志内容或None

"""

try:

# 构建命令

cmd = [

"docker-compose",

"logs",

"--tail",

str(lines),

service_name

]

# 执行命令

result = subprocess.run(

cmd,

capture_output=True,

text=True,

timeout=30

)

if result.returncode == 0:

return result.stdout

else:

logger.error(f"获取{service_name}日志失败: {result.stderr}")

return None

except subprocess.TimeoutExpired:

logger.error(f"获取{service_name}日志超时")

return None

except Exception as e:

logger.error(f"获取{service_name}日志异常: {e}")

return None

def analyze_logs(self, service_name: str) -> Dict:

"""

分析指定服务的日志

Args:

service_name: 服务名称

Returns:

分析结果

"""

# 获取日志

logs = self.get_service_logs(service_name)

if not logs:

return {

'service': service_name,

'success': False,

'error': '无法获取日志'

}

# 分析日志

lines = logs.split('\n')

error_count = 0

warning_count = 0

errors = []

for line in lines:

# 检查错误模式

for pattern in self.error_patterns:

if re.search(pattern, line):

if 'error' in pattern.lower() or 'Error' in pattern or 'failed' in pattern.lower() or 'Failed' in pattern:

error_count += 1

errors.append(line.strip())

elif 'warning' in pattern.lower() or 'Warning' in pattern:

warning_count += 1

return {

'service': service_name,

'success': True,

'total_lines': len(lines),

'error_count': error_count,

'warning_count': warning_count,

'errors': errors[-10:] if errors else [], # 只保留最近10个错误

'analyzed_at': datetime.now().isoformat()

}

def analyze_all_services(self) -> List[Dict]:

"""

分析所有服务的日志

Returns:

所有服务的分析结果

"""

results = []

for service in self.services:

logger.info(f"正在分析{service}服务日志...")

result = self.analyze_logs(service)

results.append(result)

time.sleep(1) # 避免过于频繁的请求

return results

def get_health_status(self) -> Dict:

"""

获取服务健康状态

Returns:

健康状态信息

"""

try:

# 执行docker-compose ps命令

result = subprocess.run(

["docker-compose", "ps"],

capture_output=True,

text=True,

timeout=10

)

if result.returncode == 0:

lines = result.stdout.strip().split('\n')

services_status = []

# 解析服务状态

for line in lines[1:]: # 跳过标题行

if line.strip():

parts = line.split()

if len(parts) >= 4:

service_info = {

'name': parts[0],

'status': ' '.join(parts[3:]) # 状态信息可能包含空格

}

services_status.append(service_info)

return {

'success': True,

'services': services_status,

'checked_at': datetime.now().isoformat()

}

else:

return {

'success': False,

'error': result.stderr

}

except Exception as e:

logger.error(f"获取服务健康状态失败: {e}")

return {

'success': False,

'error': str(e)

}

def generate_report(self) -> Dict:

"""

生成完整的日志分析报告

Returns:

分析报告

"""

logger.info("开始生成Dify平台日志分析报告...")

# 获取健康状态

health_status = self.get_health_status()

# 分析所有服务日志

analysis_results = self.analyze_all_services()

# 统计信息

total_errors = sum(result.get('error_count', 0) for result in analysis_results)

total_warnings = sum(result.get('warning_count', 0) for result in analysis_results)

report = {

'report_generated_at': datetime.now().isoformat(),

'project_name': self.project_name,

'health_status': health_status,

'log_analysis': analysis_results,

'summary': {

'total_services': len(self.services),

'total_errors': total_errors,

'total_warnings': total_warnings,

'error_rate': round(total_errors / len(self.services), 2) if self.services else 0

}

}

logger.info("日志分析报告生成完成")

return report

def main():

"""主函数"""

# 创建分析器实例

analyzer = DifyLogAnalyzer()

# 生成报告

report = analyzer.generate_report()

# 输出报告

print(json.dumps(report, indent=2, ensure_ascii=False))

# 检查是否有严重问题

total_errors = report['summary']['total_errors']

if total_errors > 0:

print(f"\n⚠️ 发现 {total_errors} 个错误,请检查相关服务日志")

else:

print("\n✅ 所有服务日志正常")

if __name__ == "__main__":

main()

第六章:常见问题及解决方案

在部署和运行Dify平台过程中,可能会遇到各种问题。以下是常见问题及其解决方案:

6.1 服务无法启动

问题现象:

某些服务(如api、worker、sandbox)无法启动或频繁重启

排查步骤:

- 检查服务日志:

docker-compose logs api

- 检查依赖服务状态:

docker-compose ps

解决方案:

- 权限问题:

# 在docker-compose.yaml中为相关服务添加特权配置

api:

image: langgenius/dify-api:0.5.0

privileged: true # 添加特权模式

- 资源限制问题:

# 调整资源限制

api:

image: langgenius/dify-api:0.5.0

ulimits:

nproc: 65535

nofile:

soft: 20000

hard: 40000

- 重新部署:

# 停止并删除所有容器

docker-compose down

# 重新启动服务

docker-compose up -d

6.2 setlocale警告问题

问题现象:

bash: warning: setlocale: LC_ALL: cannot change locale (en_US.UTF-8)

perl: warning: Setting locale failed.

解决方案:

在所有服务中添加区域设置环境变量:

services:

api:

environment:

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

# 为其他服务也添加相同的环境变量

或者在Dockerfile中安装区域设置支持:

# 在基础镜像中安装区域设置

RUN apt-get update && \

apt-get install -y locales && \

rm -rf /var/lib/apt/lists/* && \

locale-gen en_US.UTF-8

ENV LANG=en_US.UTF-8

ENV LANGUAGE=en_US:en

ENV LC_ALL=en_US.UTF-8

6.3 数据库连接失败

问题现象:

API服务无法连接到数据库,出现连接超时或认证失败错误

排查步骤:

- 检查数据库服务状态:

docker-compose ps db

- 测试数据库连接:

docker-compose exec db pg_isready -U dify

- 检查数据库配置:

docker-compose exec db psql -U dify -d dify -c "SELECT version();"

解决方案:

- 检查环境变量配置:

api:

environment:

DB_HOST: db

DB_PORT: 5432

DB_USERNAME: dify

DB_PASSWORD: difyPWD123

DB_DATABASE: dify

- 使用健康检查确保依赖服务就绪:

api:

depends_on:

db:

condition: service_healthy

- 检查网络连接:

docker-compose exec api ping db

6.4 插件加载失败

问题现象:

插件守护进程无法加载插件,出现ModuleNotFoundError等错误

排查步骤:

- 检查插件目录:

docker-compose exec plugin_daemon ls -la /app/plugins

- 检查插件日志:

docker-compose logs plugin_daemon

解决方案:

- 确保插件文件存在且权限正确:

# 在宿主机上检查插件目录

ls -la plugins/

# 设置正确的权限

chmod -R 755 plugins/

- 检查插件配置文件格式:

{

"name": "example_plugin",

"version": "1.0.0",

"description": "示例插件",

"entrypoint": "main"

}

- 重启插件服务:

docker-compose restart plugin_daemon

6.5 Worker任务处理异常

问题现象:

异步任务无法正常处理,任务队列积压

排查步骤:

- 检查Worker服务状态:

docker-compose ps worker

- 查看Worker日志:

docker-compose logs worker

解决方案:

- 检查Redis连接:

worker:

environment:

REDIS_HOST: redis

REDIS_PORT: 6379

- 调整Worker配置:

worker:

command: celery -A app.celery worker -P gevent -c 10 -Q dataset,generation,mail

- 重启Worker服务:

docker-compose restart worker

第七章:性能优化与最佳实践

7.1 资源配置优化

# 为关键服务配置资源限制

api:

deploy:

resources:

limits:

cpus: '2.0'

memory: 2G

reservations:

cpus: '1.0'

memory: 1G

# 为数据库配置更多资源

db:

deploy:

resources:

limits:

cpus: '2.0'

memory: 2G

reservations:

cpus: '1.0'

memory: 1G

7.2 数据库优化

# 为PostgreSQL配置优化参数

db:

environment:

POSTGRES_USER: dify

POSTGRES_PASSWORD: difyPWD123

POSTGRES_DB: dify

POSTGRES_INITDB_ARGS: "--auth-host=scram-sha-256"

command: >

postgres

-c shared_buffers=256MB

-c effective_cache_size=1GB

-c maintenance_work_mem=64MB

-c checkpoint_completion_target=0.9

-c wal_buffers=16MB

-c default_statistics_target=100

-c random_page_cost=1.1

-c effective_io_concurrency=200

-c work_mem=16MB

-c min_wal_size=1GB

-c max_wal_size=4GB

7.3 日志管理优化

# 配置日志轮转

services:

api:

logging:

driver: "json-file"

options:

max-size: "100m"

max-file: "10"

7.4 健康检查配置

# 为关键服务配置健康检查

api:

healthcheck:

test: ["CMD", "curl", "-f", "http://localhost:5001/health"]

interval: 30s

timeout: 10s

retries: 3

start_period: 60s

db:

healthcheck:

test: ["CMD-SHELL", "pg_isready -U dify"]

interval: 10s

timeout: 5s

retries: 5

第八章:实践案例

8.1 部署一个简单的AI应用

假设我们需要部署一个基于Dify的AI应用,用于文本生成和问答。以下是完整的部署步骤:

- 创建项目目录:

mkdir dify-text-app

cd dify-text-app

- 创建docker-compose.yaml文件:

version: '3.8'

networks:

dify_network:

volumes:

postgres_data:

redis_data:

services:

db:

image: postgres:15-alpine

restart: always

environment:

POSTGRES_USER: dify

POSTGRES_PASSWORD: difyPWD123

POSTGRES_DB: dify

volumes:

- postgres_data:/var/lib/postgresql/data

networks:

- dify_network

healthcheck:

test: ["CMD-SHELL", "pg_isready -U dify"]

interval: 10s

timeout: 5s

retries: 5

redis:

image: redis:6-alpine

restart: always

volumes:

- redis_data:/data

networks:

- dify_network

command: redis-server --appendonly yes

healthcheck:

test: ["CMD", "redis-cli", "ping"]

interval: 10s

timeout: 5s

retries: 5

api:

image: langgenius/dify-api:0.5.0

restart: always

ports:

- "5001:5001"

environment:

DIFY_BIND_ADDRESS: 0.0.0.0

DB_HOST: db

DB_PORT: 5432

DB_USERNAME: dify

DB_PASSWORD: difyPWD123

DB_DATABASE: dify

REDIS_HOST: redis

REDIS_PORT: 6379

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

depends_on:

db:

condition: service_healthy

redis:

condition: service_healthy

networks:

- dify_network

web:

image: langgenius/dify-web:0.5.0

restart: always

ports:

- "3000:3000"

environment:

APP_API_URL: http://api:5001

NEXT_PUBLIC_API_URL: http://api:5001

NEXT_PUBLIC_EDITOR_API_URL: http://api:5001

LANG: en_US.UTF-8

LANGUAGE: en_US:en

LC_ALL: en_US.UTF-8

depends_on:

- api

networks:

- dify_network

volumes:

postgres_data:

redis_data:

- 启动服务:

docker-compose up -d

- 查看服务状态:

docker-compose ps

- 查看日志:

docker-compose logs -f

- 访问应用:

打开浏览器访问http://localhost:3000

8.2 创建部署检查脚本

创建一个Python脚本用于检查Dify平台的部署状态:

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

Dify部署检查脚本

用于检查Dify平台各服务的部署状态

"""

import subprocess

import time

import sys

from typing import Dict, List

import requests

class DifyDeploymentChecker:

"""Dify部署检查器"""

def __init__(self):

"""初始化检查器"""

self.services = {

'db': {'port': 5432, 'check_cmd': 'pg_isready -U dify'},

'redis': {'port': 6379, 'check_cmd': 'redis-cli ping'},

'api': {'port': 5001, 'url': 'http://localhost:5001/health'},

'web': {'port': 3000, 'url': 'http://localhost:3000/'}

}

def check_port(self, port: int) -> bool:

"""

检查端口是否开放

Args:

port: 端口号

Returns:

端口是否开放

"""

import socket

try:

sock = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

sock.settimeout(5)

result = sock.connect_ex(('localhost', port))

sock.close()

return result == 0

except Exception:

return False

def check_docker_service(self, service_name: str, check_cmd: str) -> bool:

"""

检查Docker服务

Args:

service_name: 服务名称

check_cmd: 检查命令

Returns:

服务是否正常

"""

try:

cmd = f"docker-compose exec {service_name} {check_cmd}"

result = subprocess.run(

cmd.split(),

capture_output=True,

text=True,

timeout=10

)

return result.returncode == 0

except Exception:

return False

def check_http_service(self, url: str) -> bool:

"""

检查HTTP服务

Args:

url: 服务URL

Returns:

服务是否正常

"""

try:

response = requests.get(url, timeout=10)

return response.status_code == 200

except Exception:

return False

def check_all_services(self) -> Dict:

"""

检查所有服务

Returns:

检查结果

"""

results = {}

for service_name, config in self.services.items():

print(f"正在检查 {service_name} 服务...")

if 'url' in config:

# HTTP服务检查

status = self.check_http_service(config['url'])

results[service_name] = {

'status': '正常' if status else '异常',

'type': 'HTTP服务',

'url': config['url']

}

elif 'check_cmd' in config:

# Docker服务检查

status = self.check_docker_service(service_name, config['check_cmd'])

results[service_name] = {

'status': '正常' if status else '异常',

'type': 'Docker服务',

'command': config['check_cmd']

}

else:

# 端口检查

status = self.check_port(config['port'])

results[service_name] = {

'status': '正常' if status else '异常',

'type': '端口服务',

'port': config['port']

}

print(f"{service_name}: {results[service_name]['status']}")

time.sleep(1) # 避免检查过于频繁

return results

def generate_report(self) -> str:

"""

生成检查报告

Returns:

检查报告

"""

results = self.check_all_services()

# 统计信息

total_services = len(results)

normal_services = sum(1 for result in results.values() if result['status'] == '正常')

# 生成报告

report = []

report.append("=" * 50)

report.append("Dify平台部署检查报告")

report.append("=" * 50)

report.append(f"检查时间: {time.strftime('%Y-%m-%d %H:%M:%S')}")

report.append("")

report.append("服务状态详情:")

report.append("-" * 30)

for service_name, result in results.items():

report.append(f"{service_name:10} | {result['status']:4} | {result['type']}")

if 'url' in result:

report.append(f"{'':10} | {'':4} | URL: {result['url']}")

elif 'port' in result:

report.append(f"{'':10} | {'':4} | 端口: {result['port']}")

elif 'command' in result:

report.append(f"{'':10} | {'':4} | 命令: {result['command']}")

report.append("")

report.append("-" * 50)

report.append(f"总计: {total_services} 个服务")

report.append(f"正常: {normal_services} 个服务")

report.append(f"异常: {total_services - normal_services} 个服务")

if normal_services == total_services:

report.append("✅ 所有服务正常,Dify平台部署成功!")

else:

report.append("⚠️ 部分服务异常,请检查相关服务日志")

report.append("=" * 50)

return "\n".join(report)

def main():

"""主函数"""

print("开始检查Dify平台部署状态...")

print()

checker = DifyDeploymentChecker()

report = checker.generate_report()

print(report)

# 如果有异常服务,返回非零退出码

if "异常" in report:

sys.exit(1)

if __name__ == "__main__":

main()

第九章:项目实施计划

第十章:数据分布与性能分析

总结

本文全面介绍了Dify平台的Docker Compose部署方法,并针对部署过程中可能遇到的常见问题提供了详细的解决方案。通过系统的学习和实践,我们可以总结出以下关键要点:

核心要点回顾

- 系统架构理解:深入理解Dify平台的组件构成和相互关系是成功部署的基础

- 配置文件编写:合理配置docker-compose.yaml文件,确保各服务正确连接和运行

- 环境变量设置:正确设置环境变量,特别是解决setlocale警告问题

- 依赖关系管理:使用健康检查确保服务依赖关系正确处理

- 日志管理监控:建立完善的日志管理和监控机制

- 问题排查技巧:掌握常见问题的排查方法和解决方案

最佳实践建议

- 分步部署:建议按照数据库→缓存→核心服务→扩展服务的顺序逐步部署

- 资源配置:根据实际需求合理配置各服务的资源限制和保留资源

- 健康检查:为关键服务配置健康检查,确保服务稳定运行

- 日志轮转:配置日志轮转策略,避免日志文件过大

- 安全配置:使用强密码,避免使用默认配置

- 备份策略:定期备份数据库等重要数据

未来展望

随着AI技术的不断发展,Dify平台也将持续演进:

- 更多AI模型支持:支持更多类型的AI模型和算法

- 云原生集成:更好地与Kubernetes等云原生技术集成

- 边缘计算支持:支持在边缘设备上部署AI应用

- 自动化运维:实现更智能的自动化部署和运维管理

通过本文的学习和实践,开发者可以快速掌握Dify平台的部署技能,为构建强大的AI应用奠定坚实基础。

2388

2388