摘要

本文系统介绍如何利用自动化评测体系与Prompt测试工具,对Claude及其AI应用系统进行效果量化与性能优化。涵盖RAG、摘要、SQL等多场景评测方法,结合Promptfoo、LLM自动打分等主流工具,助力中国AI开发者科学提升AI系统质量。

目录

- 自动化评测原理与意义

- 多场景评测体系:RAG/摘要/SQL

- 主流评测工具:Promptfoo与自定义评测

- LLM自动打分与蓝图/自定义评测实战

- 架构图、流程图与思维导图

- 性能指标与结果可视化

- 注意事项与最佳实践

- 常见问题与扩展阅读

- 总结与参考资料

自动化评测原理与意义

- 自动化评测:通过标准化流程与工具,批量量化AI系统的输出质量,支持持续优化。

- 典型场景:RAG问答、摘要生成、SQL生成、内容分类、工具调用等。

- Claude优势:支持多种评测方式,结合Promptfoo、LLM自动打分等工具,评测高效、灵活。

重点:自动化评测是AI系统上线与迭代的核心保障,能显著提升开发效率与产品质量。

多场景评测体系:RAG/摘要/SQL

1. RAG系统评测

- 指标:准确率、召回率、F1、MRR、端到端准确率等

- 流程:构建评测集→检索召回→生成答案→与标准答案比对→自动打分

2. 摘要与文本生成评测

- 指标:ROUGE、BLEU、LLM打分、人工评测等

- 流程:生成摘要→与参考摘要比对→多维度打分

3. SQL/结构化输出评测

- 指标:语法正确率、执行正确率、字段覆盖率等

- 流程:生成SQL→自动化测试用例→比对输出与预期

主流评测工具:Promptfoo与自定义评测

1. Promptfoo简介与用法

- 功能:支持多模型、多Prompt、多测试用例批量评测,支持自定义断言与Python脚本评测。

- 典型配置:

providers:

- id: anthropic:messages:claude-3-haiku-20240307

label: "3 Haiku"

config:

max_tokens: 4096

temperature: 0

prompts:

- id: prompts.py:generate_prompt

label: Basic

- id: prompts.py:generate_prompt_with_examples

label: Few-Shot Examples

tests:

- description: "Check syntax of simple query"

vars:

user_query: "What are the names of all employees in the Engineering department?"

assert:

- type: contains

value: "<sql>"

- type: python

value: file://tests/test_simple_query.py

- 运行命令:

npx promptfoo@latest eval -c promptfooconfig.yaml --output results.csv

npx promptfoo@latest view

2. 自定义评测与Python脚本

- 支持自定义断言、Python自动化测试、LLM打分等

- 典型用法:

# 以llm_eval.py为例,自动评测摘要质量

import anthropic

import os

def llm_eval(summary, input):

client = anthropic.Anthropic(api_key=os.getenv("ANTHROPIC_API_KEY"))

prompt = f"""

Evaluate the following summary based on these criteria:

1. Conciseness (1-5)

2. Accuracy (1-5)

3. Completeness (1-5)

4. Clarity (1-5)

5. Explanation

...

Original Text: {input}

Summary to Evaluate: {summary}

"""

response = client.messages.create(

model="claude-3-haiku-20240307",

max_tokens=512,

messages=[{"role": "user", "content": prompt}]

)

return response.content[0].text

LLM自动打分与蓝图/自定义评测实战

1. LLM自动打分原理

- 通过大模型对输出进行多维度评分,支持结构化JSON输出,适合主观性较强的任务

2. 评测蓝图与自定义流程

- 评测蓝图:定义输入、输出、标准答案、评分标准、自动化流程

- 典型流程:

- 构建评测集(如docs_evaluation_dataset.json)

- 自动化生成答案

- LLM自动比对与打分(如eval_end_to_end.py)

- 汇总与可视化

# 端到端评测自动打分示例

def evaluate_end_to_end(query, generated_answer, correct_answer):

prompt = f"""

你是AI评测助手,请判断生成答案是否与标准答案一致。

问题: {query}

标准答案: {correct_answer}

生成答案: {generated_answer}

请输出<is_correct>true/false</is_correct>和解释。

"""

response = client.messages.create(

model="claude-3-haiku-20240307",

max_tokens=256,

messages=[{"role": "user", "content": prompt}]

)

return response.content[0].text

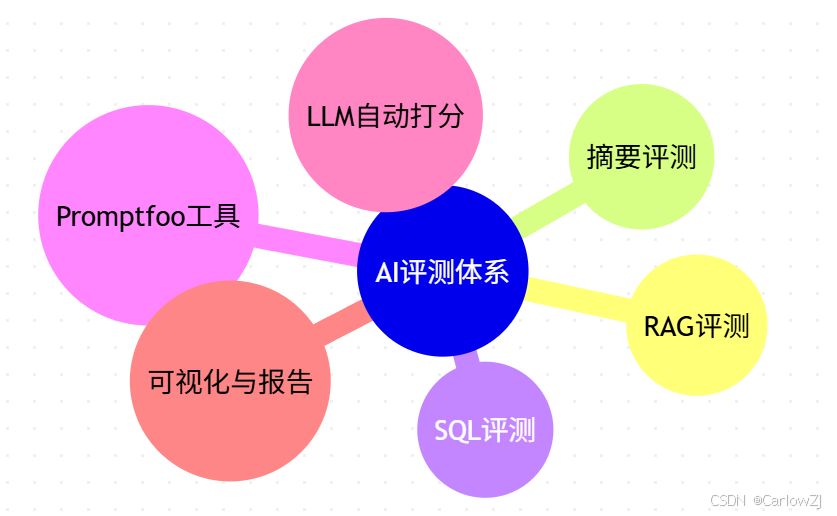

架构图、流程图与思维导图

评测系统架构图

评测流程图

评测体系思维导图

mindmap

root((AI评测体系))

子节点1((RAG评测))

子节点2((摘要评测))

子节点3((SQL评测))

子节点4((Promptfoo工具))

子节点5((LLM自动打分))

子节点6((可视化与报告))

性能指标与结果可视化

- 常用指标:准确率、召回率、F1、BLEU、ROUGE、MRR、端到端通过率等

- 可视化方法:柱状图、折线图、饼图、甘特图等

- 示例:

import matplotlib.pyplot as plt

# 假设有准确率、召回率等数据

metrics = {'准确率':0.85, '召回率':0.80, 'F1':0.82}

plt.bar(metrics.keys(), metrics.values())

plt.title('RAG系统评测指标')

plt.show()

注意事项与最佳实践

- 评测集多样性:覆盖主流场景与边界情况

- 自动化脚本健壮性:异常处理、日志记录

- 指标解释:结合业务目标解读评测结果

- 持续集成:评测流程可集成CI/CD,支持持续优化

最佳实践:评测流程自动化、指标多元化、结果可视化、与业务目标紧密结合。

常见问题与扩展阅读

- Q: 如何设计高质量评测集?

- A: 结合真实业务场景、覆盖多样输入、定期更新。

- Q: LLM自动打分是否可靠?

- A: 适合主观性任务,建议与人工评测结合。

- Q: Promptfoo能否自定义断言?

- A: 支持,且可结合Python脚本灵活扩展。

扩展阅读:

总结与参考资料

- 自动化评测是AI系统上线与持续优化的核心保障。

- Claude结合Promptfoo、LLM自动打分等工具,支持多场景高效评测。

- 推荐结合Mermaid图表、思维导图等工具,提升评测体系可视化与知识梳理能力。

参考资料:

- Anthropic Cookbook官方仓库

- Promptfoo官方文档

- Anthropic评测指南

- Python数据可视化教程

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?