1.预训练模型表现影响因素

- 模型表现强依赖于模型规模(模型参数量 N (Embedding除外)、训练Token数 D、训练总计算量 C);

- 平滑幂定律:模型表现与三个因子均遵循幂定律,不受另外两个因子限制;

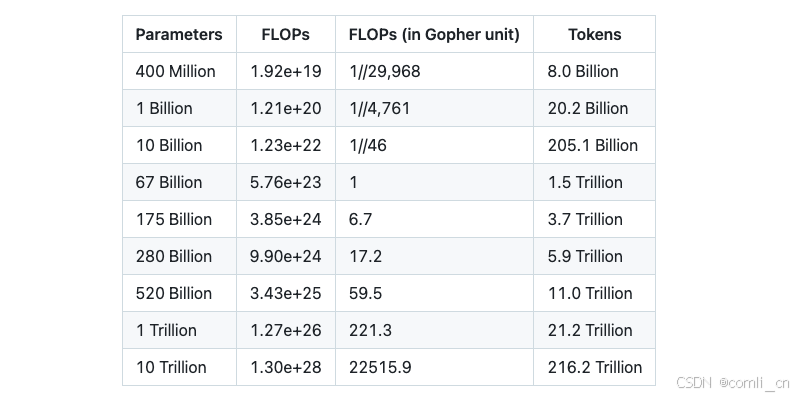

- 在给定计算量预算下,模型参数量以及训练Token数应该同比提升,对应模型参数量需要的训练Token数如下:

总体来说,这些结果表明,随着适当地提高模型大小、数据和计算能力,语言建模性能会平稳、可预测地提高。更大的语言模型将比其他模型表现更好,并且更具样本效率。

2.预训练数据 Token 重复 是否影响 模型性能?

- 多轮epoch的训练会降低模型性能;

- 更大规模的数据集会缓解重复epochs对模型性能下降的影响;

- 提高数据集的质量也无法挽救重复训练带来的过拟合;

- 小计算量模型的过拟合趋势与大计算量的差不多;

- 多样的训练目标不一定减轻多Epoch的性能下降;

- Dropout是一个被大语言模型忽视的正则技术,虽然慢,但是可以降低多epochs的影响;

- 在训练过程中逐渐使用dropout是有效的策略;

订阅专栏 解锁全文

订阅专栏 解锁全文

891

891

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?