Langchain提供了PromptTemplates提示文本技术,可以大大降低模型设计、调试和优化成本。这是一种可复制的生成prompt的方式,包含一个文本字符串,可以接收来自终端用户的一组参数,并生成prompt。

PromptTemplates可以包含指令、少量实例和一个向语言模型提出的问题。通过使用该技术,可以指导语言模型生成更高质量的文本,从而更好的完成任务。

1.prompt模板

如果每次用户要输入很多内容相似的prompt,可以考虑创建一个prompt模板。示例代码如下:

预设模板可以保存+载入:

2.微调大模型,传递给LLM终端回答

首先把前节创建的ChatGLM引入进来:

给LLM零学习样本,以便于LLM更加准确的回答问题,这个过程称为微调。

下面使用prompt的小样本模版来训练LLM。

以下示例要求根据用户输入的词语,LLM对应输出反义词。

首先定义两组输入输出的例子:

然后将它们组建成小样本学习的模板对象:

最后,在LangChain对接LLM时使用自定义小样本提示语模板,这样LLM可以根据模板格式和要求来返回对应的内容:

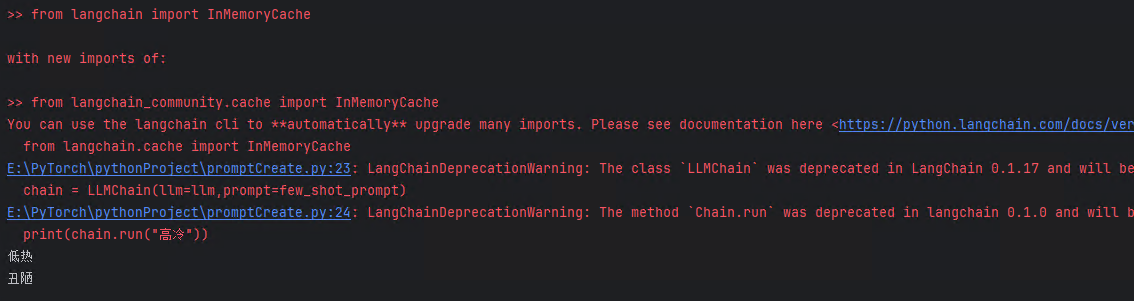

输出结果如下:

1193

1193

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?