本文在个人windws电脑上使用LM studio部署Qwen3,并将其集成到Dify中的chatflow搭建文档问答助手。主要应用如下

LM Studio:Qwen3 14b

Docker

Dify

目录

1. LM Studio本地部署Qwen3 14b

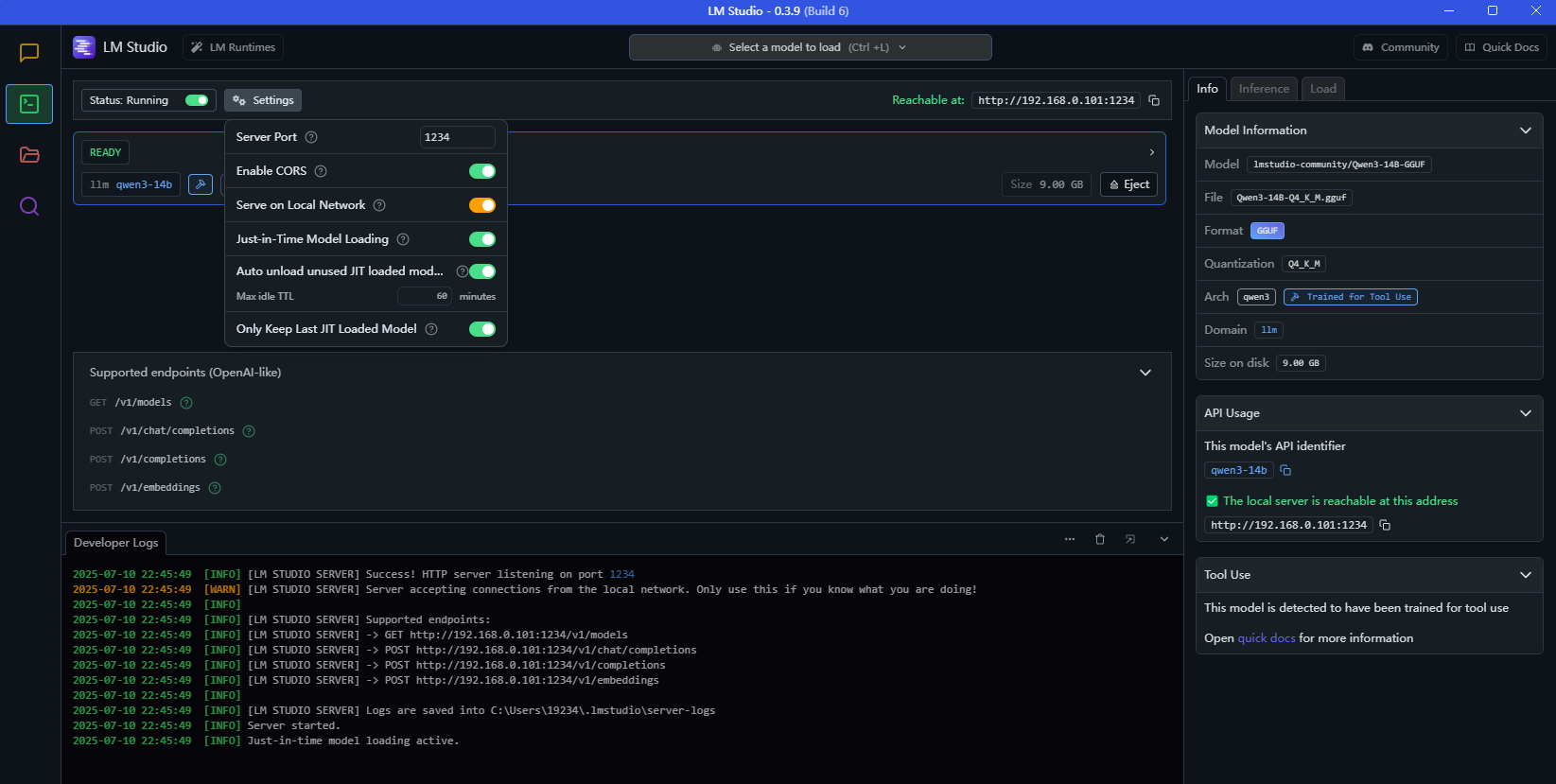

下载Qwen3 14b模型,选择Developer模式和Serve on Local Network,其余配置如下

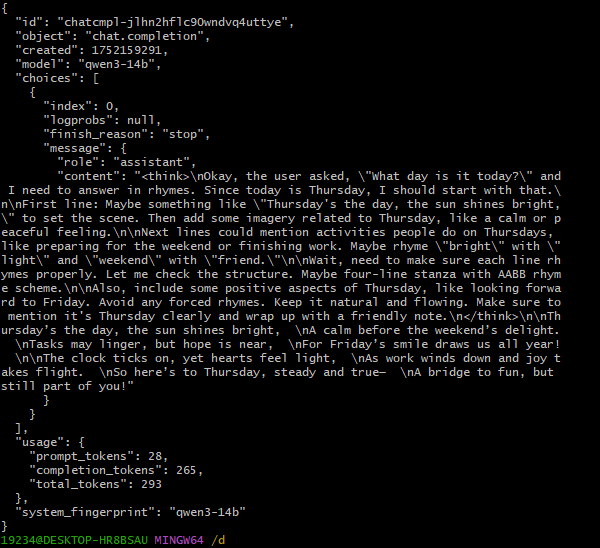

模型服务加载完成后可在git bash中用curl命令测试接口,以下是测试openai的非流式chat接口。ip和端口号可在lm studio中获取

curl http://192.168.0.xxx:1234/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "qwen3-14b",

"messages": [

{ "role": "system", "content": "Always answer in rhymes. Today is Thursday" },

{ "role": "user", "content": "What day is it today?" }

],

"temperature": 0.7,

"max_tokens": -1,

"stream": false

}'有结果返回可服务可用

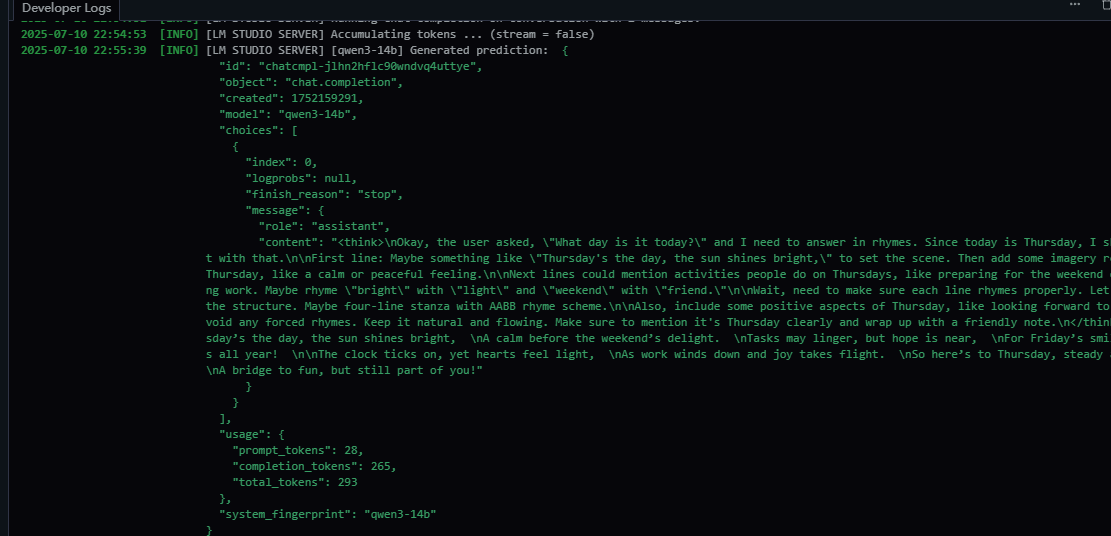

developer log也打印了对应的log

2.windows下载安装docker

下载Docker:下载地址

3.下载Dify安装包

https://github.com/langgenius/dify

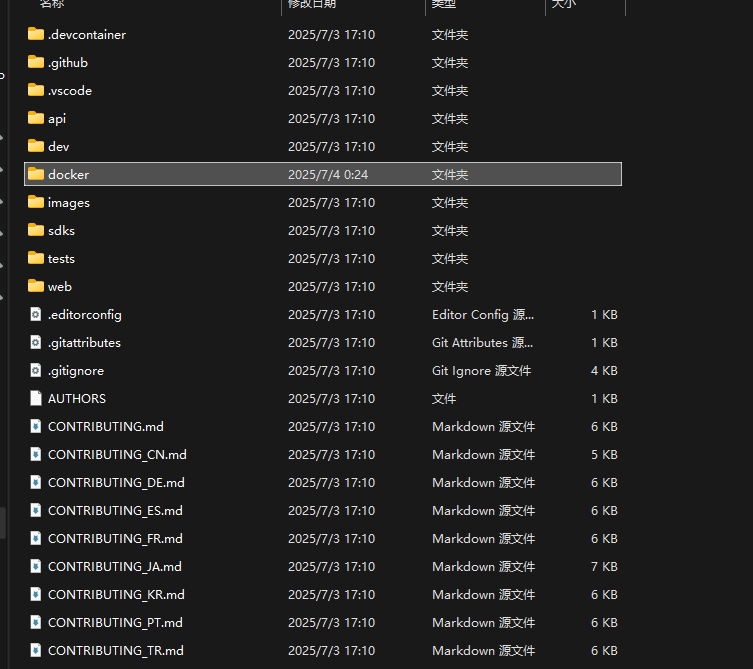

下载完成后进入docker文件夹,在此运行命令行终端

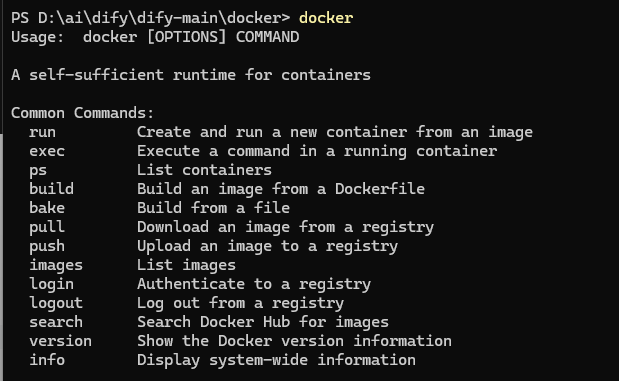

在命令行中执行docker,显示如下则docker安装成功

copy环境变量,这里使用example

cp .env.example .env执行以下docker命令,在docker中启动dify

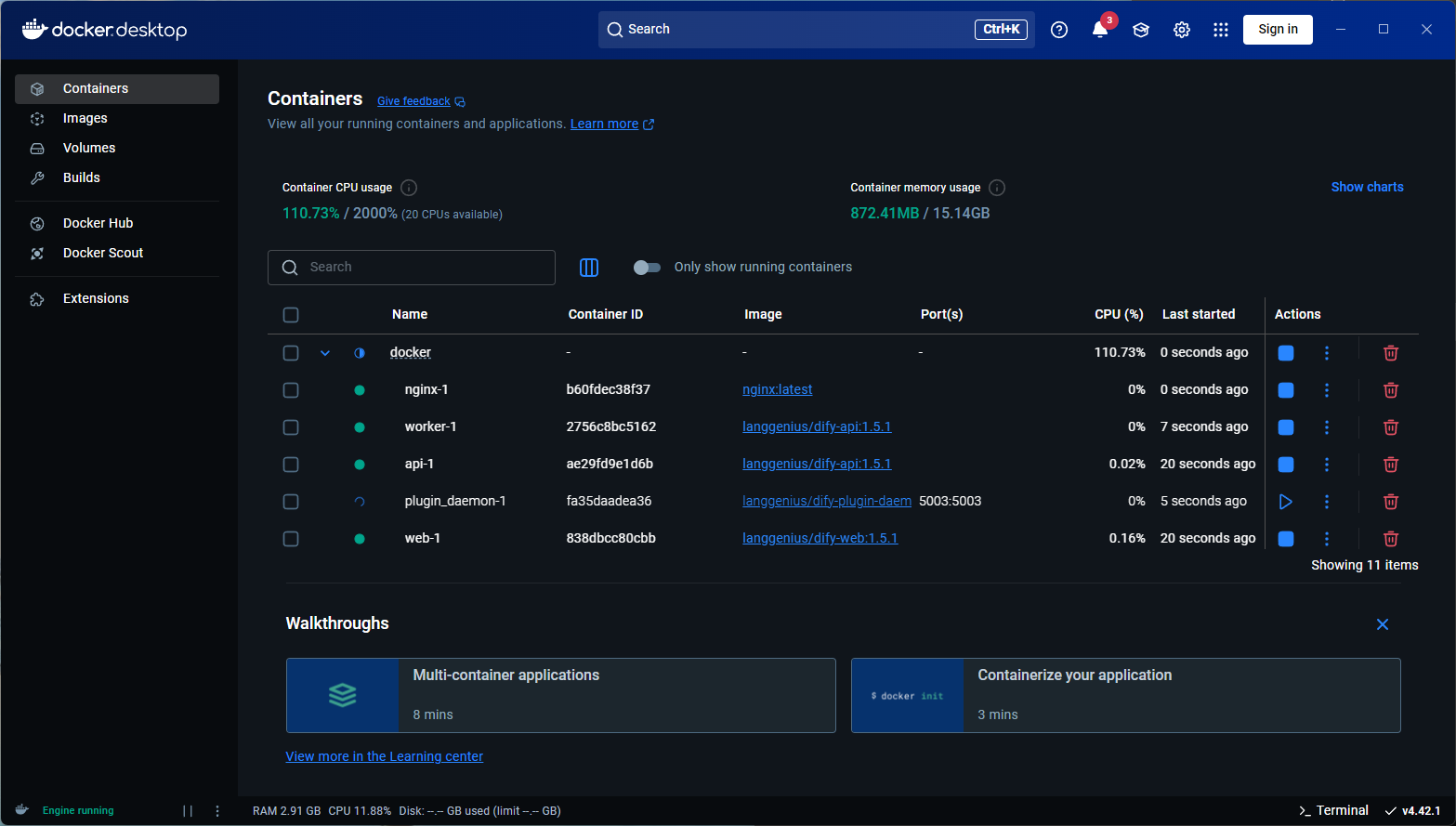

docker compose up -d启动成功后可在docker客户端看到已经启动的容器

4.Dify创建智能应用

浏览器输入url,注册登录

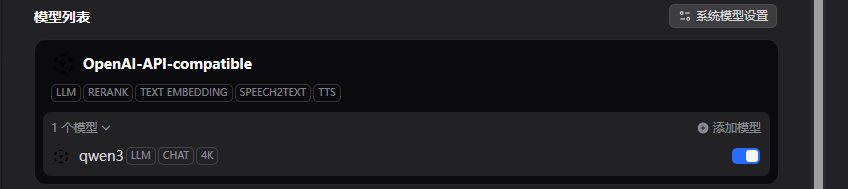

http://localhost/signin配置LM studio中的Qwen模型:在设置,模型供应商中安装

OpenAI-API-compatible

注意:此处不能选择LM studio,否则dify中会报错

validation error for LLMNodeData model.mode Field required [type=missing, input_value={'provider': 'stvlynn/lms...'completion_params': {}}, input_type=dict] For further information visit https://errors.pydantic.dev/2.11/v/missing

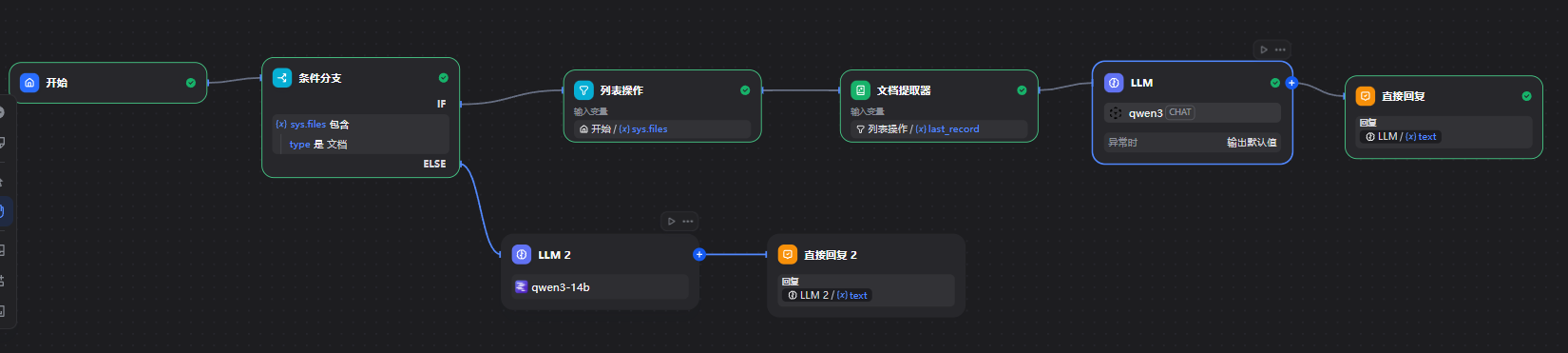

工作室创建空白应用,选择chatflow

部署以下服务

llm配置如下,助手设定为一个有着丰富教学经验的小学六年级数学老师

5.结果展示

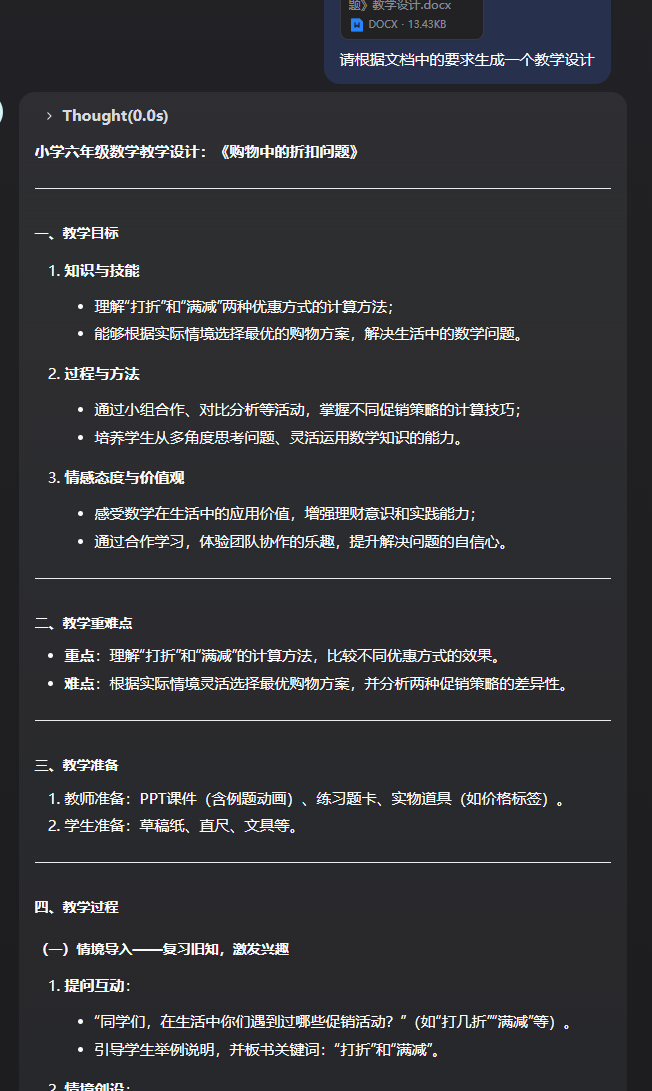

直接发布运行,上传一篇文档,让大模型帮忙输出一篇教学设计,返回结果如下

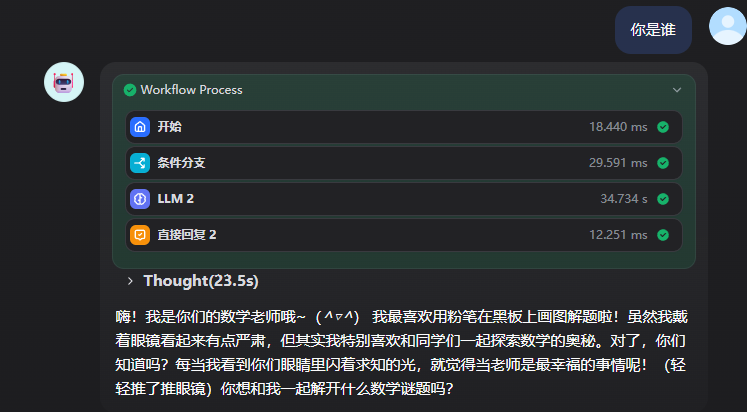

直接输入prompt

Windows电脑基于Qwen3和Dify搭建文档问答助手

Windows电脑基于Qwen3和Dify搭建文档问答助手

1028

1028

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?